随着世界日益数字化,对高质量内容的需求从未如此强烈。幸运的是,自然语言处理 (NLP) 的进步催生了强大的 AI 驱动写作工具,例如 Hugging Face 开发的工具。但如果您需要离线使用这些模型怎么办?不用担心,我们将探索如何在没有互联网连接的情况下利用 Hugging Face 模型。

离线访问 Hugging Face 的尖端语言模型开辟了无限可能。无论您是在远程位置工作、处理不可靠的互联网连接,还是仅仅优先考虑数据隐私,本地运行这些模型的能力都可能改变游戏规则。通过了解如何离线部署 Hugging Face 模型,您可以在内容创建过程中实现更高水平的效率、灵活性和控制力。

在这篇博文中,我们将深入探讨您可以采取的实际步骤,以离线利用 Hugging Face 模型的强大功能。从模型部署到与现有工作流程的无缝集成,您将学习如何最大限度地发挥这些高级 NLP 工具的潜力,即使在没有互联网连接的情况下也是如此。准备提升您的内容创作能力,并在不断发展的数字营销和传播世界中保持领先地位。

为什么你可能想要离线使用 Huggingface 模型?

您可能想知道为什么有人会费心离线运行 AI 模型。但相信我,有一些非常令人信服的理由让您将 Hugging Face 模型离线。

创建令人惊叹的网站

使用最好的免费页面构建器 Elementor

现在开始以下是关于为什么有人可能想要离线使用 Hugging Face 模型的简要解释:

离线使用 Hugging Face 模型有几个主要优点:

- 可靠性:不间断工作,无需担心互联网连接问题。

- 速度:消除网络延迟,实现更快的模型推理。

- 隐私:将敏感数据保留在本地,避免在线处理的潜在安全风险。

- 成本效益:通过在硬件上运行模型来降低云计算费用。

- 可移植性:在偏远地区或互联网接入有限的区域使用先进的人工智能功能。

- 学习:通过直接使用模型来更深入地了解模型架构和功能。

- 定制:当您拥有本地访问权限时,可以更轻松地微调和调整模型以适应特定用例。

让我们深入探索如何随时随地充分发挥 Hugging Face 模型的潜力。

如何离线使用 Huggingface 模型?

Huggingface 就像是开源 AI 的 Github 或应用商店。在这里,你可以浏览、下载甚至使用来自该网站的众多开源 LLM。此外,就像 ChatGPT 一样,他们也有 Hugging Chat。这个聊天机器人允许你选择一个你想要使用的模型,然后你可以像使用任何其他多模型 AI 助手一样与它进行对话。

每天完全免费、离线使用这些模型该有多棒?让我们这样做吧。

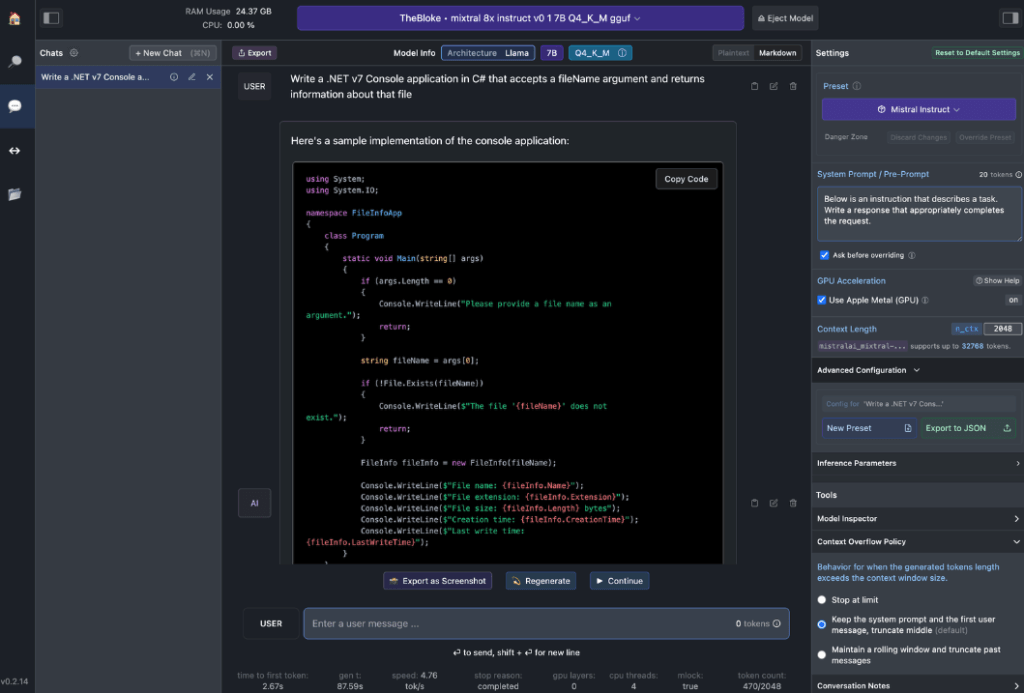

LM 工作室

LM Studio正在彻底改变我们在本地使用 AI 模型的方式。这款多功能应用适用于 Windows、Mac(Apple Silicon)和 Linux(测试版),让用户能够轻松离线下载和运行 Hugging Face 模型。

LM Studio 的主要功能包括:

- 本地模型交互:下载您喜欢的语言模型 (LLM),并像使用任何基于聊天的 AI 助手一样与其互动。自定义性能和输出格式,并通过各种内置系统提示和选项探索实验性功能。

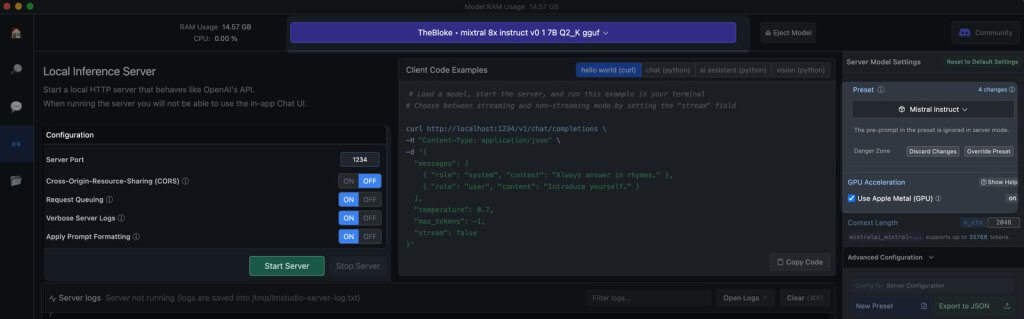

- OpenAI API 模拟:这是 LM Studio 真正出彩的地方。加载您下载的 Hugging Face 模型,LM Studio 巧妙地在其周围包装了一个本地 API 代理,模仿 OpenAI API。这种兼容性改变了游戏规则,因为它允许与已经支持 OpenAI 的众多 SDK 和流行的编辑器和 IDE 扩展无缝集成。

工作站硬件要求

要真正释放离线 Hugging Face 模型的潜力,您需要一些强大的硬件。虽然任何现代计算机都可以处理基本任务,但最佳性能需要更强大的规格:

对于 Apple 用户:

- M2/M3 Max 或 Ultra 处理器

- 更高端的配置

- 50+ GB RAM(与 M2 SoC 上的 GPU 共享)

- 金属支撑,增强性能

对于 Windows 用户:

- 更多核心CPU

- 大量 RAM

- 具有充足 VRAM 的 RTX 30 或 40 系列 GPU

如果您没有顶级系统,也不必担心。即使在最新型号中,也存在许多 RAM 和 VRAM 友好型选项。当您浏览和下载模型时,LM Studio 会帮助您估算系统的功能。

一般来说,更大的模型文件和更高的资源要求与更好的输出质量相关。虽然最好不要将系统推到绝对极限,但不要害怕在硬件能力范围内设定更高的目标。

请记住:目标是平衡模型性能和系统资源,以获得最佳的离线 Hugging Face 体验。

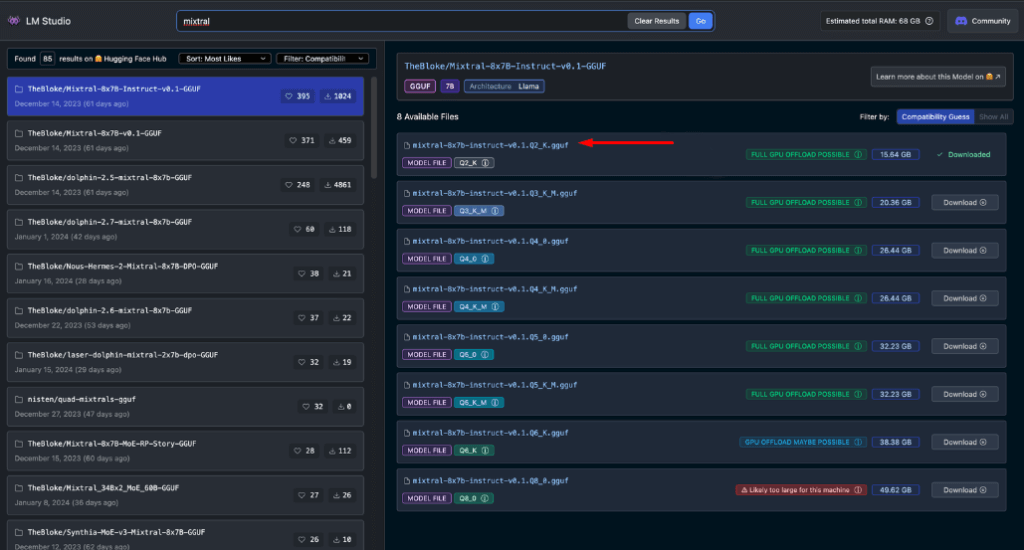

离线使用的推荐型号

离线运行 Hugging Face 模型时,选择正确的模型至关重要。通过广泛的测试,我发现以下模型在一般聊天和编码任务中都能提供始终如一的令人印象深刻的结果:

每个模型都提供了性能和资源使用之间的独特平衡,使其成为离线部署的绝佳选择。

在继续进行之前,必须自己评估这些模型:

- 在 LM Studio 中下载每个模型

- 使用 AI 聊天选项卡与模型进行交互

- 测试其在各种任务上的性能,尤其是编码(如果你关注的是编码)

- 评估输出的质量以及它们与你的需求的匹配程度

请记住,您的体验可能会因您的具体用例和硬件功能而异。花点时间找到最适合您要求的模型。这个仔细的选择过程将确保您拥有最有效的离线 Hugging Face 模型来满足您的需求,然后再进行集成和更高级的使用。

本地服务器进入 LM Studio

启动离线 Hugging Face 模型服务器非常简单:

- 打开 LM Studio

- 选择已下载的模型之一

- 单击启动服务器按钮

就是这样!默认设置通常适合大多数用户。但是,如果您希望微调您的体验,请随意调整选项以满足您的特定需求或偏好。

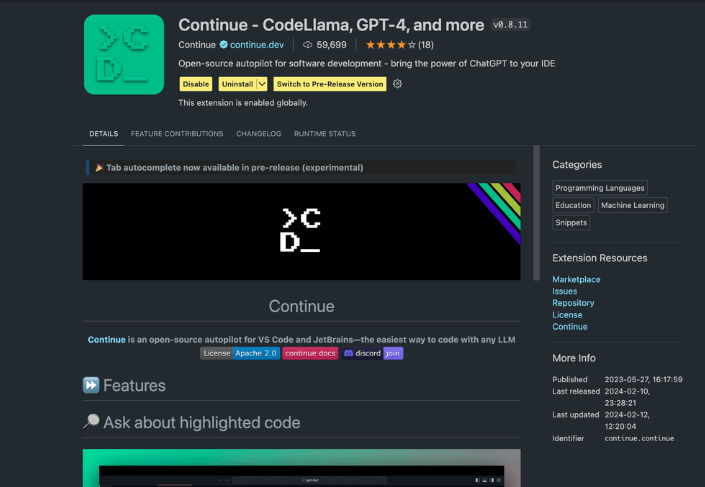

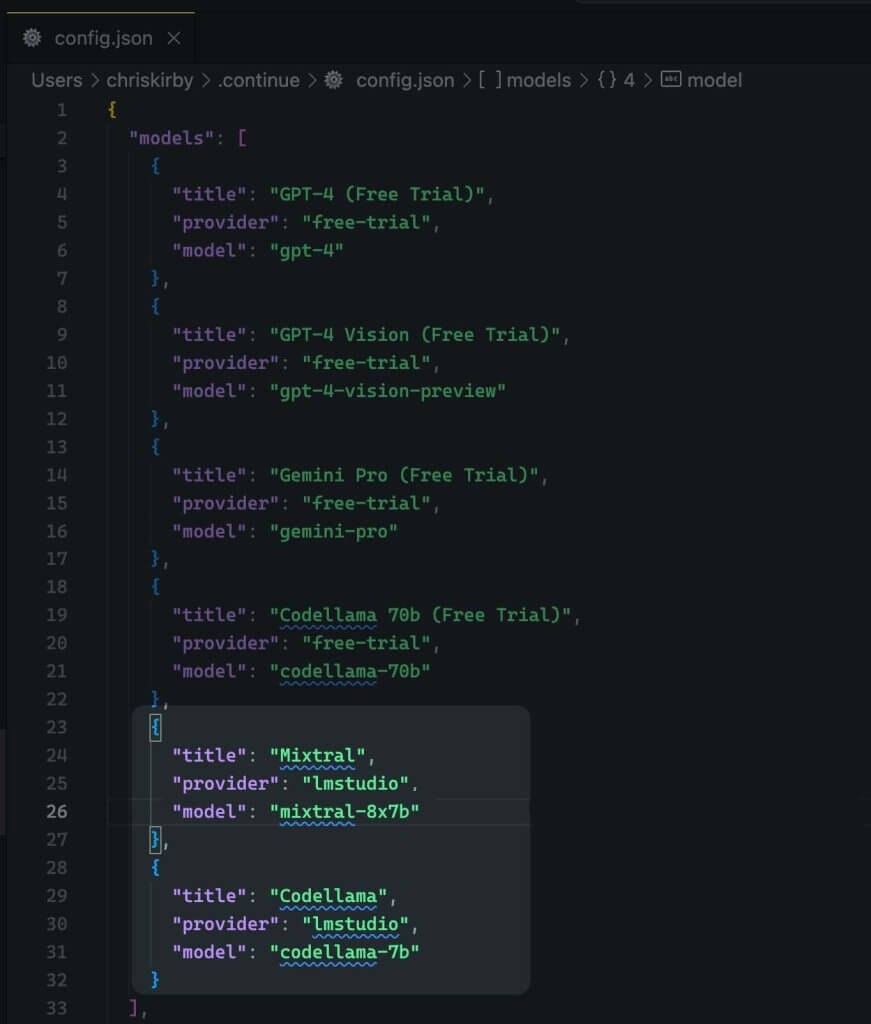

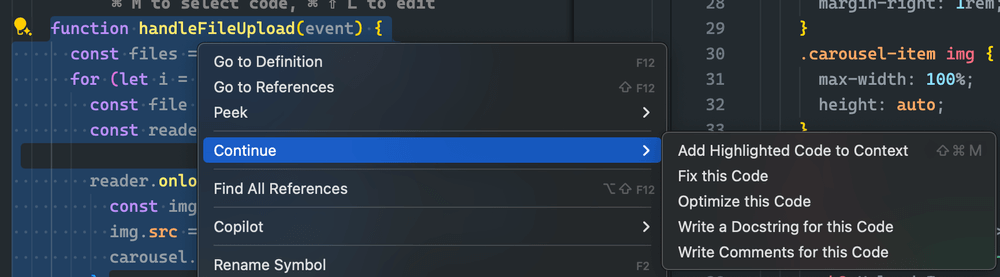

使用 Continue 扩展

从启动的 VS code studio 导航到扩展视图。在搜索栏中输入“继续”。找到正确的扩展并安装它。

现在我们需要更改扩展的配置 JSON。它将添加 LM Studio 支持。

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

现在,保存它。

接下来您需要使用这个本地模型来代替VS代码。

评估离线与在线模型性能

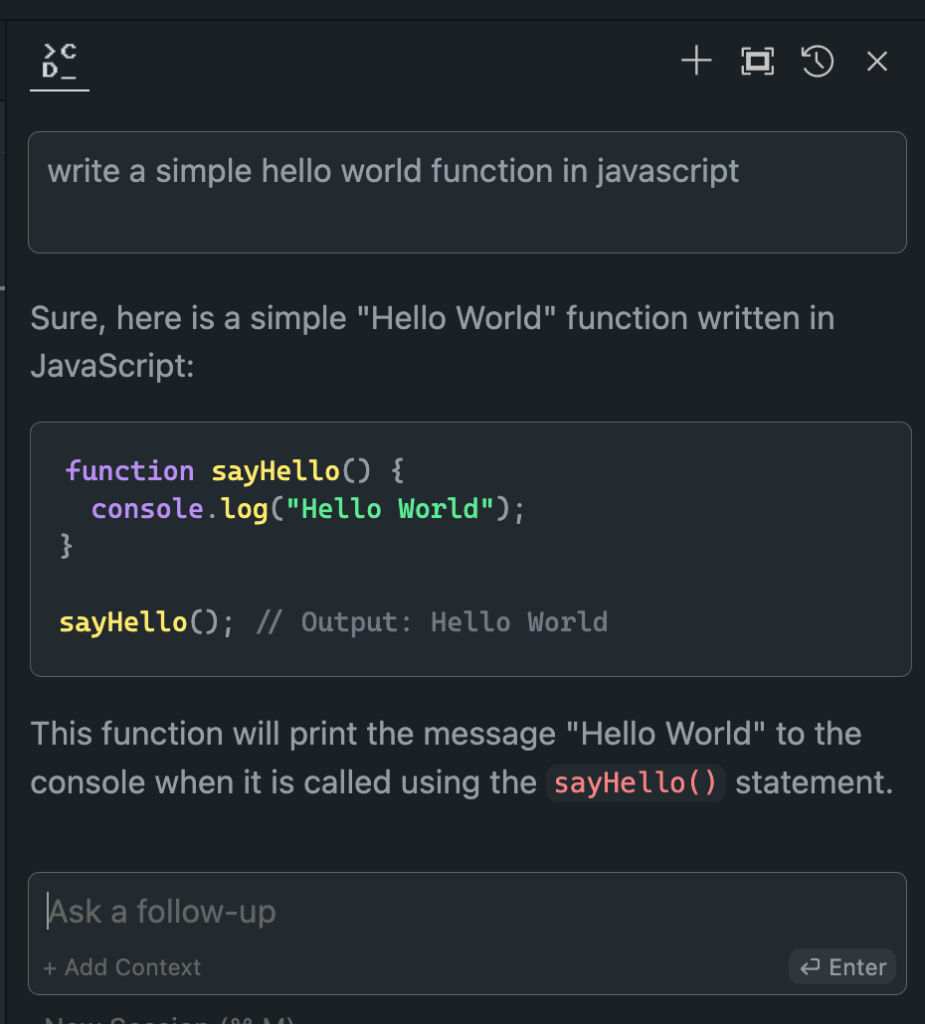

现在我们已经设置好了离线 Hugging Face 模型,接下来就是关键时刻了。让我们将它与在线模型进行对比测试吧!

在我的广泛试验中,结果令人大开眼界:

- 性能:离线模型通常可以与在线模型匹敌,在某些情况下甚至超越在线模型。

- 速度:没有网络延迟,响应速度极快。

- 一致性:不再因服务器负载或连接问题而产生变化。

虽然您的体验可能会因所选型号和硬件而异,但如果您发现自己更喜欢离线版本,请不要感到惊讶。本地处理能力和微调模型的结合可以提供令人印象深刻的结果。

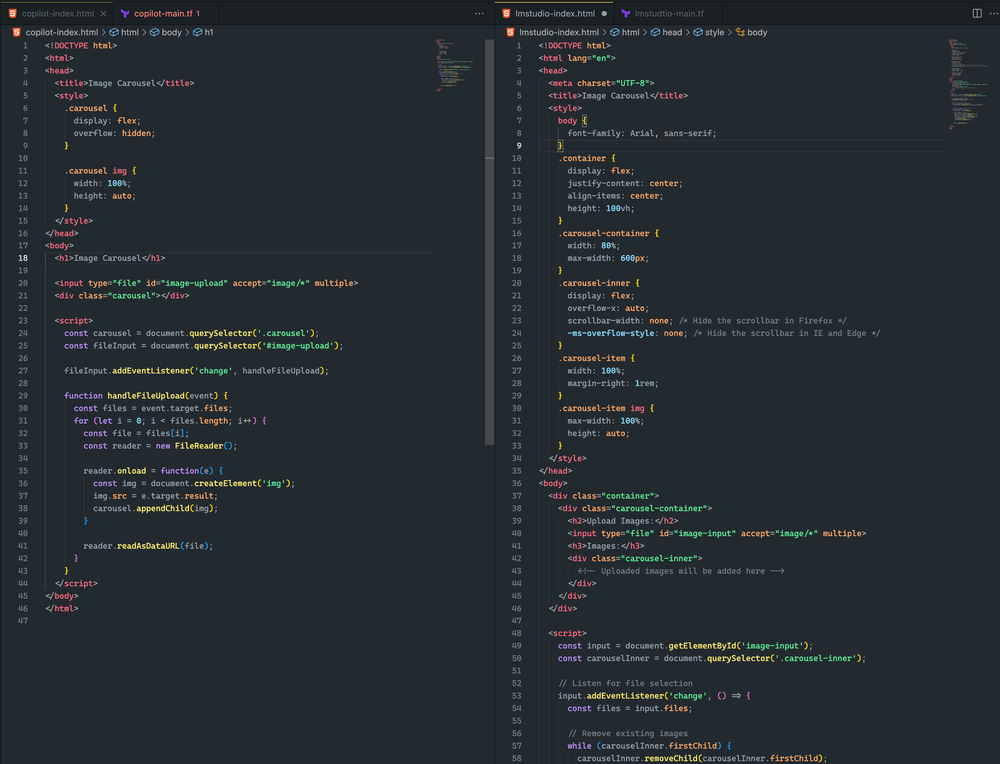

这里可以看出区别。

两种方法都很接近。虽然都没有产生图片轮播,但我成功上传了一张图片,并在两个示例中都呈现了出来。通过进一步的及时调整,我相信我可以实现更好的结果

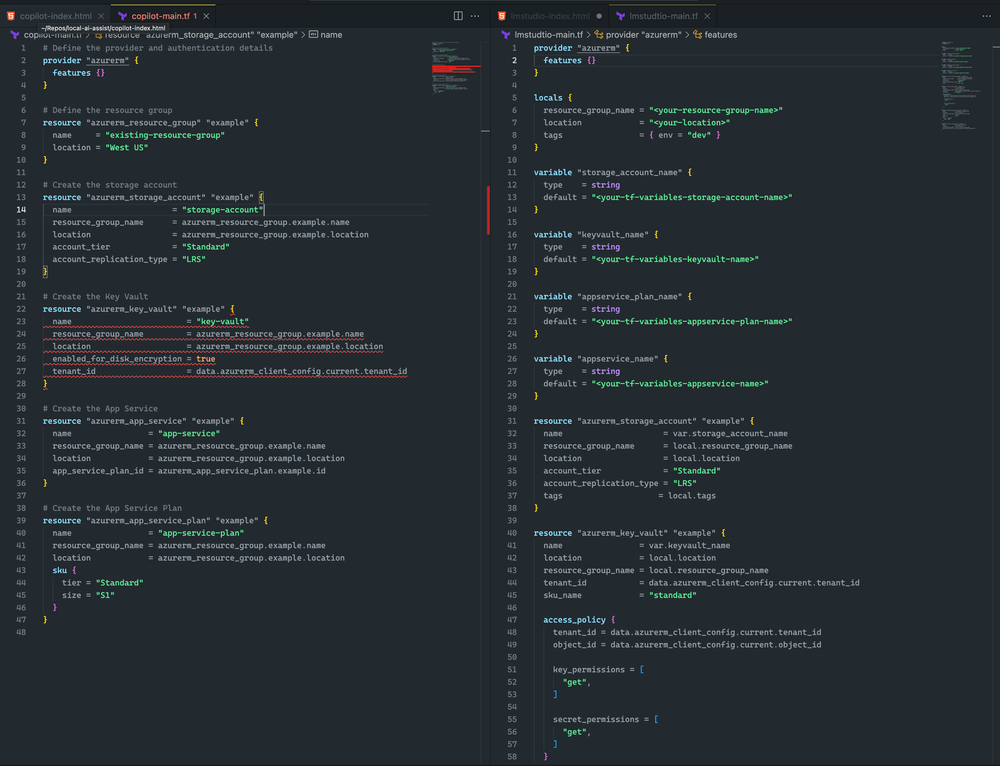

我更倾向于 LM Studio 和 Mixtral,因为 Terraform 更完整,没有语法错误。不过,CoPilot 确实有一个小问题:密钥库声明缺少sku_name ,这个问题可以轻松修复。

总结

请记住,人工智能领域正在迅速发展。通过掌握 Hugging Face 模型的离线部署,您不仅可以跟上步伐,还可以保持领先地位。无论您是开发人员、研究人员还是人工智能爱好者,这项技能都可以帮助您突破本地人工智能处理的极限。

所以,大胆尝试吧。尝试不同的模型,微调您的设置,并将这些离线功能集成到您的工作流程中。您可能会发现,人工智能开发的未来就在您的本地机器上,等待释放。