Khi thế giới ngày càng trở nên số hóa, nhu cầu về nội dung chất lượng cao chưa bao giờ lớn đến thế. May mắn thay, những tiến bộ trong xử lý ngôn ngữ tự nhiên (NLP) đã tạo ra các công cụ viết mạnh mẽ do AI điều khiển, chẳng hạn như các công cụ do Hugging Face phát triển. Nhưng nếu bạn cần sử dụng các mô hình này ngoại tuyến thì sao? Đừng lo lắng, vì chúng ta sẽ khám phá cách tận dụng các mô hình Hugging Face mà không cần kết nối internet.

Truy cập ngoại tuyến vào các mô hình ngôn ngữ tiên tiến của Hugging Face mở ra một thế giới khả năng. Cho dù bạn đang làm việc ở những địa điểm xa xôi, xử lý kết nối internet không đáng tin cậy hay chỉ đơn giản là ưu tiên quyền riêng tư dữ liệu, khả năng chạy các mô hình này cục bộ có thể là một bước ngoặt. Bằng cách hiểu cách triển khai các mô hình Hugging Face ngoại tuyến, bạn có thể mở khóa các cấp độ hiệu quả, tính linh hoạt và khả năng kiểm soát mới trong quy trình tạo nội dung của mình.

Trong bài đăng trên blog này, chúng ta sẽ đi sâu vào các bước thực tế mà bạn có thể thực hiện để khai thác sức mạnh của các mô hình Hugging Face ngoại tuyến. Từ việc triển khai mô hình đến tích hợp liền mạch với quy trình làm việc hiện tại của bạn, bạn sẽ học cách tối đa hóa tiềm năng của các công cụ NLP tiên tiến này, ngay cả khi không có sẵn kết nối internet. Chuẩn bị nâng cao trò chơi sáng tạo nội dung của bạn và luôn đi đầu trong thế giới tiếp thị và truyền thông kỹ thuật số không ngừng phát triển.

Tại sao bạn có thể muốn sử dụng Huggingface Model ngoại tuyến?

Bạn có thể tự hỏi tại sao mọi người lại bận tâm chạy mô hình AI ngoại tuyến. Nhưng tin tôi đi, có một số lý do thực sự thuyết phục để đưa mô hình Hugging Face của bạn ra khỏi lưới.

Tạo trang web tuyệt vời

Với trình tạo trang miễn phí tốt nhất Elementor

Bắt đầu bây giờSau đây là lời giải thích ngắn gọn về lý do tại sao một số người lại muốn sử dụng mô hình Hugging Face ngoại tuyến:

Sử dụng mô hình Hugging Face ngoại tuyến mang lại một số lợi thế chính:

- Độ tin cậy: Làm việc liên tục mà không phải lo lắng về vấn đề kết nối internet.

- Tốc độ: Loại bỏ độ trễ mạng để suy luận mô hình nhanh hơn.

- Quyền riêng tư: Lưu trữ dữ liệu nhạy cảm ở địa phương, tránh các rủi ro bảo mật tiềm ẩn khi xử lý trực tuyến.

- Hiệu quả về chi phí: Giảm chi phí điện toán đám mây bằng cách chạy mô hình trên phần cứng của bạn.

- Tính di động: Sử dụng các khả năng AI tiên tiến ở những địa điểm xa xôi hoặc khu vực có khả năng truy cập internet hạn chế.

- Học tập: Có được hiểu biết sâu sắc hơn về kiến trúc và chức năng của mô hình bằng cách làm việc trực tiếp với chúng.

- Tùy chỉnh: Dễ dàng tinh chỉnh và điều chỉnh các mô hình cho các trường hợp sử dụng cụ thể khi bạn có quyền truy cập cục bộ.

Hãy cùng khám phá cách khai thác hết tiềm năng của mô hình Hugging Face mọi lúc, mọi nơi.

Làm thế nào để sử dụng Huggingface Models ngoại tuyến?

Huggingface giống như Github hoặc cửa hàng ứng dụng cho AI nguồn mở. Tại đây, bạn có thể duyệt, tải xuống và thậm chí sử dụng nhiều LLM nguồn mở từ trang web này. Hơn nữa, giống như ChatGPT, họ có Hugging Chat. Chatbot này cho phép bạn chọn một mô hình bạn muốn sử dụng và sau đó bạn có thể trò chuyện với mô hình này như bạn sẽ làm với bất kỳ trợ lý AI đa mô hình nào khác.

Thật tuyệt vời biết bao khi sử dụng những mô hình này hoàn toàn miễn phí, ngoại tuyến hàng ngày? Hãy cùng thực hiện nhé.

Phòng thu LM

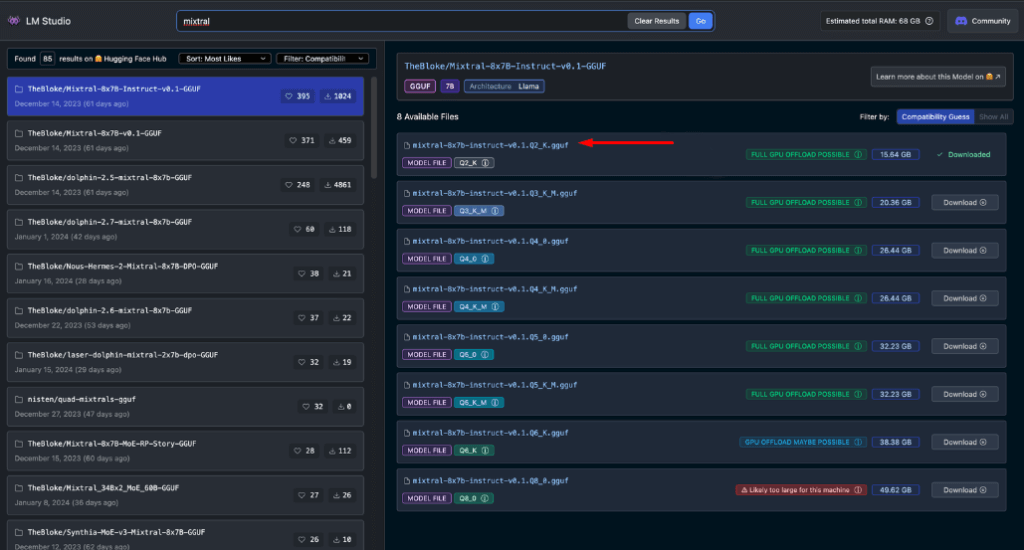

LM Studio đang cách mạng hóa cách chúng ta sử dụng các mô hình AI cục bộ. Ứng dụng đa năng này, có sẵn cho Windows, Mac (Apple Silicon) và Linux (beta), cho phép người dùng tải xuống và chạy các mô hình Hugging Face ngoại tuyến một cách dễ dàng.

Các tính năng chính của LM Studio bao gồm:

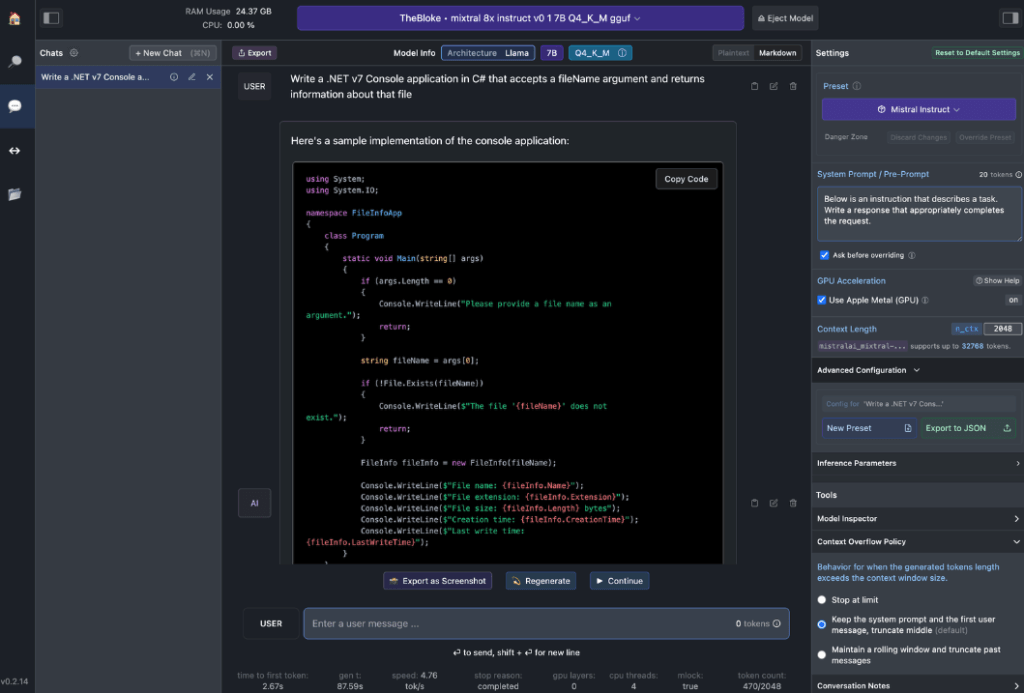

- Tương tác mô hình cục bộ: Tải xuống Mô hình ngôn ngữ (LLM) ưa thích của bạn và tương tác với nó như bất kỳ trợ lý AI dựa trên trò chuyện nào. Tùy chỉnh hiệu suất và định dạng đầu ra, đồng thời khám phá các tính năng thử nghiệm thông qua nhiều lời nhắc và tùy chọn hệ thống tích hợp sẵn.

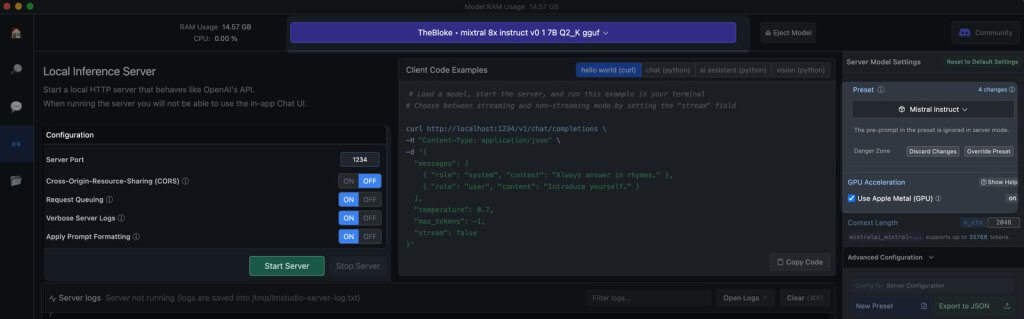

- OpenAI API Emulation: Đây là nơi LM Studio thực sự tỏa sáng. Tải mô hình Hugging Face đã tải xuống của bạn và LM Studio khéo léo bọc một proxy API cục bộ xung quanh nó, mô phỏng OpenAI API. Khả năng tương thích này là một bước ngoặt, vì nó cho phép tích hợp liền mạch với nhiều SDK và tiện ích mở rộng Editor & IDE phổ biến đã hỗ trợ OpenAI.

Yêu cầu phần cứng máy trạm

Để thực sự mở khóa tiềm năng của các mô hình Hugging Face ngoại tuyến, bạn sẽ cần một số phần cứng mạnh mẽ. Trong khi bất kỳ máy tính hiện đại nào cũng có thể xử lý các tác vụ cơ bản, hiệu suất tối ưu đòi hỏi thông số kỹ thuật mạnh mẽ hơn:

Đối với người dùng Apple:

- Bộ xử lý M2/M3 Max hoặc Ultra

- Cấu hình cao cấp hơn

- 50+ GB RAM (chia sẻ với GPU trên M2 SoC)

- Hỗ trợ kim loại để tăng cường hiệu suất

Đối với người dùng Windows:

- CPU lõi hơn

- RAM đáng kể

- GPU RTX 30 hoặc 40 series với VRAM dồi dào

Đừng lo lắng nếu bạn không có hệ thống hàng đầu. Có nhiều tùy chọn thân thiện với RAM và VRAM, ngay cả trong các mẫu mới nhất. LM Studio hữu ích ước tính khả năng của hệ thống khi bạn duyệt và tải xuống các mẫu.

Nhìn chung, các tệp mô hình lớn hơn và yêu cầu tài nguyên cao hơn tương quan với chất lượng đầu ra được cải thiện. Mặc dù tốt nhất là không nên đẩy hệ thống của bạn đến giới hạn tuyệt đối, nhưng đừng ngại đặt mục tiêu cao trong khả năng của phần cứng.

Hãy nhớ: Mục tiêu là cân bằng hiệu suất của mô hình với tài nguyên hệ thống của bạn để có trải nghiệm Hugging Face ngoại tuyến tốt nhất.

Các mô hình được đề xuất để sử dụng ngoại tuyến

Khi chạy các mô hình Hugging Face ngoại tuyến, việc chọn đúng mô hình là rất quan trọng. Qua quá trình thử nghiệm rộng rãi, tôi thấy các mô hình sau đây luôn mang lại kết quả ấn tượng cho cả nhiệm vụ trò chuyện chung và mã hóa:

Mỗi mô hình này đều có sự cân bằng độc đáo giữa hiệu suất và mức sử dụng tài nguyên, khiến chúng trở thành lựa chọn tuyệt vời cho việc triển khai ngoại tuyến.

Trước khi tiến hành tiếp, điều quan trọng là bạn phải tự mình đánh giá các mô hình này:

- Tải xuống từng mô hình trong LM Studio

- Sử dụng tab trò chuyện AI để tương tác với mô hình

- Kiểm tra hiệu suất của nó trên nhiều tác vụ khác nhau, đặc biệt là mã hóa nếu đó là trọng tâm của bạn

- Đánh giá chất lượng đầu ra và mức độ phù hợp của chúng với nhu cầu của bạn

Hãy nhớ rằng, trải nghiệm của bạn có thể khác nhau tùy thuộc vào trường hợp sử dụng cụ thể và khả năng phần cứng của bạn. Hãy dành thời gian để tìm mô hình phù hợp nhất với yêu cầu của bạn. Quy trình lựa chọn cẩn thận này sẽ đảm bảo bạn có mô hình Hugging Face ngoại tuyến hiệu quả nhất cho nhu cầu của mình trước khi chuyển sang tích hợp và sử dụng nâng cao hơn.

Máy chủ cục bộ vào LM Studio

Việc khởi chạy máy chủ mô hình Hugging Face ngoại tuyến của bạn rất đơn giản:

- Mở LM Studio

- Chọn một trong những mô hình đã tải xuống của bạn

- Nhấp vào nút Bắt đầu máy chủ

Vậy là xong! Các thiết lập mặc định thường phù hợp với hầu hết người dùng. Tuy nhiên, nếu bạn muốn tinh chỉnh trải nghiệm của mình, hãy thoải mái điều chỉnh các tùy chọn để phù hợp với nhu cầu hoặc sở thích cụ thể của bạn.

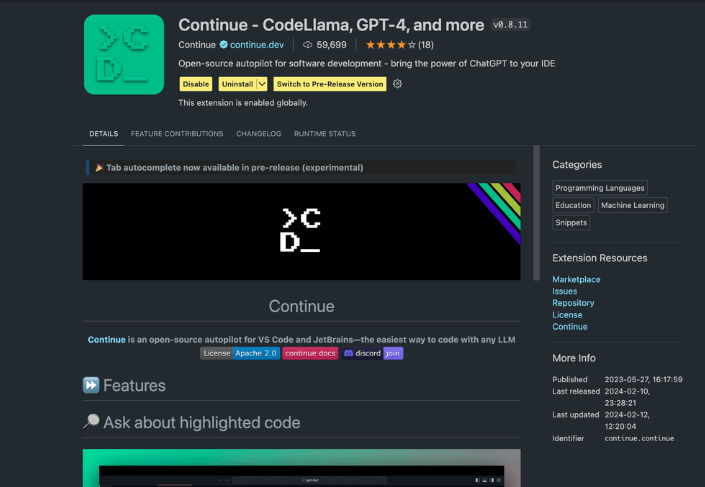

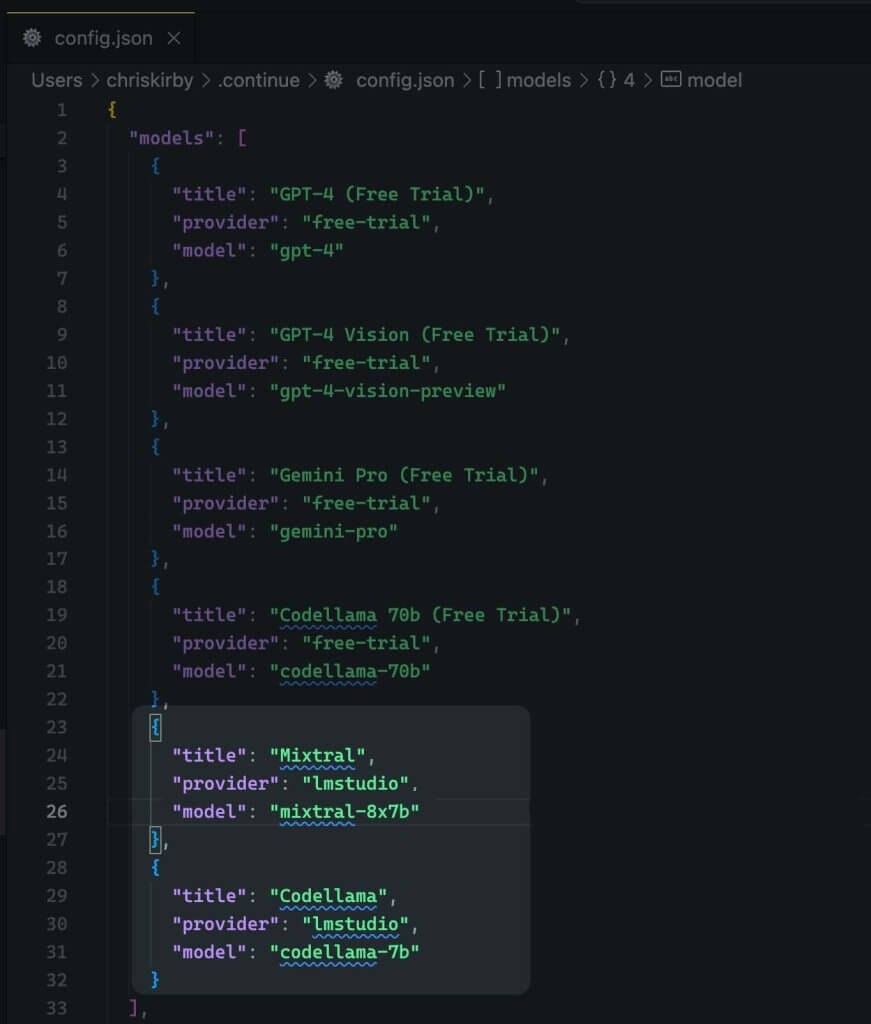

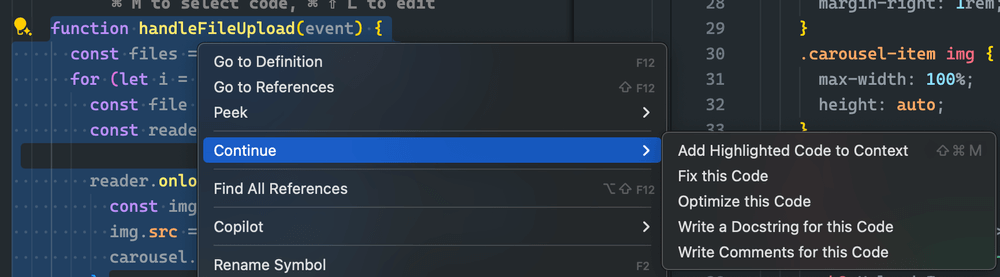

Sử dụng tiện ích mở rộng Continue

Từ VS code studio đã khởi chạy, hãy điều hướng đến chế độ xem tiện ích mở rộng. Trong thanh tìm kiếm, nhập "Tiếp tục". Tìm tiện ích mở rộng chính xác và cài đặt.

Bây giờ chúng ta cần thay đổi cấu hình JSON của tiện ích mở rộng. Nó sẽ thêm hỗ trợ LM Studio.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Bây giờ, hãy lưu lại.

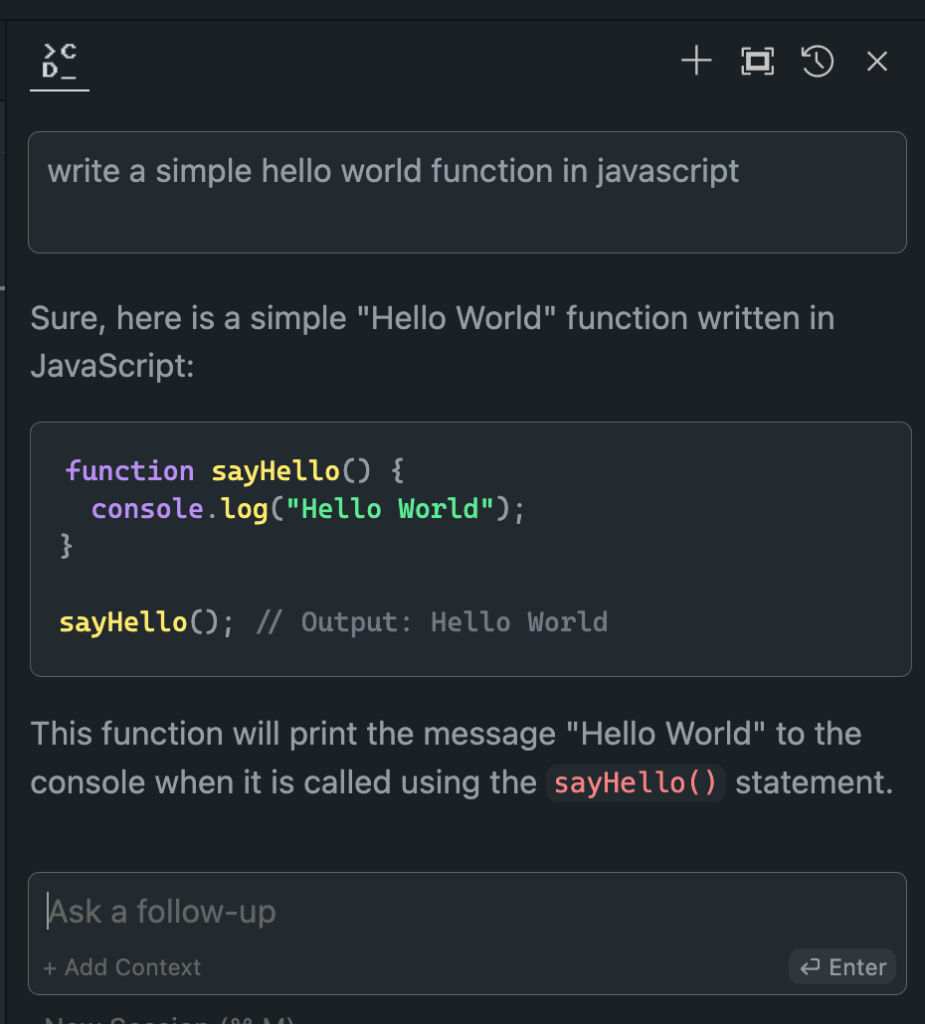

Tiếp theo, bạn cần sử dụng mô hình cục bộ này thay vì mã VS.

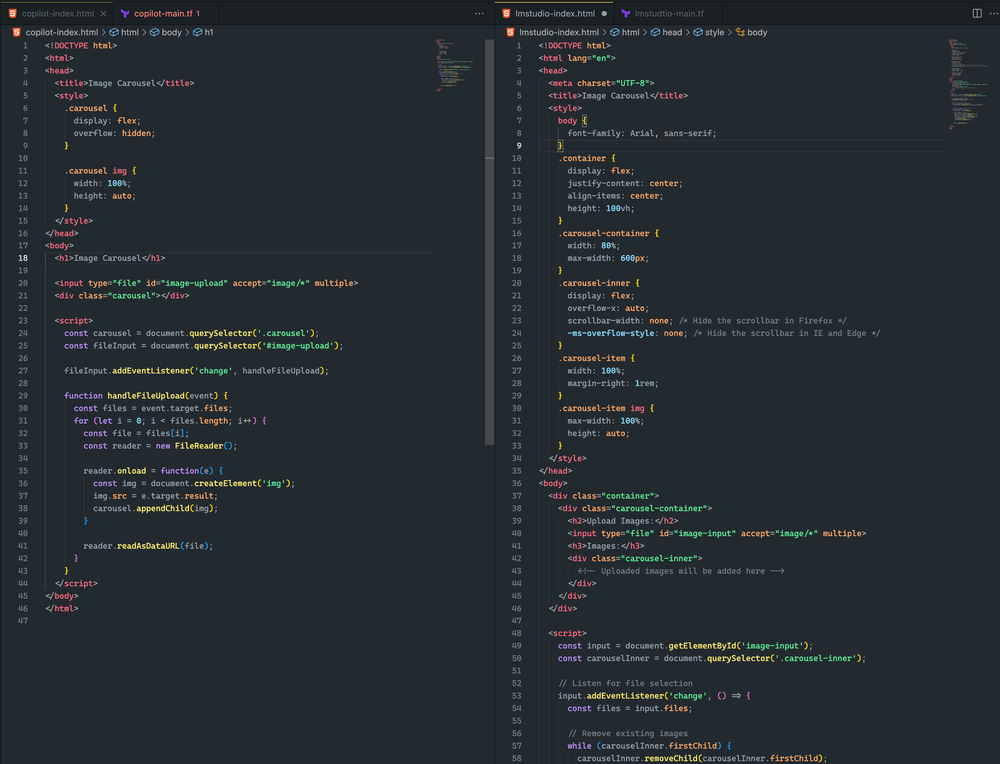

Đánh giá hiệu suất mô hình ngoại tuyến so với trực tuyến

Bây giờ chúng ta đã thiết lập mô hình Hugging Face ngoại tuyến, đã đến lúc cho khoảnh khắc của sự thật. Hãy thử nghiệm nó với các đối tác trực tuyến của nó!

Trong các thử nghiệm mở rộng của tôi, kết quả đã thực sự gây kinh ngạc:

- Hiệu suất: Mô hình ngoại tuyến thường ngang bằng và trong một số trường hợp, thậm chí còn vượt trội hơn mô hình trực tuyến.

- Tốc độ: Không có độ trễ mạng, phản hồi có thể nhanh như chớp.

- Tính nhất quán: Không còn sự thay đổi do tải máy chủ hoặc sự cố kết nối.

Mặc dù trải nghiệm của bạn có thể khác nhau tùy thuộc vào kiểu máy và phần cứng bạn chọn, đừng ngạc nhiên nếu bạn thấy mình thích phiên bản ngoại tuyến hơn. Sự kết hợp giữa sức mạnh xử lý cục bộ và các mô hình được tinh chỉnh có thể mang lại kết quả ấn tượng.

Hãy xem sự khác biệt nhé.

Cả hai cách tiếp cận đều khá gần nhau. Mặc dù không cách nào tạo ra một vòng quay hình ảnh, tôi đã tải lên thành công một hình ảnh và nó được hiển thị trong cả hai ví dụ. Với những điều chỉnh nhanh chóng hơn nữa, tôi tin rằng tôi có thể đạt được kết quả tốt hơn nữa

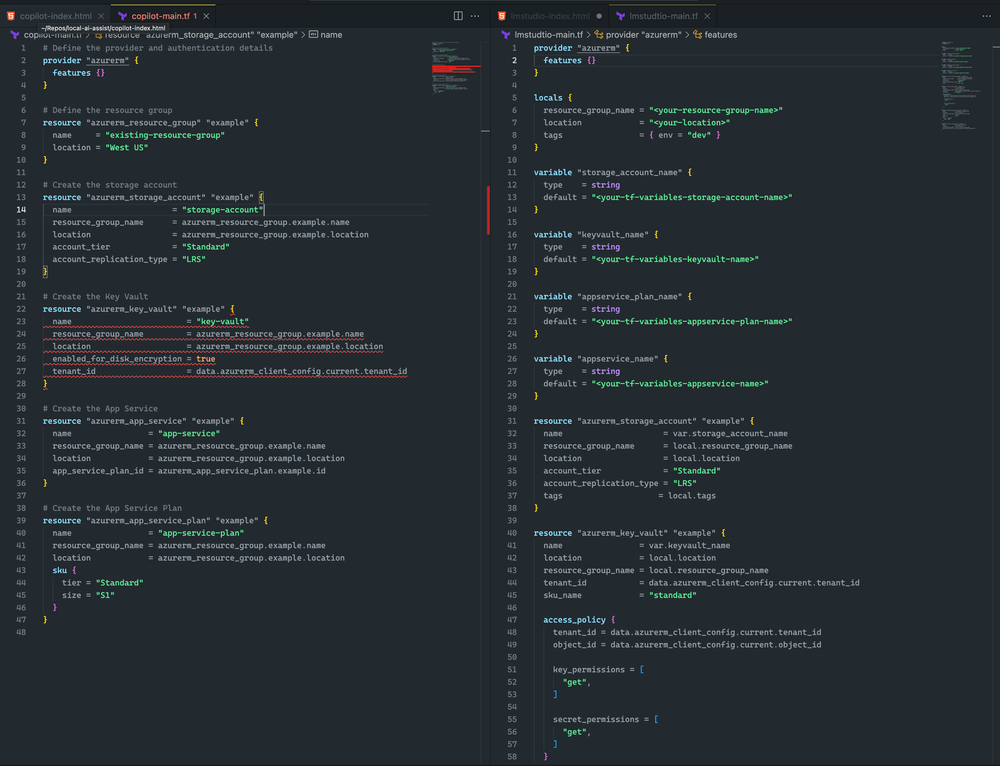

Tôi thiên về LM Studio và Mixtral vì Terraform hoàn thiện hơn và không có lỗi cú pháp. Tuy nhiên, CoPilot có một vấn đề nhỏ: khai báo khóa vault thiếu sku_name , có thể dễ dàng sửa.

Kết thúc

Hãy nhớ rằng, lĩnh vực AI đang phát triển nhanh chóng. Bằng cách thành thạo triển khai ngoại tuyến các mô hình Hugging Face, bạn không chỉ bắt kịp tốc độ mà còn đi trước thời đại. Cho dù bạn là nhà phát triển, nhà nghiên cứu hay người đam mê AI, kỹ năng này giúp bạn vượt qua ranh giới của những gì có thể với quá trình xử lý AI cục bộ.

Vậy thì hãy thử đi. Thử nghiệm với các mô hình khác nhau, tinh chỉnh thiết lập của bạn và tích hợp các nguồn năng lượng ngoại tuyến này vào quy trình làm việc của bạn. Bạn có thể thấy rằng tương lai của phát triển AI nằm ngay trên máy cục bộ của bạn, chờ đợi để được giải phóng.