เนื่องจากโลกกลายเป็นดิจิทัลมากขึ้น ความต้องการเนื้อหาคุณภาพสูงจึงไม่เคยสูงเท่านี้มาก่อน โชคดีที่ความก้าวหน้าในการประมวลผลภาษาธรรมชาติ (NLP) ทำให้เกิดเครื่องมือเขียนที่ขับเคลื่อนด้วย AI อันทรงพลัง เช่น เครื่องมือที่พัฒนาโดย Hugging Face แต่จะเกิดอะไรขึ้นหากคุณจำเป็นต้องใช้โมเดลเหล่านี้แบบออฟไลน์ ไม่ต้องกังวล เพราะเราจะมาสำรวจวิธีใช้ประโยชน์จากโมเดล Hugging Face โดยไม่ต้องเชื่อมต่ออินเทอร์เน็ต

การเข้าถึงแบบออฟไลน์สำหรับโมเดลภาษาล้ำสมัยของ Hugging Face จะเปิดโลกแห่งความเป็นไปได้ ไม่ว่าคุณจะทำงานในสถานที่ห่างไกล จัดการกับการเชื่อมต่ออินเทอร์เน็ตที่ไม่น่าเชื่อถือ หรือเพียงแค่ให้ความสำคัญกับความเป็นส่วนตัวของข้อมูล ความสามารถในการเรียกใช้โมเดลเหล่านี้ในเครื่องก็ถือเป็นตัวเปลี่ยนเกมได้ เมื่อเข้าใจวิธีการใช้งานโมเดล Hugging Face แบบออฟไลน์แล้ว คุณจะปลดล็อกระดับใหม่ด้านประสิทธิภาพ ความยืดหยุ่น และการควบคุมในกระบวนการสร้างเนื้อหาของคุณได้

ในโพสต์บล็อกนี้ เราจะเจาะลึกขั้นตอนปฏิบัติที่คุณสามารถดำเนินการได้เพื่อใช้ประโยชน์จากพลังของโมเดล Hugging Face แบบออฟไลน์ ตั้งแต่การนำโมเดลไปใช้งานจนถึงการบูรณาการอย่างราบรื่นกับเวิร์กโฟลว์ที่มีอยู่ของคุณ คุณจะได้เรียนรู้วิธีเพิ่มศักยภาพของเครื่องมือ NLP ขั้นสูงเหล่านี้ให้สูงสุด แม้ว่าจะไม่มีการเชื่อมต่ออินเทอร์เน็ตก็ตาม เตรียมพร้อมที่จะยกระดับเกมการสร้างเนื้อหาของคุณและก้าวล้ำนำหน้าผู้อื่นในโลกของการตลาดและการสื่อสารดิจิทัลที่เปลี่ยนแปลงอยู่ตลอดเวลา

เหตุใดคุณถึงอยากใช้ Huggingface Model แบบออฟไลน์?

คุณอาจสงสัยว่าทำไมถึงมีคนต้องเสียเวลารันโมเดล AI แบบออฟไลน์ แต่เชื่อฉันเถอะว่ามีเหตุผลสำคัญหลายประการที่จะทำให้คุณไม่ต้องรันโมเดล Hugging Face อีกต่อไป

สร้างเว็บไซต์ที่น่าทึ่ง

ด้วย Elementor ตัวสร้างหน้าฟรีที่ดีที่สุด

เริ่มเลยนี่คือคำอธิบายสั้นๆ ว่าเหตุใดบางคนอาจต้องการใช้โมเดล Hugging Face แบบออฟไลน์:

การใช้โมเดล Hugging Face แบบออฟไลน์มีข้อดีสำคัญหลายประการ:

- ความน่าเชื่อถือ: ทำงานโดยไม่หยุดชะงักโดยไม่ต้องกังวลเกี่ยวกับปัญหาการเชื่อมต่ออินเทอร์เน็ต

- ความเร็ว: กำจัดความล่าช้าของเครือข่ายเพื่อการอนุมานแบบจำลองที่รวดเร็วยิ่งขึ้น

- ความเป็นส่วนตัว: เก็บข้อมูลที่ละเอียดอ่อนไว้ในเครื่องและหลีกเลี่ยงความเสี่ยงด้านความปลอดภัยที่อาจเกิดขึ้นจากการประมวลผลออนไลน์

- ประหยัดต้นทุน: ลดค่าใช้จ่ายการประมวลผลบนคลาวด์ด้วยการรันโมเดลบนฮาร์ดแวร์ของคุณ

- ความสามารถในการพกพา: ใช้ความสามารถ AI ขั้นสูงในสถานที่ห่างไกลหรือพื้นที่ที่มีการเข้าถึงอินเทอร์เน็ตจำกัด

- การเรียนรู้: ได้รับความเข้าใจที่ลึกซึ้งยิ่งขึ้นเกี่ยวกับสถาปัตยกรรมและการทำงานของโมเดลโดยทำงานร่วมกับพวกเขาโดยตรง

- การปรับแต่ง: ปรับแต่งและปรับเปลี่ยนโมเดลให้เหมาะสมกับกรณีการใช้งานเฉพาะได้ง่ายขึ้นเมื่อคุณมีการเข้าถึงภายในเครื่อง

มาเจาะลึกและสำรวจวิธีใช้ประโยชน์จากศักยภาพทั้งหมดของนางแบบ Hugging Face ได้ทุกที่และทุกเวลา

วิธีการใช้ Huggingface Models แบบออฟไลน์?

Huggingface เป็นเหมือน Github หรือ app store สำหรับ AI โอเพนซอร์ส ที่นี่ คุณสามารถค้นหา ดาวน์โหลด และแม้แต่ใช้ LLM โอเพนซอร์สจำนวนมากจากเว็บไซต์นี้ นอกจากนี้ เช่นเดียวกับ ChatGPT พวกเขายังมี Hugging Chat อีกด้วย แชทบ็อตนี้ช่วยให้คุณเลือกโมเดลที่คุณต้องการใช้ และหลังจากนั้นคุณสามารถสนทนากับโมเดลนั้นได้เช่นเดียวกับที่คุณทำกับผู้ช่วย AI หลายโมเดลอื่นๆ

จะดีแค่ไหนหากสามารถใช้โมเดลเหล่านี้ได้ฟรีทุกวันแบบออฟไลน์ มาทำกันเลย

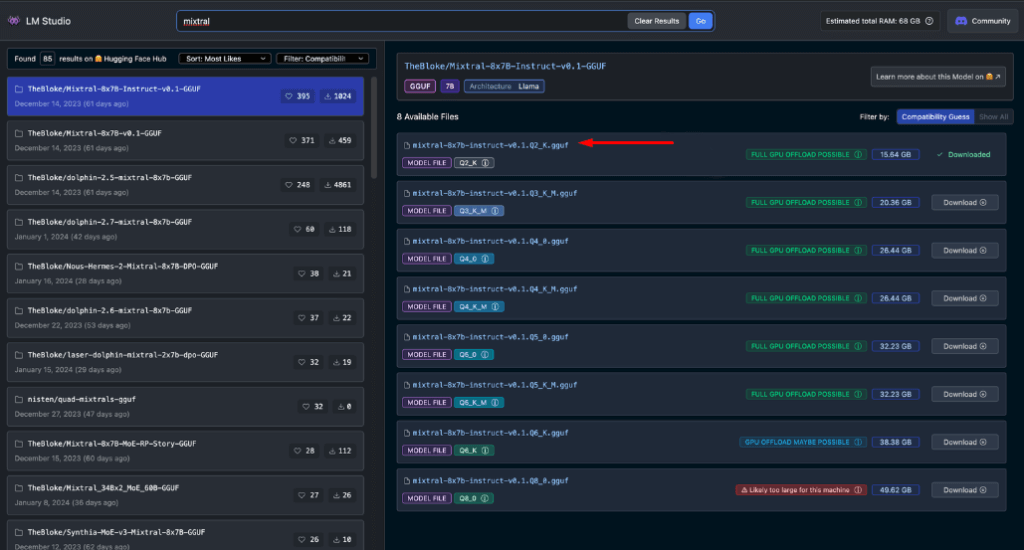

LM สตูดิโอ

LM Studio กำลังปฏิวัติวิธีที่เราใช้โมเดล AI ในพื้นที่ แอปอเนกประสงค์นี้ใช้งานได้กับ Windows, Mac (Apple Silicon) และ Linux (เบต้า) ช่วยให้ผู้ใช้สามารถดาวน์โหลดและเรียกใช้โมเดล Hugging Face แบบออฟไลน์ได้อย่างง่ายดาย

คุณสมบัติหลักของ LM Studio ได้แก่:

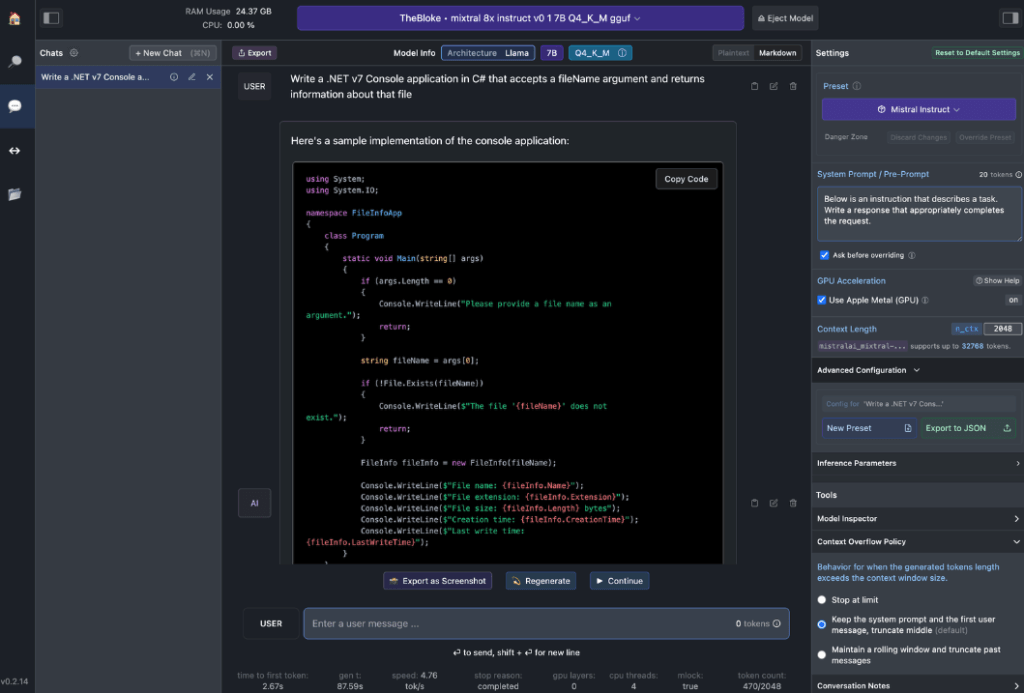

- การโต้ตอบกับโมเดลท้องถิ่น: ดาวน์โหลดโมเดลภาษาที่คุณต้องการ (LLM) และโต้ตอบกับโมเดลนั้นเหมือนกับที่คุณโต้ตอบกับผู้ช่วย AI ที่ใช้การแชท ปรับแต่งประสิทธิภาพและรูปแบบเอาต์พุต และสำรวจคุณสมบัติเชิงทดลองผ่านคำแนะนำและตัวเลือกระบบในตัวต่างๆ

- การจำลอง API ของ OpenAI: นี่คือจุดที่ LM Studio โดดเด่นอย่างแท้จริง โหลดโมเดล Hugging Face ที่คุณดาวน์โหลดมา และ LM Studio จะห่อหุ้มพร็อกซี API ภายในเครื่องอย่างชาญฉลาด โดยเลียนแบบ API ของ OpenAI ความเข้ากันได้นี้ถือเป็นตัวเปลี่ยนเกม เนื่องจากช่วยให้บูรณาการกับ SDK จำนวนมากได้อย่างราบรื่น รวมถึงส่วนขยาย Editor & IDE ยอดนิยมที่รองรับ OpenAI อยู่แล้ว

ข้อกำหนดฮาร์ดแวร์เวิร์กสเตชัน

หากต้องการปลดล็อกศักยภาพของโมเดล Hugging Face แบบออฟไลน์อย่างแท้จริง คุณจะต้องมีฮาร์ดแวร์ที่แข็งแกร่ง แม้ว่าคอมพิวเตอร์สมัยใหม่จะสามารถจัดการงานพื้นฐานได้ แต่ประสิทธิภาพที่เหมาะสมที่สุดนั้นต้องใช้สเปกที่ทรงพลังกว่า:

สำหรับผู้ใช้ Apple:

- โปรเซสเซอร์ M2/M3 Max หรือ Ultra

- การกำหนดค่าระดับสูงกว่า

- RAM มากกว่า 50 GB (ใช้ร่วมกับ GPU บน M2 SoC)

- การรองรับด้วยโลหะเพื่อประสิทธิภาพที่เพิ่มขึ้น

สำหรับผู้ใช้ Windows:

- ซีพียูแกนหลักเพิ่มมากขึ้น

- แรมที่มากเพียงพอ

- GPU ซีรีส์ RTX 30 หรือ 40 พร้อม VRAM เพียงพอ

อย่ากังวลหากคุณไม่มีระบบระดับสูงสุด มีตัวเลือก RAM และ VRAM มากมายให้เลือก แม้แต่ในรุ่นล่าสุด LM Studio จะช่วยประเมินความสามารถของระบบของคุณในขณะที่คุณเรียกดูและดาวน์โหลดรุ่นต่างๆ

โดยทั่วไป ไฟล์โมเดลขนาดใหญ่และความต้องการทรัพยากรที่สูงขึ้นจะสัมพันธ์กับคุณภาพเอาต์พุตที่ดีขึ้น แม้ว่าจะไม่ควรผลักดันระบบของคุณให้ถึงขีดจำกัดสูงสุด แต่ก็อย่ากลัวที่จะตั้งเป้าให้สูงภายในขีดความสามารถของฮาร์ดแวร์ของคุณ

โปรดจำไว้ว่า: เป้าหมายคือการสร้างสมดุลระหว่างประสิทธิภาพของโมเดลกับทรัพยากรระบบของคุณเพื่อประสบการณ์ Hugging Face แบบออฟไลน์ที่ดีที่สุด

รุ่นที่แนะนำสำหรับการใช้งานออฟไลน์

เมื่อรันโมเดล Hugging Face แบบออฟไลน์ การเลือกโมเดลที่เหมาะสมถือเป็นสิ่งสำคัญ จากการทดสอบอย่างละเอียด ฉันพบว่าโมเดลต่อไปนี้ให้ผลลัพธ์ที่น่าประทับใจอย่างสม่ำเสมอสำหรับงานแชททั่วไปและการเขียนโค้ด:

โมเดลเหล่านี้แต่ละรุ่นมีความสมดุลที่เป็นเอกลักษณ์เฉพาะตัวระหว่างประสิทธิภาพและการใช้ทรัพยากร ซึ่งทำให้เป็นตัวเลือกที่ยอดเยี่ยมสำหรับการใช้งานแบบออฟไลน์

ก่อนที่จะดำเนินการต่อ สิ่งสำคัญคือต้องประเมินโมเดลเหล่านี้ด้วยตนเอง:

- ดาวน์โหลดแต่ละโมเดลใน LM Studio

- ใช้แท็บแชท AI เพื่อโต้ตอบกับโมเดล

- ทดสอบประสิทธิภาพในการทำงานต่างๆ โดยเฉพาะการเขียนโค้ดหากนั่นคือจุดเน้นของคุณ

- ประเมินคุณภาพของผลลัพธ์และว่าตรงตามความต้องการของคุณมากเพียงใด

โปรดจำไว้ว่าประสบการณ์ของคุณอาจแตกต่างกันไปขึ้นอยู่กับกรณีการใช้งานเฉพาะและความสามารถของฮาร์ดแวร์ของคุณ ใช้เวลาในการค้นหาโมเดลที่เหมาะกับความต้องการของคุณมากที่สุด กระบวนการคัดเลือกอย่างรอบคอบนี้จะช่วยให้คุณมีโมเดล Hugging Face ออฟไลน์ที่มีประสิทธิภาพสูงสุดสำหรับความต้องการของคุณก่อนที่จะดำเนินการผสานรวมและการใช้งานขั้นสูงเพิ่มเติม

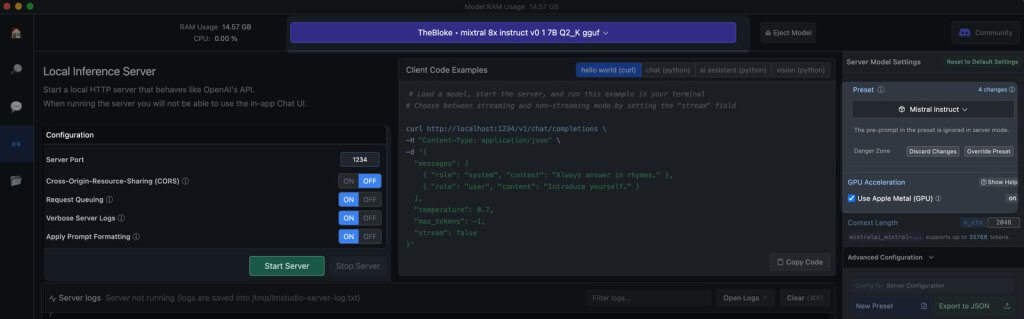

เซิร์ฟเวอร์ท้องถิ่นเข้าสู่ LM Studio

การเปิดตัวเซิร์ฟเวอร์โมเดล Hugging Face แบบออฟไลน์เป็นเรื่องง่ายมาก:

- เปิด LM Studio

- เลือกหนึ่งในโมเดลที่คุณดาวน์โหลด

- คลิกปุ่ม เริ่มเซิร์ฟเวอร์

แค่นั้นเอง การตั้งค่าเริ่มต้นนั้นเหมาะกับผู้ใช้ส่วนใหญ่ อย่างไรก็ตาม หากคุณต้องการปรับแต่งประสบการณ์ของคุณ คุณสามารถปรับตัวเลือกให้ตรงกับความต้องการหรือความชอบเฉพาะของคุณได้

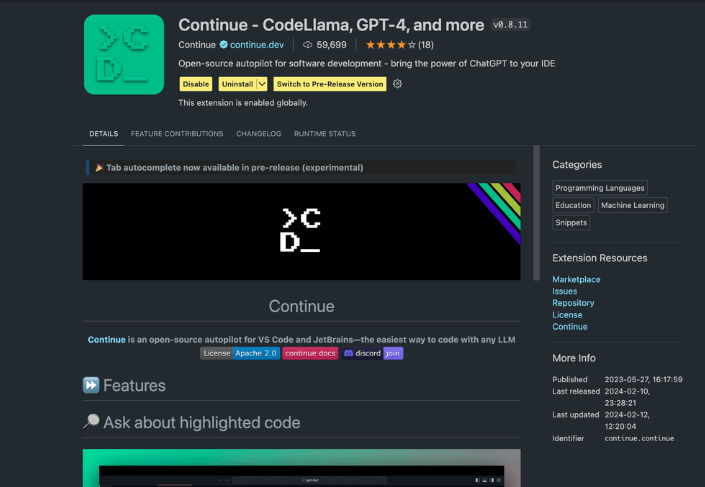

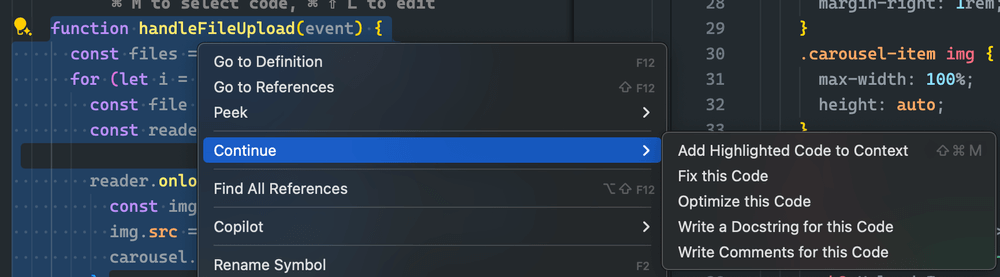

การใช้ส่วนขยาย Continue

จาก VS Code Studio ที่เปิดใช้งานแล้ว ให้ไปที่มุมมองส่วนขยาย ในแถบค้นหา ให้พิมพ์ "ดำเนินการต่อ" ค้นหาส่วนขยายที่ถูกต้อง แล้วติดตั้ง

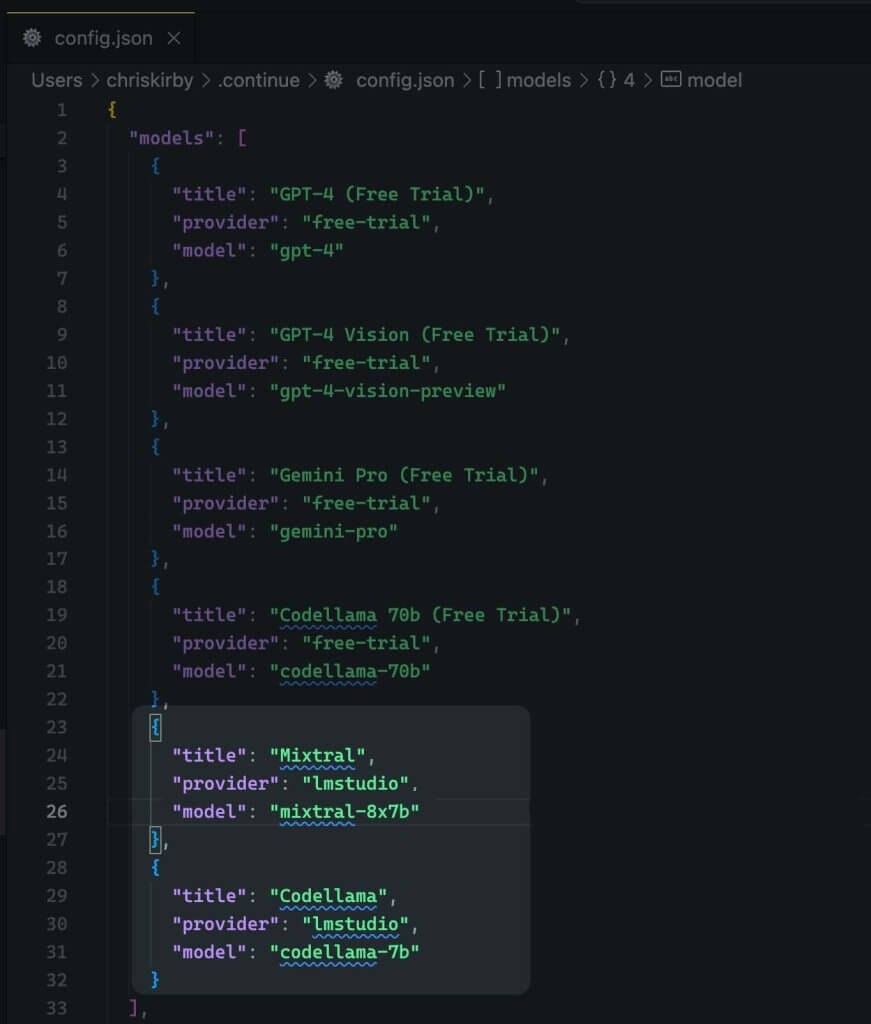

ตอนนี้เราต้องเปลี่ยนการกำหนดค่า JSON ของส่วนขยาย ซึ่งจะเพิ่มการรองรับ LM Studio

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

ตอนนี้บันทึกมันไว้

ต่อไปคุณต้องใช้โมเดลท้องถิ่นนี้แทนโค้ด VS

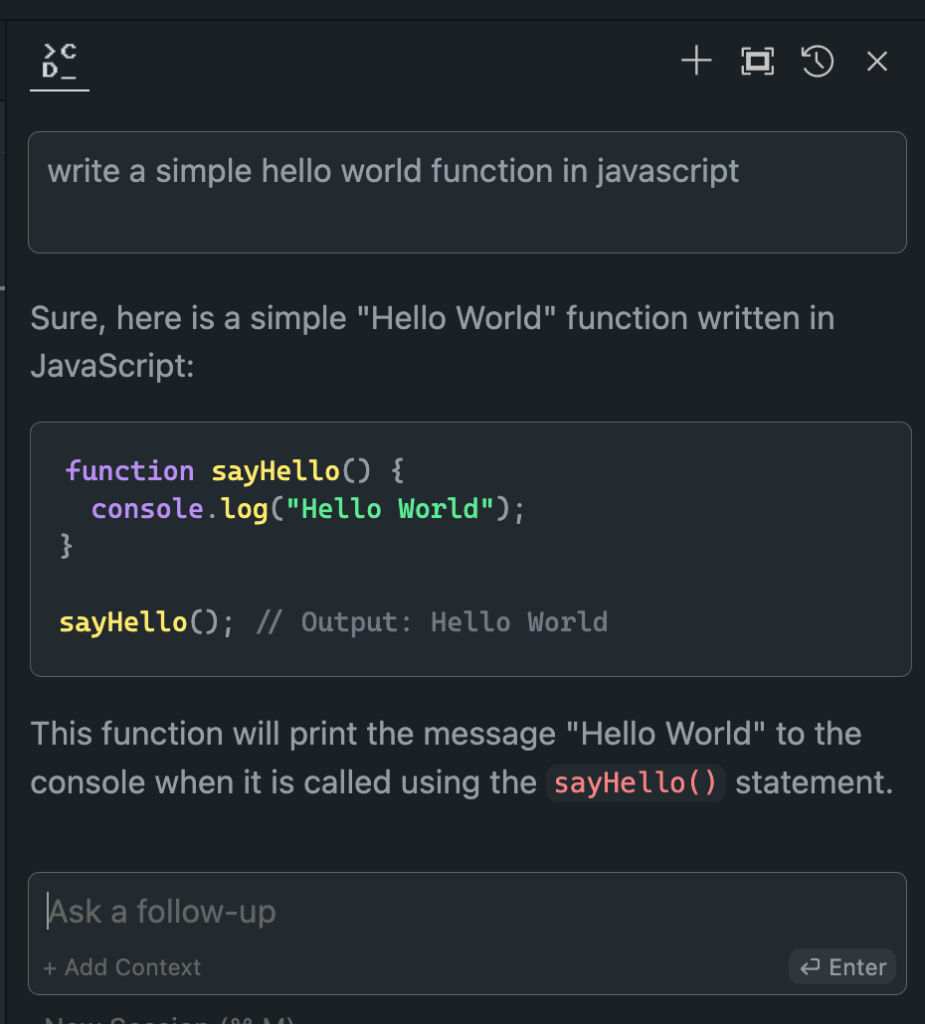

การประเมินประสิทธิภาพของโมเดลออฟไลน์เทียบกับออนไลน์

ตอนนี้เราได้สร้างโมเดล Hugging Face แบบออฟไลน์เสร็จแล้ว ก็ถึงเวลาแห่งความจริง มาทดสอบกับโมเดลแบบออนไลน์กันเลย!

จากการทดลองอย่างกว้างขวางของฉัน ผลลัพธ์ที่ได้นั้นเปิดหูเปิดตาฉันมาก:

- ประสิทธิภาพ: โมเดลออฟไลน์มักจะตรงกันหรือในบางกรณีอาจเหนือกว่าโมเดลออนไลน์ด้วยซ้ำ

- ความเร็ว: หากไม่มีความล่าช้าของเครือข่าย การตอบสนองก็จะรวดเร็วทันใจ

- ความสม่ำเสมอ: ไม่มีการเปลี่ยนแปลงอีกต่อไปเนื่องจากโหลดของเซิร์ฟเวอร์หรือปัญหาการเชื่อมต่อ

แม้ว่าประสบการณ์ของคุณอาจแตกต่างกันไปขึ้นอยู่กับรุ่นและฮาร์ดแวร์ที่คุณเลือก อย่าแปลกใจหากคุณพบว่าคุณชอบเวอร์ชันออฟไลน์มากกว่า การผสมผสานพลังการประมวลผลภายในเครื่องและรุ่นปรับแต่งอย่างละเอียดสามารถให้ผลลัพธ์ที่น่าประทับใจได้

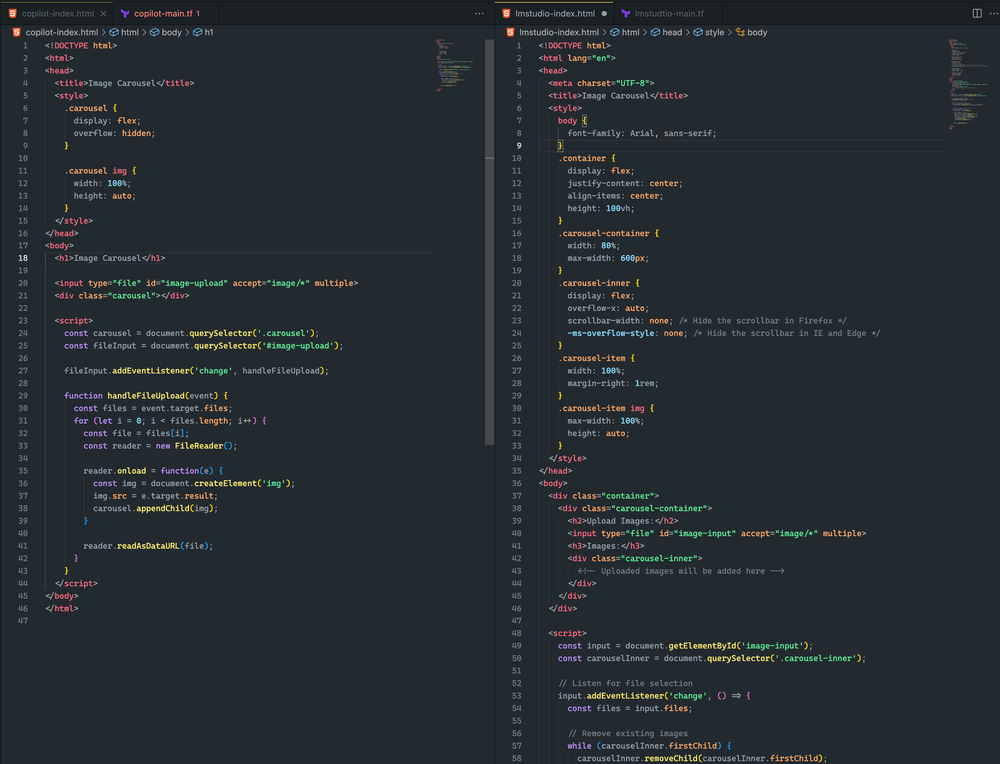

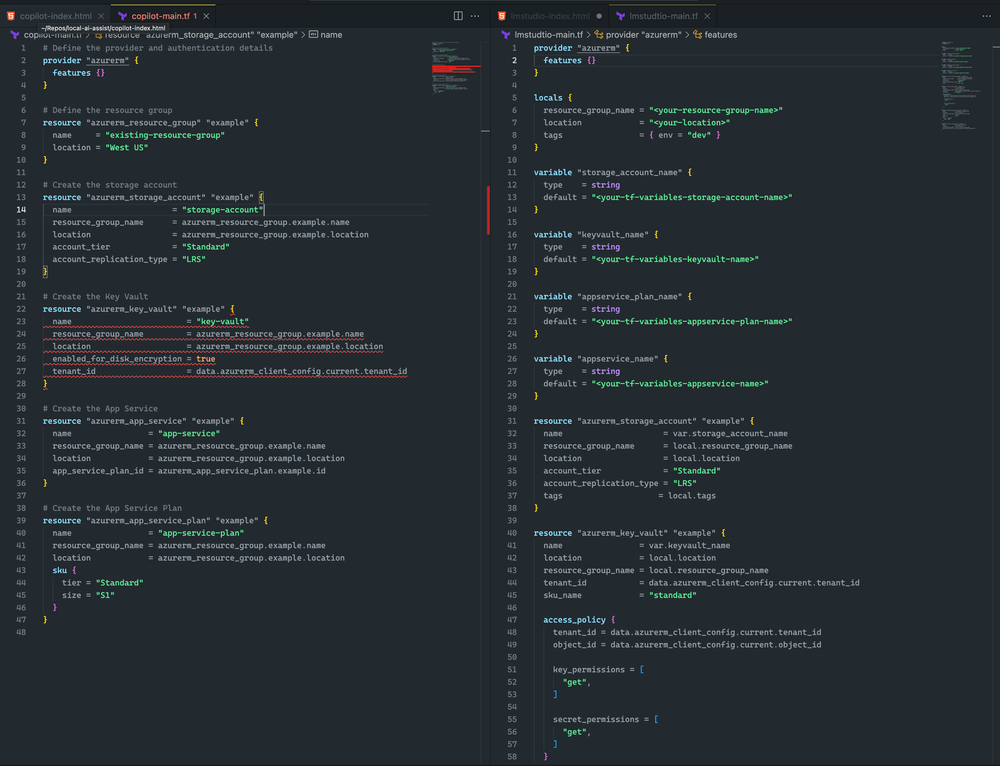

มาดูความแตกต่างกันที่นี่

ทั้งสองวิธีค่อนข้างใกล้เคียงกัน แม้ว่าจะไม่มีวิธีใดที่ทำให้เกิดภาพหมุนวน แต่ฉันก็สามารถอัปโหลดภาพได้สำเร็จ และแสดงผลในทั้งสองตัวอย่าง ด้วยการปรับแต่งที่รวดเร็วยิ่งขึ้น ฉันเชื่อว่าฉันสามารถบรรลุผลลัพธ์ที่ดีขึ้นได้

ฉันเอนเอียงไปทาง LM Studio และ Mixtral เนื่องจาก Terraform ครอบคลุมมากกว่าและไม่มีข้อผิดพลาดทางไวยากรณ์ อย่างไรก็ตาม CoPilot มีปัญหาเล็กน้อย: การประกาศคีย์วอลต์ขาด sku_name ซึ่งแก้ไขได้ง่าย

การห่อหุ้ม

โปรดจำไว้ว่าสาขา AI กำลังพัฒนาอย่างรวดเร็ว การเชี่ยวชาญการใช้งาน Hugging Face แบบออฟไลน์ไม่เพียงทำให้คุณตามทันเท่านั้น แต่ยังทำให้คุณก้าวล้ำหน้าผู้อื่นด้วย ไม่ว่าคุณจะเป็นนักพัฒนา นักวิจัย หรือผู้ที่ชื่นชอบ AI ทักษะนี้จะช่วยให้คุณขยายขอบเขตของสิ่งที่เป็นไปได้ด้วยการประมวลผล AI ในพื้นที่

ดังนั้น ให้เริ่มทดลอง ทดลองใช้โมเดลต่างๆ ปรับแต่งการตั้งค่าของคุณ และผสานรวมโมเดลออฟไลน์ที่ทรงพลังเหล่านี้เข้ากับเวิร์กโฟลว์ของคุณ คุณอาจพบว่าอนาคตของการพัฒนา AI อยู่บนเครื่องของคุณแล้ว และรอที่จะถูกปลดปล่อย