Поскольку мир становится все более цифровым, спрос на высококачественный контент никогда не был выше. К счастью, достижения в обработке естественного языка (NLP) привели к появлению мощных инструментов письма на основе искусственного интеллекта, таких как разработанные Hugging Face. Но что, если вам нужно использовать эти модели офлайн? Не бойтесь, поскольку мы рассмотрим, как использовать модели Hugging Face без подключения к интернету.

Офлайн-доступ к передовым языковым моделям Hugging Face открывает целый мир возможностей. Независимо от того, работаете ли вы в удаленных местах, имеете дело с ненадежным подключением к Интернету или просто отдаете приоритет конфиденциальности данных, возможность локального запуска этих моделей может стать переломным моментом. Поняв, как развертывать модели Hugging Face в офлайн-режиме, вы сможете открыть новые уровни эффективности, гибкости и контроля в процессе создания контента.

В этой записи блога мы рассмотрим практические шаги, которые вы можете предпринять, чтобы использовать возможности моделей Hugging Face в автономном режиме. От развертывания модели до бесшовной интеграции с вашими существующими рабочими процессами вы узнаете, как максимально использовать потенциал этих передовых инструментов NLP, даже если подключение к Интернету не всегда доступно. Приготовьтесь поднять уровень своей игры в создании контента и оставайтесь на шаг впереди в постоянно меняющемся мире цифрового маркетинга и коммуникаций.

Почему вам может понадобиться использовать модель Huggingface офлайн?

Вы можете задаться вопросом, зачем кому-то беспокоиться об использовании моделей ИИ в автономном режиме. Но поверьте мне, есть несколько действительно веских причин, чтобы убрать ваши модели Hugging Face из сети.

Создавайте потрясающие сайты

С лучшим бесплатным конструктором страниц Elementor

Начать сейчасВот краткое объяснение того, почему кому-то может понадобиться использовать модели Hugging Face офлайн:

Использование моделей Hugging Face в автономном режиме имеет несколько ключевых преимуществ:

- Надежность: работайте бесперебойно, не беспокоясь о проблемах с подключением к Интернету.

- Скорость: устранение задержек в сети для более быстрого вывода модели.

- Конфиденциальность: храните конфиденциальные данные локально, избегая потенциальных рисков безопасности при их онлайн-обработке.

- Экономическая эффективность: сократите расходы на облачные вычисления, запуская модели на своем оборудовании.

- Портативность: используйте передовые возможности ИИ в удаленных местах или зонах с ограниченным доступом в Интернет.

- Обучение: получите более глубокое понимание архитектуры и функционирования моделей, работая с ними напрямую.

- Настройка: более простая настройка и адаптация моделей для конкретных вариантов использования при наличии локального доступа.

Давайте углубимся в тему и узнаем, как раскрыть весь потенциал моделей Hugging Face в любое время и в любом месте.

Как использовать модели Huggingface офлайн?

Huggingface — это как Github или магазин приложений для ИИ с открытым исходным кодом. Здесь вы можете просматривать, загружать и даже использовать многочисленные LLM с открытым исходным кодом с этого сайта. Более того, как и ChatGPT, у них есть Hugging Chat. Этот чат-бот позволяет вам выбрать модель, которую вы хотите использовать, и позже вы можете вести с ней беседу, как и с любым другим помощником ИИ с несколькими моделями.

Как было бы здорово использовать эти модели совершенно бесплатно, офлайн ежедневно? Давайте сделаем это.

Студия ЛМ

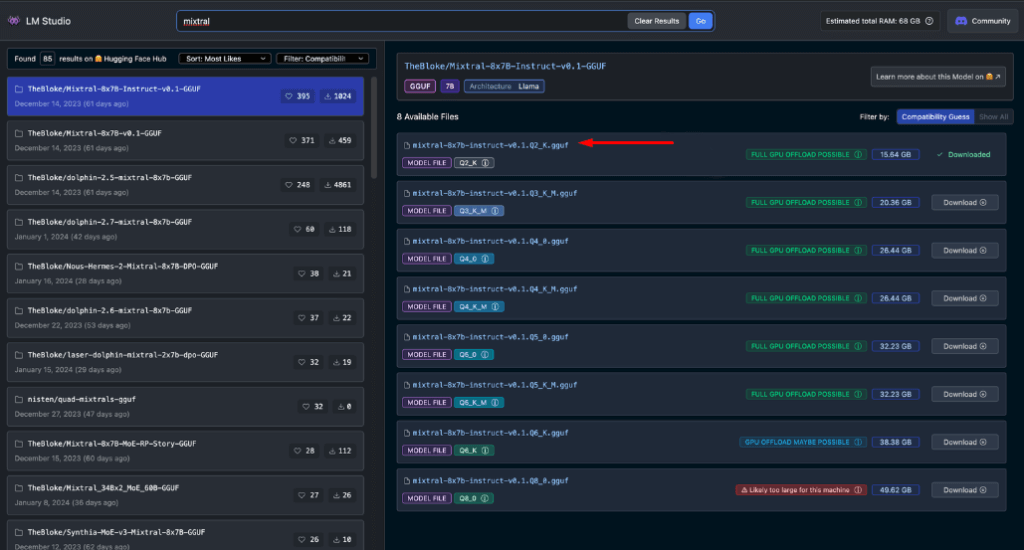

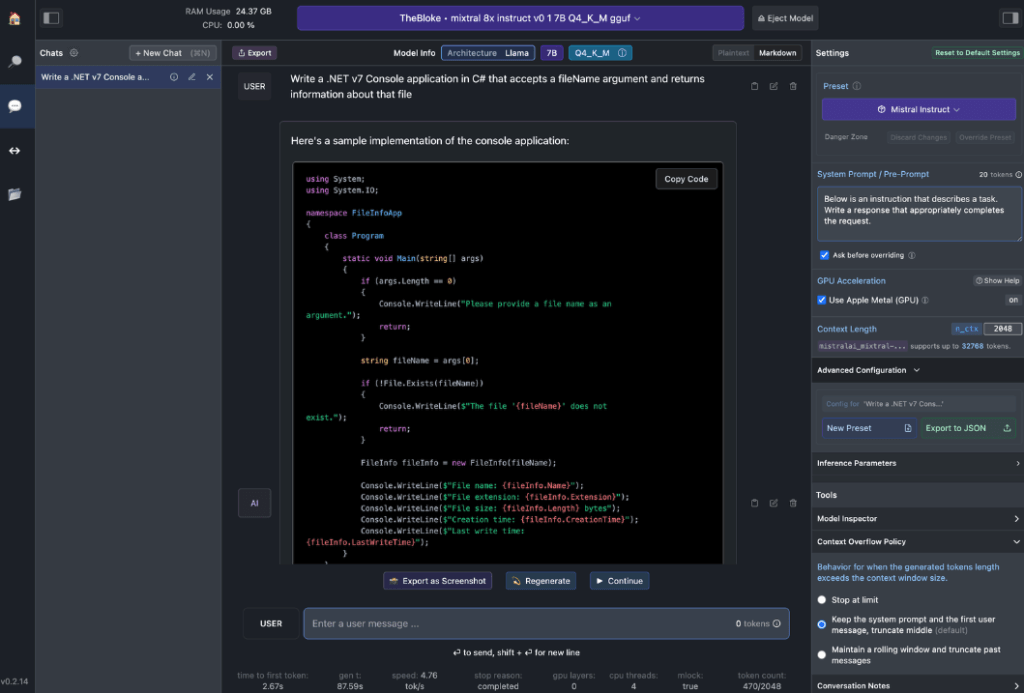

LM Studio меняет способ локального использования моделей ИИ. Это универсальное приложение, доступное для Windows, Mac (Apple Silicon) и Linux (бета-версия), позволяет пользователям легко загружать и запускать модели Hugging Face в автономном режиме.

Ключевые особенности LM Studio включают в себя:

- Взаимодействие с локальной моделью: загрузите предпочтительную языковую модель (LLM) и взаимодействуйте с ней так же, как с любым помощником на основе ИИ в чате. Настройте производительность и формат вывода, а также изучите экспериментальные функции с помощью различных встроенных системных подсказок и опций.

- Эмуляция API OpenAI: вот где LM Studio действительно блистает. Загрузите загруженную модель Hugging Face, и LM Studio изобретательно обернет ее локальным прокси API, имитируя API OpenAI. Эта совместимость меняет правила игры, поскольку она обеспечивает бесшовную интеграцию с многочисленными SDK и популярными расширениями Editor & IDE, которые уже поддерживают OpenAI.

Требования к оборудованию рабочей станции

Чтобы по-настоящему раскрыть потенциал офлайн-моделей Hugging Face, вам понадобится надежное оборудование. Хотя любой современный компьютер может справиться с базовыми задачами, для оптимальной производительности требуются более мощные характеристики:

Для пользователей Apple:

- Процессоры M2/M3 Max или Ultra

- Конфигурации более высокого класса

- 50+ ГБ оперативной памяти (совместно с графическим процессором на M2 SoC)

- Металлическая опора для повышения производительности

Для пользователей Windows:

- Больше ядер ЦП

- Значительный объем оперативной памяти

- Графический процессор серии RTX 30 или 40 с достаточным объемом видеопамяти

Не беспокойтесь, если у вас нет топовой системы. Существует множество вариантов, дружественных к ОЗУ и VRAM, даже среди последних моделей. LM Studio услужливо оценивает возможности вашей системы, когда вы просматриваете и загружаете модели.

Как правило, более крупные файлы моделей и более высокие требования к ресурсам коррелируют с улучшенным качеством вывода. Хотя лучше не загружать систему до абсолютных пределов, не бойтесь нацеливаться высоко в рамках возможностей вашего оборудования.

Помните: цель состоит в том, чтобы сбалансировать производительность модели с ресурсами вашей системы для наилучшего опыта офлайн-обнимания.

Рекомендуемые модели для использования в автономном режиме

При запуске моделей Hugging Face в автономном режиме выбор правильной модели имеет решающее значение. Благодаря обширному тестированию я обнаружил, что следующие модели обеспечивают неизменно впечатляющие результаты как для общих задач чата, так и для задач кодирования:

Каждая из этих моделей предлагает уникальный баланс производительности и использования ресурсов, что делает их отличным выбором для автономного развертывания.

Прежде чем двигаться дальше, важно самостоятельно оценить эти модели:

- Загрузите каждую модель в LM Studio

- Используйте вкладку чата ИИ для взаимодействия с моделью

- Проверьте его производительность на различных задачах, особенно на программировании, если это ваша основная задача.

- Оцените качество результатов и их соответствие вашим потребностям.

Помните, что ваш опыт может отличаться в зависимости от вашего конкретного варианта использования и возможностей оборудования. Уделите время поиску модели, которая наилучшим образом соответствует вашим требованиям. Этот тщательный процесс выбора гарантирует, что у вас будет самая эффективная офлайн-модель Hugging Face для ваших нужд, прежде чем вы перейдете к интеграции и более продвинутому использованию.

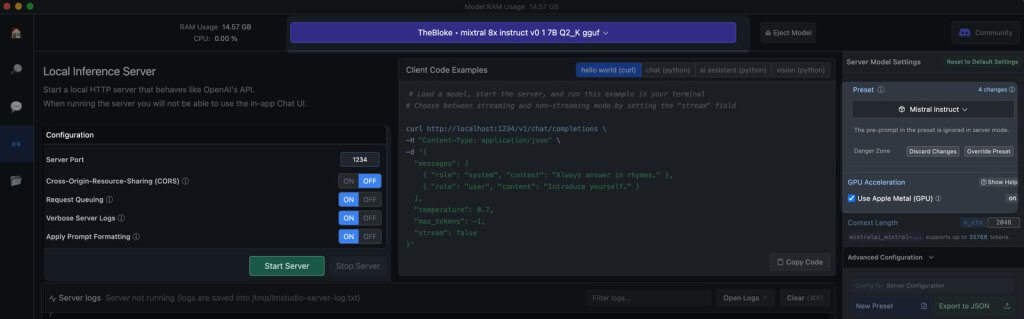

Локальный сервер в LM Studio

Запустить офлайн-сервер модели Hugging Face очень просто:

- Открыть LM-студию

- Выберите одну из загруженных вами моделей

- Нажмите кнопку «Запустить сервер».

Вот и все! Настройки по умолчанию, как правило, подходят большинству пользователей. Однако, если вы хотите настроить свой опыт более точно, не стесняйтесь изменять параметры в соответствии с вашими конкретными потребностями или предпочтениями.

Использование продолжения расширения

Из запущенной студии VS code перейдите в представление расширений. В строке поиска введите «Продолжить». Найдите нужное расширение и установите его.

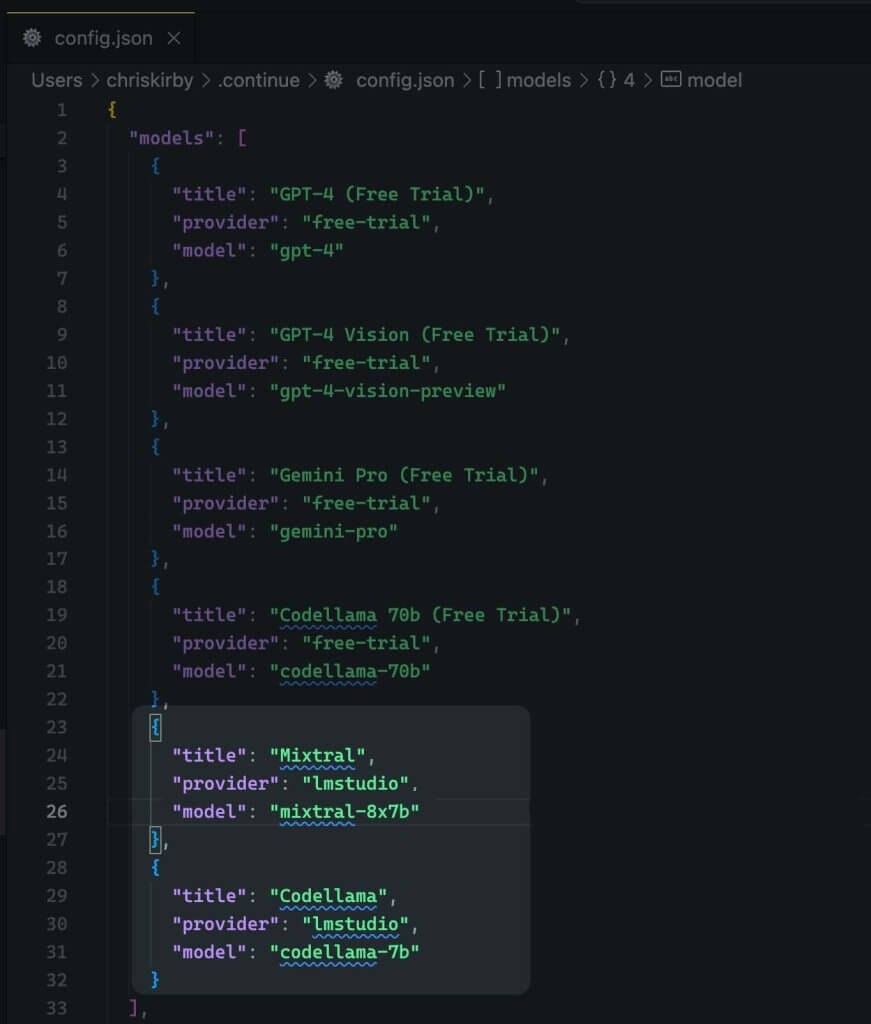

Теперь нам нужно изменить конфигурацию JSON расширения. Это добавит поддержку LM Studio.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Теперь сохраните его.

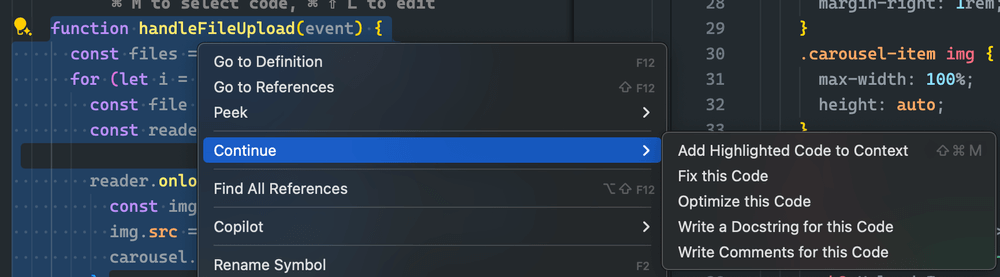

Далее вам необходимо использовать эту локальную модель вместо кода VS.

Оценка эффективности офлайн- и онлайн-моделей

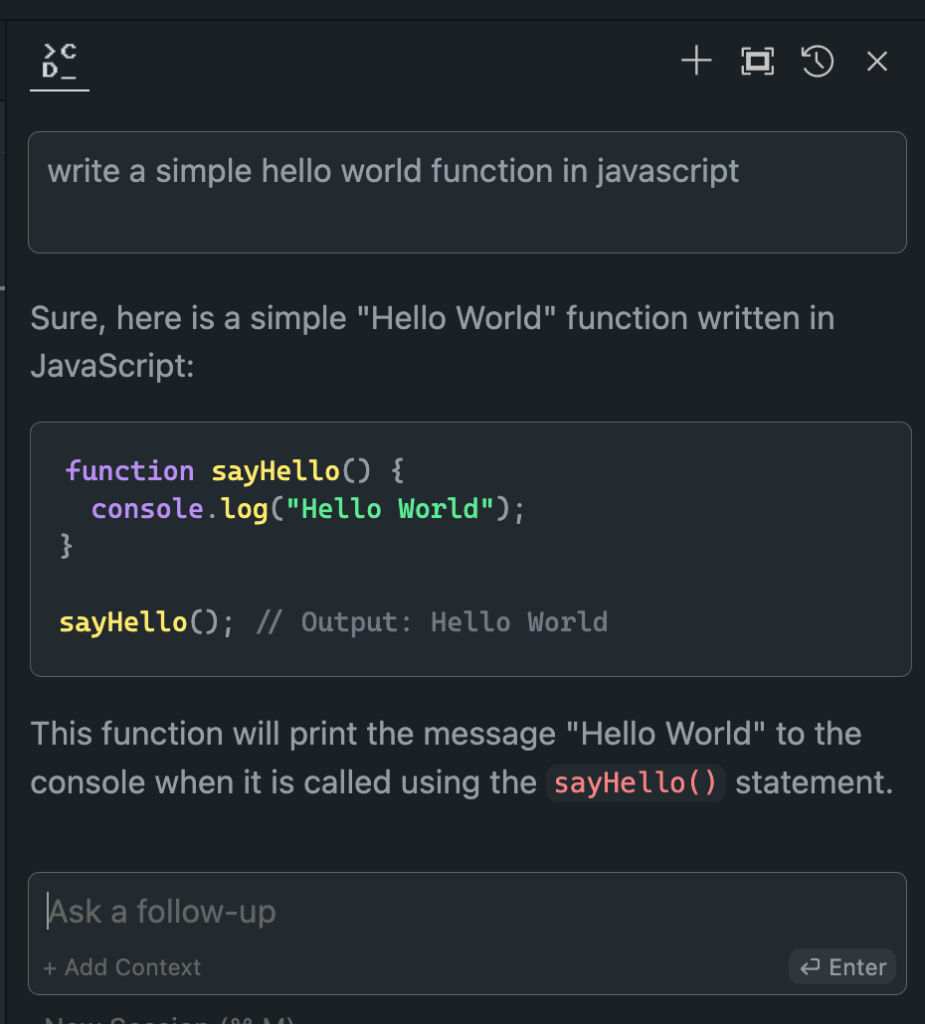

Теперь, когда мы настроили нашу офлайновую модель Hugging Face, пришло время для момента истины. Давайте проверим ее на ее онлайн-аналогах!

Результаты моих обширных испытаний оказались ошеломляющими:

- Производительность: офлайн-модель часто соответствует, а в некоторых случаях даже превосходит свои онлайн-аналоги.

- Скорость: без задержек в сети ответы могут быть молниеносными.

- Согласованность: больше никаких колебаний из-за нагрузки на сервер или проблем с подключением.

Хотя ваш опыт может различаться в зависимости от выбранной вами модели и оборудования, не удивляйтесь, если вы обнаружите, что предпочитаете офлайн-версию. Сочетание локальной вычислительной мощности и точно настроенных моделей может дать впечатляющие результаты.

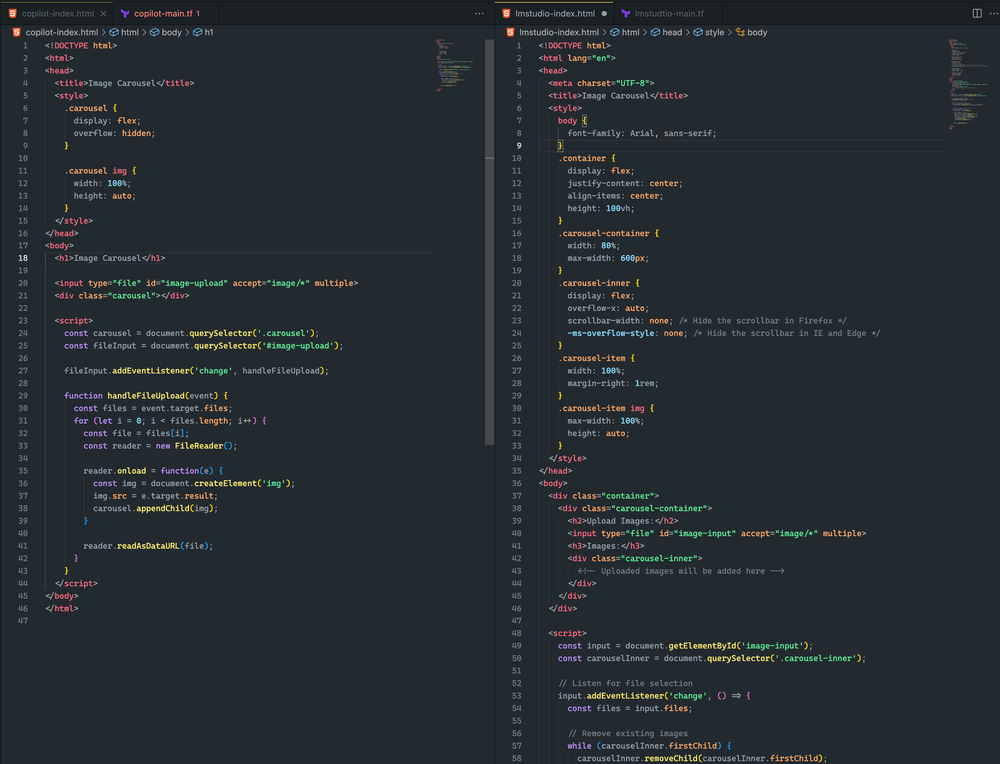

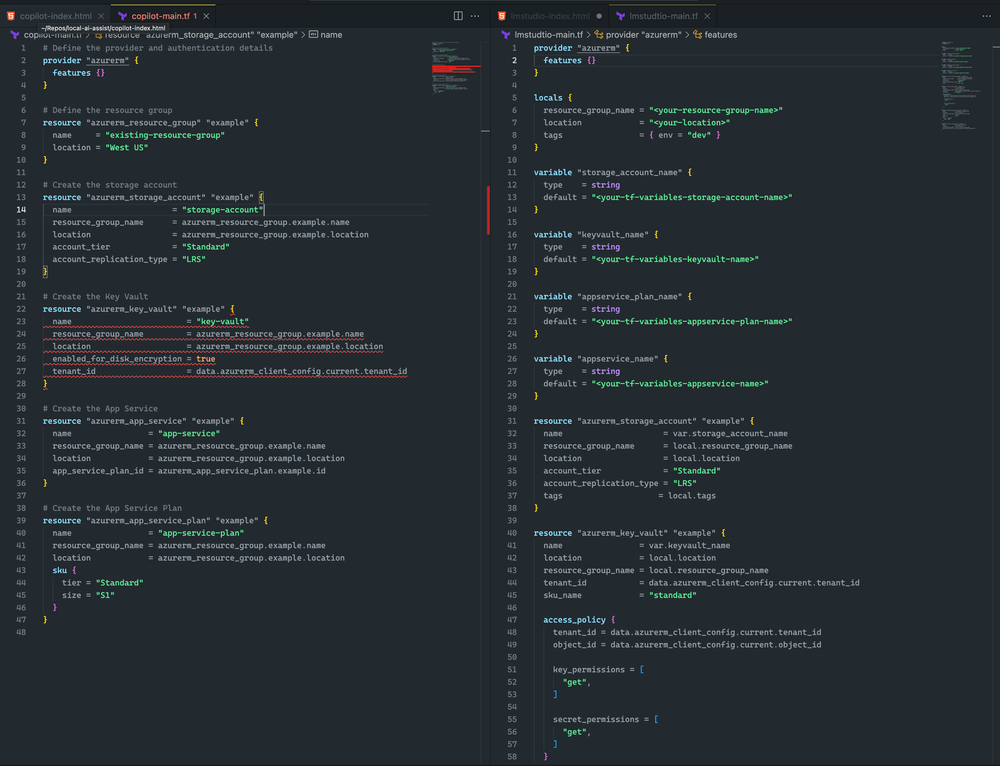

Вот видите разницу.

Оба подхода были довольно близки. Хотя ни один из них не привел к карусели изображений, я успешно загрузил изображение, и оно отобразилось в обоих примерах. С дальнейшими оперативными корректировками я считаю, что смогу достичь еще лучшего результата

Я склоняюсь к LM Studio и Mixtral, потому что Terraform более полный и не имеет синтаксических ошибок. Однако у CoPilot есть небольшая проблема: в объявлении хранилища ключей отсутствует sku_name , что можно легко исправить.

Подведение итогов

Помните, что область ИИ стремительно развивается. Осваивая офлайн-развертывание моделей Hugging Face, вы не просто идете в ногу со временем — вы опережаете события. Независимо от того, являетесь ли вы разработчиком, исследователем или энтузиастом ИИ, этот навык позволяет вам раздвигать границы возможностей локальной обработки ИИ.

Итак, дерзайте. Экспериментируйте с разными моделями, настраивайте настройки и интегрируйте эти офлайн-мощности в свой рабочий процесс. Вы можете обнаружить, что будущее разработки ИИ уже здесь, на вашей локальной машине, и ждет, когда его выпустят на волю.