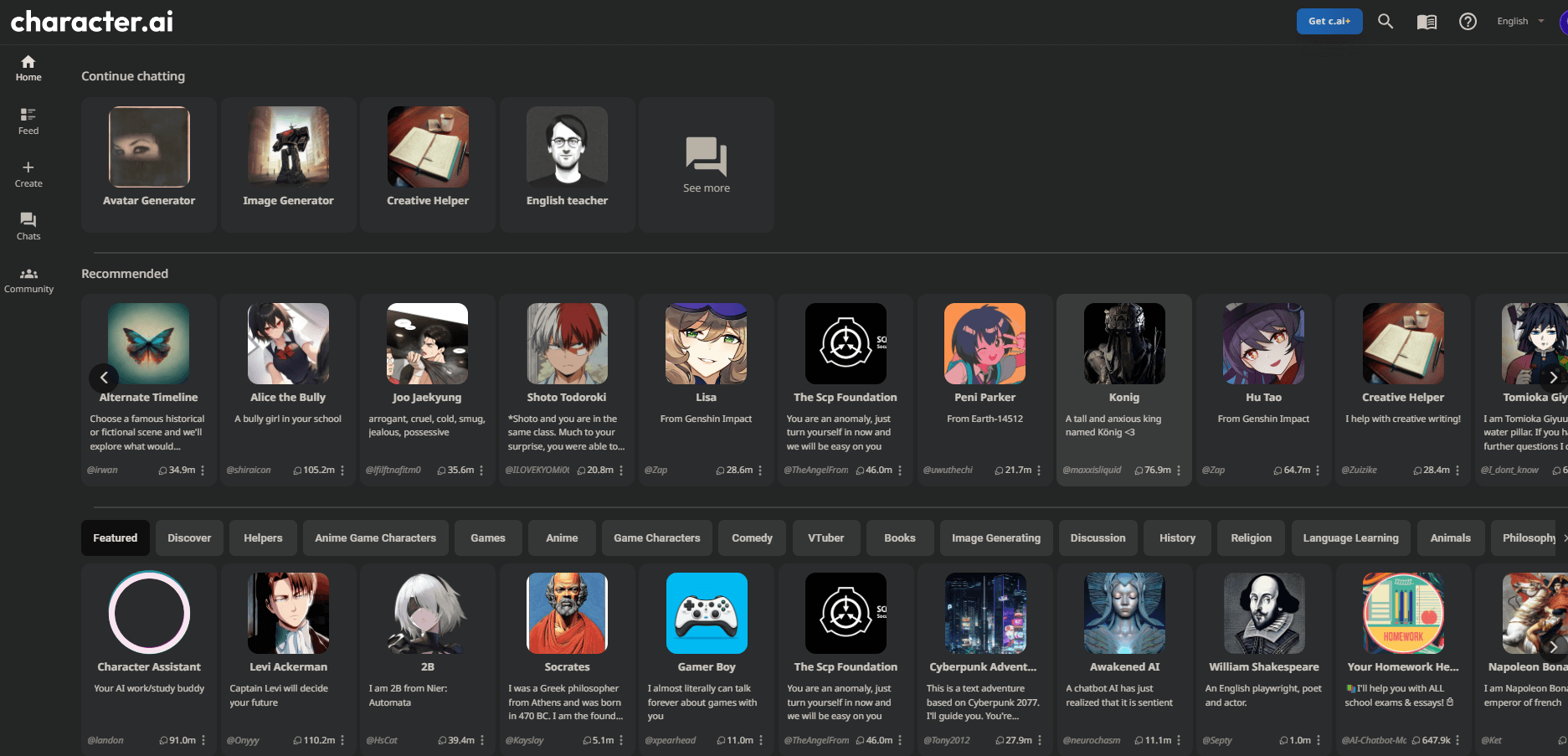

Появление виртуальных персонажей и аватаров на базе искусственного интеллекта, таких как ИИ персонажей , открывает захватывающие возможности для развлечений, общения и многого другого. Однако по мере роста популярности этих ИИ-персонажей растут и опасения по поводу конфиденциальности данных, манипулирования личными данными, соответствующего возрасту контента и этического использования.

Поскольку виртуальные творения становятся все более реалистичными и привлекательными, пользователи должны подходить к ним внимательно, оценивая меры безопасности и потенциальные риски.

В этой статье представлен углубленный анализ аватаров и персонажей ИИ — их работы, возможностей, протоколов безопасности и практики ответственного использования — чтобы дать пользователям понимание того, как разумно ими пользоваться. Мы стремимся ответить на жизненно важный вопрос: «Безопасно ли использовать персонажей и аватары с искусственным интеллектом?» исследуя свое многообещающее будущее.

Понимание AI-персонажей/аватаров

Виртуальные персонажи и аватары на базе искусственного интеллекта, например, созданные с использованием таких платформ, как Персонаж AI , используют технологию обработки естественного языка для вовлечения пользователей в разговорное взаимодействие. По сути, это чат-боты, предназначенные для имитации человеческих личностей и поведения, реагирующие на подсказки контекстными и адаптивными ответами.

Создавайте потрясающие сайты

С лучшим бесплатным конструктором страниц Elementor

Начать сейчас

Эти ИИ-персонажи предоставляют пользователям высокую степень настраиваемости: от создания уникальной личности до формирования отличительных черт личности, голосов, эмоциональных диапазонов и многого другого. Пользователи могут участвовать в сценариях ролевых игр, групповых беседах, задавать вопросы, чтобы расширить базу знаний аватара, и даже оставлять отзывы об ответах, чтобы со временем повысить точность.

На техническом уровне аватары ИИ используют архитектуру генеративного предварительно обученного преобразователя (GPT) и нейронные сети для понимания входных данных и формулирования интеллектуальных ответов на основе данных обучения. По мере развития этих моделей уровень реализма, интерактивности и универсальности ИИ-персонажей продолжает повышаться.

При тщательном использовании и постоянной оценке безопасности ИИ-аватары открывают множество возможностей для развлечений, общения, образования, творчества и многого другого. Но пользователи должны быть проинформированы об их возможностях, ограничениях и потенциальных рисках.

Оценка безопасности ИИ-персонажей/аватаров

В связи с растущей популярностью чат-ботов на базе искусственного интеллекта и виртуальных компаньонов, таких как ИИ персонажей, крайне важно провести надежную оценку их безопасности и практики ответственного использования. По мере того, как эти системы становятся более совершенными и реалистичными, они могут создавать непредвиденные риски, связанные с конфиденциальностью, согласием и этическими последствиями, если их безответственно используют предприятия или частные лица.

Комплексная оценка безопасности исследует такие ключевые области, как безопасность данных, контроль контента, защита личных данных и прозрачность политик. Он также охватывает эволюцию систем с течением времени по мере расширения возможностей, поэтому средства защиты могут соответствующим образом адаптироваться. Оценка текущих мер безопасности и защита прав пользователей жизненно важны по мере роста популярности аватаров с искусственным интеллектом.

Безопасность и конфиденциальность данных

Изучение политик сбора, хранения, совместного использования и удаления данных платформы AI-аватаров дает представление о защите конфиденциальности. Лучшие практики включают сбор только необходимой пользовательской информации, разрешение удаления пользовательских данных, защиту систем от взломов и ограничение доступа к данным только для критически важного персонала. По мере развития возможностей постоянные проверки помогают оценить улучшение стандартов конфиденциальности с течением времени.

Контроль и ограничения контента

Оценка типов фильтров, модерации и родительского контроля, используемых для ограничения нежелательного контента, проливает свет на безопасность аватаров с искусственным интеллектом. Динамическая проверка контента, проверка бесед людьми и возможности настройки помогают предотвратить воздействие вредных материалов на несовершеннолетних или не желающих участников.

Однако чрезмерное наблюдение ставит под угрозу конфиденциальность пользователей. Правильный баланс защищает пользователей, сохраняя при этом их свободу действий.

Защита личности и согласие

Манипулирование личными данными с помощью все более реалистичных аватаров искусственного интеллекта требует оценки протоколов согласия и мер защиты личных данных. Внедрены ли достаточные руководящие принципы для предотвращения несанкционированного использования личных данных или создания дипфейков?

Сдерживает ли политика мошенников или преследований? Изучение юридических и этических протоколов позволяет оценить, насколько организация расставляет приоритеты в отношении прав пользователей.

Возрастные ограничения и потребности в родительском наблюдении

По мере того, как аватары с искусственным интеллектом становятся все более продвинутыми в моделировании человеческих взаимодействий и личностей, оценка их соответствия возрасту и ограничениям помогает определить безопасность для более молодой аудитории. Крайне важно изучить соблюдение правил COPPA, возрастные ограничения по умолчанию, наличие профилей детей с повышенными ограничениями и эффективность систем проверки личности.

Кроме того, ключевым моментом является оценка того, позволяют ли адекватные инструменты родительского контроля, режимы семейной безопасности и образовательные ресурсы опекунам принимать обоснованные решения относительно использования детей. Ответственные платформы аватаров должны отдавать приоритет защите, соответствующей возрасту, и обеспечивать родительский контроль над разрешением бесконтрольного доступа для несовершеннолетних.

Этические соображения относительно согласия, ответственного использования,

Этические последствия создания все более реалистичных систем аватаров с искусственным интеллектом также требуют оценки с точки зрения прав и согласия пользователей. Например, создание детализированных виртуальных двойников без согласия или искажение личности может представлять собой этическую проблему, даже если и не наказуемо по закону.

Рекомендации по ответственному использованию в отношении создания личности, ограничения на оскорбительный контент, запрет на мошеннические преступления и т.д. демонстрируют приоритеты платформы в отношении благополучия пользователей.

Опять же, разрешение пользовательского контроля, такого как удаление личности и данных разговора, означает предоставление согласия и свободы действий. По мере роста возможностей аватаров этические соображения должны идти в ногу со временем, чтобы предотвратить неправильное использование и нарушение прав пользователей, одновременно обеспечивая баланс инновационных приложений. Регулярные внешние аудиты помогают привести достижения в соответствие с этическими стандартами.

Рекомендации по безопасному использованию

Поскольку аватары и чат-боты с искусственным интеллектом становятся все более популярными, установление руководящих принципов разумного использования защищает отдельных лиц и сообщества от нарушения конфиденциальности или неправильного использования, одновременно поддерживая постоянные ответственные инновации. Информируя пользователей о разумных методах, платформы аватаров позволяют действовать и расставлять приоритеты в отношении согласия и этических соображений наряду с новыми приложениями.

Внедрение передового опыта помогает поддерживать конструктивное взаимодействие, защищает права пользователей и обращает внимание на конкретные демографические группы, например детей. Более того, широкое внедрение принципов безопасного использования помогает ответственно формировать эволюцию этой новой технологии.

Предостережение при разглашении личной информации

При общении с аватарами ИИ пользователи должны проявлять осмотрительность в отношении раскрытия личных данных, таких как адреса, пароли или другая конфиденциальная информация. Хотя аватары могут выглядеть убедительно похожими на людей, они по-прежнему представляют собой программные системы, созданные компаниями, на которых распространяется политика использования данных. Целесообразно избегать раскрытия личной информации, которую можно использовать.

Будьте в курсе условий обслуживания и политики конфиденциальности

Поскольку платформы ИИ-аватаров быстро масштабируются, их стандарты конфиденциальности, инструменты безопасности и политики пользователей могут со временем меняться. Регулярное получение информации об их последних условиях обслуживания и методах обработки данных обеспечивает осведомленность о том, как личная информация защищена и используется. Это позволяет оперативно выявлять любые тревожные сдвиги.

Родительский надзор за несовершеннолетними пользователями

Надзор со стороны опекунов является ключевым моментом, когда несовершеннолетние люди взаимодействуют с персонажами ИИ, чтобы предотвратить несоответствующее возрасту разоблачение или инциденты с обменом информацией. Предоставляемые платформой инструменты родительского контроля, режимы безопасности детей и ресурсы для семейного консультирования помогают создать защищенную среду. Сочетание внешнего наблюдения и защиты платформы является идеальным решением.

Сообщение о неприемлемом контенте или поведении

Четкие и доступные инструменты отчетности, позволяющие отмечать оскорбительное поведение аватаров, способствуют созданию более здоровой среды. Оповещение платформ о нарушениях политики, ущемлении личных данных или злоупотреблениях, независимо от того, активируется ли это искусственным интеллектом или человеком, позволяет исправить ситуацию и помогает усилить системные меры предосторожности.

Информация для проверки фактов, которой делятся персонажи ИИ

Несмотря на расширенные возможности, аватары ИИ могут делиться ложной информацией или закреплять предвзятость в разговорах. Следовательно, пользователям следует критически анализировать сделанные заявления, а не предполагать их достоверность, поощряя платформы усиливать проверки точности.

Будущее AI-персонажей/аватаров

Поскольку чат-боты и виртуальные компаньоны с искусственным интеллектом продолжают развиваться, становясь все более реалистичными и интерактивными, их будущее обещает новые захватывающие приложения наряду с развитием вопросов безопасности.

Ожидается, что платформы ИИ-аватаров станут более универсальными и многофункциональными благодаря таким улучшениям, как видео и AR-варианты, расширенный эмоциональный интеллект и креативность, более глубокая персонализация и контекстное взаимодействие. Поскольку базовые языковые модели продолжают совершенствоваться за счет увеличения объема данных и оптимизации, аватары могут убедительно проходить длительные «тесты Тьюринга», демонстрируя удивительно человеческое поведение.

Благодаря такому прогрессу приложения могут расшириться в сторону эмоциональной поддержки, индивидуального обучения, интерактивных игр, доступных виртуальных отношений и более захватывающих развлекательных средств. Компании могут использовать интеллектуальных виртуальных помощников для улучшения качества обслуживания клиентов и даже тестирования продуктов или услуг с помощью фокус-групп по искусственному интеллекту.

Однако риски, связанные с согласием, эмоциональными манипуляциями, эксплуатацией данных, дезинформацией и слабостями, лежащими в основе предвзятости, также растут вместе с такими достижениями. Следовательно, постоянные оценки безопасности, внешние аудиты практики и надзор за этикой ИИ будут по-прежнему иметь решающее значение. Такие архитектуры, как конституционный ИИ, которые согласовывают достижения с человеческими ценностями посредством повышения прозрачности, подотчетности и надзора, обещают ответственные инновации.

В целом, благодаря совместным усилиям пользователей, политиков, исследователей и платформ, аватары ИИ обладают огромным потенциалом как технологии расширения прав и возможностей человека, а не просто как инструменты для коммерческих интересов.

Подведение итогов

По мере того, как платформы аватаров на базе искусственного интеллекта, такие как ИИ персонажей, продолжают развиваться, имитируя взаимодействие людей со все большей точностью, их захватывающий потенциал переплетается с меняющимися рисками. Хотя такие инновации обещают применение в сфере развлечений и образования, их неправильное использование может нарушить конфиденциальность, манипулировать пользователями или увековечить предвзятость.

Следовательно, наряду с прогрессом таких компаний, как Character AI и других, решающее значение имеет оценка и усиление этических гарантий. Такие факторы, как протоколы согласия, контроль возраста, политика дезинформации, прозрачные модели надзора и принципы использования сообщества, будут определять, будут ли эти платформы расширять возможности пользователей или эксплуатировать потребителей. Благодаря бдительному прогрессу, который согласовывает инновации в области ИИ-аватаров с человеческими ценностями, можно использовать их преимущества, одновременно минимизируя риски.