À medida que o mundo se torna cada vez mais digital, a demanda por conteúdo de alta qualidade nunca foi tão grande. Felizmente, os avanços no processamento de linguagem natural (NLP) deram origem a poderosas ferramentas de escrita orientadas por IA, como as desenvolvidas pela Hugging Face. Mas e se você precisar utilizar esses modelos offline? Não tenha medo, pois exploraremos como aproveitar os modelos da Hugging Face sem uma conexão com a internet.

O acesso offline aos modelos de linguagem de ponta do Hugging Face abre um mundo de possibilidades. Não importa se você está trabalhando em locais remotos, lidando com conectividade de internet não confiável ou simplesmente priorizando a privacidade de dados, a capacidade de executar esses modelos localmente pode ser um divisor de águas. Ao entender como implementar modelos do Hugging Face offline, você pode desbloquear novos níveis de eficiência, flexibilidade e controle em seu processo de criação de conteúdo.

Nesta postagem do blog, vamos nos aprofundar nas etapas práticas que você pode seguir para aproveitar o poder dos modelos Hugging Face offline. Da implantação do modelo à integração perfeita com seus fluxos de trabalho existentes, você aprenderá como maximizar o potencial dessas ferramentas avançadas de PNL, mesmo quando uma conexão com a Internet não estiver prontamente disponível. Prepare-se para elevar seu jogo de criação de conteúdo e ficar à frente da curva no mundo em constante evolução do marketing e comunicação digital.

Por que você pode querer usar o modelo Huggingface offline?

Você pode se perguntar por que alguém se daria ao trabalho de executar modelos de IA offline. Mas acredite em mim, há algumas razões realmente convincentes para tirar seus modelos Hugging Face da grade.

Create Amazing Websites

Com o melhor criador de páginas gratuito Elementor

Comece agoraAqui está uma explicação concisa do motivo pelo qual alguém pode querer usar modelos do Hugging Face offline:

Usar modelos do Hugging Face offline oferece várias vantagens importantes:

- Confiabilidade: trabalhe sem interrupções e sem se preocupar com problemas de conectividade com a Internet.

- Velocidade: elimine a latência da rede para uma inferência de modelo mais rápida.

- Privacidade: mantenha os dados confidenciais locais, evitando potenciais riscos de segurança do processamento online.

- Custo-benefício: reduza as despesas com computação em nuvem executando modelos em seu hardware.

- Portabilidade: use recursos avançados de IA em locais remotos ou áreas com acesso limitado à Internet.

- Aprendizado: obtenha uma compreensão mais profunda da arquitetura e do funcionamento do modelo trabalhando diretamente com eles.

- Personalização: ajuste e adapte modelos com mais facilidade para casos de uso específicos quando você tiver acesso local.

Vamos mergulhar e explorar como aproveitar todo o potencial dos modelos do Hugging Face, a qualquer hora e em qualquer lugar.

Como usar modelos do Huggingface offline?

Huggingface é como um Github ou loja de aplicativos para IA de código aberto. Aqui, você pode navegar, baixar e até mesmo usar vários LLMs de código aberto deste site. Além disso, assim como o ChatGPT, eles têm o Hugging Chat. Este chatbot permite que você escolha um modelo que deseja usar e, mais tarde, você pode conversar com ele como faria com qualquer outro assistente de IA multimodelo.

Quão incrível seria usar esses modelos completamente grátis, offline, diariamente? Vamos fazer isso.

Estúdio LM

O LM Studio está revolucionando a maneira como usamos modelos de IA localmente. Este aplicativo versátil, disponível para Windows, Mac (Apple Silicon) e Linux (beta), capacita os usuários a baixar e executar modelos Hugging Face offline com facilidade.

Os principais recursos do LM Studio incluem:

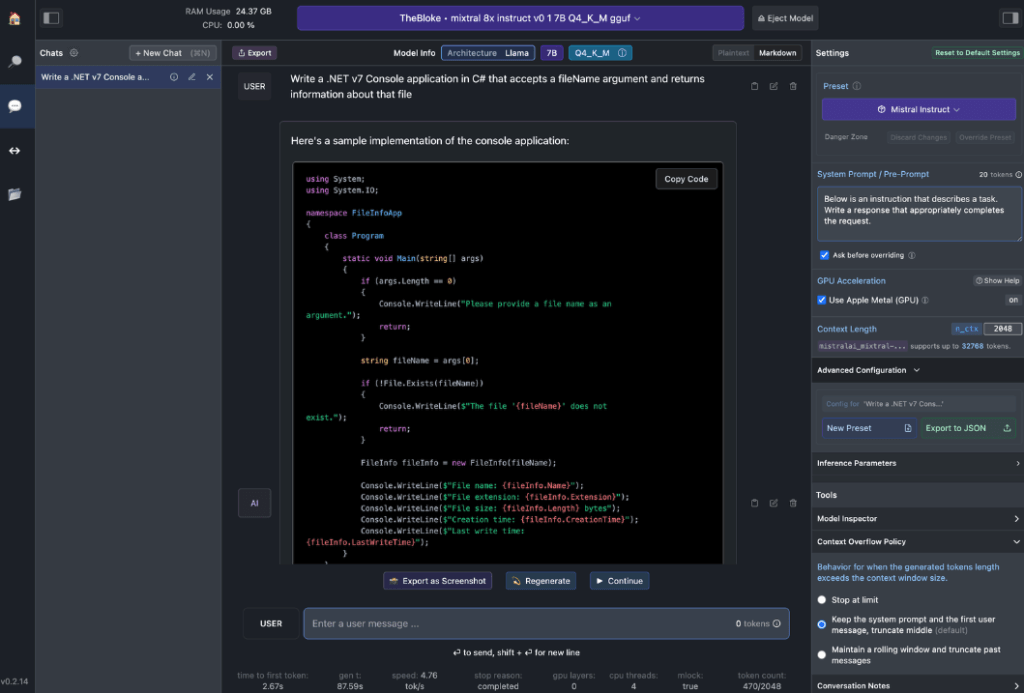

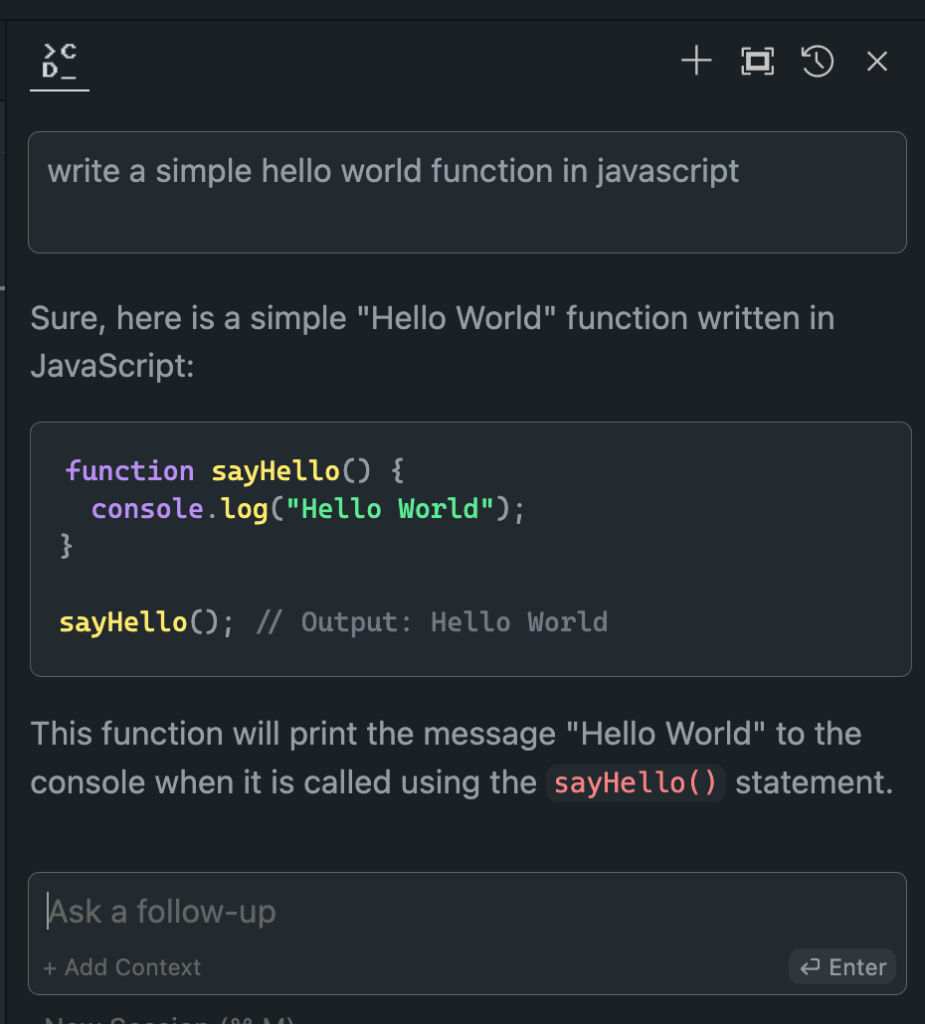

- Interação com o Modelo Local: Baixe seu Modelo de Linguagem (LLM) preferido e interaja com ele como faria com qualquer assistente de IA baseado em chat. Personalize o desempenho e o formato de saída e explore recursos experimentais por meio de vários prompts e opções de sistema integrados.

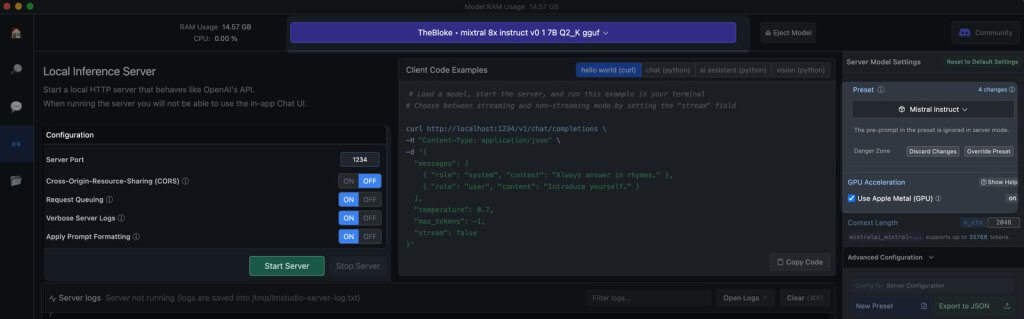

- Emulação de API OpenAI: É aqui que o LM Studio realmente brilha. Carregue seu modelo Hugging Face baixado, e o LM Studio engenhosamente envolve um proxy de API local em torno dele, imitando a API OpenAI. Essa compatibilidade é um divisor de águas, pois permite integração perfeita com vários SDKs e extensões populares de Editor e IDE que já oferecem suporte ao OpenAI.

Requisitos de hardware da estação de trabalho

Para realmente desbloquear o potencial dos modelos offline do Hugging Face, você precisará de um hardware robusto. Embora qualquer computador moderno possa lidar com tarefas básicas, o desempenho ideal requer especificações mais poderosas:

Para usuários da Apple:

- Processadores M2/M3 Max ou Ultra

- Configurações de ponta

- Mais de 50 GB de RAM (compartilhado com GPU no M2 SoC)

- Suporte de metal para melhor desempenho

Para usuários do Windows:

- Mais núcleo de CPU

- RAM substancial

- GPU série RTX 30 ou 40 com VRAM ampla

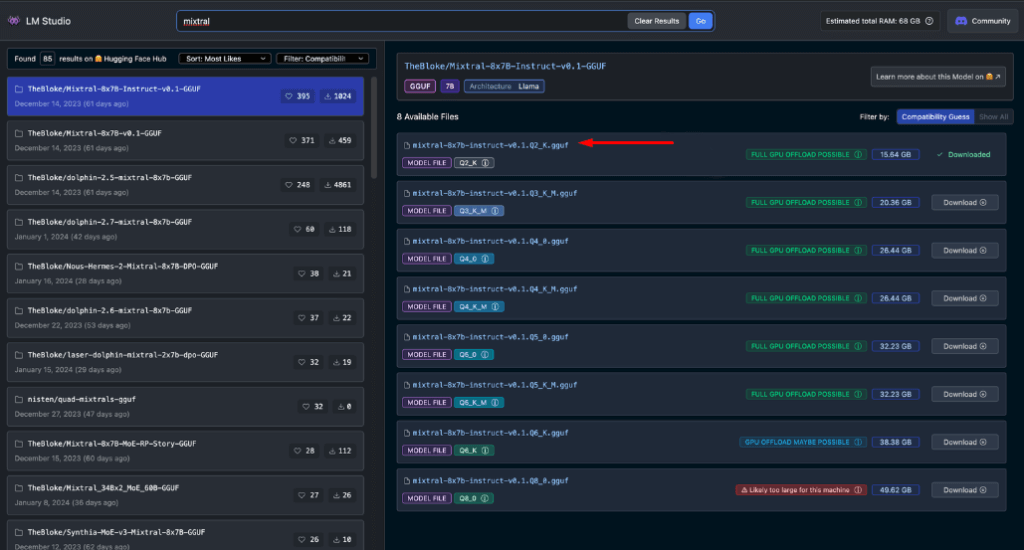

Não se preocupe se você não tiver um sistema de primeira linha. Existem muitas opções amigáveis de RAM e VRAM, mesmo entre os modelos mais recentes. O LM Studio estima com presteza as capacidades do seu sistema enquanto você navega e baixa modelos.

Geralmente, arquivos de modelo maiores e requisitos de recursos mais altos se correlacionam com qualidade de saída melhorada. Embora seja melhor não forçar seu sistema aos seus limites absolutos, não tenha medo de mirar alto dentro das capacidades do seu hardware.

Lembre-se: o objetivo é equilibrar o desempenho do modelo com os recursos do seu sistema para a melhor experiência offline do Hugging Face.

Modelos recomendados para uso offline

Ao executar modelos Hugging Face offline, escolher o modelo certo é crucial. Por meio de testes extensivos, descobri que os seguintes modelos entregam resultados consistentemente impressionantes para tarefas gerais de bate-papo e codificação:

Cada um desses modelos oferece um equilíbrio único entre desempenho e uso de recursos, o que os torna excelentes opções para implantação offline.

Antes de prosseguir, é essencial que você mesmo avalie esses modelos:

- Baixe cada modelo no LM Studio

- Use a aba de bate-papo da IA para interagir com o modelo

- Teste seu desempenho em várias tarefas, especialmente codificação, se esse for seu foco

- Avalie a qualidade dos resultados e o quão bem eles se alinham com suas necessidades

Lembre-se, sua experiência pode diferir com base em seu caso de uso específico e capacidades de hardware. Reserve um tempo para encontrar o modelo que melhor se adapta às suas necessidades. Este processo de seleção cuidadoso garantirá que você tenha o modelo offline Hugging Face mais eficaz para suas necessidades antes de passar para a integração e uso mais avançado.

Servidor local no LM Studio

Iniciar seu servidor de modelo offline Hugging Face é muito simples:

- Abra o LM Studio

- Selecione um dos modelos baixados

- Clique no botão Iniciar servidor

É isso! As configurações padrão são geralmente adequadas para a maioria dos usuários. No entanto, se você estiver procurando ajustar sua experiência, sinta-se à vontade para ajustar as opções para corresponder às suas necessidades ou preferências específicas.

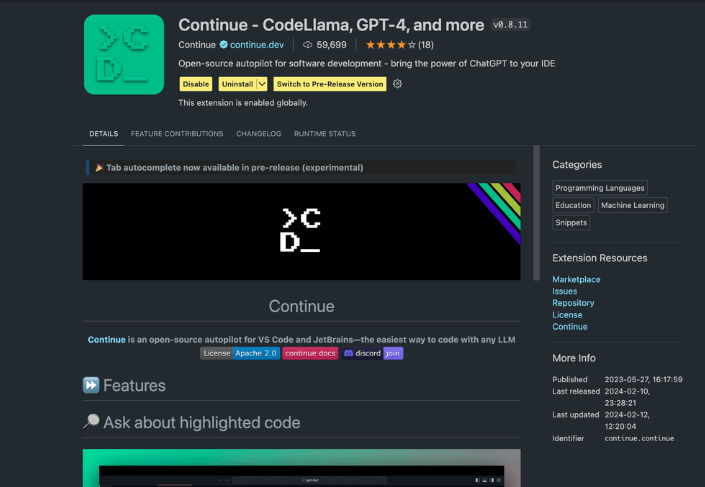

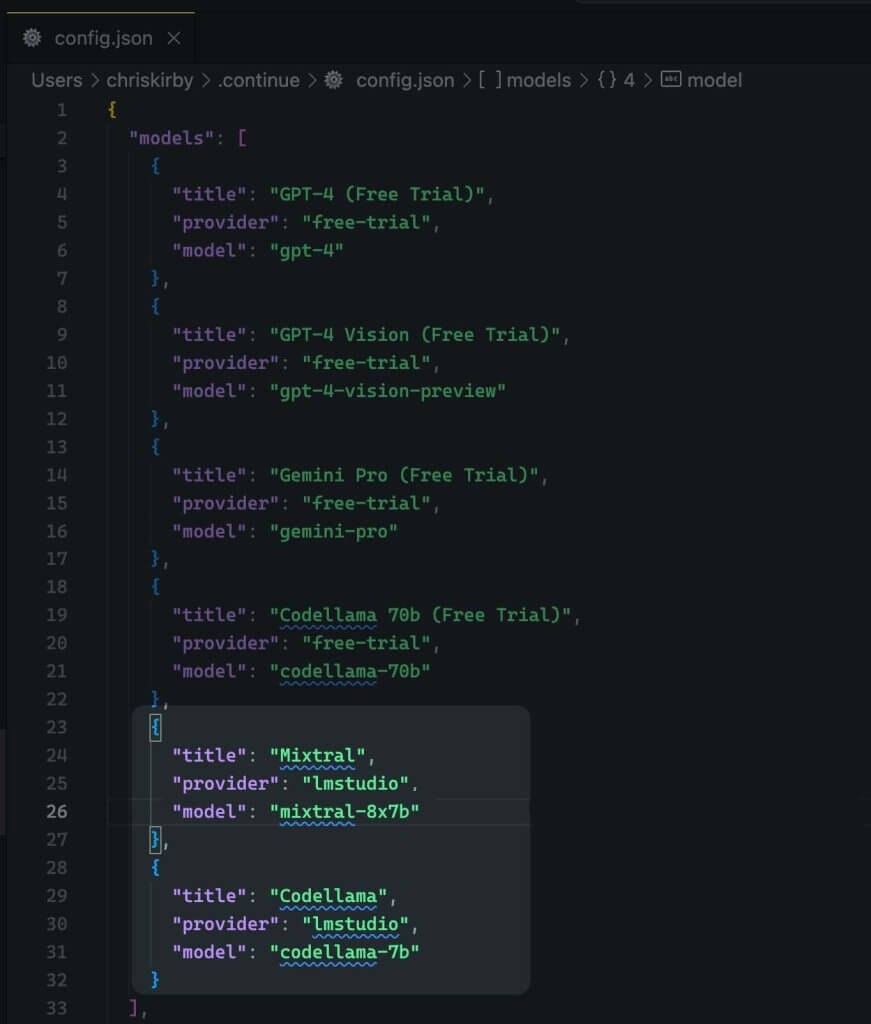

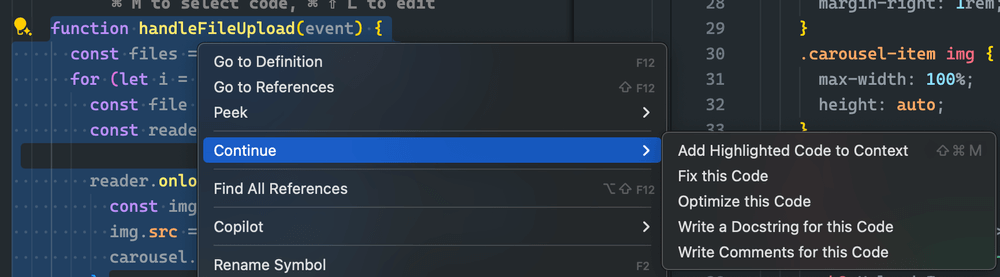

Usando a extensão Continue

No VS code studio iniciado, navegue até a exibição de extensões. Na barra de pesquisa, digite "Continue". Encontre a extensão correta e instale-a.

Agora precisamos alterar a configuração JSON da extensão. Ela adicionará o suporte ao LM Studio.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Agora, salve-o.

Em seguida, você precisa usar este modelo local em vez do código VS.

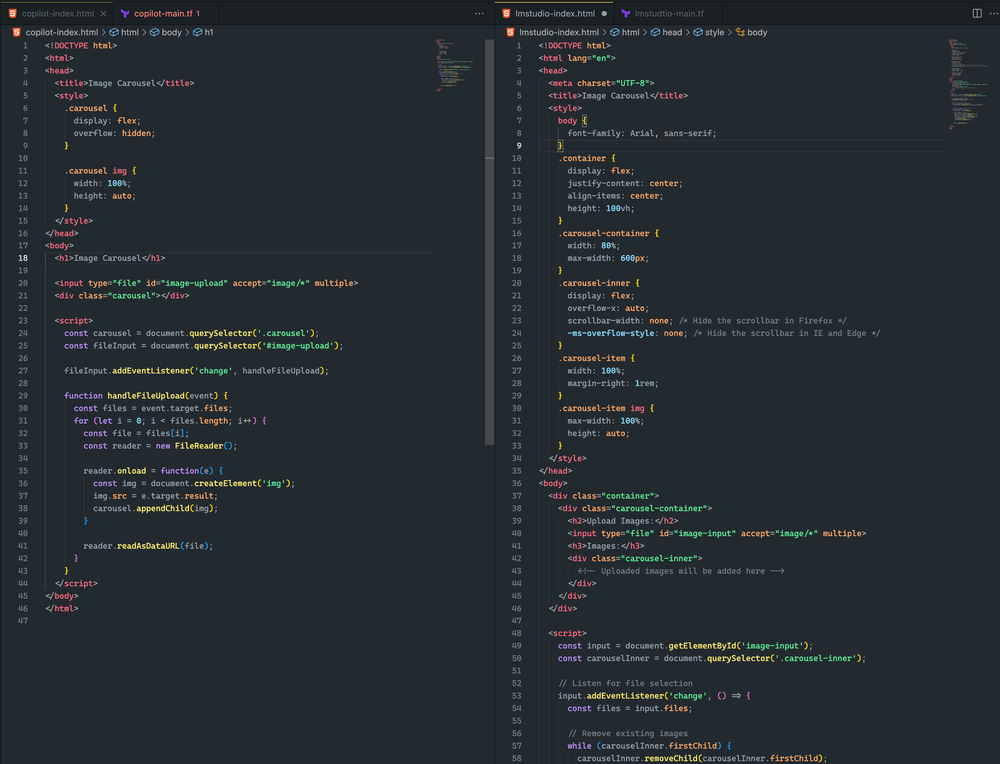

Avaliando o desempenho do modelo offline vs. online

Agora que configuramos nosso modelo offline Hugging Face, é hora do momento da verdade. Vamos testá-lo contra seus equivalentes online!

Em meus extensos testes, os resultados foram reveladores:

- Desempenho: O modelo offline geralmente corresponde e, em alguns casos, até supera seus equivalentes online.

- Velocidade: Sem latência de rede, as respostas podem ser extremamente rápidas.

- Consistência: Não há mais variabilidade devido à carga do servidor ou problemas de conexão.

Embora sua experiência possa variar dependendo do modelo e hardware escolhidos, não se surpreenda se você preferir a versão offline. A combinação de poder de processamento local e modelos ajustados pode fornecer resultados impressionantes.

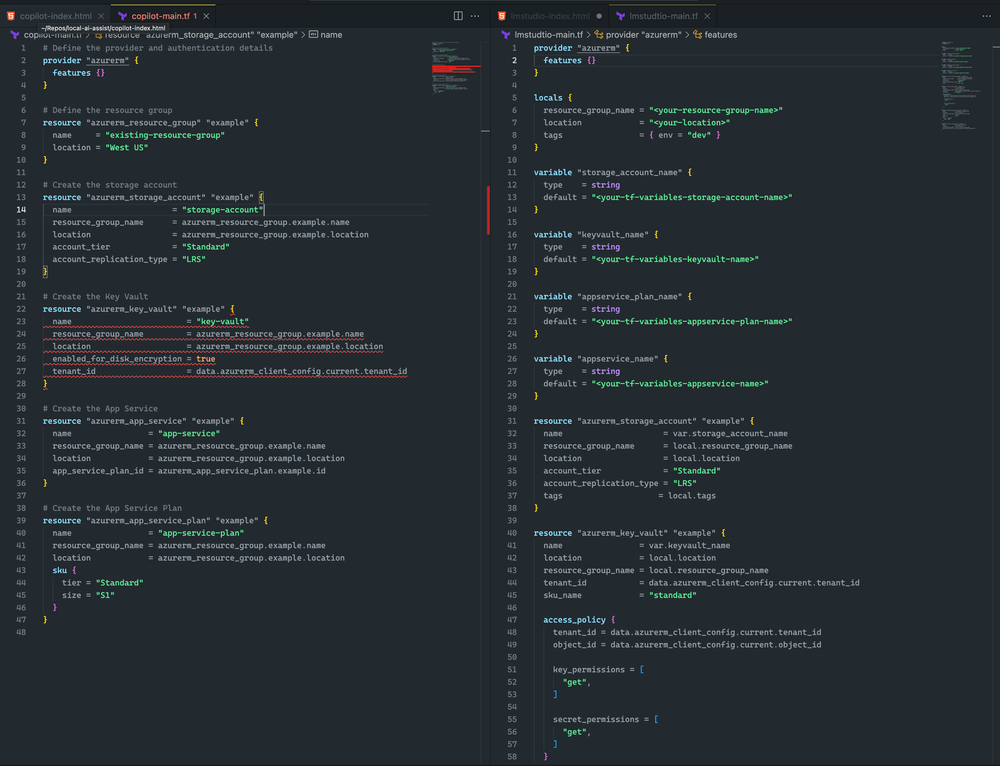

Veja aqui a diferença.

Ambas as abordagens foram bem próximas. Embora nenhuma delas tenha resultado em um carrossel de imagens, carreguei uma imagem com sucesso, e ela foi renderizada em ambos os exemplos. Com mais ajustes rápidos, acredito que posso obter um resultado ainda melhor

Eu me inclino para o LM Studio e o Mixtral porque o Terraform é mais completo e não tem erros de sintaxe. No entanto, o CoPilot tem um pequeno problema: a declaração do key vault está sem o sku_name , o que pode ser facilmente corrigido.

Encerrando

Lembre-se, o campo da IA está evoluindo rapidamente. Ao dominar a implantação offline dos modelos Hugging Face, você não está apenas mantendo o ritmo – você está se mantendo à frente da curva. Seja você um desenvolvedor, pesquisador ou entusiasta de IA, essa habilidade o capacita a ultrapassar os limites do que é possível com o processamento de IA local.

Então, mergulhe de cabeça. Experimente diferentes modelos, ajuste sua configuração e integre essas potências offline ao seu fluxo de trabalho. Você pode descobrir que o futuro do desenvolvimento de IA está bem ali na sua máquina local, esperando para ser liberado.