W miarę jak świat staje się coraz bardziej cyfrowy, popyt na wysokiej jakości treści nigdy nie był większy. Na szczęście postęp w przetwarzaniu języka naturalnego (NLP) doprowadził do powstania potężnych narzędzi do pisania opartych na sztucznej inteligencji, takich jak te opracowane przez Hugging Face. Ale co, jeśli musisz wykorzystać te modele offline? Nie obawiaj się, ponieważ zbadamy, jak wykorzystać modele Hugging Face bez połączenia z Internetem.

Dostęp offline do najnowocześniejszych modeli językowych Hugging Face otwiera świat możliwości. Niezależnie od tego, czy pracujesz w odległych lokalizacjach, masz do czynienia z zawodnym połączeniem internetowym, czy po prostu priorytetowo traktujesz prywatność danych, możliwość uruchamiania tych modeli lokalnie może być przełomem. Rozumiejąc, jak wdrażać modele Hugging Face offline, możesz odblokować nowe poziomy wydajności, elastyczności i kontroli w procesie tworzenia treści.

W tym wpisie na blogu zagłębimy się w praktyczne kroki, które możesz podjąć, aby wykorzystać moc modeli Hugging Face w trybie offline. Od wdrożenia modelu po bezproblemową integrację z istniejącymi przepływami pracy, dowiesz się, jak zmaksymalizować potencjał tych zaawansowanych narzędzi NLP, nawet gdy połączenie internetowe nie jest łatwo dostępne. Przygotuj się na podniesienie poziomu tworzenia treści i bądź o krok przed innymi w ciągle ewoluującym świecie marketingu cyfrowego i komunikacji.

Dlaczego warto korzystać z Huggingface Model w trybie offline?

Możesz się zastanawiać, dlaczego ktokolwiek miałby zawracać sobie głowę uruchamianiem modeli AI offline. Ale uwierz mi, jest kilka naprawdę przekonujących powodów, aby usunąć swoje modele Hugging Face z sieci.

Twórz niesamowite strony internetowe

Z najlepszym darmowym kreatorem stron Elementor

Zacząć terazOto zwięzłe wyjaśnienie, dlaczego ktoś może chcieć korzystać z modeli Hugging Face w trybie offline:

Korzystanie z modeli Hugging Face w trybie offline oferuje kilka kluczowych korzyści:

- Niezawodność: Pracuj nieprzerwanie i nie przejmuj się problemami z łącznością internetową.

- Prędkość: eliminacja opóźnień w sieci umożliwia szybsze wnioskowanie w modelu.

- Prywatność: przechowuj poufne dane lokalnie, unikając potencjalnych zagrożeń bezpieczeństwa związanych z przetwarzaniem danych online.

- Oszczędność kosztów: Zmniejsz wydatki na przetwarzanie w chmurze, uruchamiając modele na swoim sprzęcie.

- Przenośność: korzystaj z zaawansowanych możliwości sztucznej inteligencji w odległych lokalizacjach lub obszarach o ograniczonym dostępie do Internetu.

- Nauka: Zdobądź głębsze zrozumienie architektury i funkcjonowania modeli, pracując z nimi bezpośrednio.

- Personalizacja: Możliwość łatwiejszego dostosowywania i dostosowywania modeli do konkretnych przypadków użycia przy dostępie lokalnym.

Przyjrzyjmy się bliżej i dowiedzmy się, jak wykorzystać pełen potencjał modeli Hugging Face, zawsze i wszędzie.

Jak korzystać z modeli Huggingface w trybie offline?

Huggingface jest jak Github lub sklep z aplikacjami dla open-source AI. Tutaj możesz przeglądać, pobierać, a nawet używać wielu open-source LLM z tej strony internetowej. Ponadto, podobnie jak ChatGPT, mają Hugging Chat. Ten chatbot pozwala wybrać model, którego chcesz użyć, a później możesz z nim rozmawiać, tak jak z każdym innym wielomodelowym asystentem AI.

Jak wspaniale byłoby używać tych modeli całkowicie za darmo, offline codziennie? Zróbmy to.

Studio LM

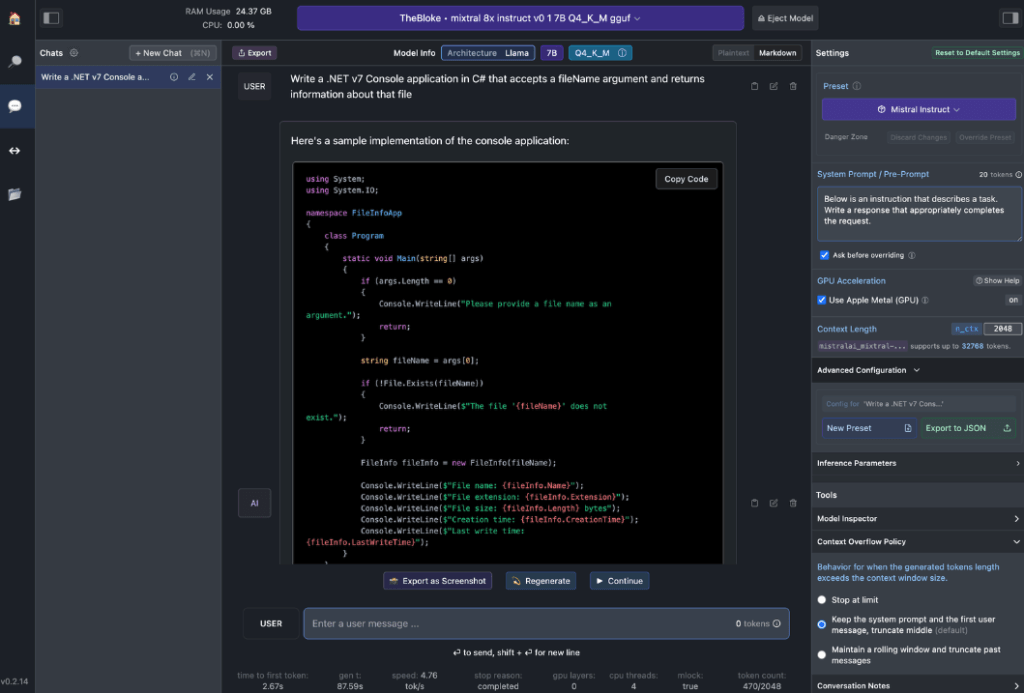

LM Studio rewolucjonizuje sposób, w jaki lokalnie wykorzystujemy modele AI. Ta wszechstronna aplikacja, dostępna na systemy Windows, Mac (Apple Silicon) i Linux (wersja beta), umożliwia użytkownikom łatwe pobieranie i uruchamianie modeli Hugging Face w trybie offline.

Główne cechy LM Studio obejmują:

- Interakcja z modelem lokalnym: Pobierz preferowany model językowy (LLM) i wchodź z nim w interakcję tak, jak z każdym asystentem AI opartym na czacie. Dostosuj wydajność i format wyjściowy oraz eksploruj funkcje eksperymentalne za pomocą różnych wbudowanych monitów systemowych i opcji.

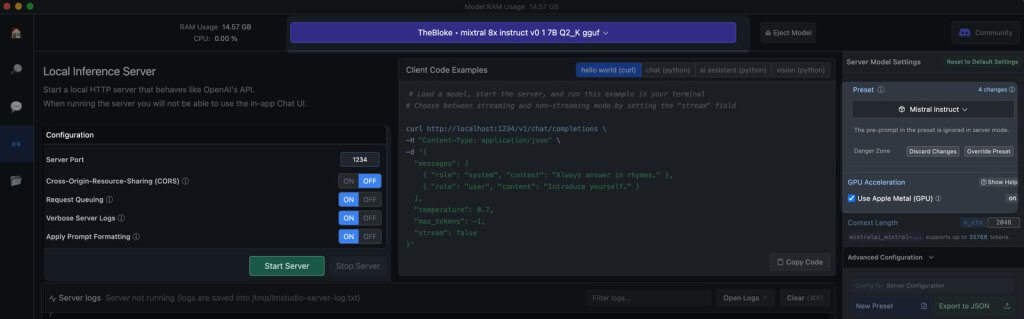

- Emulacja API OpenAI: To jest miejsce, w którym LM Studio naprawdę błyszczy. Załaduj pobrany model Hugging Face, a LM Studio pomysłowo opakuje go w lokalny serwer proxy API, naśladując API OpenAI. Ta zgodność zmienia zasady gry, ponieważ umożliwia bezproblemową integrację z wieloma zestawami SDK i popularnymi rozszerzeniami Editor & IDE, które już obsługują OpenAI.

Wymagania sprzętowe stacji roboczej

Aby w pełni wykorzystać potencjał modeli Hugging Face w trybie offline, będziesz potrzebować solidnego sprzętu. Podczas gdy każdy nowoczesny komputer poradzi sobie z podstawowymi zadaniami, optymalna wydajność wymaga bardziej zaawansowanych specyfikacji:

Dla użytkowników Apple:

- Procesory M2/M3 Max lub Ultra

- Konfiguracje wyższej klasy

- Ponad 50 GB pamięci RAM (współdzielonej z GPU w układzie SoC M2)

- Metalowe wsparcie dla zwiększonej wydajności

Dla użytkowników systemu Windows:

- Więcej rdzeni CPU

- Duża pamięć RAM

- Karta graficzna RTX serii 30 lub 40 z dużą ilością pamięci VRAM

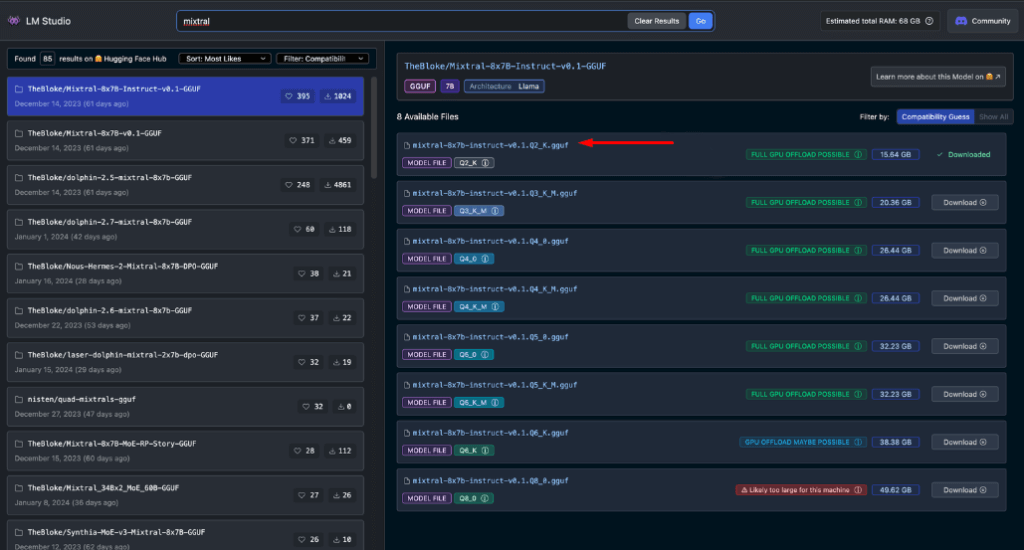

Nie martw się, jeśli brakuje Ci systemu najwyższej klasy. Istnieje wiele opcji przyjaznych dla pamięci RAM i VRAM, nawet wśród najnowszych modeli. LM Studio pomocnie szacuje możliwości Twojego systemu podczas przeglądania i pobierania modeli.

Generalnie, większe pliki modeli i wyższe wymagania dotyczące zasobów korelują z lepszą jakością wyników. Chociaż najlepiej nie forsować systemu do absolutnych granic, nie bój się celować wysoko w ramach możliwości swojego sprzętu.

Pamiętaj: celem jest zrównoważenie wydajności modelu z zasobami systemu, aby uzyskać najlepsze działanie aplikacji Hugging Face w trybie offline.

Zalecane modele do użytku offline

Podczas uruchamiania modeli Hugging Face w trybie offline wybór odpowiedniego modelu jest kluczowy. Dzięki obszernym testom odkryłem, że następujące modele zapewniają niezmiennie imponujące wyniki zarówno w przypadku ogólnych zadań czatu, jak i kodowania:

Każdy z tych modeli oferuje wyjątkową równowagę między wydajnością i wykorzystaniem zasobów, dzięki czemu doskonale nadają się do wdrożeń w trybie offline.

Zanim przejdziemy dalej, konieczne jest samodzielne ocenienie tych modeli:

- Pobierz każdy model w LM Studio

- Użyj zakładki czatu AI, aby wejść w interakcję z modelem

- Przetestuj jego wydajność w różnych zadaniach, szczególnie w kodowaniu, jeśli się na tym skupiasz

- Oceń jakość wyników i to, w jakim stopniu odpowiadają one Twoim potrzebom

Pamiętaj, że Twoje doświadczenie może się różnić w zależności od konkretnego przypadku użycia i możliwości sprzętowych. Poświęć trochę czasu na znalezienie modelu, który najlepiej odpowiada Twoim wymaganiom. Ten staranny proces selekcji zapewni Ci najbardziej efektywny model Hugging Face offline dla Twoich potrzeb, zanim przejdziesz do integracji i bardziej zaawansowanego użytkowania.

Serwer lokalny do LM Studio

Uruchomienie serwera modelu Hugging Face w trybie offline jest bardzo proste:

- Otwórz LM Studio

- Wybierz jeden z pobranych modeli

- Kliknij przycisk Uruchom serwer

To wszystko! Domyślne ustawienia są generalnie odpowiednie dla większości użytkowników. Jeśli jednak chcesz dostroić swoje doświadczenie, możesz swobodnie dostosować opcje do swoich konkretnych potrzeb lub preferencji.

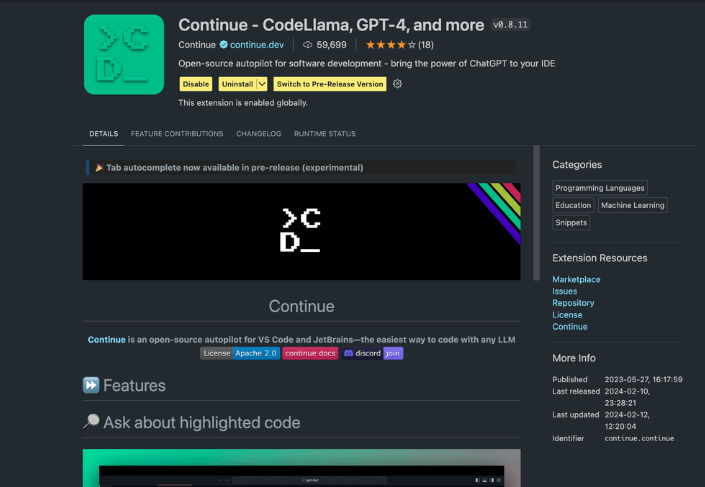

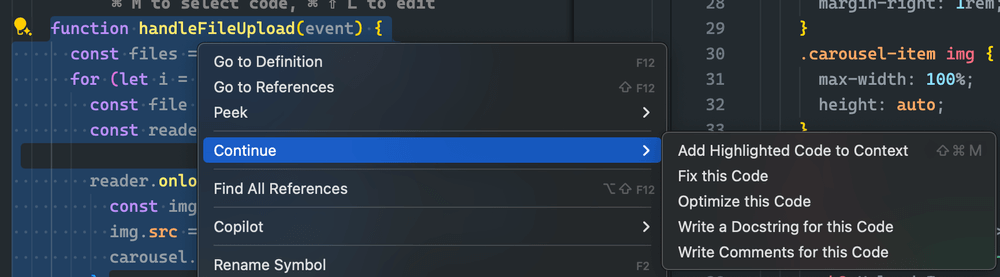

Korzystanie z rozszerzenia Continue

Z uruchomionego studia VS Code przejdź do widoku rozszerzeń. W pasku wyszukiwania wpisz „Kontynuuj”. Znajdź właściwe rozszerzenie i zainstaluj je.

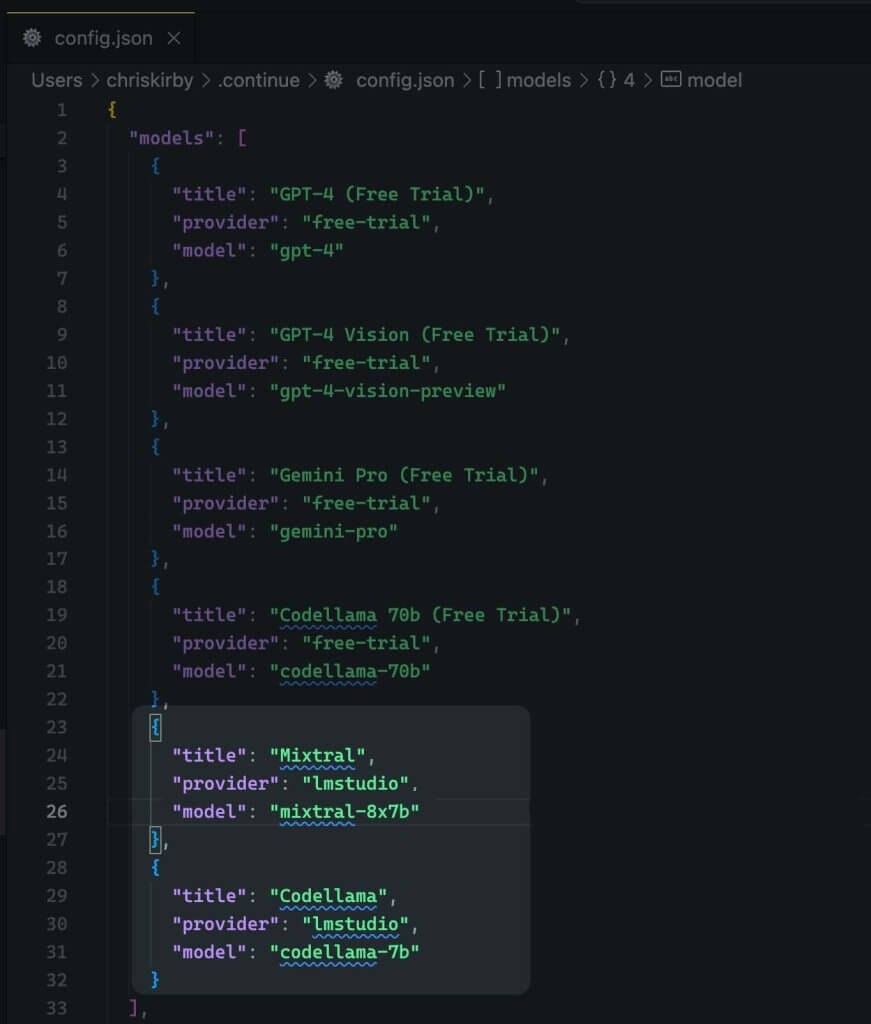

Teraz musimy zmienić konfigurację JSON rozszerzenia. To doda obsługę LM Studio.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Teraz zapisz.

Następnie należy użyć tego lokalnego modelu zamiast kodu VS.

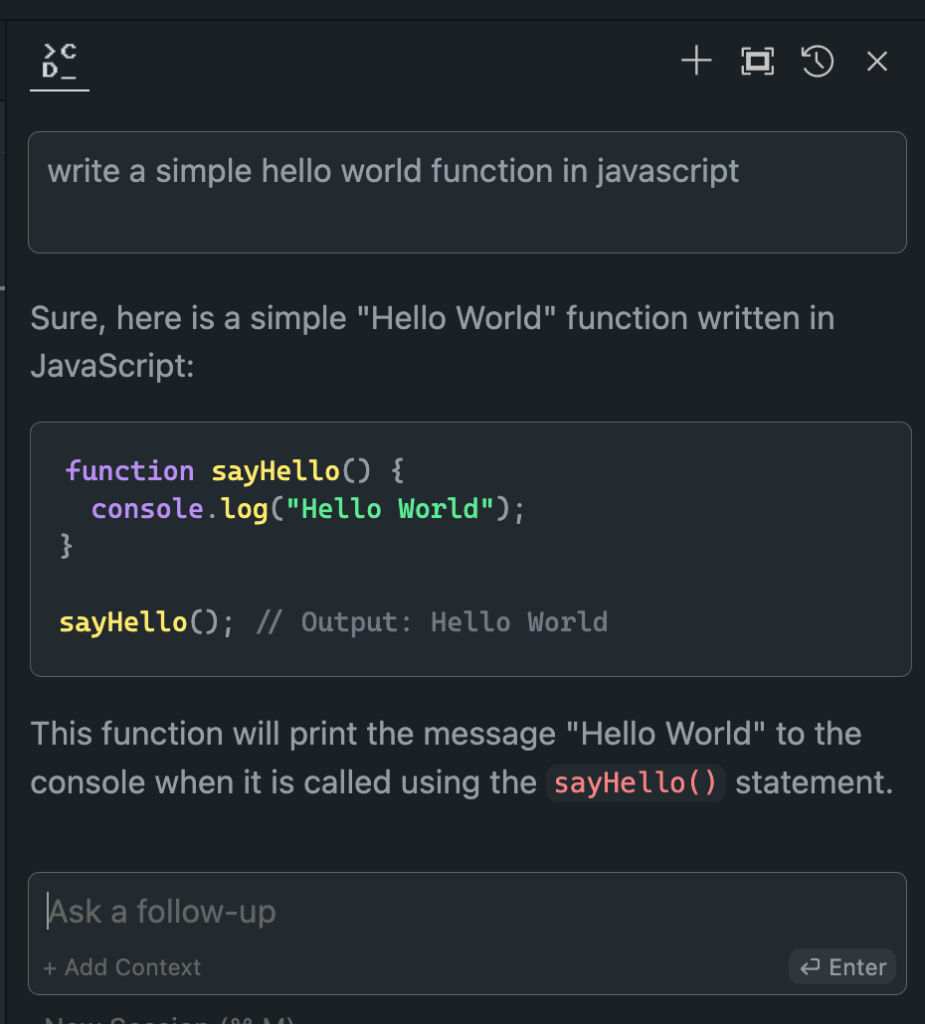

Ocena wydajności modelu offline i online

Teraz, gdy skonfigurowaliśmy nasz model Hugging Face w trybie offline, nadszedł czas na moment prawdy. Przetestujmy go w porównaniu z jego odpowiednikami online!

Wyniki moich szeroko zakrojonych prób były szokujące:

- Wydajność: Model offline często dorównuje swoim odpowiednikom online, a w niektórych przypadkach nawet je przewyższa.

- Szybkość: Bez opóźnień w sieci odpowiedzi mogą być błyskawiczne.

- Spójność: Koniec ze zmiennością spowodowaną obciążeniem serwera lub problemami z połączeniem.

Choć Twoje doświadczenie może się różnić w zależności od wybranego modelu i sprzętu, nie zdziw się, jeśli okaże się, że wolisz wersję offline. Połączenie lokalnej mocy przetwarzania i dostrojonych modeli może dać imponujące rezultaty.

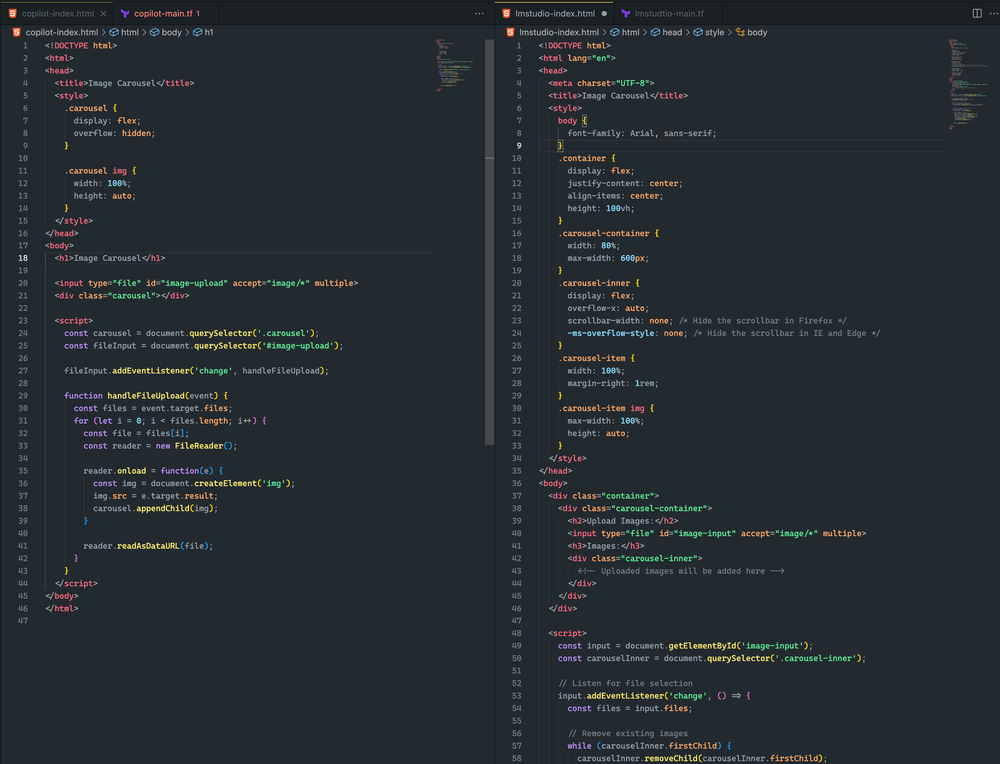

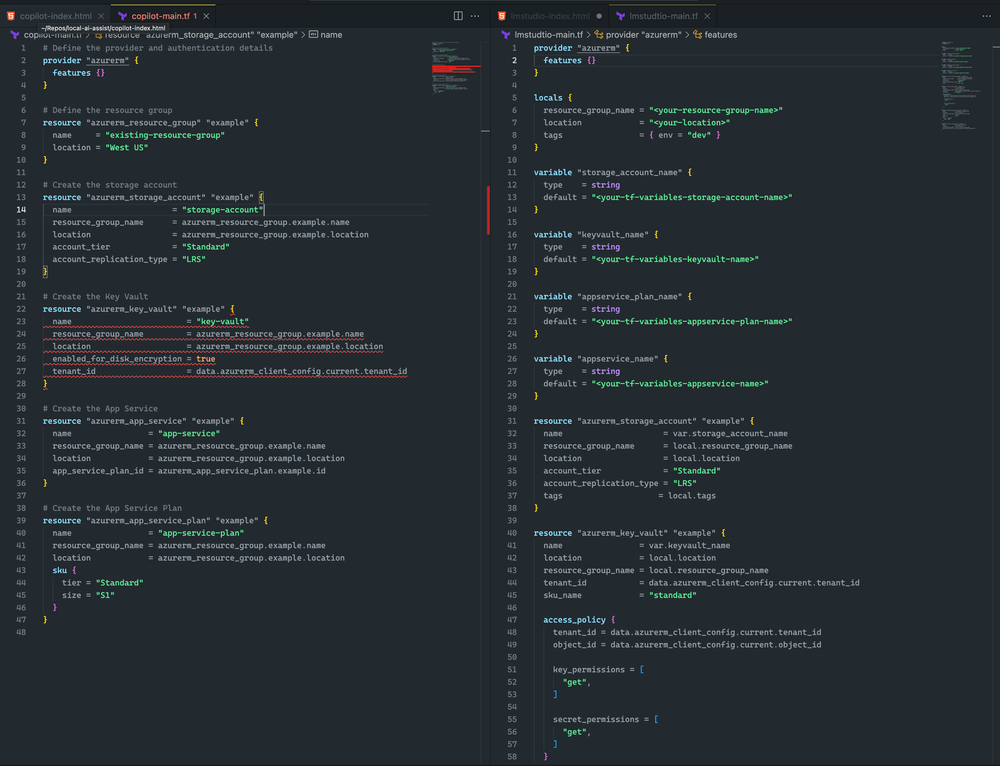

Tutaj widać różnicę.

Oba podejścia były dość zbliżone. Chociaż żadne z nich nie doprowadziło do karuzeli obrazów, udało mi się przesłać obraz i został on wyrenderowany w obu przykładach. Przy dalszych szybkich poprawkach uważam, że mogę osiągnąć jeszcze lepszy wynik

Skłaniam się ku LM Studio i Mixtral, ponieważ Terraform jest bardziej kompletny i nie ma błędów składniowych. Jednak CoPilot ma drobny problem: deklaracja key vault nie zawiera sku_name , co można łatwo naprawić.

Podsumowanie

Pamiętaj, że dziedzina AI szybko się rozwija. Opanowując wdrażanie offline modeli Hugging Face, nie tylko dotrzymujesz kroku – wyprzedzasz trendy. Niezależnie od tego, czy jesteś programistą, badaczem czy entuzjastą AI, ta umiejętność pozwala Ci przesuwać granice tego, co jest możliwe dzięki lokalnemu przetwarzaniu AI.

Więc podejmij wyzwanie. Eksperymentuj z różnymi modelami, dopracuj konfigurację i zintegruj te offline'owe potęgi ze swoim przepływem pracy. Możesz odkryć, że przyszłość rozwoju AI jest tuż obok, na Twoim komputerze lokalnym, czekając na uwolnienie.