Jako entuzjasta AI byłem naocznym świadkiem niesamowitego wzrostu dużych modeli językowych (LLM). Te potężne narzędzia AI zrewolucjonizowały sposób, w jaki wchodzimy w interakcje z technologią, wywołując dylematy zarówno dla firm, jak i osób prywatnych.

Czy powinniśmy przyjąć wygodę usług subskrypcyjnych, czy przejąć kontrolę, hostując nasze modele? To pytanie nie dotyczy tylko kosztów — dotyczy wydajności, prywatności i skalowalności.

W tym wpisie na blogu przyjrzę się obu opcjom, korzystając z własnego doświadczenia i najnowszych trendów w branży, aby pomóc Ci podjąć świadomą decyzję, która będzie zgodna z Twoimi konkretnymi potrzebami i zasobami.

Hosting LLM kontra subskrypcja ChatGPT: zrozumienie opcji

Przyjrzyjmy się bliżej dwóm głównym kandydatom na arenie LLM.

Twórz niesamowite strony internetowe

Z najlepszym darmowym kreatorem stron Elementor

Zacząć terazSubskrypcja ChatGPT

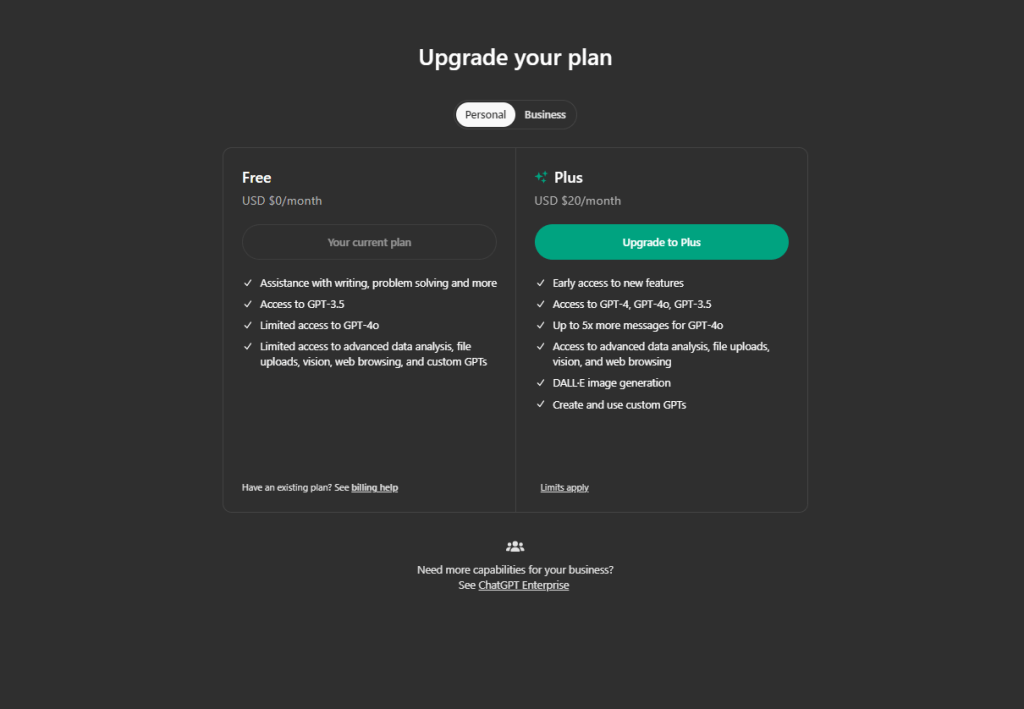

ChatGPT stało się powszechnie znane z dobrego powodu. Jako subskrybent otrzymujesz:

- Dostęp do najnowocześniejszych modeli językowych

- Regularne aktualizacje i ulepszenia

- Przyjazny dla użytkownika interfejs

- Solidne API do integracji z różnymi aplikacjami

Cennik jest prosty: płacisz w zależności od wykorzystania. Dla okazjonalnych użytkowników lub małych firm może to być dość opłacalne.

Samodzielne hostowanie programów LLM typu Open Source

Z drugiej strony mamy podejście DIY. Popularne modele open-source, takie jak LLaMA i GPT-NeoX, oferują:

- Pełna kontrola nad Twoim modelem

- Opcje dostosowywania

- Prywatność danych

- Potencjał oszczędności kosztów na dużą skalę

Tutaj masz dwie główne opcje wdrożenia:

a) Hosting w chmurze (AWS, Google Cloud, Azure)

b) Sprzęt lokalny

Każda ścieżka ma swoje zalety i wady, które omówimy szczegółowo w dalszej części artykułu.

Wybór między tymi opcjami nie zawsze jest oczywisty. Zależy to od Twoich konkretnych potrzeb, zasobów i długoterminowych celów. W poniższych sekcjach poprowadzę Cię przez kluczowe czynniki, które należy wziąć pod uwagę, pomagając Ci podjąć najlepszą decyzję w Twojej wyjątkowej sytuacji.

Porównanie kosztów

Jeśli chodzi o LLM, koszt jest często głównym czynnikiem decydującym. Rozłóżmy liczby.

Subskrypcja ChatGPT

jeśli użyjemy ChatGPT, koszt subskrypcji wyniesie:

- Obecnie OpenAI pobiera opłatę 0,002 USD za 1000 tokenów.

- Dla porównania, 1 tys. tokenów odpowiada około 750 słowom.

- Typowy dzień z 5000 zapytań może kosztować około 6,5 dolara.

- To około 200 dolarów miesięcznie przy umiarkowanym użytkowaniu.

Brzmi rozsądnie, prawda? Ale jest pewien haczyk: koszty mogą gwałtownie wzrosnąć przy intensywnym użytkowaniu. Twój miesięczny rachunek może szybko stać się oszałamiający, jeśli codziennie obsługujesz tysiące zapytań.

Samodzielne hostowanie programów LLM z otwartym kodem źródłowym

Jeśli chcesz stworzyć własny, samodzielnie hostowany program LLM, będzie to kosztować:

- Sprzęt: Wysokiej klasy karta graficzna, np. NVIDIA RTX 3090, kosztuje około 700 dolarów.

- Hosting w chmurze: AWS może kosztować około 150–160 USD dziennie przy 1 mln żądań.

- Nie zapomnij o prądzie: przy koszcie 0,12 USD/kWh korzystanie z wydajnego procesora graficznego przez całą dobę, 7 dni w tygodniu jest kosztowne.

- Koszty robocizny: Do skonfigurowania i konserwacji systemu potrzebna będzie specjalistyczna wiedza.

Początkowa konfiguracja samodzielnego hostingu jest droższa, ale w przypadku intensywnego użytkowania może okazać się bardziej opłacalna z czasem.

Ukryte koszty, które należy wziąć pod uwagę:

- Czas: Konfiguracja samodzielnie hostowanego systemu nie jest procesem natychmiastowym.

- Ulepszenia: Technologia w świecie sztucznej inteligencji rozwija się szybko.

- Przerwy w działaniu: W przypadku systemów hostowanych samodzielnie mogą występować częstsze przerwy.

Werdykt: Model subskrypcji ChatGPT często wygrywa pod względem kosztów dla użytkowników o małej liczbie użytkowników. Ale jeśli patrzysz na miliony zapytań miesięcznie, samodzielne hostowanie może zaoszczędzić Ci pieniądze w dłuższej perspektywie.

Wydajność i jakość

Jeśli chodzi o LLM, wydajność jest najważniejsza. Przyjrzyjmy się, jak ChatGPT i modele open-source wypadają:

Możliwości ChatGPT

- Zawsze wysokiej jakości odpowiedzi

- Szeroka baza wiedzy obejmująca różnorodne tematy

- Regularne aktualizacje poprawiające wydajność

- Zdolność do obsługi złożonych zapytań i zadań

Uważam, że ChatGPT jest szczególnie imponujący w kreatywnym pisaniu i scenariuszach rozwiązywania problemów. Jego odpowiedzi często wydają się ludzkie i kontekstowo odpowiednie.

Oprogramowanie Open Source LLM Performance

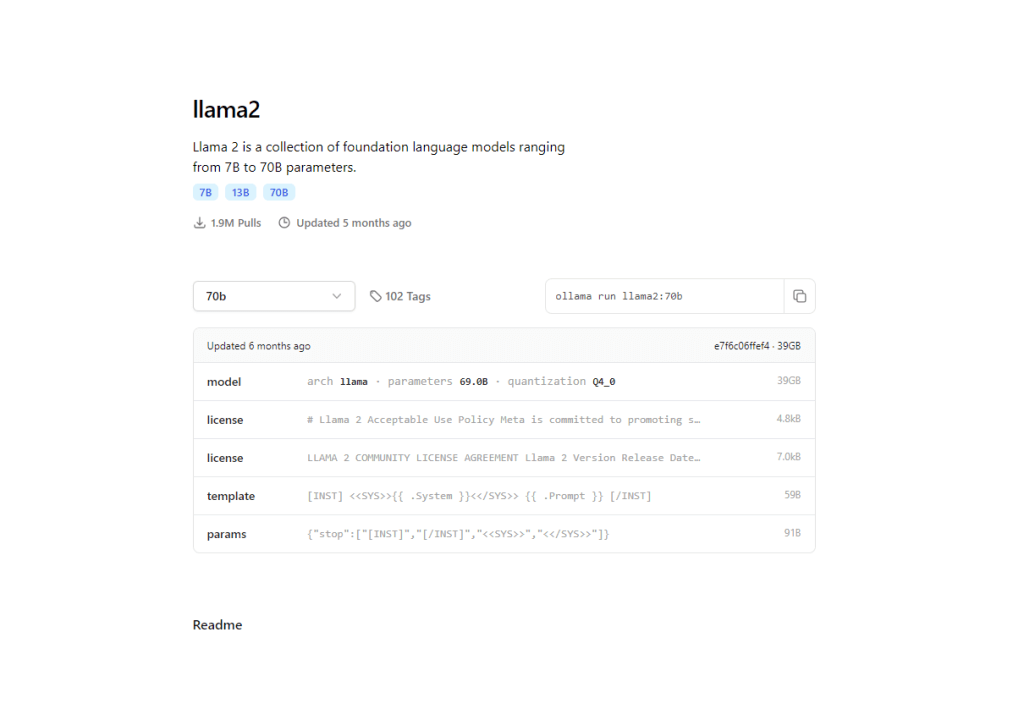

- Modele takie jak LLaMA 2 szybko nadrabiają zaległości

- Niektóre wyspecjalizowane modele przewyższają ChatGPT w określonych domenach

- Potencjał dostosowywania w celu optymalizacji zadań

Z mojego doświadczenia wynika, że ostatnie modele open-source, takie jak LLaMA 2 70B, mogą dorównać lub nawet przewyższyć GPT-3.5 w określonych zadaniach. Różnica szybko się zmniejsza.

To właśnie tutaj modele open-source błyszczą. Dzięki samodzielnemu hostingowi możesz:

- Szkolenie na danych specyficznych dla domeny

- Optymalizacja pod kątem konkretnych zadań

- Potencjalnie przewyższają modele ogólne w zastosowaniach niszowych

Przedsiębiorstwa osiągnęły niezwykłe wyniki dzięki dostosowaniu modeli open source do swoich konkretnych potrzeb.

Teraz, jeśli weźmiemy pod uwagę wydajność,

- Opóźnienie: modele hostowane samodzielnie mogą oferować krótsze czasy reakcji

- Dostosowywanie: Dostosuj modele open-source do swoich dokładnych wymagań

- Spójność: ChatGPT zapewnia niezawodną wydajność w przypadku różnych zadań

Werdykt: ChatGPT oferuje najwyższą wydajność od razu po wyjęciu z pudełka. Jeśli jednak masz konkretne, specjalistyczne potrzeby, dopracowany model open-source może potencjalnie przewyższyć go w Twoim konkretnym przypadku użycia.

Prywatność i kontrola danych

Obecnie prywatność nie jest już tylko luksusem — to konieczność. Przyjrzyjmy się, jak ChatGPT i samodzielnie hostowane LLM-y radzą sobie z tym kluczowym aspektem:

Obsługa danych ChatGPT

- OpenAI ma surowe zasady prywatności

- Dane przesłane do ChatGPT mogą zostać wykorzystane do udoskonalenia modelu

- Możliwość rezygnacji z udostępniania danych, ale z potencjalnymi kompromisami w zakresie wydajności

Chociaż OpenAI dba o prywatność użytkowników, wysyłanie poufnych danych osobom trzecim zawsze wiąże się z pewnym ryzykiem. Widziałem firmy wahające się przed korzystaniem z ChatGPT w celu uzyskania poufnych informacji.

Korzyści z samodzielnego prowadzenia studiów LLM

- Pełna kontrola nad Twoimi danymi

- Brak ryzyka zewnętrznego ujawnienia danych

- Możliwość wdrożenia niestandardowych środków bezpieczeństwa

Z mojego doświadczenia wynika, że taki poziom kontroli to prawdziwy przełom w takich branżach jak opieka zdrowotna czy finanse, w których prywatność danych ma kluczowe znaczenie.

Współpracowałem z firmami, które zdecydowały się na samodzielny hosting specjalnie po to, aby spełnić rygorystyczne wymagania zgodności.

Kluczowe czynniki prywatności:

- Własność danych: W przypadku samodzielnego hostingu zachowujesz pełną własność swoich danych i modelu

- Przejrzystość: Modele typu open source umożliwiają inspekcję i zrozumienie kodu

- Personalizacja: wdrażaj funkcje prywatności dostosowane do Twoich konkretnych potrzeb

Werdykt: Jeśli prywatność danych jest Twoim priorytetem, samodzielne hostowanie LLM z otwartym kodem źródłowym daje Ci niezrównaną kontrolę. Jednak solidne środki ochrony prywatności ChatGPT mogą być wystarczające w przypadku mniej wrażliwych aplikacji.

Skalowalność i elastyczność

Przyjrzyjmy się bliżej, jak ChatGPT i samodzielnie hostowane programy LLM wypadają pod względem skalowalności i elastyczności.

Opcje skalowalności ChatGPT

- Bezproblemowa skalowalność przy zwiększonym wykorzystaniu

- Brak konieczności zarządzania infrastrukturą

- API umożliwia łatwą integrację z różnymi aplikacjami

Jeśli mówimy o możliwościach personalizacji, ChatGPT ogranicza się do parametrów API i szybkiego projektowania.

Widziałem, jak firmy szybko skalowały swoje możliwości AI, korzystając z ChatGPT, nie martwiąc się o logistykę zaplecza. To jest imponująco bezproblemowe.

Elastyczność LLM z własnym hostingiem

- Pełna kontrola nad rozmiarem i możliwościami modelu

- Możliwość skalowania poziomego na wielu maszynach

- Swoboda optymalizacji pod kątem konkretnych konfiguracji sprzętowych

Aby umożliwić przyszłą personalizację, będziesz mieć pełny dostęp do architektury modelu i będziesz mieć możliwość trenowania danych na zaawansowanym poziomie.

W moich projektach ten poziom kontroli okazał się nieoceniony dla precyzyjnego dostrajania wydajności i opłacalności.

Werdykt: ChatGPT wyróżnia się łatwą skalowalnością, co czyni go idealnym rozwiązaniem dla firm o zmiennych wymaganiach. Jednak samodzielne hostowanie oferuje niezrównaną elastyczność dla tych, którzy chcą zarządzać własną infrastrukturą.

Rozważania techniczne

Ponieważ pracuję z AI od dłuższego czasu, mogę powiedzieć, że aspekty techniczne są kluczowe. Rozłóżmy to, co musisz wiedzieć.

W przypadku ChatGPT wymagana jest minimalna konfiguracja, a OpenAI zajmuje się resztą.

Aby samodzielnie hostować model LLM, musisz dogłębnie rozumieć uczenie maszynowe i przetwarzanie języka naturalnego. Najlepiej byłoby mieć biegłość w infrastrukturze chmury lub zarządzaniu sprzętem poza lokalizacją. Ponadto będziesz potrzebować również rozległej wiedzy na temat dostrajania i optymalizacji.

Wiele osób nie docenia wymaganej wiedzy fachowej, co prowadzi do niepowodzeń. Nie chodzi tylko o pobranie modelu — chodzi o jego skuteczne wdrożenie i utrzymanie.

Kluczowe czynniki techniczne:

- Opóźnienie: Modele hostowane samodzielnie mogą oferować krótsze czasy reakcji, jeśli zostaną odpowiednio zoptymalizowane

- Personalizacja: Pełna kontrola nad architekturą modelu i danymi treningowymi

- Debugowanie: Łatwiejsza diagnoza i rozwiązywanie problemów w przypadku modeli hostowanych samodzielnie

Werdykt: ChatGPT jest wyraźnym zwycięzcą dla tych, którzy szukają rozwiązania typu plug-and-play. Jednak jeśli masz wiedzę techniczną i chęć pełnej kontroli, samodzielne hostowanie może zapewnić niezrównane możliwości dostosowywania i potencjalne korzyści wydajnościowe.

Analiza przypadków użycia

Jako profesjonalista AI widziałem różne scenariusze, w których różne rozwiązania LLM się sprawdzają. Przyjrzyjmy się kilku rzeczywistym przypadkom użycia, aby pomóc Ci podjąć decyzję.

Subskrypcja ChatGPT

Małe i średnie firmy często korzystają z łatwości użytkowania ChatGPT. Przy ograniczonych zasobach technicznych i potrzebie szybkiego wdrożenia obserwowałem, jak startupy szybko prototypowały funkcje AI, oszczędzając miesiące czasu rozwoju.

Zespoły ds. tworzenia treści i marketingu rozwijają się dzięki różnorodnym możliwościom językowym ChatGPT. Agencja marketingowa, z którą współpracowałem, używała go do burzy mózgów na temat pomysłów na kampanie i tworzenia postów w mediach społecznościowych, co znacznie zwiększyło ich produktywność.

Automatyzacja obsługi klienta to kolejny obszar, w którym ChatGPT się wyróżnia. Dostępność 24/7 i możliwość obsługi ogólnych zapytań sprawiają, że jest to wybór dla wielu firm, którym doradzałem.

Samodzielne prowadzenie LLM

Duże przedsiębiorstwa o dużych wolumenach często uważają, że samodzielne hostowanie jest bardziej ekonomiczne. Pomogłem platformie e-commerce przejść na model samodzielnego hostowania, obniżając koszty AI o 60% w ciągu roku.

Branże o wysokim stopniu regulacji korzystają z kontroli, jaką oferuje samodzielne hostingowanie. Firma fintech, której doradzałem, wybrała tę drogę, aby zapewnić zgodność z GDPR i chronić poufne dane finansowe.

Specjalistyczne aplikacje domenowe często wymagają niestandardowych modeli. Pracowałem ze startupem technologii prawnych, który dopracował model open-source w dokumentach prawnych, przewyższając ogólne modele w analizie umów.

Kluczowe czynniki - obejmują wolumen zapytań, wrażliwość danych, zasoby techniczne i potrzeby dostosowywania. Większe wolumeny i bardziej wrażliwe dane często uzasadniają samodzielne hostowanie, podczas gdy ograniczone zasoby sprzyjają ChatGPT.

Wniosek

Po głębokim zanurzeniu się w świat LLM-ów jasne jest, że wybór między ChatGPT a modelami hostowanymi samodzielnie nie jest czarno-biały. Jako entuzjasta i profesjonalista AI widziałem udane wdrożenia obu podejść.

ChatGPT wyróżnia się łatwością obsługi, stałą wydajnością i regularnymi aktualizacjami. To doskonały wybór dla firm poszukujących szybkiego, bezproblemowego rozwiązania AI. Model subskrypcji sprawdza się dobrze w przypadku umiarkowanego użytkowania i ogólnych zastosowań.

Z drugiej strony, self-hosting oferuje niezrównaną kontrolę, potencjał personalizacji i prywatność danych. Jest idealny dla użytkowników o dużej liczbie użytkowników, specjalistycznych aplikacji i branż z surowymi przepisami dotyczącymi danych. Początkowa konfiguracja może być trudna, ale długoterminowe korzyści mogą być znaczące.

Pamiętaj, że to nie jest stały wybór. W miarę jak Twoje potrzeby ewoluują, a krajobraz AI się zmienia, zawsze możesz dokonać ponownej oceny i zmienić podejście.

Ostatecznie najlepszym wyborem jest ten, który jest zgodny z Twoimi celami, zasobami i wizją integracji AI w Twoim przepływie pracy. Niezależnie od tego, czy zdecydujesz się na wygodę ChatGPT, czy kontrolę samodzielnego hostingu, wkraczasz w ekscytujący świat możliwości opartych na AI.