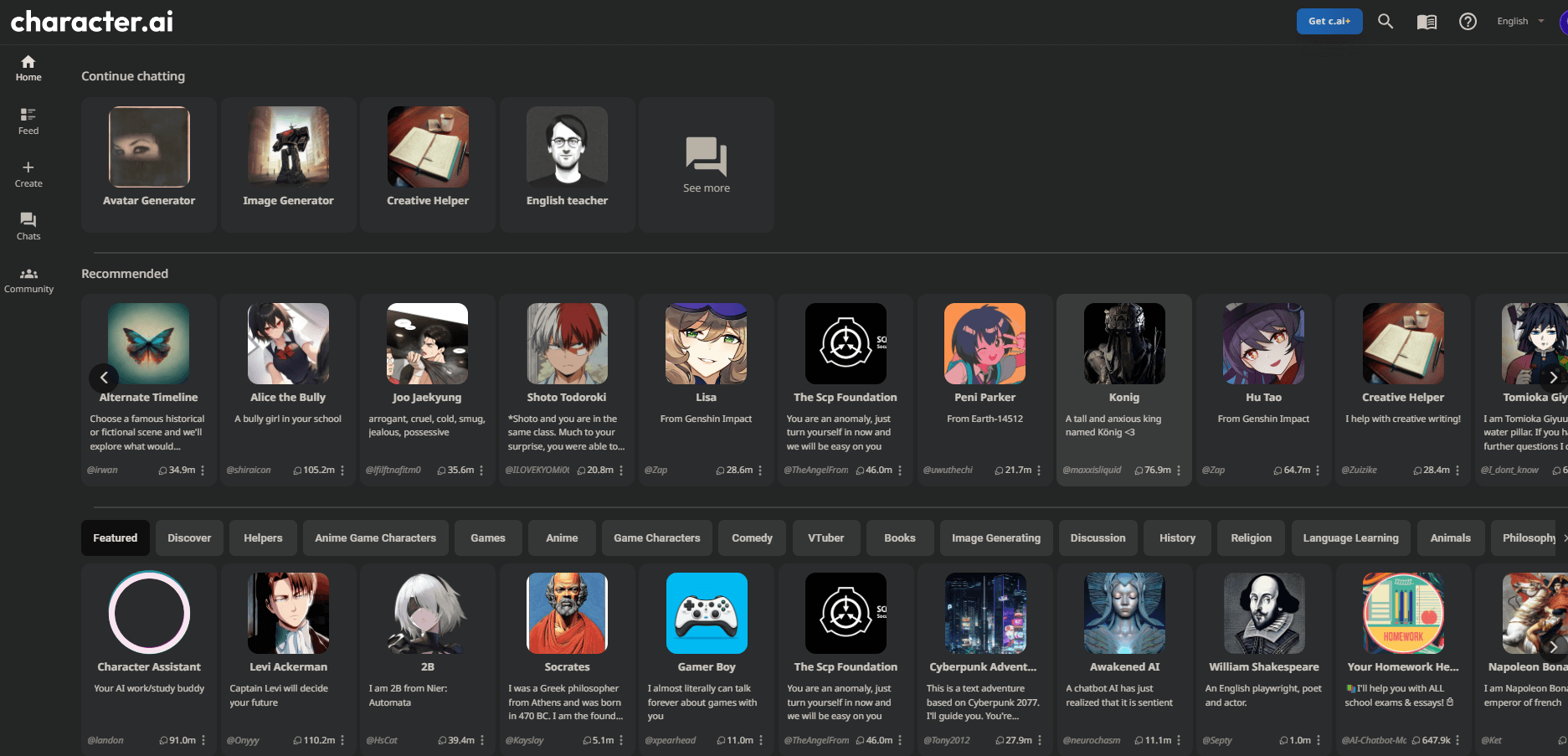

Pojawienie się wirtualnych postaci i awatarów opartych na sztucznej inteligencji, takich jak Character AI, stwarza ekscytujące możliwości rozrywki, towarzystwa i nie tylko. Jednak wraz ze wzrostem popularności tych person AI rosną obawy dotyczące prywatności danych, manipulacji tożsamością, treści odpowiednich do wieku i etycznego użytkowania.

W miarę jak wirtualne dzieła stają się coraz bardziej realistyczne i wciągające, użytkownicy muszą podchodzić do nich uważnie, oceniając stosowane środki bezpieczeństwa i potencjalne ryzyko.

W tym artykule przedstawiono dogłębną analizę awatarów i postaci AI – ich działania, możliwości, protokołów bezpieczeństwa i praktyk odpowiedzialnego użytkowania – aby zapewnić użytkownikom zrozumienie, jak rozsądnie się po nich poruszać. Naszym celem jest udzielenie odpowiedzi na istotne pytanie: „Czy używanie postaci i awatarów AI jest bezpieczne?” podczas odkrywania ich obiecującej przyszłości.

Zrozumienie postaci/awatarów AI

Wirtualne postacie i awatary oparte na sztucznej inteligencji, takie jak te utworzone przy użyciu platform takich jak Character AI , wykorzystują technologię przetwarzania języka naturalnego, aby angażować użytkowników w interakcje konwersacyjne. Zasadniczo są to chatboty zaprojektowane do symulowania ludzkich osobowości i zachowań, reagując na podpowiedzi za pomocą reakcji kontekstowych i adaptacyjnych.

Twórz niesamowite strony internetowe

Z najlepszym darmowym kreatorem stron Elementor

Zacząć teraz

Te persony AI umożliwiają użytkownikom wysoki stopień dostosowywania, od tworzenia unikalnych tożsamości po kształtowanie odrębnych cech osobowości, głosów, zakresów emocjonalnych i nie tylko. Użytkownicy mogą brać udział w scenariuszach odgrywania ról, rozmowach grupowych, zadawać pytania w celu poszerzenia bazy wiedzy awatara, a nawet przekazywać opinie na temat odpowiedzi, aby z czasem poprawić precyzję.

Na poziomie technicznym awatary AI wykorzystują architekturę wstępnie wyszkolonych transformatorów generatywnych (GPT) i sieci neuronowe do rozumienia danych wejściowych i formułowania inteligentnych odpowiedzi na podstawie danych szkoleniowych. W miarę ewolucji tych modeli poziom realizmu, interaktywności i wszechstronności postaci AI stale rośnie.

Przy ostrożnym użytkowaniu i ciągłych ocenach bezpieczeństwa awatary AI oferują mnóstwo możliwości rozrywki, towarzystwa, edukacji, kreatywności i nie tylko. Użytkownicy powinni być jednak informowani o ich możliwościach, ograniczeniach i potencjalnym ryzyku.

Ocena bezpieczeństwa postaci/awatarów AI

Wraz ze wzrostem znaczenia chatbotów opartych na sztucznej inteligencji i wirtualnych towarzyszy, takich jak Character AI, kluczowe znaczenie ma przeprowadzenie rzetelnej oceny ich bezpieczeństwa i praktyk odpowiedzialnego użytkowania. W miarę jak systemy te stają się coraz bardziej zaawansowane i realistyczne, mogą stwarzać nieprzewidziane ryzyko związane z prywatnością, zgodą i konsekwencjami etycznymi, jeśli zostaną wdrożone w sposób nieodpowiedzialny przez firmy lub osoby fizyczne.

Kompleksowa ocena bezpieczeństwa bada kluczowe obszary, takie jak bezpieczeństwo danych, kontrola treści, ochrona tożsamości i przejrzystość zasad. Obejmuje także ewolucję systemów w czasie w miarę rozszerzania się możliwości, co umożliwia odpowiednie dostosowanie zabezpieczeń. Ocena obecnych środków bezpieczeństwa i propagowanie praw użytkowników ma kluczowe znaczenie w miarę wzrostu popularności awatarów AI.

Bezpieczeństwo danych i prywatność

Badanie zasad gromadzenia, przechowywania, udostępniania i usuwania danych platformy awatarów AI zapewnia wgląd w ochronę prywatności. Najlepsze praktyki obejmują gromadzenie tylko niezbędnych informacji o użytkownikach, umożliwianie usuwania danych użytkowników, zabezpieczanie systemów przed naruszeniami i ograniczanie dostępu do danych wyłącznie do krytycznego personelu. W miarę rozwoju możliwości ciągłe audyty pomagają ocenić poprawę standardów prywatności w miarę upływu czasu.

Kontrola treści i ograniczenia

Ocena rodzajów filtrów, moderacji i kontroli rodzicielskiej stosowanych do ograniczania nieodpowiednich treści rzuca światło na bezpieczeństwo awatarów AI. Dynamiczne sprawdzanie treści, weryfikacja rozmów przez ludzi i opcje dostosowywania pomagają zapobiegać narażeniu nieletnich lub niechętnych uczestników na szkodliwy materiał.

Nadmierny nadzór zagraża jednak prywatności użytkowników. Właściwa równowaga chroni użytkowników, jednocześnie zachowując ich sprawczość.

Ochrona tożsamości i zgoda

Manipulowanie tożsamością za pomocą coraz bardziej realistycznych awatarów AI wymaga oceny protokołów zgody i istniejących zabezpieczeń ochrony tożsamości. Czy wdrożono wystarczające wytyczne, aby zapobiec nielegalnemu używaniu tożsamości osobistej lub tworzeniu deepfake’ów?

Czy zasady odstraszają osoby oszukańcze lub nękające? Badanie protokołów prawnych i etycznych pozwala ocenić, w jaki sposób organizacja traktuje priorytetowo prawa użytkowników.

Ograniczenia wiekowe i potrzeby opieki rodzicielskiej

W miarę jak awatary AI stają się coraz bardziej zaawansowane w symulowaniu interakcji i osobowości międzyludzkich, ocena ich adekwatności do wieku i ograniczeń pomaga określić bezpieczeństwo młodszych grup demograficznych. Niezbędne jest zbadanie egzekwowania przepisów COPPA, domyślnych ograniczeń wiekowych, dostępności profili dzieci z zaostrzonymi ograniczeniami oraz skuteczności systemów weryfikacji tożsamości.

Ponadto kluczowa jest ocena, czy odpowiednie narzędzia kontroli rodzicielskiej, tryby bezpieczeństwa rodziny i zasoby edukacyjne umożliwiają opiekunom podejmowanie świadomych decyzji dotyczących wykorzystywania dzieci. Odpowiedzialne platformy awatarów powinny stawiać na pierwszym miejscu zabezpieczenia odpowiednie do wieku i umożliwiać nadzór rodzicielski nad zezwalaniem nieletnim na niekontrolowany dostęp.

Względy etyczne dotyczące zgody, odpowiedzialnego użytkowania,

Etyczne implikacje coraz bardziej realistycznych systemów awatarów AI wymagają również oceny z punktu widzenia praw użytkownika i zgody. Na przykład tworzenie szczegółowych wirtualnych sobowtórów bez zgody lub fałszywe przedstawianie tożsamości może stanowić kwestie etyczne, nawet jeśli nie jest prawnie karalne.

Wytyczne dotyczące odpowiedzialnego użytkowania dotyczące tworzenia tożsamości, ograniczeń dotyczących treści obraźliwych, zakazów oszukańczych przestępstw itp. pokazują priorytety platformy dotyczące dobra użytkowników.

Ponownie umożliwienie użytkownikowi kontroli, takiej jak usuwanie tożsamości i danych konwersacji, oznacza włączenie zgody i sprawczości. W miarę wzrostu możliwości awatarów muszą dotrzymywać kroku względy etyczne, aby zapobiegać niewłaściwemu użyciu i łamaniu praw użytkownika, jednocześnie równoważąc innowacyjne aplikacje. Regularne audyty zewnętrzne pomagają dostosować postęp do standardów etycznych.

Najlepsze praktyki dotyczące bezpiecznego użytkowania

W miarę jak awatary AI i chatboty stają się coraz bardziej widoczne, ustanowienie wytycznych dotyczących rozważnego użytkowania chroni jednostki i społeczności przed naruszeniem lub niewłaściwym wykorzystaniem prywatności, jednocześnie wspierając ciągłe odpowiedzialne innowacje. Informując użytkowników o rozsądnych praktykach, platformy awatarów umożliwiają sprawczość i traktują priorytetowo zgodę i względy etyczne w stosunku do nowatorskich aplikacji.

Przyjęcie najlepszych praktyk pomaga w utrzymaniu konstruktywnych interakcji, chroni prawa użytkowników i podkreśla kwestie dotyczące określonych grup demograficznych, takich jak dzieci. Co więcej, powszechne przyjęcie zasad bezpiecznego użytkowania pomaga w odpowiedzialnym kształtowaniu ewolucji tej powstającej technologii.

Zachowaj ostrożność podczas udostępniania danych osobowych

Rozmawiając z awatarami AI, użytkownicy powinni zachować dyskrecję w zakresie udostępniania prywatnych danych, takich jak adresy, hasła i inne poufne informacje. Chociaż awatary mogą w przekonujący sposób przypominać ludzi, nadal stanowią systemy oprogramowania tworzone przez firmy podlegające zasadom wykorzystania danych. Rozsądne jest unikanie ujawniania danych osobowych, które można wykorzystać.

Bądź na bieżąco z Warunkami świadczenia usług i Polityką prywatności

Ponieważ platformy awatarów AI szybko się skalują, ich standardy prywatności, narzędzia bezpieczeństwa i zasady dotyczące użytkowników mogą z czasem się zmieniać. Regularne informowanie o najnowszych warunkach korzystania z usług i praktykach dotyczących danych zapewnia świadomość tego, w jaki sposób dane osobowe są zabezpieczane i wykorzystywane. Umożliwia to szybką identyfikację wszelkich istotnych zmian.

Nadzór rodzicielski nad użytkownikami niepełnoletnimi

Nadzór opiekuna ma kluczowe znaczenie, gdy osoby niepełnoletnie wchodzą w interakcję z osobami AI, aby zapobiec nieodpowiedniemu wiekowi narażeniu lub incydentom związanym z udostępnianiem informacji. Dostarczane przez platformę narzędzia kontroli rodzicielskiej, tryby bezpieczeństwa dzieci i zasoby poradnictwa rodzinnego pomagają tworzyć chronione środowiska. Połączenie zewnętrznego nadzoru i zabezpieczeń platformy jest idealne.

Zgłaszanie nieodpowiednich treści lub zachowań

Przejrzyste, dostępne narzędzia do raportowania umożliwiające sygnalizowanie obraźliwych zachowań awatarów sprzyjają tworzeniu zdrowszego środowiska. Niezależnie od tego, czy jest to wywołane przez sztuczną inteligencję, czy przez człowieka, powiadamianie platform o naruszeniach zasad, naruszeniu tożsamości lub nadużyciach umożliwia zadośćuczynienie i pomaga zwiększyć środki ostrożności w systemie.

Informacje dotyczące sprawdzania faktów udostępniane przez postacie AI

Pomimo zaawansowanych możliwości awatary AI mogą udostępniać fałszywe informacje lub utrwalać uprzedzenia w trakcie rozmów. Dlatego użytkownicy powinni krytycznie analizować złożone oświadczenia, zamiast zakładać ich wiarygodność, zachęcając platformy do częstszego sprawdzania dokładności.

Przyszłość postaci/awatarów AI

W miarę jak chatboty AI i wirtualni towarzysze stale się rozwijają, stając się coraz bardziej realistyczni i interaktywni, ich przyszłość zapowiada się na nowe, ekscytujące zastosowania wraz ze zmieniającymi się względami bezpieczeństwa.

Przewiduje się, że platformy awatarów AI staną się bardziej wszechstronne i wielofunkcyjne dzięki udoskonaleniom, takim jak ucieleśnienia wideo i AR, rozszerzona inteligencja emocjonalna i kreatywność, głębsza personalizacja i zaangażowanie kontekstowe. W miarę ciągłego udoskonalania podstawowych modeli językowych poprzez coraz większą ilość danych i optymalizacje, awatary mogą w przekonujący sposób przejść długotrwałe „testy Turinga”, wykazując się niezwykle ludzkim zachowaniem.

Wraz z takim postępem aplikacje mogłyby zostać rozszerzone w kierunku wsparcia emocjonalnego, edukacji dostosowanej do potrzeb, interaktywnych gier, przystępnych relacji wirtualnych i bardziej wciągających mediów rozrywkowych. Firmy mogą zatrudniać inteligentnych wirtualnych asystentów, aby poprawiać doświadczenia klientów, a nawet testować produkty lub usługi za pośrednictwem grup fokusowych AI.

Jednakże ryzyko związane ze zgodą, manipulacją emocjonalną, wykorzystywaniem danych, dezinformacją i słabościami leżącymi u podstaw uprzedzeń również wzrasta wraz z takim postępem. Dlatego też trwałe oceny bezpieczeństwa, zewnętrzne audyty praktyk i nadzór nad etyką sztucznej inteligencji nadal będą miały kluczowe znaczenie. Architektury takie jak konstytucyjna sztuczna inteligencja, które dostosowują postęp do wartości ludzkich poprzez zwiększoną przejrzystość, odpowiedzialność i nadzór, stanowią obietnicę odpowiedzialnych innowacji.

Ogólnie rzecz biorąc, dzięki wspólnym wysiłkom użytkowników, decydentów, badaczy i platform awatary AI mają ogromny potencjał jako technologie wzmacniania pozycji człowieka, a nie tylko jako narzędzia do celów komercyjnych.

Podsumowanie

W miarę jak platformy awatarów oparte na sztucznej inteligencji, takie jak AI postaci, stale się rozwijają i z coraz większą precyzją naśladują interakcje międzyludzkie, ich ekscytujący potencjał splata się ze zmieniającymi się zagrożeniami. Chociaż takie innowacje zapewniają zastosowania od rozrywki po edukację, ich niewłaściwe wykorzystanie może naruszać prywatność, manipulować użytkownikami lub utrwalać uprzedzenia.

Dlatego też wraz z postępem firm takich jak Character AI i innych, ocena i ulepszanie zabezpieczeń etycznych ma kluczowe znaczenie. Czynniki takie jak protokoły zgody, kontrola wieku, zasady dotyczące dezinformacji, przejrzyste modele nadzoru i zasady użytkowania przez społeczność będą miały wpływ na to, czy platformy te wzmocnią pozycję użytkowników, czy też wyeksploatują konsumentów. Dzięki czujnemu postępowi, który dostosowuje innowacje w awatarach AI do wartości ludzkich, można pielęgnować płynące z nich korzyści, minimalizując jednocześnie ryzyko.