Nu de wereld steeds digitaler wordt, is de vraag naar hoogwaardige content nog nooit zo groot geweest. Gelukkig hebben ontwikkelingen in natuurlijke taalverwerking (NLP) geleid tot krachtige AI-gestuurde schrijftools, zoals die ontwikkeld door Hugging Face. Maar wat als u deze modellen offline moet gebruiken? Wees niet bang, want we gaan onderzoeken hoe u Hugging Face-modellen kunt gebruiken zonder internetverbinding.

Offline toegang tot de geavanceerde taalmodellen van Hugging Face opent een wereld aan mogelijkheden. Of u nu op afgelegen locaties werkt, te maken hebt met onbetrouwbare internetconnectiviteit of gewoon prioriteit geeft aan gegevensprivacy, de mogelijkheid om deze modellen lokaal uit te voeren kan een game-changer zijn. Door te begrijpen hoe u Hugging Face-modellen offline kunt implementeren, kunt u nieuwe niveaus van efficiëntie, flexibiliteit en controle in uw contentcreatieproces ontgrendelen.

In deze blogpost duiken we in de praktische stappen die je kunt nemen om de kracht van Hugging Face-modellen offline te benutten. Van modelimplementatie tot naadloze integratie met je bestaande workflows, je leert hoe je het potentieel van deze geavanceerde NLP-tools kunt maximaliseren, zelfs wanneer een internetverbinding niet direct beschikbaar is. Bereid je voor om je contentcreatie naar een hoger niveau te tillen en voorop te blijven lopen in de voortdurend veranderende wereld van digitale marketing en communicatie.

Waarom zou u het Huggingface Model offline willen gebruiken?

Je vraagt je misschien af waarom iemand de moeite zou nemen om AI-modellen offline te draaien. Maar geloof me, er zijn een aantal serieus dwingende redenen om je Hugging Face-modellen off the grid te halen.

Maak geweldige websites

Met de beste gratis paginabuilder Elementor

Begin nuHier is een beknopte uitleg waarom iemand Hugging Face-modellen offline zou willen gebruiken:

Het offline gebruiken van Hugging Face-modellen biedt verschillende belangrijke voordelen:

- Betrouwbaarheid: Werk ononderbroken zonder u zorgen te maken over problemen met de internetverbinding.

- Snelheid: elimineer netwerklatentie voor snellere modelinferentie.

- Privacy: bewaar gevoelige gegevens lokaal en voorkom mogelijke beveiligingsrisico's van onlineverwerking.

- Kostenefficiëntie: verlaag de kosten voor cloud computing door modellen op uw hardware uit te voeren.

- Draagbaarheid: gebruik geavanceerde AI-mogelijkheden op afgelegen locaties of in gebieden met beperkte internettoegang.

- Leren: Krijg een dieper inzicht in de architectuur en werking van modellen door er direct mee te werken.

- Aanpassing: U kunt modellen eenvoudiger verfijnen en aanpassen voor specifieke use cases wanneer u lokale toegang hebt.

Laten we eens kijken hoe je het volledige potentieel van Hugging Face-modellen kunt benutten, altijd en overal.

Hoe kun je Huggingface-modellen offline gebruiken?

Huggingface is als een Github of app store voor open-source AI. Hier kunt u talloze open-source LLM's van deze website bekijken, downloaden en zelfs gebruiken. Bovendien hebben ze, net als ChatGPT, Hugging Chat. Met deze chatbot kunt u een model kiezen dat u wilt gebruiken en later kunt u hiermee een gesprek voeren, zoals u dat met elke andere multi-model AI-assistent zou doen.

Hoe geweldig zou het zijn om deze modellen volledig gratis, offline dagelijks te gebruiken? Laten we dat doen.

LM-Studio

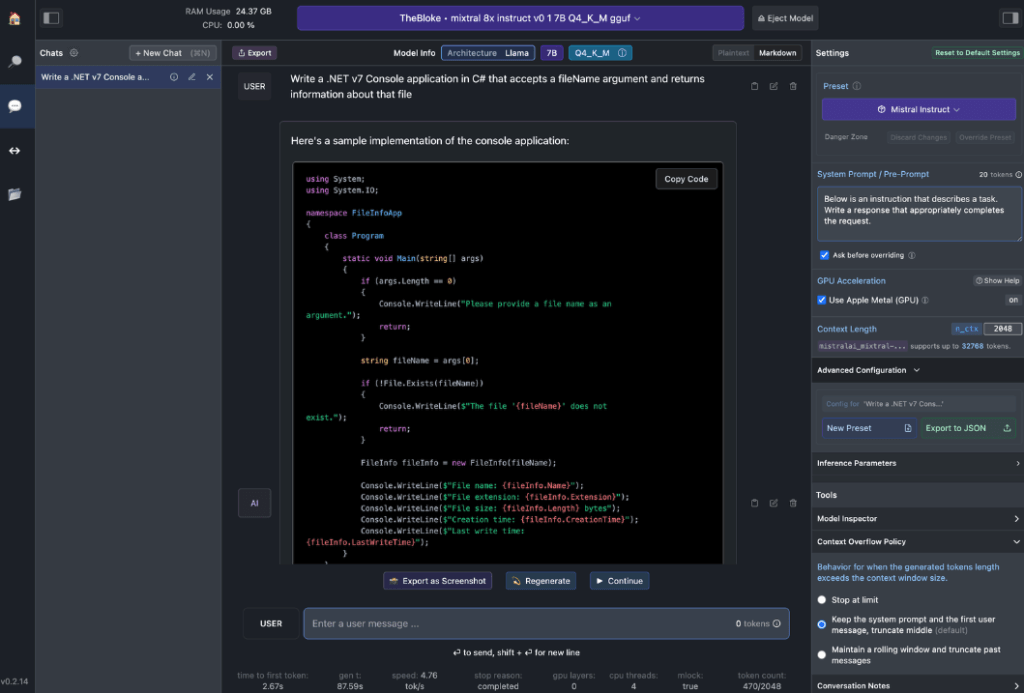

LM Studio revolutioneert de manier waarop we AI-modellen lokaal gebruiken. Deze veelzijdige app, beschikbaar voor Windows, Mac (Apple Silicon) en Linux (bèta), stelt gebruikers in staat om Hugging Face-modellen eenvoudig offline te downloaden en uit te voeren.

Belangrijkste kenmerken van LM Studio zijn:

- Lokale modelinteractie: download uw favoriete taalmodel (LLM) en ga ermee aan de slag zoals u dat met een chatgebaseerde AI-assistent zou doen. Pas de prestaties en het uitvoerformaat aan en verken experimentele functies via verschillende ingebouwde systeemprompts en opties.

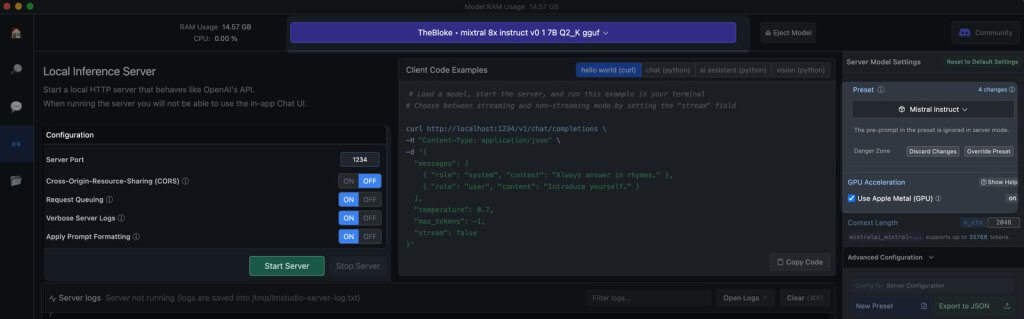

- OpenAI API-emulatie: dit is waar LM Studio echt schittert. Laad uw gedownloade Hugging Face-model en LM Studio wikkelt er op ingenieuze wijze een lokale API-proxy omheen, die de OpenAI API nabootst. Deze compatibiliteit is een game-changer, omdat het naadloze integratie met talloze SDK's en populaire Editor & IDE-extensies mogelijk maakt die OpenAI al ondersteunen.

Hardwarevereisten voor werkstations

Om het potentieel van offline Hugging Face-modellen echt te ontsluiten, heb je robuuste hardware nodig. Hoewel elke moderne computer basistaken aankan, zijn voor optimale prestaties krachtigere specificaties nodig:

Voor Apple-gebruikers:

- M2/M3 Max of Ultra-processors

- Hogere configuraties

- 50+ GB RAM (gedeeld met GPU op M2 SoC)

- Metalen ondersteuning voor verbeterde prestaties

Voor Windows-gebruikers:

- Meer kern-CPU

- Aanzienlijk RAM

- RTX 30 of 40 serie GPU met voldoende VRAM

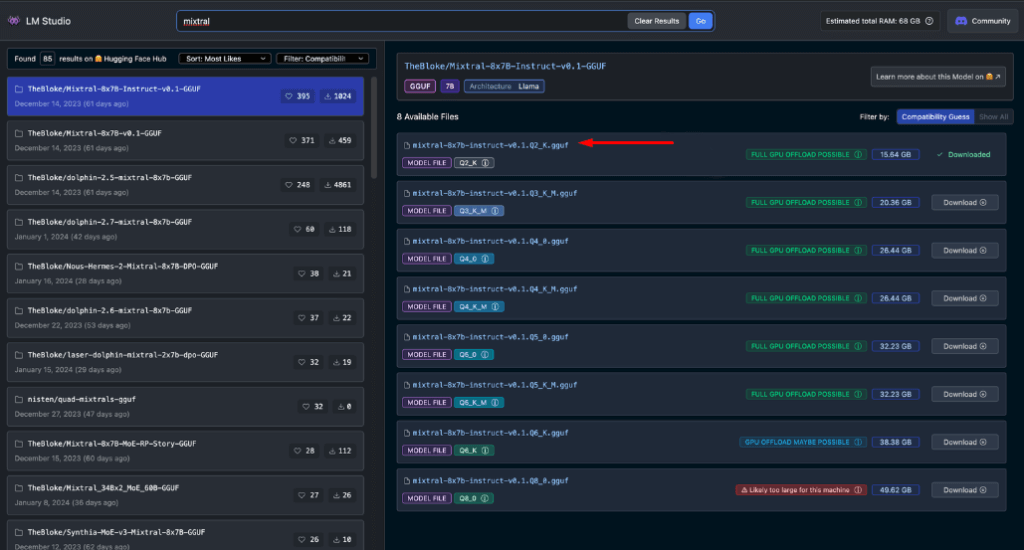

Maak je geen zorgen als je geen topklasse systeem hebt. Er bestaan veel RAM- en VRAM-vriendelijke opties, zelfs onder de nieuwste modellen. LM Studio schat op behulpzame wijze de mogelijkheden van je systeem in terwijl je modellen doorbladert en downloadt.

Over het algemeen correleren grotere modelbestanden en hogere resourcevereisten met een verbeterde outputkwaliteit. Hoewel het beter is om uw systeem niet tot het uiterste te drijven, moet u niet bang zijn om hoog te mikken binnen de mogelijkheden van uw hardware.

Onthoud: het doel is om de modelprestaties in evenwicht te brengen met de bronnen van uw systeem voor de beste offline Hugging Face-ervaring.

Aanbevolen modellen voor offline gebruik

Bij het offline uitvoeren van Hugging Face-modellen is het cruciaal om het juiste model te kiezen. Door uitgebreide tests heb ik ontdekt dat de volgende modellen consistent indrukwekkende resultaten leveren voor zowel algemene chat- als coderingstaken:

Elk van deze modellen biedt een unieke balans tussen prestaties en resourcegebruik, waardoor ze uitstekende keuzes zijn voor offline implementatie.

Voordat u verdergaat, is het van essentieel belang dat u deze modellen zelf evalueert:

- Download elk model in LM Studio

- Gebruik het AI-chattabblad om met het model te communiceren

- Test de prestaties ervan op verschillende taken, vooral codering als dat uw focus is

- Beoordeel de kwaliteit van de uitkomsten en hoe goed deze aansluiten bij uw behoeften

Vergeet niet dat uw ervaring kan verschillen op basis van uw specifieke use case en hardwaremogelijkheden. Neem de tijd om het model te vinden dat het beste bij uw vereisten past. Dit zorgvuldige selectieproces zorgt ervoor dat u het meest effectieve offline Hugging Face-model voor uw behoeften hebt voordat u doorgaat naar integratie en geavanceerder gebruik.

Lokale server in LM Studio

Het starten van uw offline Hugging Face-modelserver is heel eenvoudig:

- LM Studio openen

- Selecteer een van uw gedownloade modellen

- Klik op de knop Start Server

Dat is alles! De standaardinstellingen zijn over het algemeen geschikt voor de meeste gebruikers. Als u echter uw ervaring wilt verfijnen, kunt u de opties aanpassen aan uw specifieke behoeften of voorkeuren.

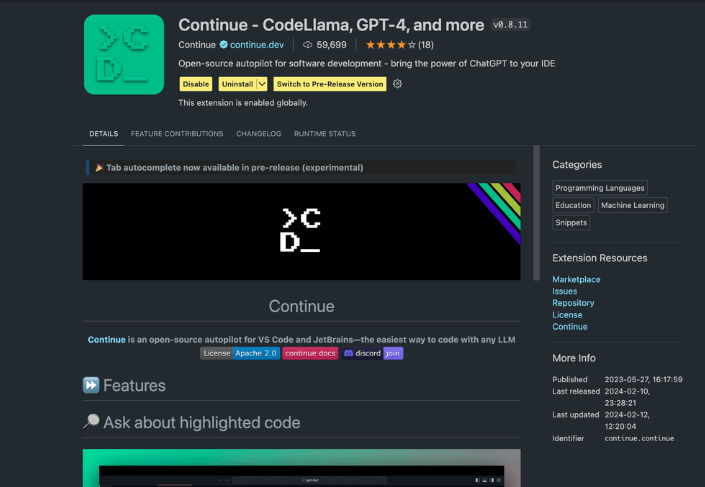

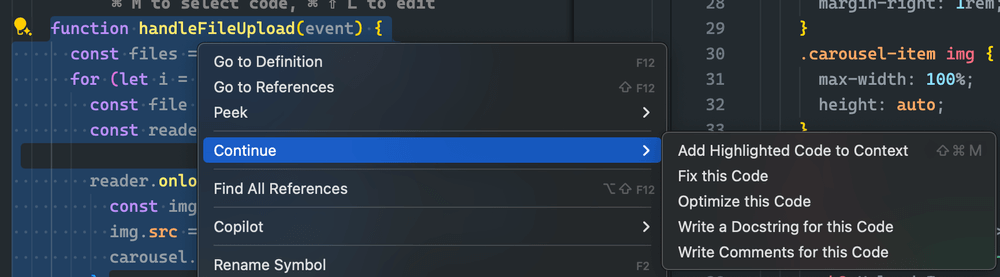

Gebruik van de Continue-extensie

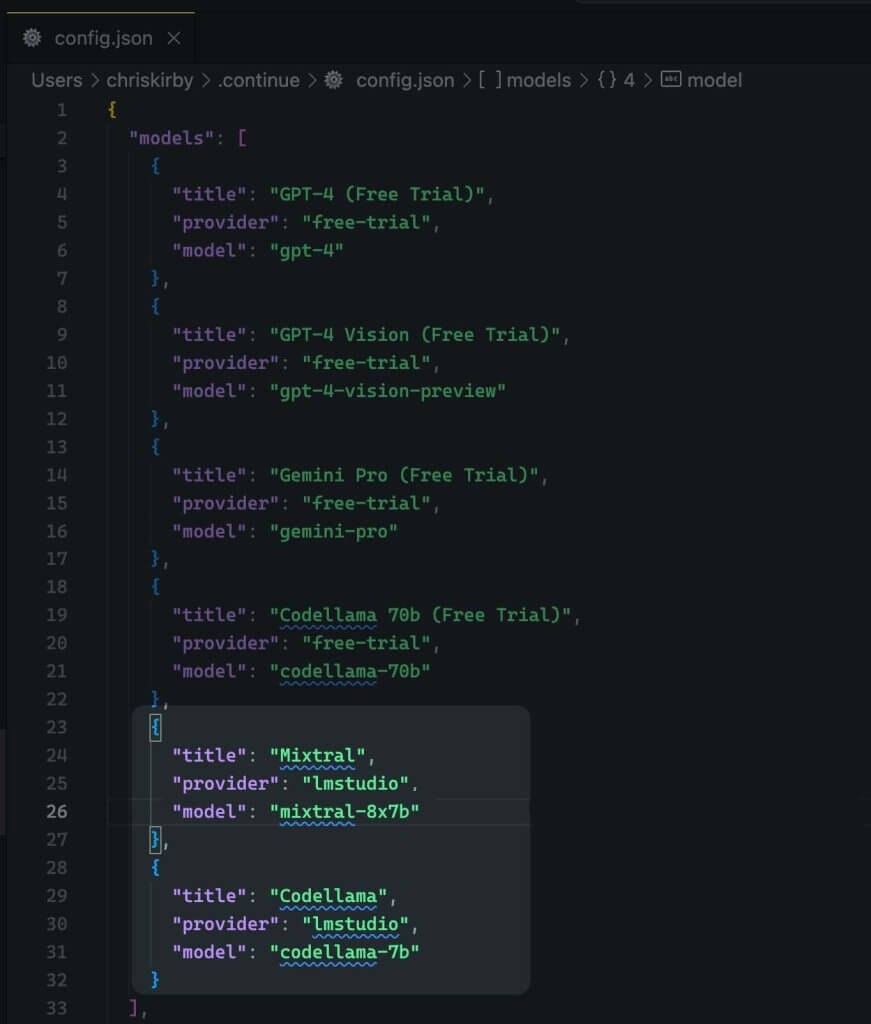

Navigeer vanuit de gestarte VS code studio naar de extensieweergave. Typ 'Doorgaan' in de zoekbalk. Zoek de juiste extensie en installeer deze.

Nu moeten we de configuratie-JSON van de extensie wijzigen. Dit zal de LM Studio-ondersteuning toevoegen.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Sla het nu op.

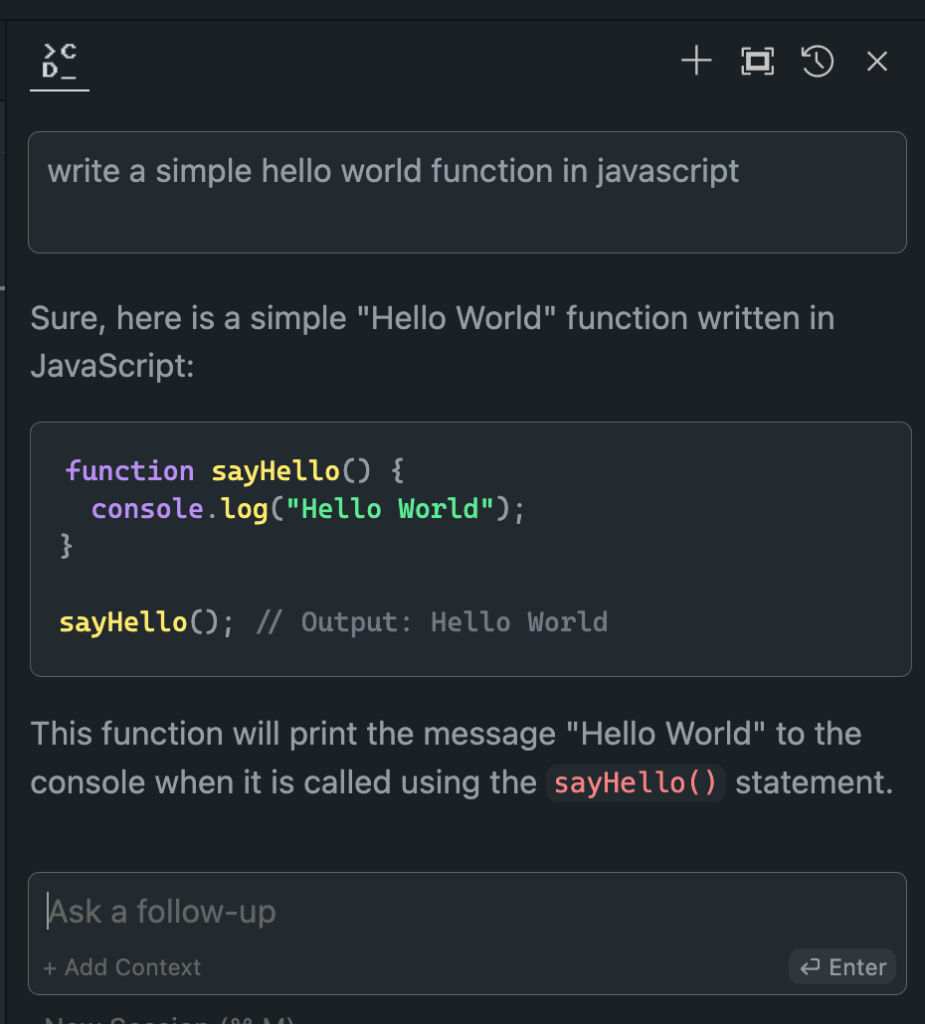

Vervolgens moet u dit lokale model gebruiken in plaats van de VS-code.

Evaluatie van offline versus online modelprestaties

Nu we ons offline Hugging Face-model hebben opgezet, is het tijd voor het moment van de waarheid. Laten we het eens testen met zijn online tegenhangers!

De resultaten die ik tijdens mijn uitgebreide onderzoeken heb behaald, zijn verbijsterend:

- Prestaties: Het offline model evenaart vaak de online equivalenten en overtreft ze in sommige gevallen zelfs.

- Snelheid: Zonder netwerklatentie kunnen reacties razendsnel zijn.

- Consistentie: Geen variabiliteit meer vanwege serverbelasting of verbindingsproblemen.

Hoewel uw ervaring kan variëren afhankelijk van uw gekozen model en hardware, wees niet verrast als u de voorkeur geeft aan de offline versie. De combinatie van lokale verwerkingskracht en verfijnde modellen kan indrukwekkende resultaten opleveren.

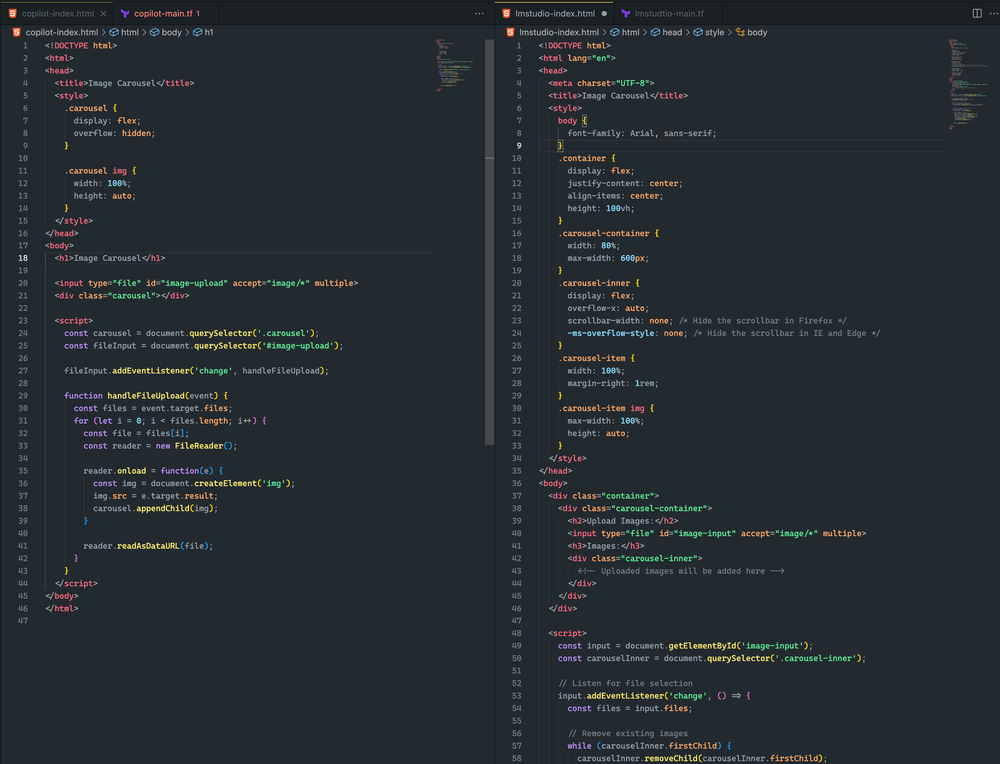

Zie hier het verschil.

Beide benaderingen waren vrij dicht bij elkaar. Hoewel geen van beide resulteerde in een beeldcarrousel, heb ik met succes een afbeelding geüpload en deze werd in beide voorbeelden gerenderd. Met verdere snelle aanpassingen denk ik dat ik een nog beter resultaat kan bereiken

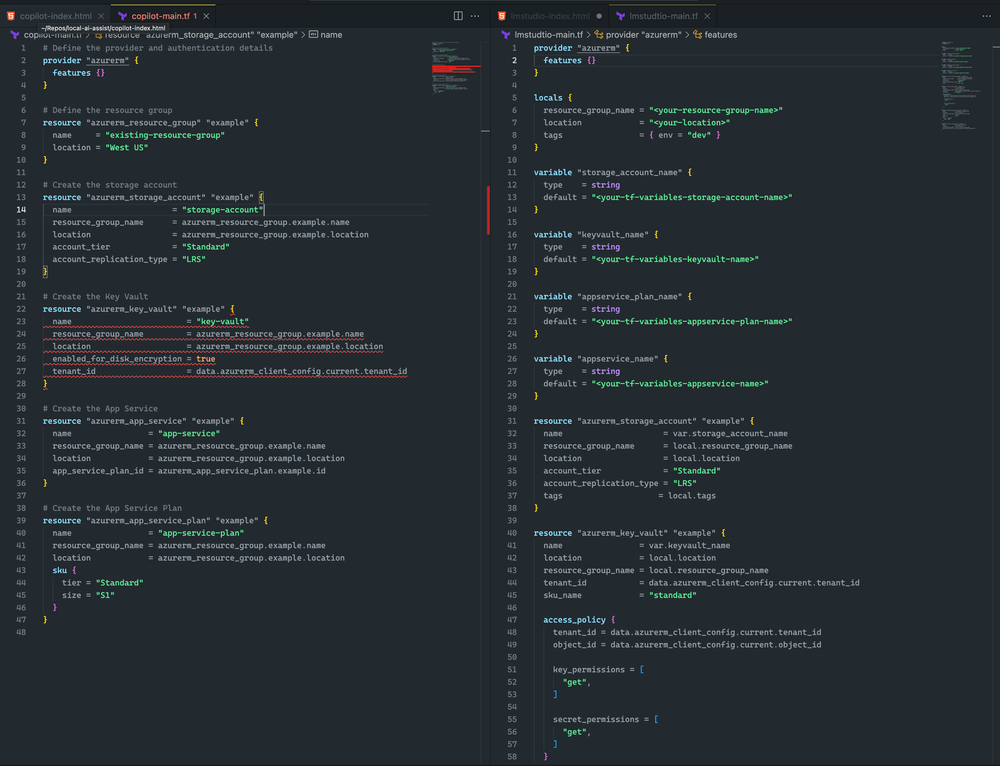

Ik neig naar LM Studio en Mixtral omdat Terraform completer is en geen syntaxisfouten heeft. CoPilot heeft echter een klein probleem: de key vault-declaratie mist de sku_name , wat eenvoudig kan worden opgelost.

Afronden

Vergeet niet dat het AI-veld zich snel ontwikkelt. Door offline implementatie van Hugging Face-modellen onder de knie te krijgen, houdt u niet alleen gelijke tred, maar blijft u ook voorop lopen. Of u nu een ontwikkelaar, onderzoeker of AI-enthousiasteling bent, deze vaardigheid stelt u in staat om de grenzen van wat mogelijk is met lokale AI-verwerking te verleggen.

Dus waag de sprong. Experimenteer met verschillende modellen, verfijn uw opstelling en integreer deze offline krachtpatsers in uw workflow. Misschien ontdekt u wel dat de toekomst van AI-ontwikkeling zich op uw lokale machine bevindt, wachtend om ontketend te worden.