AI 愛好家として、私は大規模言語モデル (LLM) の驚くべき台頭を直接目撃してきました。これらの強力な AI ツールは、テクノロジーとの関わり方に革命をもたらし、企業と個人の両方にジレンマを引き起こしています。

サブスクリプション サービスの利便性を受け入れるべきか、それともモデルをホストして制御するべきでしょうか。この質問はコストだけの問題ではなく、パフォーマンス、プライバシー、スケーラビリティにも関係します。

このブログ記事では、私の経験と最新の業界動向に基づいて両方のオプションを検討し、皆さんが特定のニーズとリソースに合った情報に基づいた決定を下せるようお手伝いします。

LLMホスティングとChatGPTサブスクリプション:オプションを理解する

LLM 分野における 2 つの主要候補を分析してみましょう。

素晴らしいウェブサイトを作成します

最高の無料ページビルダーElementor を使用

今すぐ始めるChatGPTサブスクリプション

ChatGPT が有名になったのは、当然のことです。加入者には以下の特典があります。

- 最先端の言語モデルへのアクセス

- 定期的なアップデートと改善

- ユーザーフレンドリーなインターフェース

- さまざまなアプリケーションに統合できる堅牢なAPI

料金はシンプルで、使用量に応じて支払います。一般ユーザーや小規模企業にとって、これは非常にコスト効率が良いと言えます。

セルフホスティングオープンソースLLM

反対に、DIY アプローチもあります。LLaMA や GPT-NeoX などの人気のオープンソース モデルは、次の機能を提供します。

- モデルを完全に制御

- カスタマイズオプション

- データのプライバシー

- 大規模なコスト削減の可能性

ここでは、主に 2 つの展開オプションがあります。

a) クラウドホスティング(AWS、Google Cloud、Azure)

b) オンプレミスハードウェア

それぞれの道には長所と短所があり、後ほど詳しく検討していきます。

これらのオプションの選択は必ずしも明確ではありません。それは、あなたの特定のニーズ、リソース、そして長期的な目標によって異なります。次のセクションでは、考慮すべき重要な要素を説明し、あなたの独自の状況に最適な決定を下せるようお手伝いします。

コスト比較

LLM に関しては、費用が大きな決定要因となることがよくあります。数字を分析してみましょう。

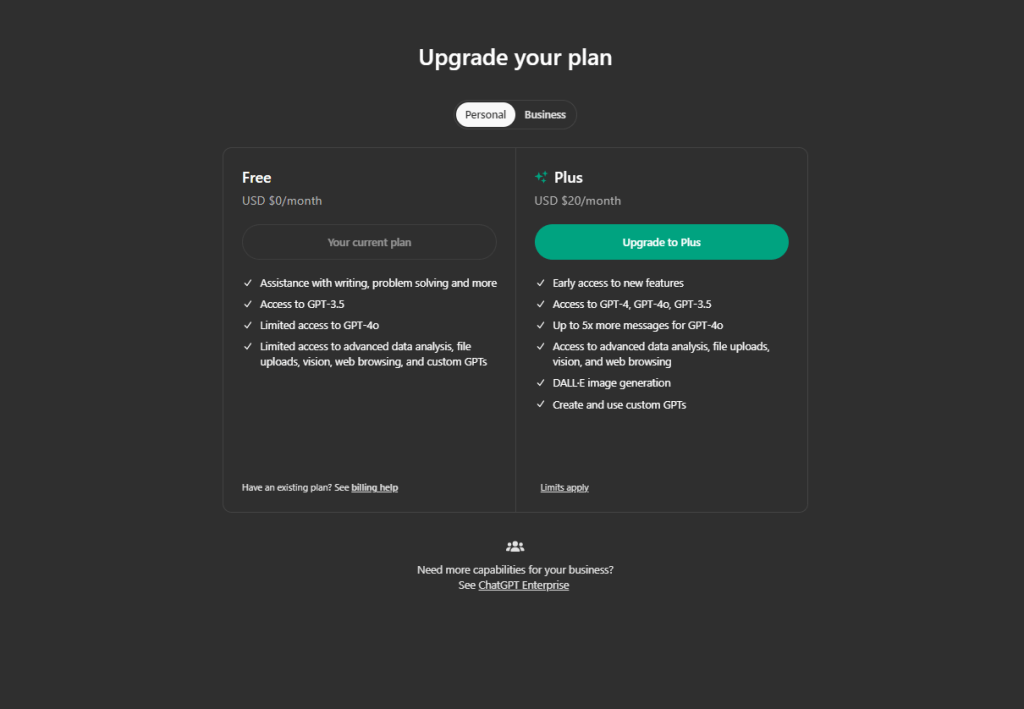

ChatGPTサブスクリプション

ChatGPTを使用する場合、サブスクリプションの費用は次のようになります。

- 現在、OpenAI は 1K トークンあたり 0.002 ドルを請求します。

- ちなみに、1K トークンはおよそ 750 語です。

- 通常、1 日に 5,000 件のクエリを実行すると、コストは約 6.5 ドルになります。

- 中程度の使用であれば、月額約 200 ドルになります。

合理的に思えますよね? しかし、ここに落とし穴があります。使用量が多ければコストが急騰する可能性があります。毎日何千ものクエリを処理している場合、毎月の請求額はすぐに目が飛び出るほど高額になる可能性があります。

セルフホスティングオープンソースLLM

独自のセルフホスト型 LLM を作成する場合、以下の費用がかかります。

- ハードウェア: NVIDIA RTX 3090 のようなハイエンド GPU の価格は約 700 ドルです。

- クラウド ホスティング: AWS では、100 万件のリクエストに対して 1 日あたり約 150 ~ 160 ドルかかります。

- 電気代も忘れないでください。強力な GPU を 24 時間 365 日稼働させると、電気代は 0.12 ドル/kWh とかさみます。

- 人件費: システムをセットアップして維持するには専門知識が必要です。

セルフホスティングの初期設定は高価ですが、長期にわたって大量に使用する場合はコスト効率が高くなります。

考慮すべき隠れたコスト:

- 時間: セルフホスト型システムのセットアップはすぐには完了しません。

- アップグレード: AI の世界ではテクノロジーが急速に進化しています。

- ダウンタイム: 自己ホスト型システムでは、中断が多く発生する可能性があります。

結論: ChatGPT のサブスクリプション モデルは、低ボリュームのユーザーの場合、コストの面で優れていることがよくあります。ただし、毎月何百万ものクエリが予想される場合は、長期的にはセルフホスティングの方がコストを節約できる可能性があります。

パフォーマンスと品質

LLM に関しては、パフォーマンスが重要です。ChatGPT とオープンソース モデルの比較を見てみましょう。

ChatGPTの機能

- 一貫して高品質の応答

- 多様なトピックをカバーする幅広い知識ベース

- 定期的なアップデートでパフォーマンスを向上

- 複雑なクエリやタスクを処理する能力

ChatGPT は、クリエイティブな文章作成や問題解決のシナリオで特に印象的だと感じました。その応答は、人間らしく、状況に合っていると感じることが多いです。

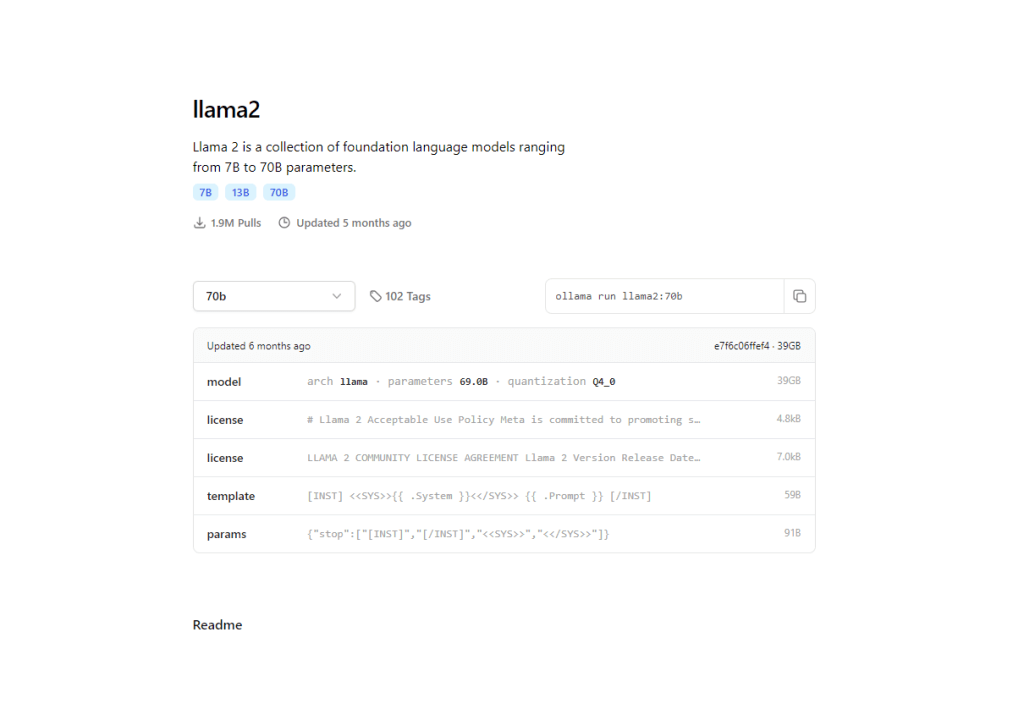

オープンソース LLM パフォーマンス

- LLaMA 2のようなモデルは急速に追いついている

- 特定の分野ではChatGPTを上回る特殊なモデルもある

- タスク固有の最適化のためのカスタマイズの可能性

私の経験では、LLaMA 2 70B などの最近のオープンソース モデルは、特定のタスクでは GPT-3.5 に匹敵するか、それを上回ることもあります。その差は急速に縮まっています。

ここでオープンソース モデルが活躍します。セルフホスティングでは、次のことが可能になります。

- ドメイン固有のデータでトレーニングする

- 特定のタスクに最適化

- ニッチなアプリケーションでは一般的なモデルを上回る性能を発揮する可能性がある

企業は、オープンソース モデルを特定のニーズに合わせて微調整することで、驚くべき成果を達成しています。

さて、パフォーマンスについて考えてみると、

- レイテンシ: セルフホストモデルでは応答時間が短くなる可能性がある

- カスタマイズ: オープンソース モデルをお客様の要件に合わせてカスタマイズします

- 一貫性: ChatGPTはさまざまなタスクにわたって信頼性の高いパフォーマンスを保証します

結論: ChatGPT は、すぐに使用できる状態でトップクラスのパフォーマンスを提供します。ただし、特定の特殊なニーズがある場合は、微調整されたオープンソース モデルの方が、特定のユースケースで優れたパフォーマンスを発揮する可能性があります。

データのプライバシーと管理

今日、プライバシーは単なる贅沢ではなく、必需品です。ChatGPT とセルフホスト型 LLM がこの重要な側面をどのように扱っているかを見てみましょう。

ChatGPTのデータ処理

- OpenAIは厳格なプライバシーポリシーを持っている

- ChatGPTに送信されたデータはモデルの改善に使用される可能性があります

- データ共有をオプトアウトするオプションがありますが、パフォーマンスのトレードオフが発生する可能性があります。

OpenAI はユーザーのプライバシー保護に尽力していますが、機密データを第三者に送信することには常に一定のリスクが伴います。企業が機密情報に ChatGPT を使用することを躊躇しているのを見たことがあります。

セルフホスティングLLMのメリット

- データの完全な制御

- 外部データ漏洩のリスクなし

- カスタムセキュリティ対策を実装する機能

私の経験では、このレベルの制御は、データのプライバシーが最も重要である医療や金融などの業界にとって、大きな変化をもたらします。

私は、厳格なコンプライアンス要件を満たすために特にセルフホスティングを選択した企業と仕事をしてきました。

主なプライバシー要因:

- データの所有権: セルフホスティングでは、データとモデルの完全な所有権を保持します。

- 透明性: オープンソースモデルにより、コードを検査して理解することができます。

- カスタマイズ: 特定のニーズに合わせたプライバシー機能を実装します

結論:データのプライバシーが最優先事項である場合、オープンソースの LLM をセルフホストすることで、比類のない制御が可能になります。ただし、機密性の低いアプリケーションの場合は、ChatGPT の堅牢なプライバシー対策で十分かもしれません。

拡張性と柔軟性

ChatGPT とセルフホスト型 LLM がスケーラビリティと柔軟性の面でどのように評価されるかを見てみましょう。

ChatGPTのスケーラビリティオプション

- 使用量の増加に応じてシームレスに拡張

- インフラストラクチャ管理は不要

- APIにより、さまざまなアプリケーションへの統合が容易になります

カスタマイズの可能性について言えば、ChatGPT は API パラメーターとプロンプト エンジニアリングに限定されています。

バックエンドのロジスティクスを気にすることなく、ChatGPT を使用して AI 機能を急速に拡張する企業を見てきました。驚くほど手間がかかりません。

セルフホスト型LLMの柔軟性

- モデルのサイズと機能を完全に制御

- 複数のマシンにわたって水平に拡張する機能

- 特定のハードウェア構成に合わせて自由に最適化

将来のカスタマイズのために、モデル アーキテクチャに完全にアクセスし、高度なレベルでデータをトレーニングできます。

私のプロジェクトでは、このレベルの制御は、パフォーマンスとコスト効率を微調整するのに非常に役立ちました。

結論: ChatGPT は、簡単に拡張できるという点で優れているため、需要が変動する企業に最適です。ただし、セルフホスティングは、独自のインフラストラクチャを管理したい人にとっては比類のない柔軟性を提供します。

技術的な考慮事項

私は長い間 AI に携わってきたので、技術的な側面が重要であることは間違いありません。知っておくべきことを詳しく説明しましょう。

ChatGPT の場合、最小限のセットアップが必要で、残りの部分は OpenAI がすでに管理しています。

LLM モデルをセルフホストするには、機械学習と自然言語処理を深く理解している必要があります。クラウド インフラストラクチャまたは非プレミス ハードウェア管理に精通していることが望ましいでしょう。さらに、微調整と最適化に関する幅広い知識も必要になります。

多くの人は必要な専門知識を過小評価し、それが失敗につながります。モデルをダウンロードするだけではなく、効果的に展開して維持することも重要です。

主な技術的要因:

- レイテンシ: セルフホストモデルは、適切に最適化すれば応答時間を短縮できる

- カスタマイズ: モデルアーキテクチャとトレーニングデータを完全に制御

- デバッグ: セルフホスト型モデルの問題の診断と修正が容易になります

結論:プラグアンドプレイ ソリューションを求める人にとって、ChatGPT は明らかに勝者です。ただし、技術的な専門知識があり、完全な制御を望む場合は、セルフホスティングによって比類のないカスタマイズと潜在的なパフォーマンス上のメリットが得られます。

ユースケース分析

AI の専門家として、私はさまざまな LLM ソリューションが効果を発揮するさまざまなシナリオを見てきました。実際の使用例をいくつか見て、決定の参考にしましょう。

ChatGPTサブスクリプション

中小企業は、ChatGPT の使いやすさから多くの恩恵を受けています。技術リソースが限られており、迅速な導入が必要なスタートアップ企業が、AI 機能のプロトタイプを迅速に作成し、開発期間を数か月節約しているのを目にしてきました。

コンテンツ作成およびマーケティング チームは、ChatGPT の多様な言語機能を活用して成果を上げています。私が働いていたマーケティング エージェンシーは、キャンペーンのアイデアをブレインストーミングしたり、ソーシャル メディアの投稿を作成したりするために ChatGPT を使用し、生産性を大幅に向上させました。

カスタマー サポートの自動化は、ChatGPT が優れているもう 1 つの分野です。24 時間 365 日対応で、一般的な問い合わせに対応できるため、私がアドバイスした多くの企業にとって頼りになる選択肢となっています。

セルフホスティングLLM

大量のデータを扱う大企業では、セルフホスティングの方が経済的であることがよくあります。私は、eコマース プラットフォームがセルフホスティング モデルに切り替え、1 年で AI コストを 60% 削減するのを支援しました。

規制の厳しい業界は、セルフホスティングが提供する制御の恩恵を受けています。私がアドバイスしたフィンテック企業は、GDPR への準拠を確保し、機密性の高い財務データを保護するためにこの方法を選択しました。

専門分野のアプリケーションでは、多くの場合、カスタム モデルが必要になります。私は、法的文書のオープン ソース モデルを微調整し、契約分析で一般的なモデルを上回るパフォーマンスを実現したリーガル テクノロジーのスタートアップ企業と協力しました。

主な要因には、クエリ量、データの機密性、技術リソース、カスタマイズのニーズが含まれます。データ量が多く機密性が高い場合は、セルフホスティングが正当化されることが多く、リソースが限られている場合は ChatGPT が有利です。

結論

LLM の世界を深く掘り下げてみると、 ChatGPTとセルフホスト モデルの選択は白か黒かという単純なものではないことが分かります。AI 愛好家であり専門家でもある私は、両方のアプローチの実装が成功しているのを見てきました。

ChatGPT は、使いやすさ、一貫したパフォーマンス、定期的なアップデートが特長です。迅速で手間のかからない AI ソリューションを探している企業にとって最適な選択肢です。サブスクリプション モデルは、中程度の使用と一般的なアプリケーションに適しています。

一方、セルフホスティングは、比類のない制御、カスタマイズの可能性、およびデータ プライバシーを提供します。これは、大量のユーザー、特殊なアプリケーション、および厳格なデータ規制のある業界に最適です。最初のセットアップは難しいかもしれませんが、長期的なメリットは大きい可能性があります。

これは永続的な選択ではないことを覚えておいてください。ニーズが進化し、AI の状況が変化すると、いつでも再評価してアプローチを切り替えることができます。

最終的に、ワークフローへの AI 統合の目標、リソース、ビジョンに一致するものが最善の選択です。ChatGPT の利便性を選択するか、セルフホスティングの制御を選択するかにかかわらず、AI を活用した可能性の刺激的な世界に足を踏み入れることになります。