世界がますますデジタル化されるにつれて、高品質のコンテンツに対する需要はかつてないほど高まっています。幸いなことに、自然言語処理 (NLP) の進歩により、Hugging Face が開発したような強力な AI 駆動型ライティング ツールが登場しました。しかし、これらのモデルをオフラインで利用する必要がある場合はどうでしょうか。心配はいりません。インターネット接続なしで Hugging Face モデルを活用する方法を説明します。

Hugging Face の最先端の言語モデルへのオフライン アクセスにより、可能性の世界が広がります。遠隔地で作業している場合、信頼性の低いインターネット接続を使用している場合、または単にデータのプライバシーを優先している場合など、これらのモデルをローカルで実行できると状況が大きく変わります。Hugging Face モデルをオフラインで展開する方法を理解することで、コンテンツ作成プロセスにおける効率、柔軟性、制御を新たなレベルに引き上げることができます。

このブログ記事では、オフラインで Hugging Face モデルのパワーを活用するための実践的な手順について詳しく説明します。モデルの展開から既存のワークフローとのシームレスな統合まで、インターネット接続が利用できない場合でも、これらの高度な NLP ツールの可能性を最大限に引き出す方法を学びます。コンテンツ作成のレベルを高め、進化し続けるデジタル マーケティングとコミュニケーションの世界で常に一歩先を行く準備をしましょう。

Huggingface モデルをオフラインで使用する必要があるのはなぜですか?

AI モデルをオフラインで実行することになぜこだわるのか不思議に思うかもしれません。しかし、信じてください。Hugging Face モデルをオフラインにすべき非常に説得力のある理由がいくつかあります。

素晴らしいウェブサイトを作成します

最高の無料ページビルダーElementor を使用

今すぐ始めるHugging Face モデルをオフラインで使用する理由を簡単に説明します。

Hugging Face モデルをオフラインで使用すると、いくつかの重要な利点があります。

- 信頼性: インターネット接続の問題を心配することなく、中断することなく作業できます。

- 速度: ネットワーク遅延を排除してモデル推論を高速化します。

- プライバシー: 機密データをローカルに保存し、オンライン処理の潜在的なセキュリティ リスクを回避します。

- コスト効率: ハードウェア上でモデルを実行することで、クラウド コンピューティングの費用を削減します。

- ポータビリティ: 遠隔地やインターネットアクセスが制限されているエリアでも高度な AI 機能を使用できます。

- 学習: モデルのアーキテクチャと機能を直接操作することで、より深く理解できます。

- カスタマイズ: ローカル アクセス権がある場合、特定のユース ケースに合わせてモデルをより簡単に微調整および適応できます。

いつでもどこでも、Hugging Face モデルの潜在能力を最大限に活用する方法を詳しく見ていきましょう。

Huggingface モデルをオフラインで使用するには?

Huggingface はオープンソース AI の Github やアプリストアのようなものです。この Web サイトから多数のオープンソース LLM を参照、ダウンロード、さらには使用することもできます。さらに、ChatGPT と同様に、Hugging Chat もあります。このチャットボットでは、使用したいモデルを選択でき、他のマルチモデル AI アシスタントと同じように、これを使用して会話を行うことができます。

これらのモデルを完全に無料で、オフラインで毎日使用できたら素晴らしいと思いませんか? ぜひやってみてください。

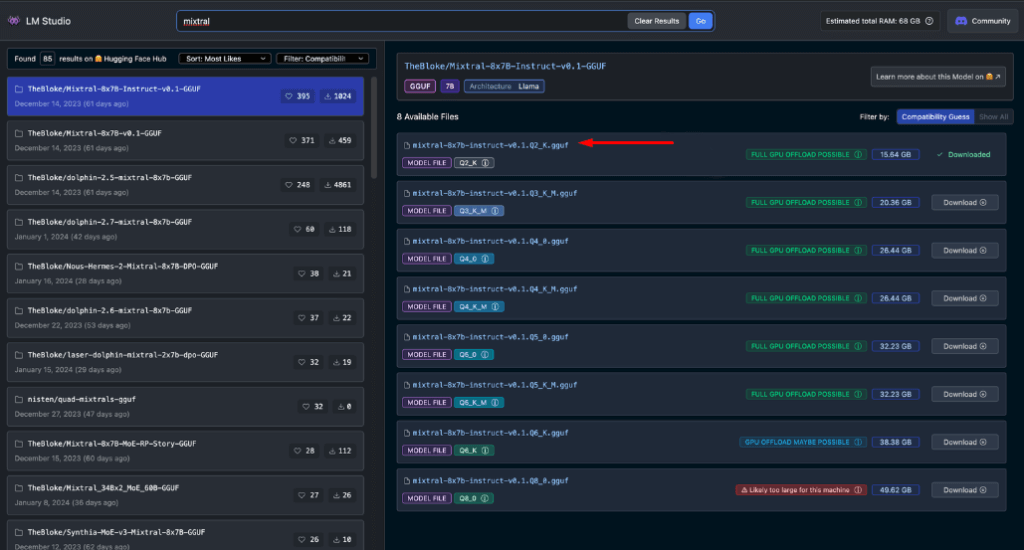

LMスタジオ

LM Studio は、 AI モデルをローカルで使用する方法に革命をもたらします。Windows、Mac (Apple Silicon)、Linux (ベータ版) で利用できるこの多機能アプリにより、ユーザーは Hugging Face モデルを簡単にダウンロードしてオフラインで実行できるようになります。

LM Studio の主な機能は次のとおりです。

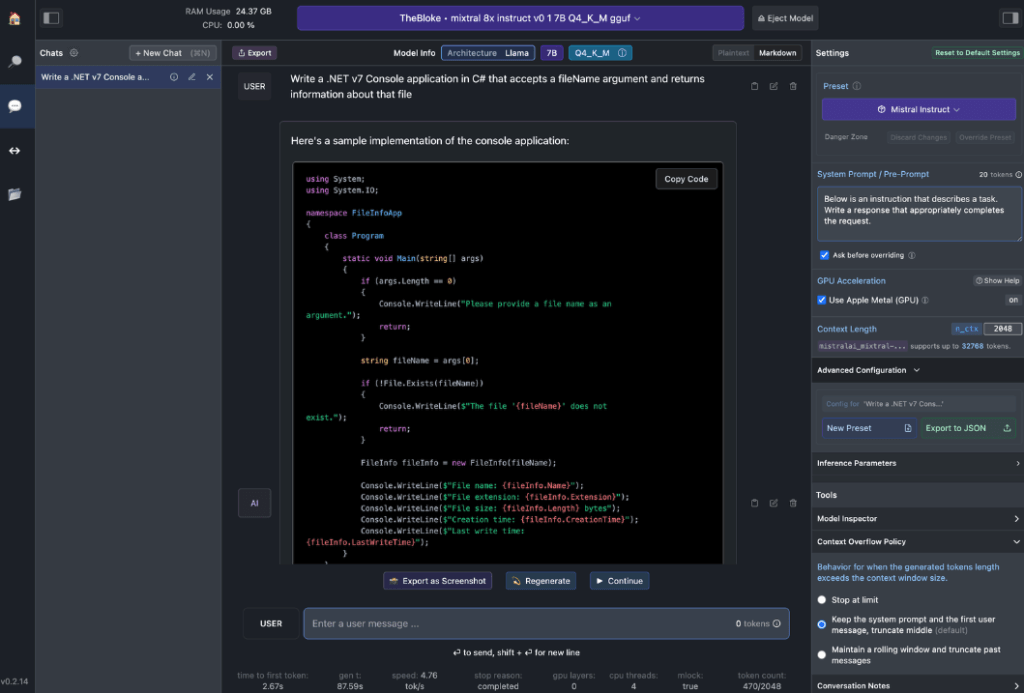

- ローカル モデル インタラクション: 好みの言語モデル (LLM) をダウンロードし、チャットベースの AI アシスタントと同じように操作します。パフォーマンスや出力形式をカスタマイズし、さまざまな組み込みシステム プロンプトやオプションを使用して実験的な機能を探索します。

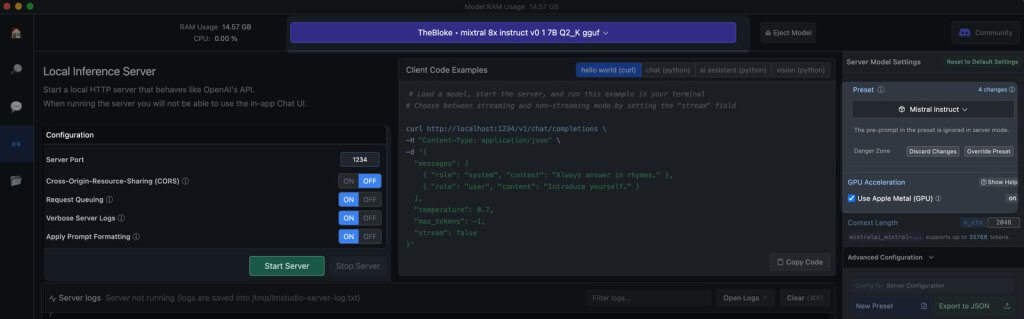

- OpenAI API エミュレーション: これは LM Studio が真価を発揮するところです。ダウンロードした Hugging Face モデルを読み込むと、LM Studio は巧妙にその周りにローカル API プロキシをラップし、OpenAI API を模倣します。この互換性は画期的なものであり、すでに OpenAI をサポートしている多数の SDK や人気のエディターおよび IDE 拡張機能とのシームレスな統合が可能になります。

ワークステーションのハードウェア要件

オフラインの Hugging Face モデルの潜在能力を真に引き出すには、堅牢なハードウェアが必要です。最新のコンピューターであれば基本的なタスクは処理できますが、最適なパフォーマンスを得るには、より強力な仕様が必要です。

Appleユーザーの場合:

- M2/M3 MaxまたはUltraプロセッサ

- ハイエンド構成

- 50 GB 以上の RAM (M2 SoC 上の GPU と共有)

- パフォーマンスを向上させる金属サポート

Windows ユーザーの場合:

- より多くのコアCPU

- 大容量のRAM

- 十分なVRAMを備えたRTX 30または40シリーズGPU

最高級のシステムがない場合でも心配はいりません。最新モデルの中にも、RAM と VRAM に適したオプションが多数あります。LM Studio は、モデルを参照してダウンロードするときに、システムの能力を便利に推定します。

一般的に、モデル ファイルが大きく、リソース要件が高いほど、出力品質が向上します。システムを絶対的な限界まで押し上げないことが最善ですが、ハードウェアの能力の範囲内で高い目標を設定することを恐れないでください。

覚えておいてください: 目標は、モデルのパフォーマンスとシステムのリソースのバランスを取り、オフラインでの Hugging Face エクスペリエンスを最適にすることです。

オフライン使用に推奨されるモデル

Hugging Face モデルをオフラインで実行する場合、適切なモデルを選択することが重要です。広範囲にわたるテストを通じて、一般的なチャットとコーディング タスクの両方で一貫して優れた結果をもたらすモデルとして次のモデルが見つかりました。

これらの各モデルは、パフォーマンスとリソース使用量の独自のバランスを提供するため、オフライン展開に最適です。

さらに進む前に、これらのモデルを自分で評価することが重要です。

- LM Studioで各モデルをダウンロードする

- AIチャットタブを使用してモデルと対話します

- さまざまなタスク、特にコーディングに重点を置いている場合は、そのパフォーマンスをテストします。

- 出力の品質とそれがニーズにどれだけ合致しているかを評価する

実際の体験は、特定のユースケースやハードウェアの機能によって異なる場合があることに注意してください。時間をかけて、要件に最適なモデルを見つけてください。この慎重な選択プロセスにより、統合やより高度な使用方法に進む前に、ニーズに合った最も効果的なオフライン Hugging Face モデルを確実に入手できます。

ローカルサーバーをLM Studioに

オフラインの Hugging Face モデル サーバーの起動は非常に簡単です。

- LMスタジオを開く

- ダウンロードしたモデルから1つを選択してください

- 「サーバーを起動」ボタンをクリックします

これで完了です。デフォルト設定は、一般的にほとんどのユーザーに適しています。ただし、エクスペリエンスを微調整したい場合は、特定のニーズや好みに合わせてオプションを自由に調整してください。

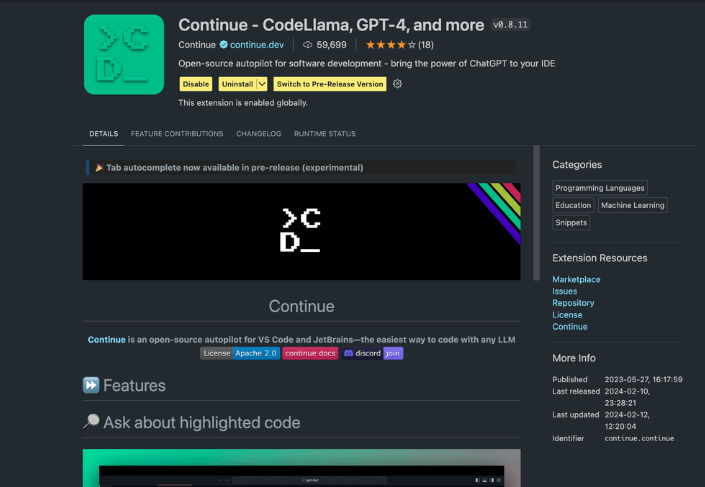

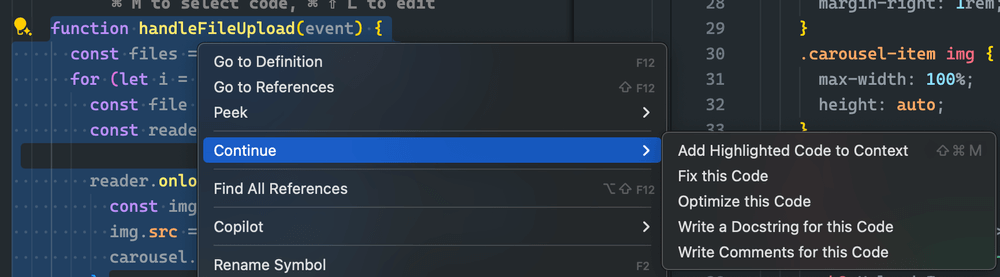

Continue拡張機能の使用

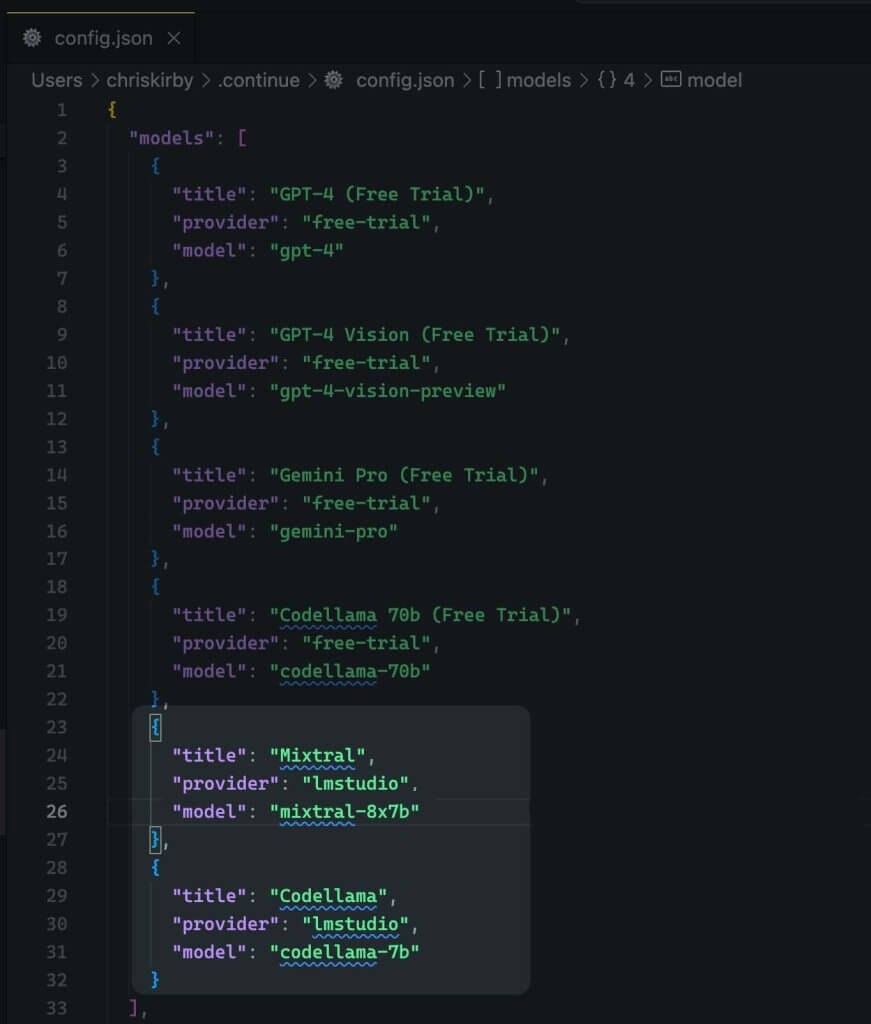

起動した VS コード スタジオから、拡張機能ビューに移動します。検索バーに「続行」と入力します。適切な拡張機能を見つけてインストールします。

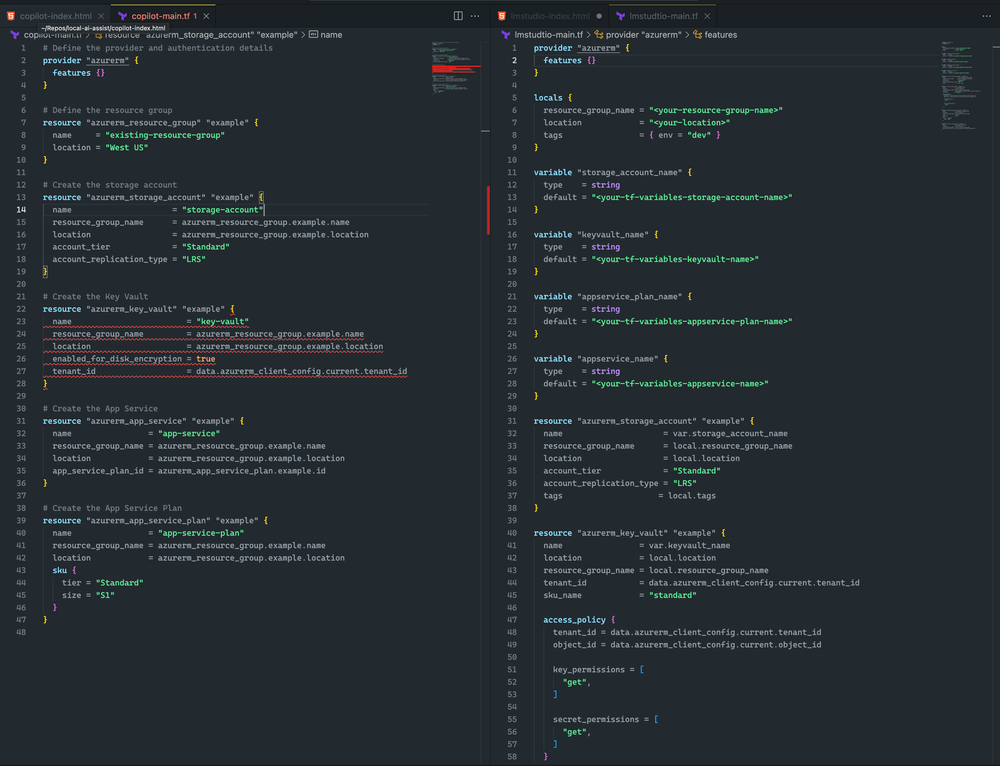

ここで、拡張機能の構成 JSON を変更する必要があります。これにより、LM Studio サポートが追加されます。

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

さあ、保存しましょう。

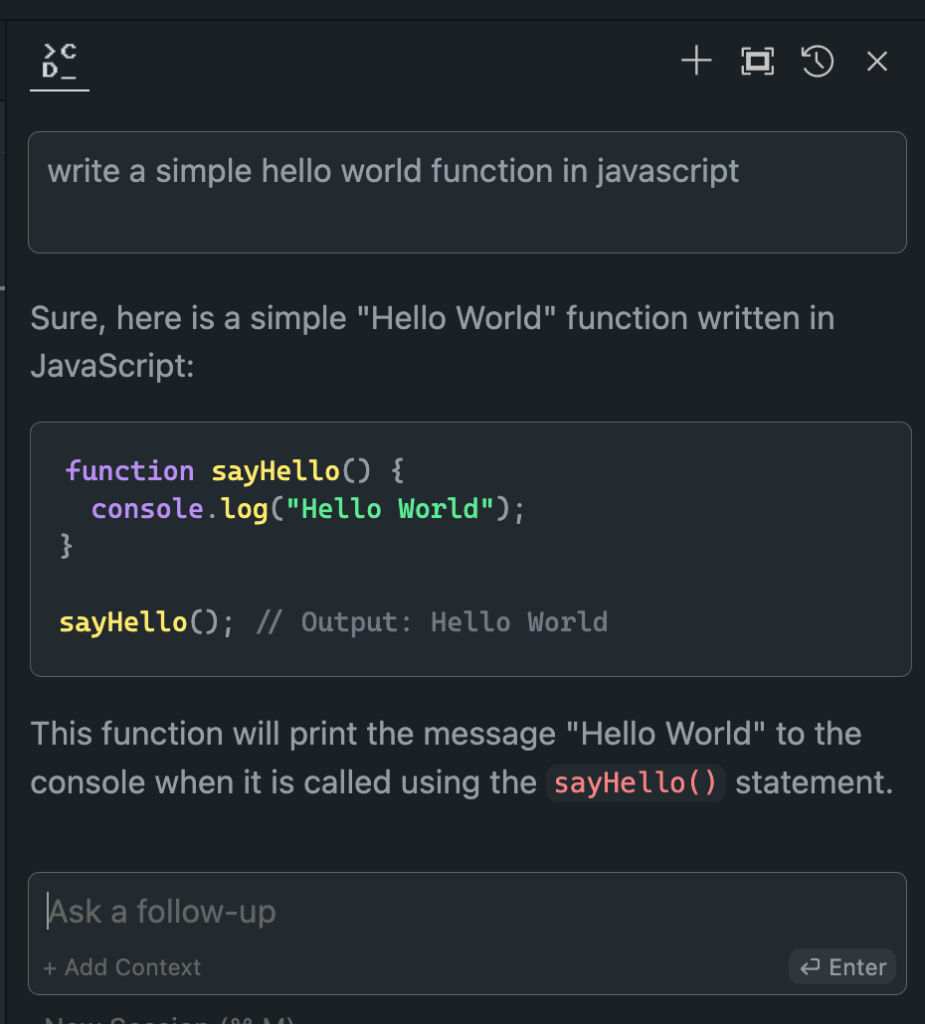

次に、VS コードの代わりにこのローカル モデルを使用する必要があります。

オフラインとオンラインのモデルパフォーマンスの評価

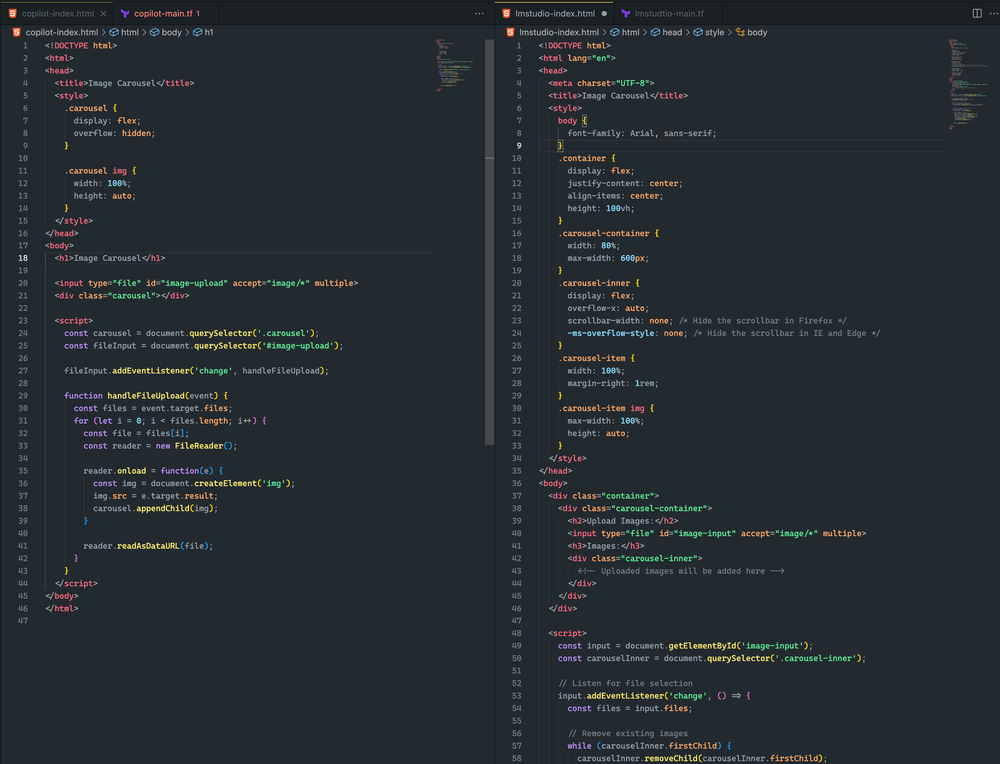

オフラインの Hugging Face モデルをセットアップしたので、いよいよ決定的な瞬間です。オンラインのモデルと比較してテストしてみましょう。

私の広範囲にわたる試験の結果は目を見張るものでした。

- パフォーマンス: オフライン モデルはオンライン モデルと同等であることが多く、場合によってはオンライン モデルを上回ります。

- 速度: ネットワーク遅延がないため、応答が非常に速くなります。

- 一貫性: サーバーの負荷や接続の問題による変動がなくなります。

選択したモデルとハードウェアによってエクスペリエンスは異なりますが、オフライン バージョンの方が好みになったとしても驚かないでください。ローカル処理能力と微調整されたモデルの組み合わせにより、素晴らしい結果が得られます。

ここで違いを確認してください。

どちらのアプローチもかなり近いものでした。どちらも画像カルーセルにはならなかったものの、画像をアップロードすることに成功し、両方の例でレンダリングされました。さらに迅速に調整すれば、さらに良い結果が得られると思います。

私は LM Studio と Mixtral の方が好きです。Terraform の方が完全で構文エラーがないからです。ただし、CoPilot には小さな問題があります。キー コンテナーの宣言にsku_nameがありませんが、これは簡単に修正できます。

まとめ

AI 分野は急速に進化していることを忘れないでください。Hugging Face モデルのオフライン展開をマスターすることで、単に時代の流れに遅れずについていくだけでなく、常に先を行くことができます。開発者、研究者、AI 愛好家のいずれであっても、このスキルにより、ローカル AI 処理の可能性の限界を押し広げることができます。

ぜひ、思い切って挑戦してみてください。さまざまなモデルを試し、セットアップを微調整し、これらのオフラインの強力なツールをワークフローに統合してください。AI 開発の未来があなたのローカル マシン上に存在し、解き放たれるのを待っていることに気づくかもしれません。