Mentre il mondo diventa sempre più digitale, la domanda di contenuti di alta qualità non è mai stata così alta. Fortunatamente, i progressi nell'elaborazione del linguaggio naturale (NLP) hanno dato origine a potenti strumenti di scrittura basati sull'intelligenza artificiale, come quelli sviluppati da Hugging Face. Ma cosa succede se hai bisogno di utilizzare questi modelli offline? Niente paura, perché esploreremo come sfruttare i modelli di Hugging Face senza una connessione Internet.

L'accesso offline ai modelli linguistici all'avanguardia di Hugging Face apre un mondo di possibilità. Che tu stia lavorando in luoghi remoti, affrontando una connettività Internet inaffidabile o semplicemente dando priorità alla privacy dei dati, la possibilità di eseguire questi modelli localmente può cambiare le carte in tavola. Comprendendo come distribuire i modelli Hugging Face offline, puoi sbloccare nuovi livelli di efficienza, flessibilità e controllo nel tuo processo di creazione di contenuti.

In questo post del blog, ci immergeremo nei passaggi pratici che puoi adottare per sfruttare la potenza dei modelli Hugging Face offline. Dall'implementazione del modello all'integrazione fluida con i tuoi flussi di lavoro esistenti, imparerai come massimizzare il potenziale di questi strumenti NLP avanzati, anche quando una connessione Internet non è prontamente disponibile. Preparati a migliorare il tuo gioco di creazione di contenuti e a rimanere all'avanguardia nel mondo in continua evoluzione del marketing e della comunicazione digitale.

Perché potresti voler utilizzare il modello Huggingface offline?

Potresti chiederti perché qualcuno si preoccuperebbe di eseguire modelli AI offline. Ma fidati, ci sono delle ragioni davvero convincenti per togliere i tuoi modelli Hugging Face dalla rete.

Create Amazing Websites

Con il miglior generatore di pagine gratuito Elementor

Parti oraEcco una spiegazione concisa del motivo per cui qualcuno potrebbe voler utilizzare i modelli Hugging Face offline:

L'utilizzo offline dei modelli Hugging Face offre diversi vantaggi chiave:

- Affidabilità: lavora senza interruzioni, senza preoccuparti di problemi di connettività Internet.

- Velocità: elimina la latenza di rete per un'inferenza più rapida del modello.

- Privacy: mantenere i dati sensibili in locale, evitando potenziali rischi per la sicurezza derivanti dall'elaborazione online.

- Efficienza dei costi: riduci le spese del cloud computing eseguendo i modelli sul tuo hardware.

- Portabilità: utilizzare funzionalità di intelligenza artificiale avanzate in luoghi remoti o aree con accesso a Internet limitato.

- Apprendimento: acquisire una comprensione più approfondita dell'architettura e del funzionamento dei modelli lavorando direttamente con essi.

- Personalizzazione: è più facile perfezionare e adattare i modelli per casi d'uso specifici quando si ha accesso locale.

Scopriamo insieme come sfruttare appieno il potenziale dei modelli Hugging Face, sempre e ovunque.

Come utilizzare i modelli di Huggingface offline?

Huggingface è come un Github o un app store per l'intelligenza artificiale open source. Qui puoi navigare, scaricare e persino usare numerosi LLM open source da questo sito web. Inoltre, proprio come ChatGPT, hanno Hugging Chat. Questo chatbot ti consente di scegliere un modello che vuoi usare e in seguito puoi conversare con questo come faresti con qualsiasi altro assistente AI multi-modello.

Quanto sarebbe fantastico usare questi modelli completamente gratis, offline ogni giorno? Facciamolo.

Studio LM

LM Studio sta rivoluzionando il modo in cui utilizziamo i modelli AI a livello locale. Questa versatile app, disponibile per Windows, Mac (Apple Silicon) e Linux (beta), consente agli utenti di scaricare ed eseguire modelli Hugging Face offline con facilità.

Le caratteristiche principali di LM Studio includono:

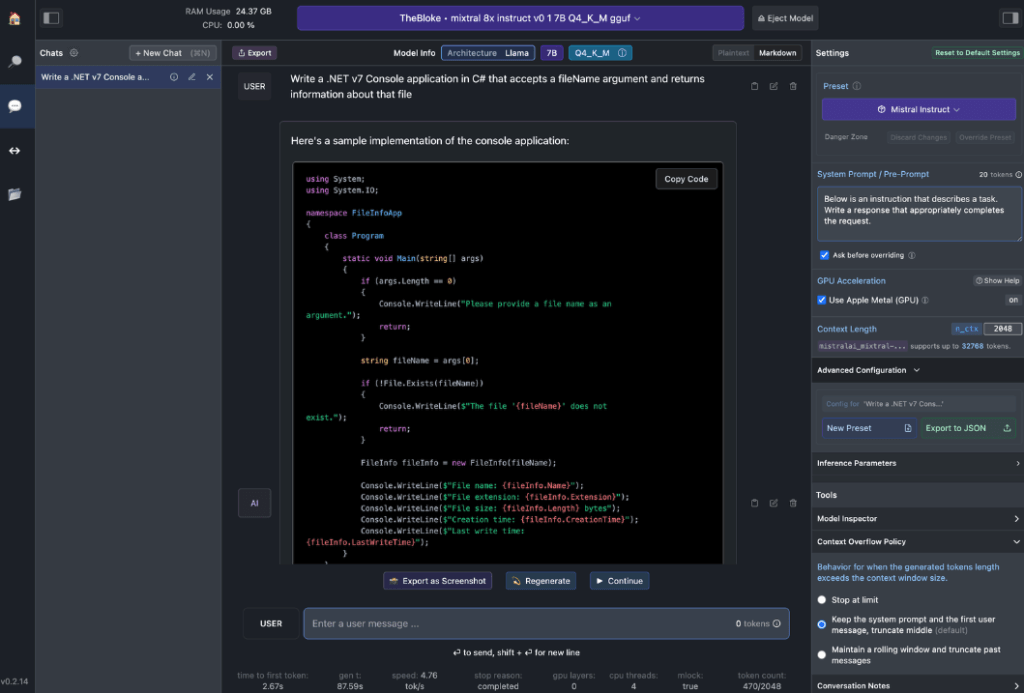

- Interazione con il modello locale: scarica il tuo Language Model (LLM) preferito e interagisci con esso come faresti con qualsiasi assistente AI basato su chat. Personalizza le prestazioni e il formato di output ed esplora le funzionalità sperimentali tramite vari prompt e opzioni di sistema integrati.

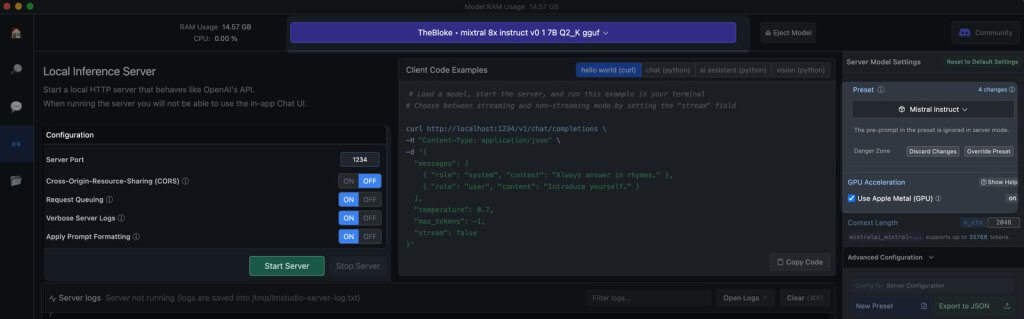

- Emulazione API OpenAI: è qui che LM Studio brilla davvero. Carica il modello Hugging Face scaricato e LM Studio avvolge ingegnosamente un proxy API locale attorno ad esso, imitando l'API OpenAI. Questa compatibilità è un punto di svolta, in quanto consente un'integrazione senza soluzione di continuità con numerosi SDK e le estensioni Editor e IDE più diffuse che supportano già OpenAI.

Requisiti hardware della workstation

Per sbloccare davvero il potenziale dei modelli Hugging Face offline, avrai bisogno di hardware robusto. Mentre qualsiasi computer moderno può gestire attività di base, le prestazioni ottimali richiedono specifiche più potenti:

Per gli utenti Apple:

- Processori M2/M3 Max o Ultra

- Configurazioni di fascia alta

- Oltre 50 GB di RAM (condivisa con GPU su M2 SoC)

- Supporto in metallo per prestazioni migliorate

Per gli utenti Windows:

- Più core CPU

- RAM sostanziale

- GPU RTX serie 30 o 40 con ampia VRAM

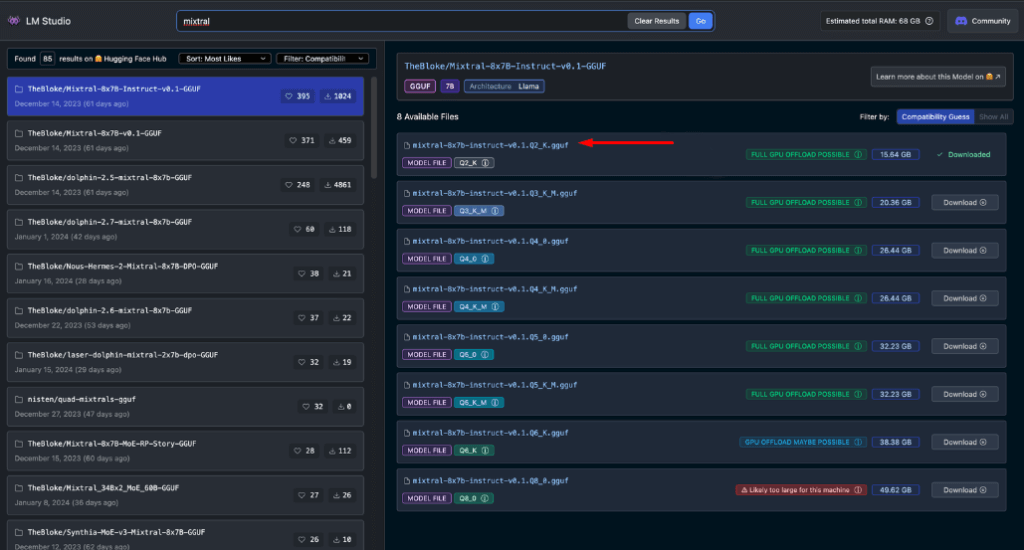

Non preoccuparti se non hai un sistema di fascia alta. Esistono molte opzioni RAM e VRAM-friendly, anche tra i modelli più recenti. LM Studio stima in modo utile le capacità del tuo sistema mentre navighi e scarichi modelli.

In genere, file di modello più grandi e requisiti di risorse più elevati sono correlati a una migliore qualità di output. Sebbene sia meglio non spingere il sistema ai suoi limiti assoluti, non aver paura di puntare in alto entro le capacità del tuo hardware.

Ricorda: l'obiettivo è bilanciare le prestazioni del modello con le risorse del tuo sistema per ottenere la migliore esperienza offline con Hugging Face.

Modelli consigliati per l'uso offline

Quando si eseguono modelli Hugging Face offline, è fondamentale scegliere il modello giusto. Attraverso test approfonditi, ho scoperto che i seguenti modelli forniscono risultati costantemente impressionanti sia per le chat generali che per le attività di codifica:

Ognuno di questi modelli offre un equilibrio unico tra prestazioni e utilizzo delle risorse, rendendoli una scelta eccellente per l'implementazione offline.

Prima di procedere oltre, è essenziale valutare personalmente questi modelli:

- Scarica ogni modello in LM Studio

- Utilizzare la scheda chat AI per interagire con il modello

- Testa le sue prestazioni su vari compiti, in particolare la codifica se è questo il tuo obiettivo

- Valuta la qualità degli output e quanto sono in linea con le tue esigenze

Ricorda che la tua esperienza potrebbe variare in base al tuo caso d'uso specifico e alle capacità hardware. Prenditi il tempo necessario per trovare il modello più adatto alle tue esigenze. Questo attento processo di selezione ti garantirà di avere il modello Hugging Face offline più efficace per le tue esigenze prima di passare all'integrazione e all'utilizzo più avanzato.

Server locale in LM Studio

Avviare il tuo server modello Hugging Face offline è molto semplice:

- Apri LM Studio

- Seleziona uno dei modelli scaricati

- Fare clic sul pulsante Avvia server

Ecco fatto! Le impostazioni predefinite sono generalmente adatte alla maggior parte degli utenti. Tuttavia, se stai cercando di perfezionare la tua esperienza, sentiti libero di adattare le opzioni in base alle tue esigenze o preferenze specifiche.

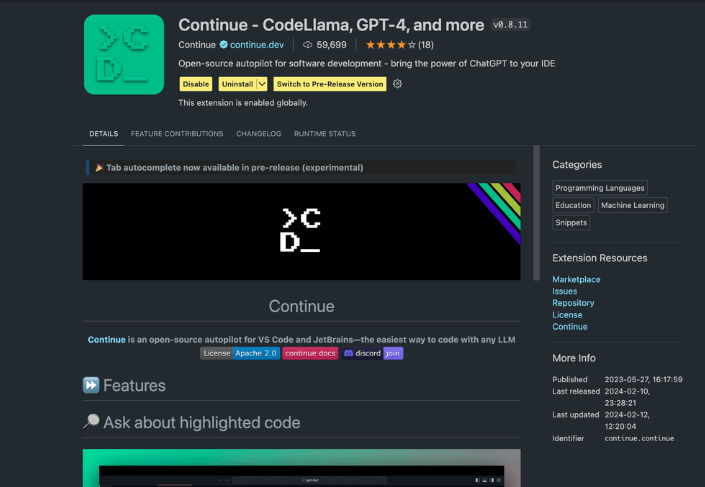

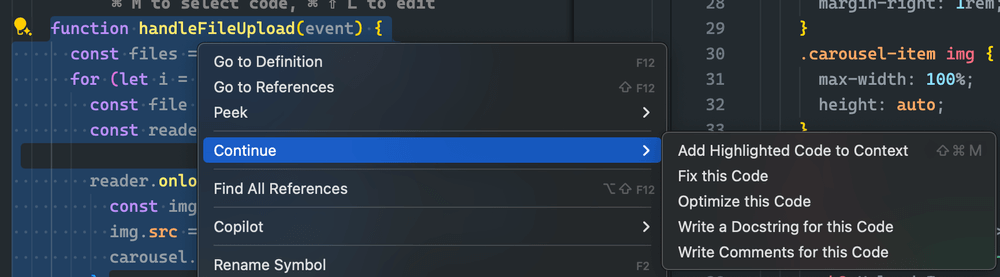

Utilizzo dell'estensione Continua

Dallo studio VS code avviato, vai alla vista estensioni. Nella barra di ricerca, digita "Continua". Trova l'estensione corretta e installala.

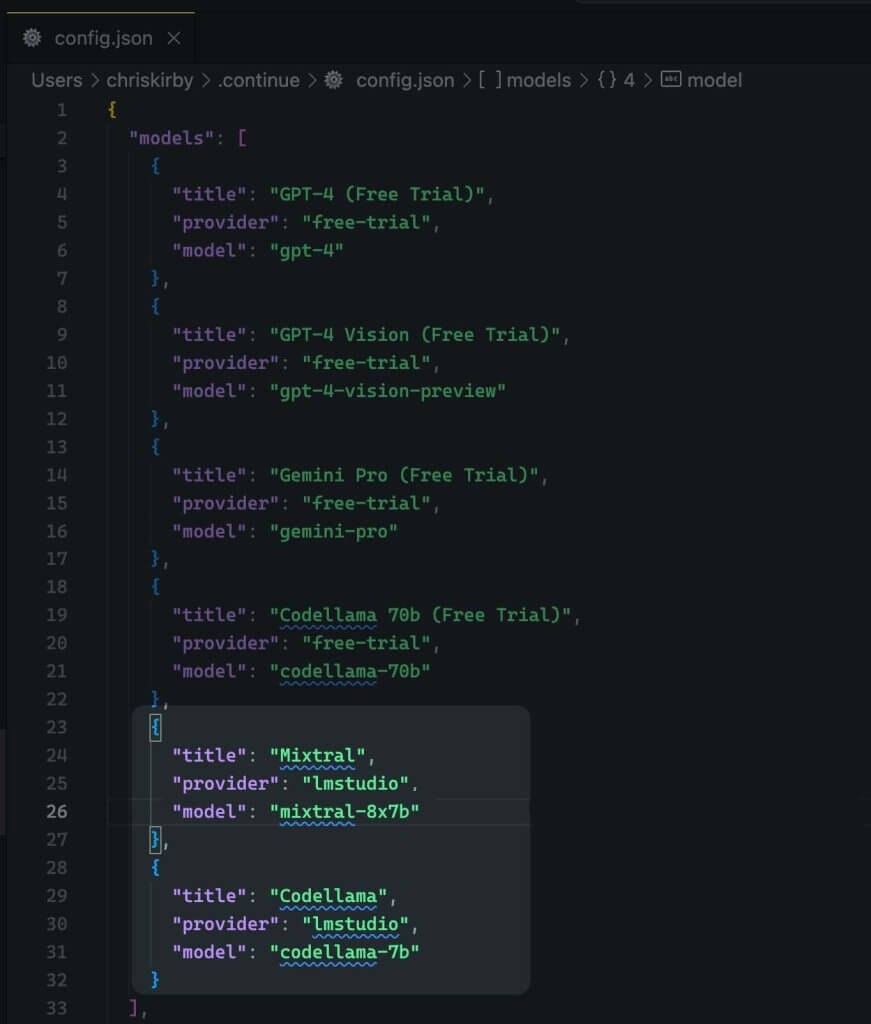

Ora dobbiamo modificare la configurazione JSON dell'estensione. Aggiungerà il supporto LM Studio.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Ora salvalo.

Successivamente, è necessario utilizzare questo modello locale al posto del codice VS.

Valutazione delle prestazioni del modello offline rispetto a quello online

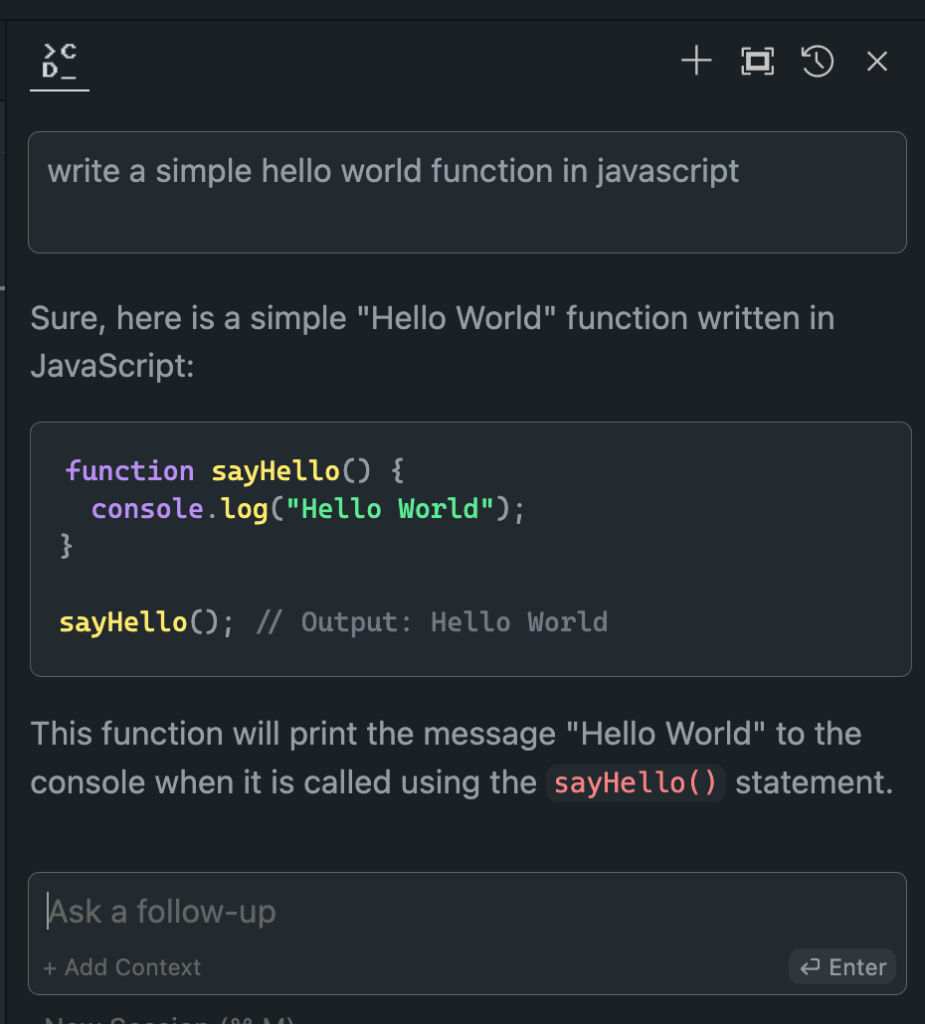

Ora che abbiamo impostato il nostro modello Hugging Face offline, è il momento della verità. Mettiamolo alla prova con le sue controparti online!

Nei miei ampi studi, i risultati sono stati illuminanti:

- Prestazioni: il modello offline spesso eguaglia e, in alcuni casi, addirittura supera i suoi equivalenti online.

- Velocità: senza latenza di rete, le risposte possono essere rapidissime.

- Coerenza: niente più variabilità dovuta al carico del server o a problemi di connessione.

Sebbene la tua esperienza possa variare a seconda del modello e dell'hardware scelti, non sorprenderti se ti ritrovi a preferire la versione offline. La combinazione di potenza di elaborazione locale e modelli ottimizzati può offrire risultati impressionanti.

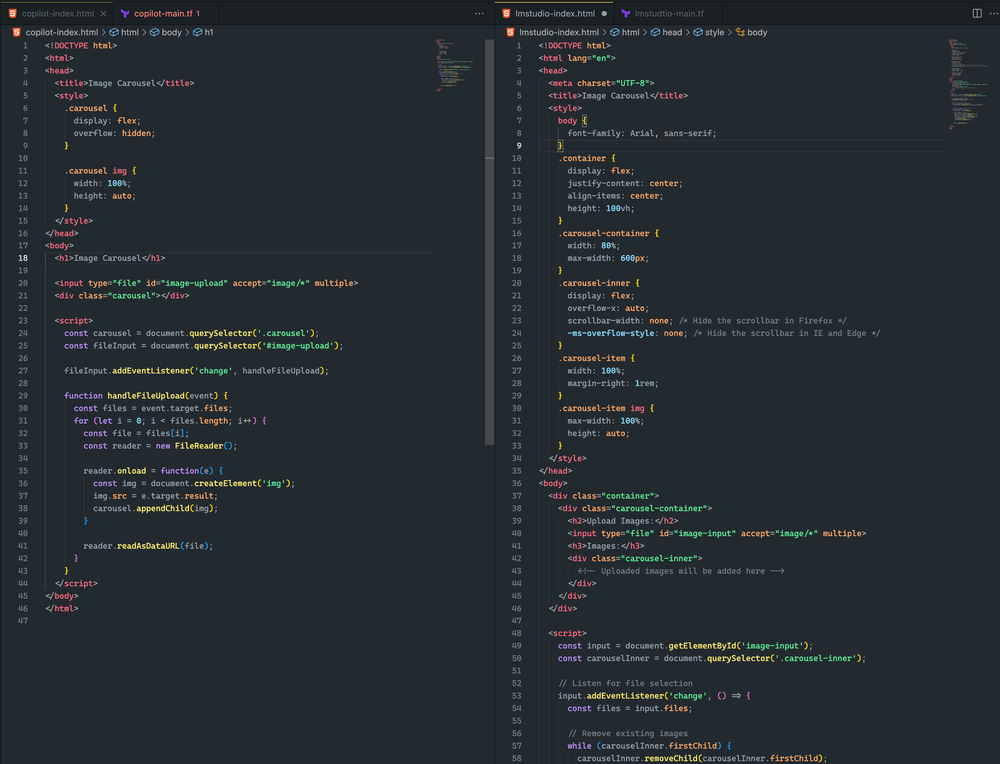

Ecco la differenza.

Entrambi gli approcci erano piuttosto simili. Sebbene nessuno dei due abbia prodotto un carosello di immagini, ho caricato con successo un'immagine, che è stata renderizzata in entrambi gli esempi. Con ulteriori tempestive modifiche, credo di poter ottenere un risultato ancora migliore

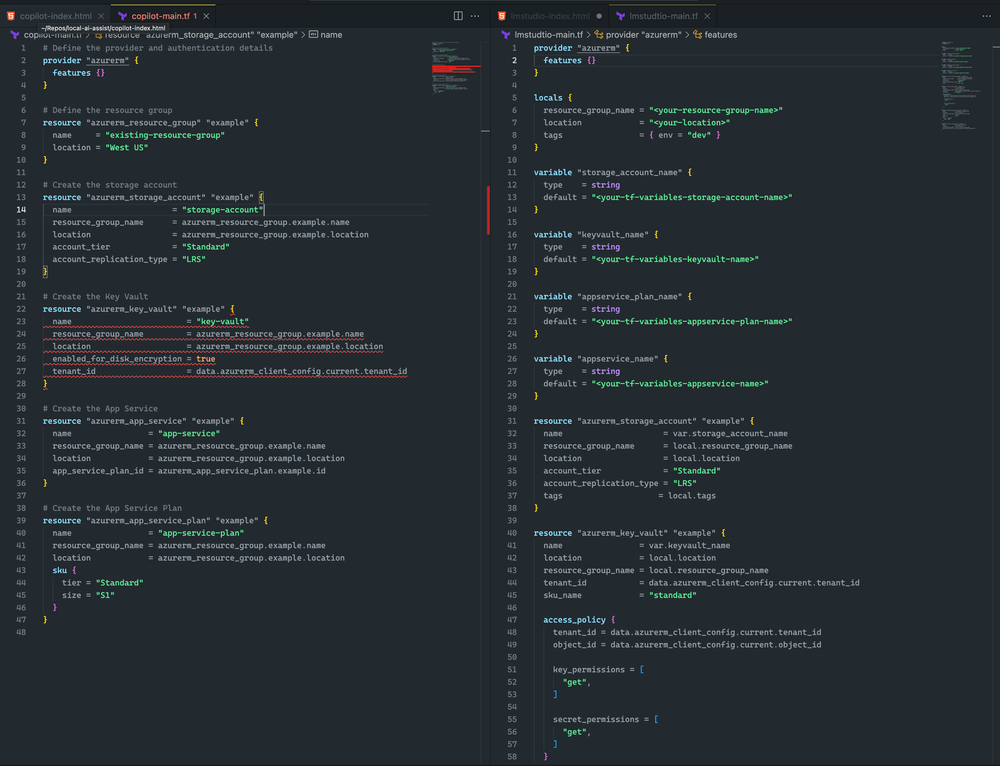

Propendo per LM Studio e Mixtral perché Terraform è più completo e non ha errori di sintassi. Tuttavia, CoPilot ha un piccolo problema: la dichiarazione del key vault non ha sku_name , che può essere facilmente risolto.

Conclusione

Ricorda, il campo dell'IA si sta evolvendo rapidamente. Padroneggiando l'implementazione offline dei modelli Hugging Face, non solo stai al passo, ma stai anche anticipando i tempi. Che tu sia uno sviluppatore, un ricercatore o un appassionato di IA, questa competenza ti consente di superare i limiti di ciò che è possibile con l'elaborazione locale dell'IA.

Quindi, tuffati. Sperimenta modelli diversi, perfeziona la tua configurazione e integra queste centrali elettriche offline nel tuo flusso di lavoro. Potresti scoprire che il futuro dello sviluppo dell'IA è proprio lì, sulla tua macchina locale, in attesa di essere scatenato.