Seiring dengan semakin digitalnya dunia, permintaan akan konten berkualitas tinggi tidak pernah sebesar ini. Untungnya, kemajuan dalam pemrosesan bahasa alami (NLP) telah menghasilkan alat tulis canggih berbasis AI, seperti yang dikembangkan oleh Hugging Face. Namun, bagaimana jika Anda perlu memanfaatkan model ini secara offline? Jangan khawatir, karena kami akan membahas cara memanfaatkan model Hugging Face tanpa koneksi internet.

Akses offline ke model bahasa mutakhir Hugging Face membuka dunia kemungkinan. Baik Anda bekerja di lokasi terpencil, berhadapan dengan konektivitas internet yang tidak dapat diandalkan, atau sekadar memprioritaskan privasi data, kemampuan untuk menjalankan model ini secara lokal dapat menjadi pengubah permainan. Dengan memahami cara menggunakan model Hugging Face secara offline, Anda dapat membuka tingkat efisiensi, fleksibilitas, dan kontrol baru dalam proses pembuatan konten Anda.

Dalam posting blog ini, kita akan membahas langkah-langkah praktis yang dapat Anda ambil untuk memanfaatkan kekuatan model Hugging Face secara offline. Dari penerapan model hingga integrasi yang lancar dengan alur kerja Anda yang sudah ada, Anda akan mempelajari cara memaksimalkan potensi alat NLP canggih ini, bahkan saat koneksi internet tidak tersedia. Bersiaplah untuk meningkatkan kemampuan pembuatan konten Anda dan tetap menjadi yang terdepan dalam dunia pemasaran dan komunikasi digital yang terus berkembang.

Mengapa Anda Mungkin Ingin Menggunakan Model Huggingface Secara Offline?

Anda mungkin bertanya-tanya mengapa ada orang yang mau repot-repot menjalankan model AI secara offline. Namun percayalah, ada beberapa alasan yang sangat kuat untuk menghapus model Hugging Face Anda.

Buat Situs Web Luar Biasa

Dengan Elementor pembuat halaman gratis terbaik

Mulai sekarangBerikut penjelasan singkat mengapa seseorang mungkin ingin menggunakan model Hugging Face secara offline:

Menggunakan model Hugging Face secara offline menawarkan beberapa keuntungan utama:

- Keandalan: Bekerja tanpa gangguan tanpa khawatir tentang masalah konektivitas internet.

- Kecepatan: Hilangkan latensi jaringan untuk inferensi model yang lebih cepat.

- Privasi: Simpan data sensitif secara lokal, hindari potensi risiko keamanan dalam pemrosesan daring.

- Efisiensi biaya: Kurangi biaya komputasi awan dengan menjalankan model pada perangkat keras Anda.

- Portabilitas: Gunakan kemampuan AI canggih di lokasi terpencil atau area dengan akses internet terbatas.

- Pembelajaran: Dapatkan pemahaman yang lebih mendalam tentang arsitektur dan fungsi model dengan bekerja dengannya secara langsung.

- Kustomisasi: Lebih mudah menyempurnakan dan mengadaptasi model untuk kasus penggunaan tertentu saat Anda memiliki akses lokal.

Mari selami dan jelajahi cara memanfaatkan potensi penuh model Hugging Face, kapan saja dan di mana saja.

Bagaimana Cara Menggunakan Model Huggingface Secara Offline?

Huggingface seperti Github atau toko aplikasi untuk AI sumber terbuka. Di sini, Anda dapat menelusuri, mengunduh, dan bahkan menggunakan banyak LLM sumber terbuka dari situs web ini. Selain itu, seperti halnya ChatGPT, mereka memiliki Hugging Chat. Chatbot ini memungkinkan Anda memilih model yang ingin digunakan dan kemudian Anda dapat melakukan percakapan dengannya seperti yang Anda lakukan dengan asisten AI multimodel lainnya.

Betapa hebatnya jika kita dapat menggunakan model-model ini secara gratis, offline setiap hari? Mari kita lakukan ini.

Studio LM

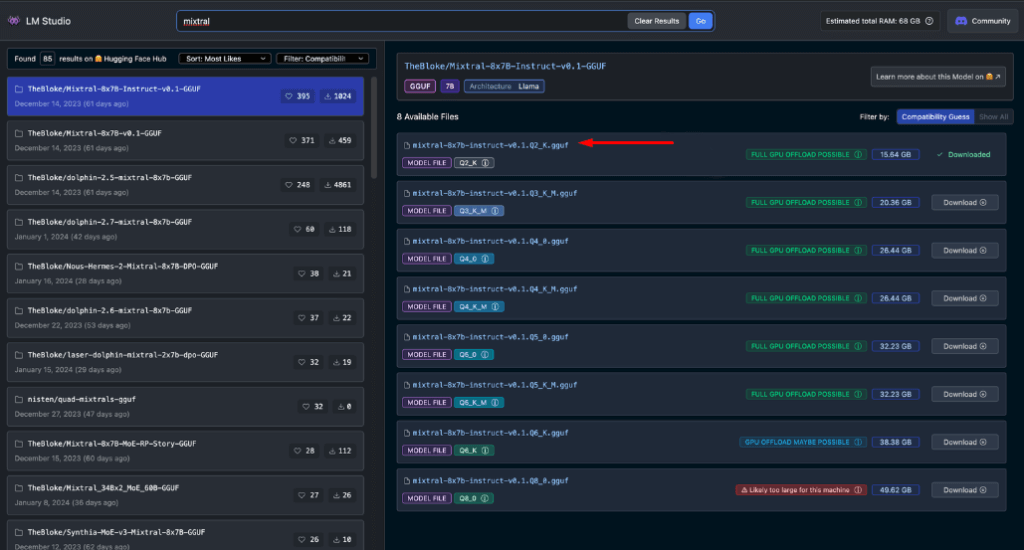

LM Studio merevolusi cara kita menggunakan model AI secara lokal. Aplikasi serbaguna ini, tersedia untuk Windows, Mac (Apple Silicon), dan Linux (beta), memungkinkan pengguna mengunduh dan menjalankan model Hugging Face secara offline dengan mudah.

Fitur utama LM Studio meliputi:

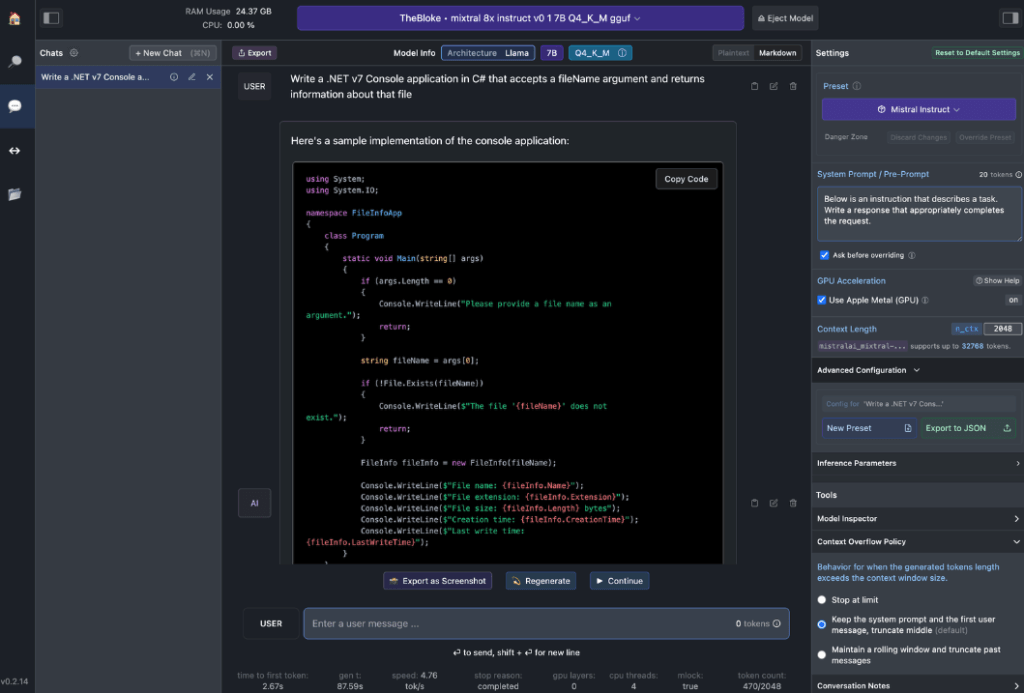

- Interaksi Model Lokal: Unduh Model Bahasa (LLM) pilihan Anda dan berinteraksilah dengannya seperti Anda berinteraksi dengan asisten AI berbasis obrolan lainnya. Sesuaikan kinerja dan format keluaran, serta jelajahi fitur eksperimental melalui berbagai perintah dan opsi sistem bawaan.

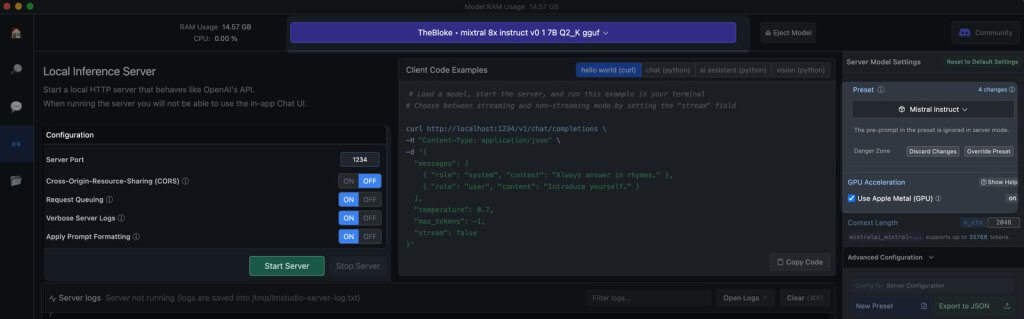

- Emulasi API OpenAI: Di sinilah LM Studio benar-benar bersinar. Muat model Hugging Face yang Anda unduh, dan LM Studio dengan cerdik membungkus proksi API lokal di sekitarnya, meniru API OpenAI. Kompatibilitas ini mengubah permainan, karena memungkinkan integrasi yang lancar dengan berbagai SDK dan ekstensi Editor & IDE populer yang sudah mendukung OpenAI.

Persyaratan Perangkat Keras Stasiun Kerja

Untuk benar-benar membuka potensi model Hugging Face offline, Anda memerlukan beberapa perangkat keras yang tangguh. Meskipun komputer modern mana pun dapat menangani tugas-tugas dasar, kinerja optimal memerlukan spesifikasi yang lebih canggih:

Untuk pengguna Apple:

- Prosesor M2/M3 Max atau Ultra

- Konfigurasi kelas atas

- RAM 50+ GB (dibagi dengan GPU pada SoC M2)

- Dukungan logam untuk kinerja yang ditingkatkan

Untuk pengguna Windows:

- CPU inti lebih banyak

- RAM besar

- GPU seri RTX 30 atau 40 dengan VRAM yang cukup

Jangan khawatir jika Anda tidak memiliki sistem terbaik. Tersedia banyak pilihan yang sesuai dengan RAM dan VRAM, bahkan di antara model-model terbaru. LM Studio akan membantu memperkirakan kemampuan sistem Anda saat Anda menelusuri dan mengunduh model.

Umumnya, file model yang lebih besar dan kebutuhan sumber daya yang lebih tinggi berkorelasi dengan kualitas output yang lebih baik. Meskipun sebaiknya jangan memaksakan sistem Anda hingga batas maksimal, jangan takut untuk membidik target yang lebih tinggi dalam kemampuan perangkat keras Anda.

Ingat: Tujuannya adalah menyeimbangkan kinerja model dengan sumber daya sistem Anda untuk pengalaman Pelukan Wajah offline terbaik.

Model yang Direkomendasikan untuk Penggunaan Offline

Saat menjalankan model Hugging Face secara offline, memilih model yang tepat sangatlah penting. Melalui pengujian yang ekstensif, saya menemukan model berikut memberikan hasil yang mengesankan secara konsisten untuk tugas obrolan umum dan pengodean:

Masing-masing model ini menawarkan keseimbangan unik antara performa dan penggunaan sumber daya, menjadikannya pilihan yang sangat baik untuk penerapan offline.

Sebelum melangkah lebih jauh, penting untuk mengevaluasi sendiri model-model ini:

- Unduh setiap model di LM Studio

- Gunakan tab obrolan AI untuk berinteraksi dengan model

- Uji kinerjanya pada berbagai tugas, terutama pengkodean jika itu fokus Anda

- Menilai kualitas keluaran dan seberapa baik keluaran tersebut sesuai dengan kebutuhan Anda

Ingat, pengalaman Anda mungkin berbeda berdasarkan kasus penggunaan dan kemampuan perangkat keras tertentu. Luangkan waktu untuk menemukan model yang paling sesuai dengan kebutuhan Anda. Proses pemilihan yang cermat ini akan memastikan Anda memiliki model Hugging Face offline yang paling efektif untuk kebutuhan Anda sebelum beralih ke integrasi dan penggunaan yang lebih canggih.

Server Lokal Ke LM Studio

Meluncurkan server model Hugging Face offline Anda sangatlah mudah:

- Buka LM Studio

- Pilih salah satu model yang Anda unduh

- Klik tombol Mulai Server

Selesai! Pengaturan default umumnya sesuai untuk sebagian besar pengguna. Namun, jika Anda ingin menyempurnakan pengalaman Anda, jangan ragu untuk menyesuaikan opsi agar sesuai dengan kebutuhan atau preferensi spesifik Anda.

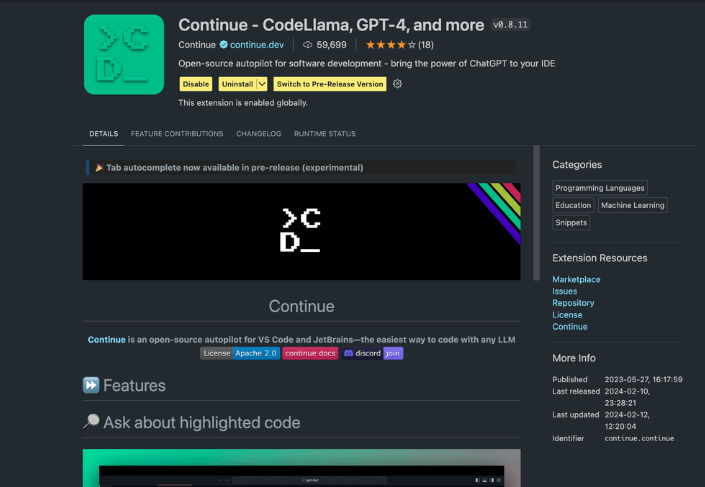

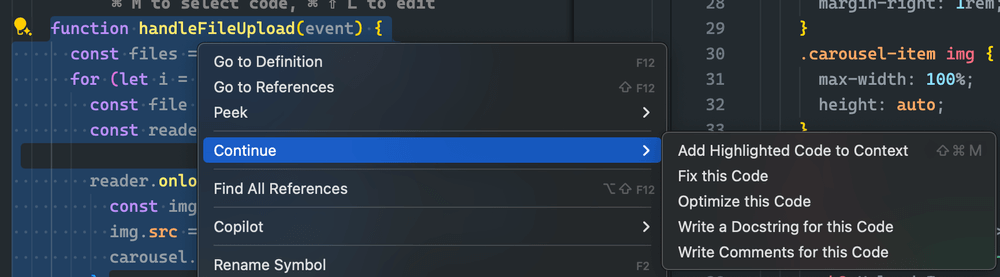

Menggunakan Ekstensi Lanjutkan

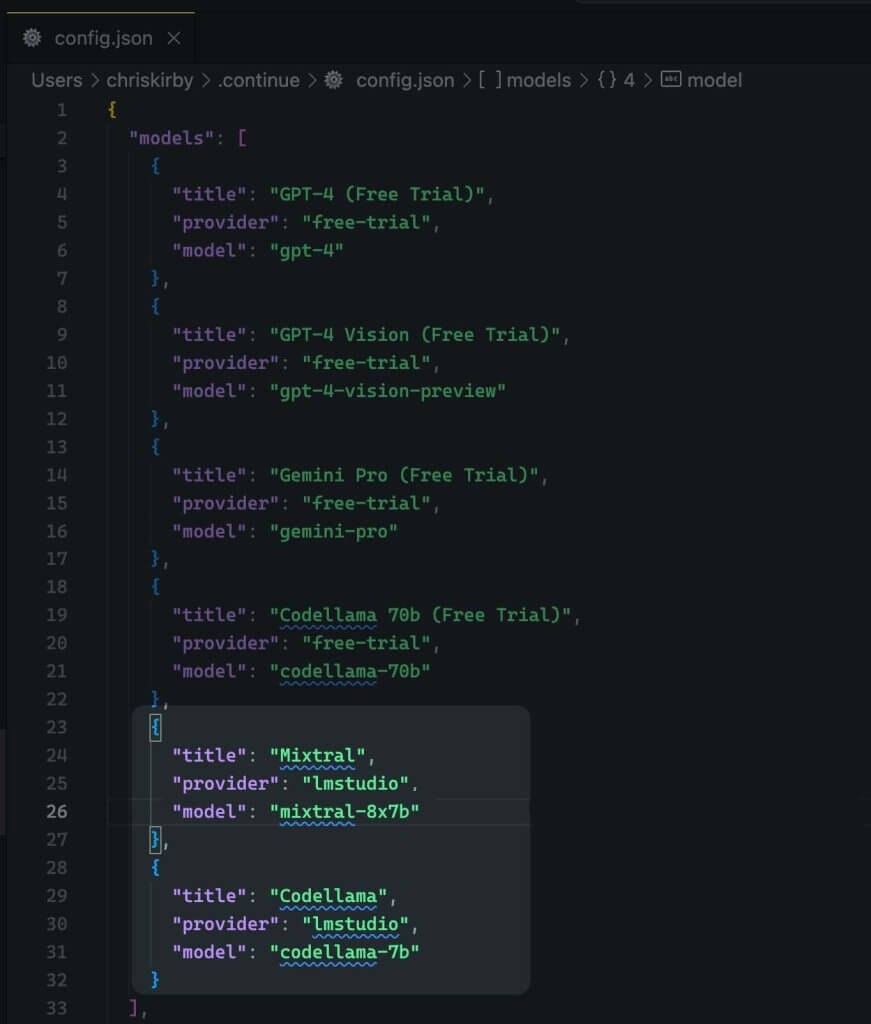

Dari VS Code Studio yang telah diluncurkan, navigasikan ke tampilan ekstensi. Di bilah pencarian, ketik "Lanjutkan". Temukan ekstensi yang tepat, lalu instal.

Sekarang kita perlu mengubah konfigurasi JSON dari ekstensi tersebut. Ini akan menambahkan dukungan LM Studio.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Sekarang, simpan.

Berikutnya, Anda perlu menggunakan model lokal ini, bukan kode VS.

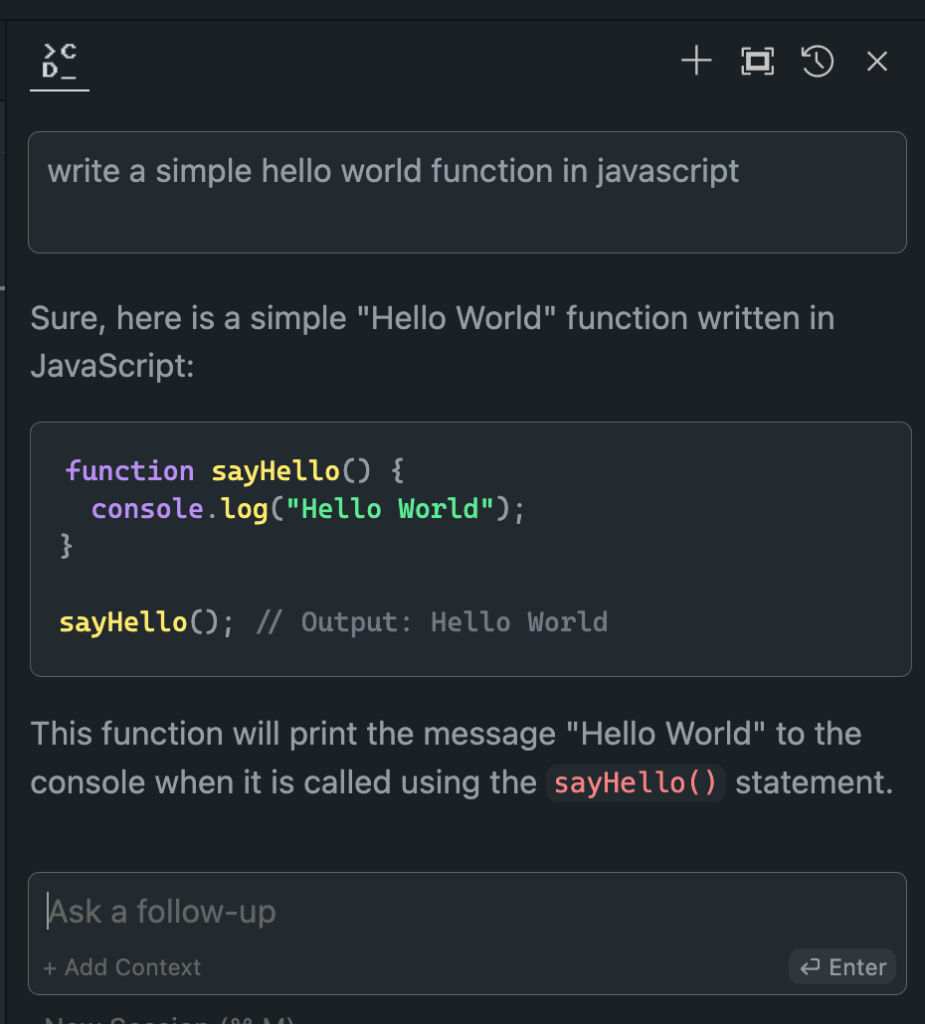

Mengevaluasi Kinerja Model Offline vs. Online

Sekarang setelah kita menyiapkan model Hugging Face offline, saatnya untuk momen kebenaran. Mari kita uji coba dengan model online!

Dalam uji coba ekstensif saya, hasilnya sungguh mencengangkan:

- Performa: Model luring sering kali menyamai, dan dalam beberapa kasus, bahkan melampaui model daring.

- Kecepatan: Tanpa latensi jaringan, respons dapat sangat cepat.

- Konsistensi: Tidak ada lagi variabilitas karena beban server atau masalah koneksi.

Meskipun pengalaman Anda mungkin berbeda-beda, tergantung pada model dan perangkat keras yang Anda pilih, jangan heran jika Anda lebih memilih versi offline. Kombinasi daya pemrosesan lokal dan model yang disetel dengan baik dapat memberikan hasil yang mengesankan.

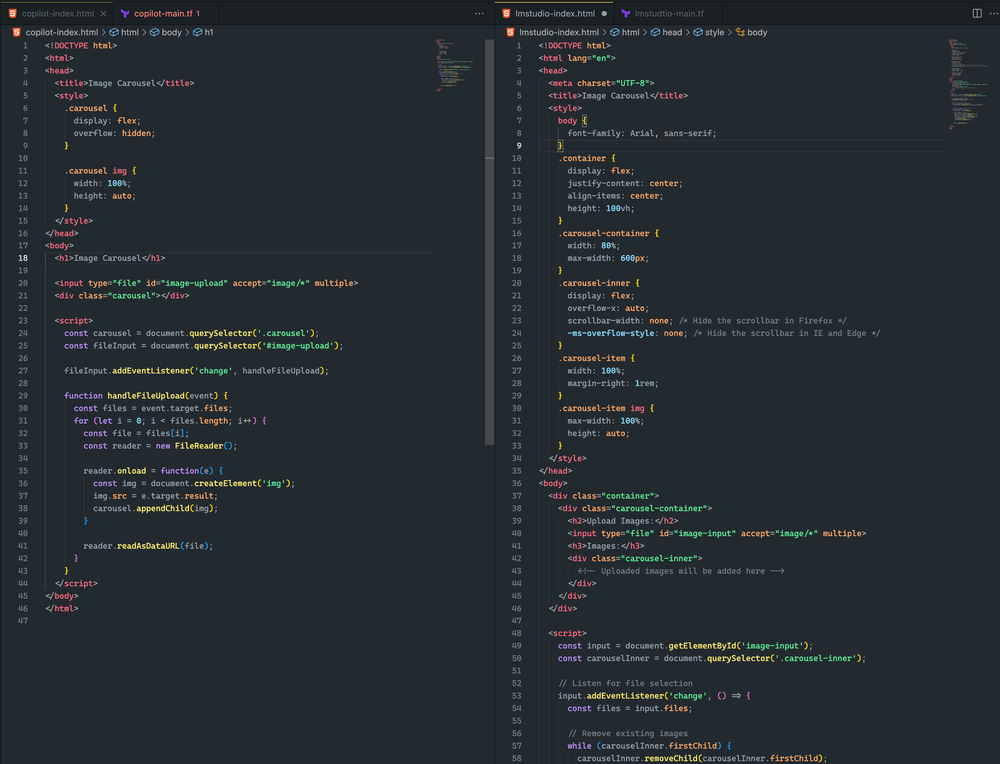

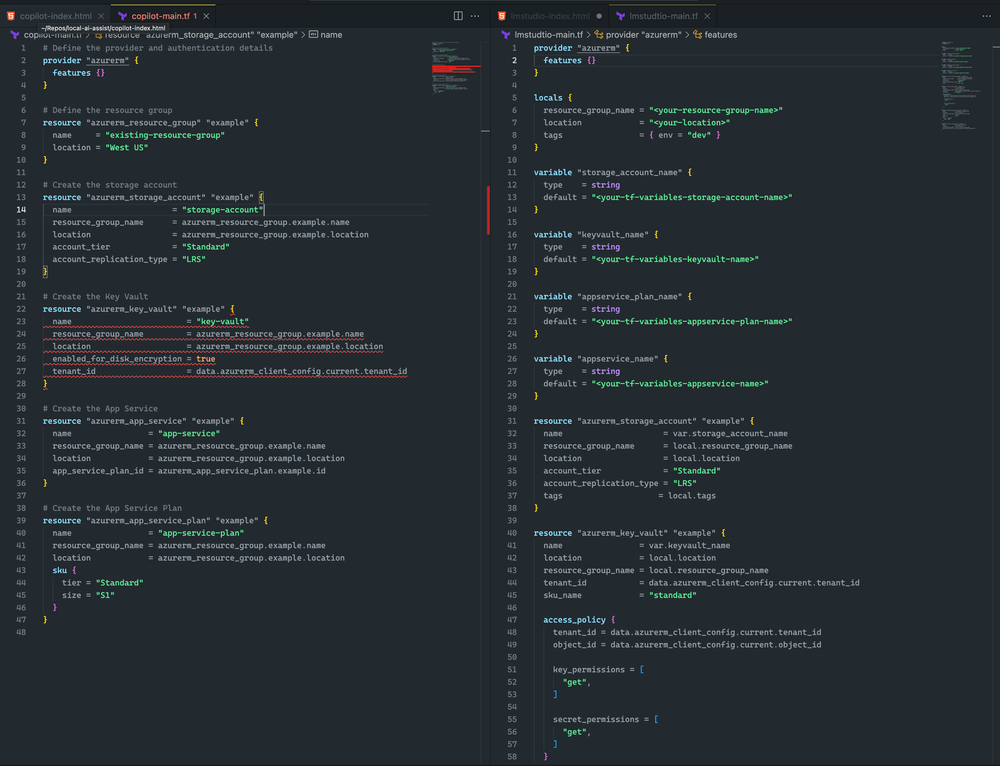

Di sini lihat perbedaannya.

Kedua pendekatan tersebut cukup mirip. Meskipun keduanya tidak menghasilkan rangkaian gambar, saya berhasil mengunggah gambar, dan gambar tersebut ditampilkan dalam kedua contoh. Dengan penyesuaian lebih lanjut yang cepat, saya yakin saya dapat memperoleh hasil yang lebih baik.

Saya condong ke LM Studio dan Mixtral karena Terraform lebih lengkap dan tidak memiliki kesalahan sintaksis. Namun, CoPilot memiliki masalah kecil: deklarasi brankas kunci tidak memiliki sku_name , yang dapat diperbaiki dengan mudah.

Penutup

Ingat, bidang AI berkembang dengan cepat. Dengan menguasai penerapan model Hugging Face secara offline, Anda tidak hanya mengimbangi, tetapi juga menjadi yang terdepan. Baik Anda seorang pengembang, peneliti, atau penggemar AI, keterampilan ini memberdayakan Anda untuk melampaui batas-batas yang memungkinkan dengan pemrosesan AI lokal.

Jadi, ambil risiko. Bereksperimenlah dengan berbagai model, sempurnakan pengaturan Anda, dan integrasikan kekuatan offline ini ke dalam alur kerja Anda. Anda mungkin menemukan bahwa masa depan pengembangan AI ada di komputer lokal Anda, menunggu untuk dilepaskan.