En tant que passionné d'IA, j'ai pu constater de mes propres yeux l'essor incroyable des grands modèles de langage (LLM). Ces puissants outils d'IA ont révolutionné notre façon d'interagir avec la technologie, suscitant des dilemmes pour les entreprises comme pour les particuliers.

Devons-nous opter pour la commodité des services d'abonnement ou prendre le contrôle en hébergeant nos modèles ? Cette question ne concerne pas uniquement le coût : elle touche également aux performances, à la confidentialité et à l'évolutivité.

Dans cet article de blog, j'explorerai les deux options, en m'appuyant sur mon expérience et les dernières tendances du secteur pour vous aider à prendre une décision éclairée qui correspond à vos besoins et ressources spécifiques.

Hébergement LLM vs abonnement ChatGPT: comprendre les options

Analysons nos deux principaux prétendants dans le domaine du LLM.

Créer des sites Web incroyables

Avec le meilleur constructeur de page Elementor

Commencer MaintenantAbonnement à ChatGPT

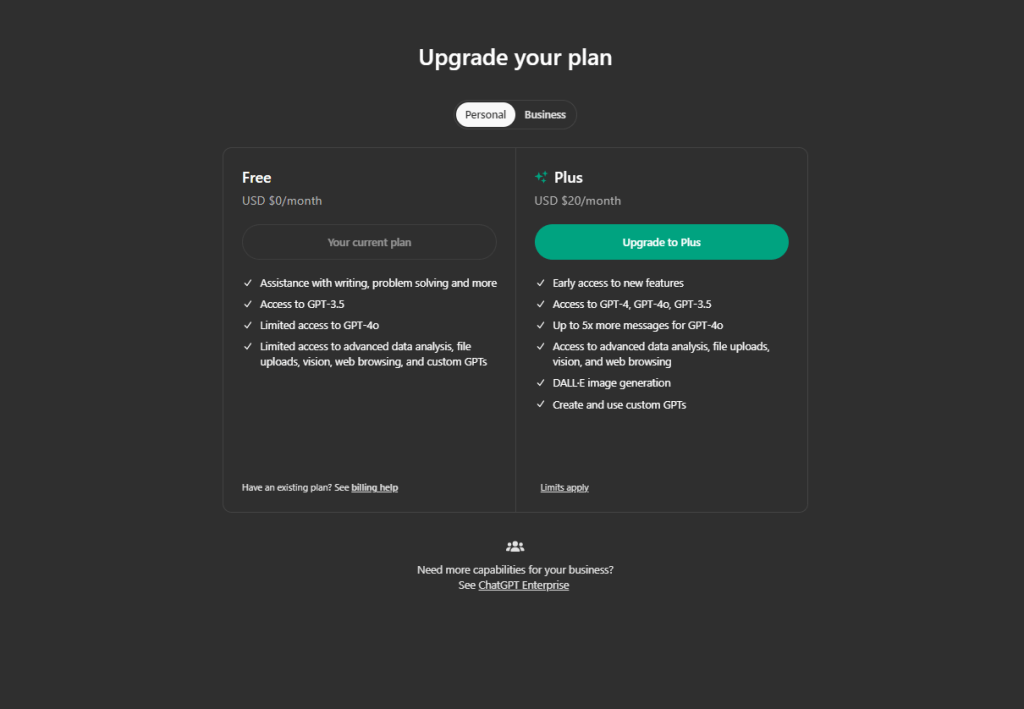

ChatGPT est devenu un nom familier pour une bonne raison. En tant qu'abonné, vous obtenez :

- Accès à des modèles linguistiques de pointe

- Mises à jour et améliorations régulières

- Une interface conviviale

- API robuste pour l'intégration dans diverses applications

La tarification est simple : vous payez en fonction de votre utilisation. Pour les utilisateurs occasionnels ou les petites entreprises, cela peut s'avérer très rentable.

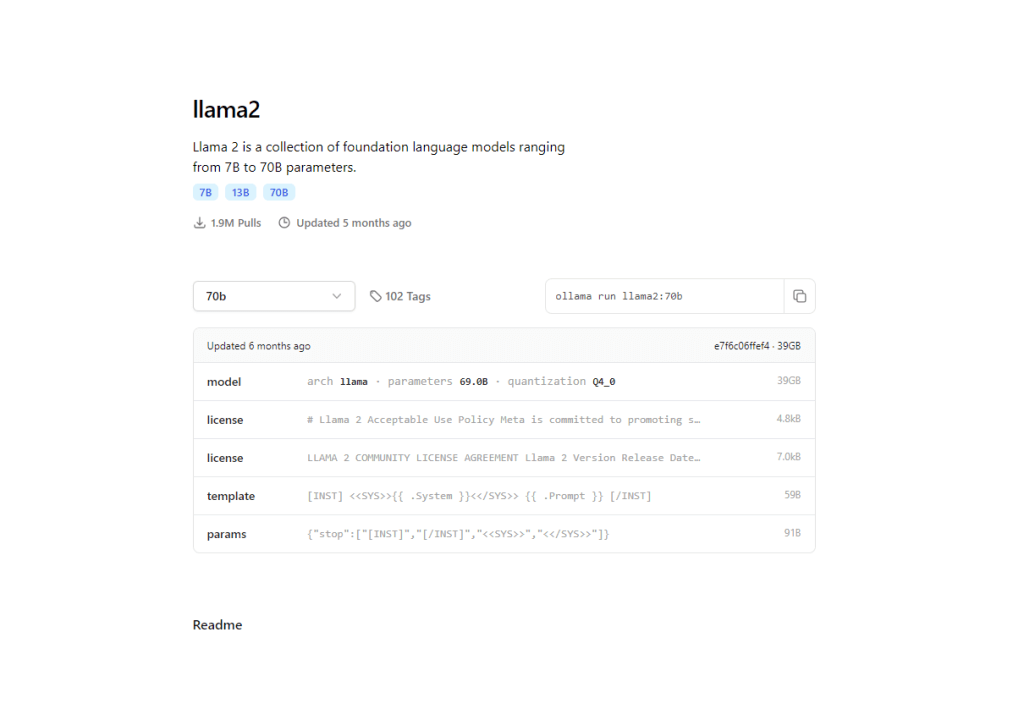

LLM Open Source auto-hébergés

De l'autre côté, nous avons l'approche DIY. Les modèles open source populaires comme LLaMA et GPT-NeoX offrent :

- Contrôle total sur votre modèle

- Options de personnalisation

- Confidentialité des données

- Potentiel d'économies de coûts à grande échelle

Vous disposez ici de deux options de déploiement principales:

a) Hébergement Cloud (AWS, Google Cloud, Azure)

b) Matériel sur site

Chaque chemin a ses avantages et ses inconvénients, que nous explorerons en profondeur au fur et à mesure.

Le choix entre ces options n'est pas toujours évident. Cela dépend de vos besoins spécifiques, de vos ressources et de vos objectifs à long terme. Dans les sections suivantes, je vous guiderai à travers les facteurs clés à prendre en compte, vous aidant à prendre la meilleure décision en fonction de votre situation particulière.

Comparaison des coûts

En matière de LLM, le coût est souvent un facteur décisif. Analysons les chiffres.

Abonnement à ChatGPT

si nous utilisons ChatGPT, l'abonnement coûtera :

- Actuellement, OpenAI facture 0,002 $ pour 1000 jetons.

- Pour donner une idée, 1000 jetons représentent environ 750 mots.

- Une journée typique avec 5 000 requêtes peut coûter environ 6,5 $.

- Cela représente environ 200 $ par mois pour une utilisation modérée.

Cela semble raisonnable, n'est-ce pas ? Mais voici le problème : les coûts peuvent grimper en flèche en cas d'utilisation intensive. Votre facture mensuelle pourrait rapidement devenir exorbitante si vous traitez des milliers de requêtes chaque jour.

LLM Open Source auto-hébergés

Si vous souhaitez créer votre propre LLM auto-hébergé, cela vous coûtera :

- Matériel : Un GPU haut de gamme comme une NVIDIA RTX 3090 coûte environ 700 $.

- Hébergement cloud : AWS peut coûter environ 150 à 160 $ par jour pour 1 million de requêtes.

- N'oubliez pas l'électricité : à 0,12 $/kWh, faire fonctionner un GPU puissant 24 heures sur 24, 7 jours sur 7, coûte cher.

- Coûts de main-d’œuvre : vous aurez besoin d’une expertise pour configurer et entretenir votre système.

La configuration initiale pour l’auto-hébergement est plus coûteuse, mais elle peut s’avérer plus rentable pour une utilisation à volume élevé au fil du temps.

Coûts cachés à prendre en compte:

- Temps : la configuration d’un système auto-hébergé n’est pas instantanée.

- Mises à niveau : la technologie évolue rapidement dans le monde de l’IA.

- Temps d'arrêt : les systèmes auto-hébergés peuvent être confrontés à davantage d'interruptions.

Le verdict : le modèle d'abonnement de ChatGPT est souvent le plus avantageux en termes de coût pour les utilisateurs à faible volume. Mais si vous envisagez de traiter des millions de requêtes mensuelles, l'auto-hébergement pourrait vous faire économiser de l'argent à long terme.

Performance et qualité

En matière de LLM, la performance est primordiale. Examinons de plus près la comparaison entre ChatGPT et les modèles open source:

Fonctionnalités de ChatGPT

- Des réponses de qualité constante

- Vaste base de connaissances couvrant divers sujets

- Mises à jour régulières améliorant les performances

- Capacité à gérer des requêtes et des tâches complexes

J'ai trouvé ChatGPT particulièrement impressionnant dans les scénarios d'écriture créative et de résolution de problèmes. Ses réponses semblent souvent humaines et adaptées au contexte.

Performances du LLM Open Source

- Des modèles comme LLaMA 2 rattrapent rapidement leur retard

- Certains modèles spécialisés surpassent ChatGPT dans des domaines spécifiques

- Potentiel de personnalisation pour une optimisation spécifique aux tâches

D'après mon expérience, les modèles open source récents comme LLaMA 2 70B peuvent égaler ou même dépasser GPT-3.5 dans des tâches spécifiques. L'écart se réduit rapidement.

C'est là que les modèles open source se démarquent. Avec l'auto-hébergement, vous pouvez :

- Entraînez-vous sur des données spécifiques à un domaine

- Optimiser pour des tâches particulières

- Surpasser potentiellement les modèles génériques dans les applications de niche

Les entreprises ont obtenu des résultats remarquables en adaptant les modèles open source à leurs besoins spécifiques.

Maintenant, si nous considérons la performance,

- Latence : les modèles auto-hébergés peuvent offrir des temps de réponse plus courts

- Personnalisation : adaptez les modèles open source à vos besoins exacts

- Cohérence : ChatGPT garantit des performances fiables sur diverses tâches

Le verdict : ChatGPT offre des performances de premier ordre dès sa sortie. Cependant, si vous avez des besoins spécifiques et spécialisés, un modèle open source optimisé pourrait potentiellement le surpasser dans votre cas d'utilisation particulier.

Confidentialité et contrôle des données

De nos jours, la confidentialité n'est pas seulement un luxe, c'est une nécessité. Examinons comment ChatGPT et les LLM auto-hébergés gèrent cet aspect crucial:

Traitement des données de ChatGPT

- OpenAI a des politiques de confidentialité strictes

- Les données envoyées à ChatGPT peuvent être utilisées pour améliorer le modèle

- Possibilité de refuser le partage de données, mais avec des compromis potentiels en termes de performances

Bien qu'OpenAI s'engage à respecter la confidentialité des utilisateurs, l'envoi de données sensibles à un tiers comporte toujours certains risques. J'ai vu des entreprises hésiter à utiliser ChatGPT pour des informations confidentielles.

Avantages du LLM auto-hébergé

- Contrôle total sur vos données

- Aucun risque d’exposition de données externes

- Capacité à mettre en œuvre des mesures de sécurité personnalisées

D’après mon expérience, ce niveau de contrôle change la donne pour des secteurs comme la santé ou la finance, où la confidentialité des données est primordiale.

J'ai travaillé avec des entreprises qui ont choisi l'auto-hébergement spécifiquement pour répondre à des exigences de conformité strictes.

Facteurs clés de confidentialité:

- Propriété des données : avec l'auto-hébergement, vous conservez la pleine propriété de vos données et de votre modèle

- Transparence : les modèles open source vous permettent d'inspecter et de comprendre le code

- Personnalisation : implémentez des fonctionnalités de confidentialité adaptées à vos besoins spécifiques

Le verdict : si la confidentialité des données est votre priorité absolue, l'auto-hébergement d'un LLM open source vous offre un contrôle inégalé. Cependant, les mesures de confidentialité robustes de ChatGPT peuvent être suffisantes pour les applications moins sensibles.

Évolutivité et flexibilité

Explorons comment ChatGPT et les LLM auto-hébergés se mesurent en termes d'évolutivité et de flexibilité.

Options d'évolutivité de ChatGPT

- Mise à l'échelle transparente avec une utilisation accrue

- Aucune gestion d’infrastructure requise

- L'API permet une intégration facile dans diverses applications

Si nous parlons de potentiel de personnalisation, ChatGPT se limite aux paramètres API et à l'ingénierie rapide.

J'ai vu des entreprises faire évoluer rapidement leurs capacités d'IA en utilisant ChatGPT sans se soucier de la logistique du back-end. C'est incroyablement simple.

Flexibilité du LLM auto-hébergé

- Contrôle total sur la taille et les capacités du modèle

- Capacité d'évolutivité horizontale sur plusieurs machines

- Liberté d'optimisation pour des configurations matérielles spécifiques

Pour une personnalisation future, vous aurez un accès complet à l'architecture du modèle et vous pourrez entraîner les données à un niveau avancé.

Dans mes projets, ce niveau de contrôle s’est avéré précieux pour affiner les performances et la rentabilité.

Le verdict : ChatGPT excelle en termes d'évolutivité sans effort, ce qui le rend idéal pour les entreprises dont les demandes fluctuent. Cependant, l'auto-hébergement offre une flexibilité inégalée pour ceux qui souhaitent gérer leur propre infrastructure.

Considérations techniques

Comme je travaille avec l'IA depuis longtemps, je peux vous dire que les aspects techniques sont cruciaux. Décomposons ce que vous devez savoir.

Pour ChatGPT, vous avez besoin d’une configuration minimale, et OpenAI gère déjà le reste.

Pour héberger vous-même un modèle LLM, vous devez comprendre en profondeur l'apprentissage automatique et le traitement du langage naturel. Il serait préférable d'avoir des compétences en matière d'infrastructure cloud ou de gestion de matériel hors site. De plus, vous aurez également besoin de vastes connaissances en matière de réglage fin et d'optimisation.

De nombreuses personnes sous-estiment l'expertise nécessaire, ce qui peut conduire à des échecs. Il ne s'agit pas seulement de télécharger un modèle, mais de le déployer et de le maintenir efficacement.

Facteurs techniques clés :

- Latence : les modèles auto-hébergés peuvent offrir des temps de réponse plus courts s'ils sont correctement optimisés

- Personnalisation : Contrôle total sur l'architecture du modèle et les données de formation

- Débogage: diagnostic et résolution des problèmes plus faciles avec les modèles auto-hébergés

Le verdict : ChatGPT est le grand gagnant pour ceux qui recherchent une solution plug-and-play. Cependant, si vous disposez de l'expertise technique et du désir d'un contrôle total, l'auto-hébergement peut offrir une personnalisation inégalée et des avantages potentiels en termes de performances.

Analyse des cas d'utilisation

En tant que professionnel de l'IA, j'ai vu différents scénarios dans lesquels différentes solutions LLM se sont révélées efficaces. Explorons quelques cas d'utilisation concrets pour guider votre décision.

Abonnement à ChatGPT

Les petites et moyennes entreprises bénéficient souvent de la simplicité d'utilisation de ChatGPT. Avec des ressources techniques limitées et un besoin de déploiement rapide, j'ai vu des startups prototyper rapidement des fonctionnalités d'IA, économisant ainsi des mois de développement.

Les équipes de création de contenu et de marketing s'épanouissent grâce aux diverses capacités linguistiques de ChatGPT. Une agence de marketing avec laquelle j'ai travaillé l'a utilisé pour réfléchir à des idées de campagne et rédiger des publications sur les réseaux sociaux, augmentant ainsi considérablement sa productivité.

L'automatisation du support client est un autre domaine dans lequel ChatGPT excelle. Sa disponibilité 24h/24 et 7j/7 et sa capacité à gérer les demandes générales en font un choix incontournable pour de nombreuses entreprises que j'ai conseillées.

LLM auto-hébergés

Les grandes entreprises qui traitent des volumes importants trouvent souvent l'auto-hébergement plus économique. J'ai aidé une plateforme de commerce électronique à passer à un modèle auto-hébergé, réduisant ainsi ses coûts d'IA de 60 % sur un an.

Les secteurs hautement réglementés bénéficient des avantages de l'auto-hébergement de contrôle. Une société fintech que j'ai conseillée a choisi cette voie pour garantir la conformité au RGPD et protéger les données financières sensibles.

Les applications spécialisées dans les domaines nécessitent souvent des modèles personnalisés. J'ai travaillé avec une start-up de technologie juridique qui a peaufiné un modèle open source sur des documents juridiques, surpassant les modèles génériques dans l'analyse des contrats.

Facteurs clés : volume de requêtes, sensibilité des données, ressources techniques et besoins de personnalisation. Des volumes plus importants et des données plus sensibles justifient souvent l'auto-hébergement, tandis que des ressources limitées favorisent ChatGPT.

Conclusion

Après avoir plongé dans le monde des LLM, il est clair que le choix entre ChatGPT et les modèles auto-hébergés n'est pas tout à fait évident. En tant que passionné et professionnel de l'IA, j'ai vu des mises en œuvre réussies des deux approches.

ChatGPT se distingue par sa simplicité d'utilisation, ses performances constantes et ses mises à jour régulières. C'est un excellent choix pour les entreprises à la recherche d'une solution d'IA rapide et sans tracas. Le modèle d'abonnement fonctionne bien pour une utilisation modérée et des applications générales.

L'auto-hébergement, en revanche, offre un contrôle, un potentiel de personnalisation et une confidentialité des données inégalés. Il est idéal pour les utilisateurs à volume élevé, les applications spécialisées et les secteurs soumis à des réglementations strictes en matière de données. La configuration initiale peut être difficile, mais les avantages à long terme peuvent être substantiels.

N'oubliez pas qu'il ne s'agit pas d'un choix permanent. À mesure que vos besoins évoluent et que le paysage de l'IA se transforme, vous pouvez toujours réévaluer et changer d'approche.

En fin de compte, le meilleur choix est celui qui correspond à vos objectifs, à vos ressources et à votre vision de l'intégration de l'IA dans votre flux de travail. Que vous optiez pour la commodité de ChatGPT ou le contrôle de l'auto-hébergement, vous entrez dans un monde passionnant de possibilités alimentées par l'IA.