À l’heure où le monde devient de plus en plus numérique, la demande de contenu de haute qualité n’a jamais été aussi forte. Heureusement, les progrès du traitement du langage naturel (TLN) ont donné naissance à de puissants outils d’écriture basés sur l’IA, tels que ceux développés par Hugging Face. Mais que faire si vous devez utiliser ces modèles hors ligne ? N’ayez crainte, car nous allons découvrir comment exploiter les modèles Hugging Face sans connexion Internet.

L'accès hors ligne aux modèles de langage de pointe de Hugging Face ouvre un monde de possibilités. Que vous travailliez dans des endroits éloignés, que vous soyez confronté à une connectivité Internet peu fiable ou que vous accordiez simplement la priorité à la confidentialité des données, la possibilité d'exécuter ces modèles localement peut changer la donne. En comprenant comment déployer les modèles Hugging Face hors ligne, vous pouvez accéder à de nouveaux niveaux d'efficacité, de flexibilité et de contrôle dans votre processus de création de contenu.

Dans cet article de blog, nous allons examiner les étapes pratiques que vous pouvez suivre pour exploiter la puissance des modèles Hugging Face hors ligne. Du déploiement du modèle à l'intégration transparente avec vos flux de travail existants, vous apprendrez à maximiser le potentiel de ces outils NLP avancés, même lorsqu'une connexion Internet n'est pas facilement disponible. Préparez-vous à améliorer votre création de contenu et à garder une longueur d'avance dans le monde en constante évolution du marketing et de la communication numériques.

Pourquoi pourriez-vous vouloir utiliser le modèle Huggingface hors ligne?

Vous vous demandez peut-être pourquoi quelqu'un prendrait la peine d'exécuter des modèles d'IA hors ligne. Mais croyez-moi, il existe des raisons vraiment convaincantes de retirer vos modèles Hugging Face de la grille.

Créer des sites Web incroyables

Avec le meilleur constructeur de page Elementor

Commencer MaintenantVoici une explication concise des raisons pour lesquelles quelqu'un pourrait vouloir utiliser les modèles Hugging Face hors ligne:

L'utilisation de modèles Hugging Face hors ligne offre plusieurs avantages clés:

- Fiabilité : Travaillez sans interruption sans vous soucier des problèmes de connectivité Internet.

- Vitesse : éliminez la latence du réseau pour une inférence de modèle plus rapide.

- Confidentialité : conservez les données sensibles localement, évitant ainsi les risques potentiels de sécurité liés au traitement en ligne.

- Rentabilité : réduisez les dépenses de cloud computing en exécutant des modèles sur votre matériel.

- Portabilité : utilisez des fonctionnalités d’IA avancées dans des emplacements distants ou des zones avec un accès Internet limité.

- Apprentissage : Acquérir une compréhension plus approfondie de l’architecture et du fonctionnement des modèles en travaillant directement avec eux.

- Personnalisation : affinez et adaptez plus facilement les modèles à des cas d'utilisation spécifiques lorsque vous disposez d'un accès local.

Plongeons-nous dans le vif du sujet et découvrons comment exploiter tout le potentiel des modèles Hugging Face, à tout moment et en tout lieu.

Comment utiliser les modèles Huggingface hors ligne?

Huggingface est comme un Github ou un magasin d'applications pour l'IA open source. Ici, vous pouvez parcourir, télécharger et même utiliser de nombreux LLM open source à partir de ce site Web. De plus, tout comme ChatGPT, ils ont Hugging Chat. Ce chatbot vous permet de choisir un modèle que vous souhaitez utiliser et vous pouvez ensuite engager une conversation avec celui-ci comme vous le feriez avec n'importe quel autre assistant d'IA multi-modèle.

Ne serait-ce pas génial d'utiliser ces modèles de manière totalement gratuite, hors ligne et au quotidien ? Faisons-le.

Studio LM

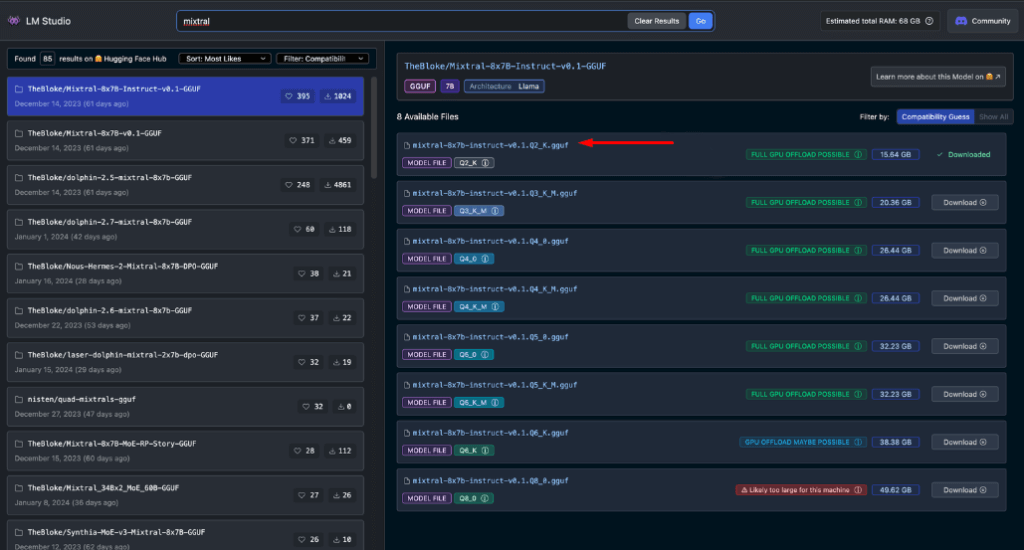

LM Studio révolutionne la façon dont nous utilisons les modèles d'IA localement. Cette application polyvalente, disponible pour Windows, Mac (Apple Silicon) et Linux (version bêta), permet aux utilisateurs de télécharger et d'exécuter facilement des modèles Hugging Face hors ligne.

Les principales fonctionnalités de LM Studio incluent:

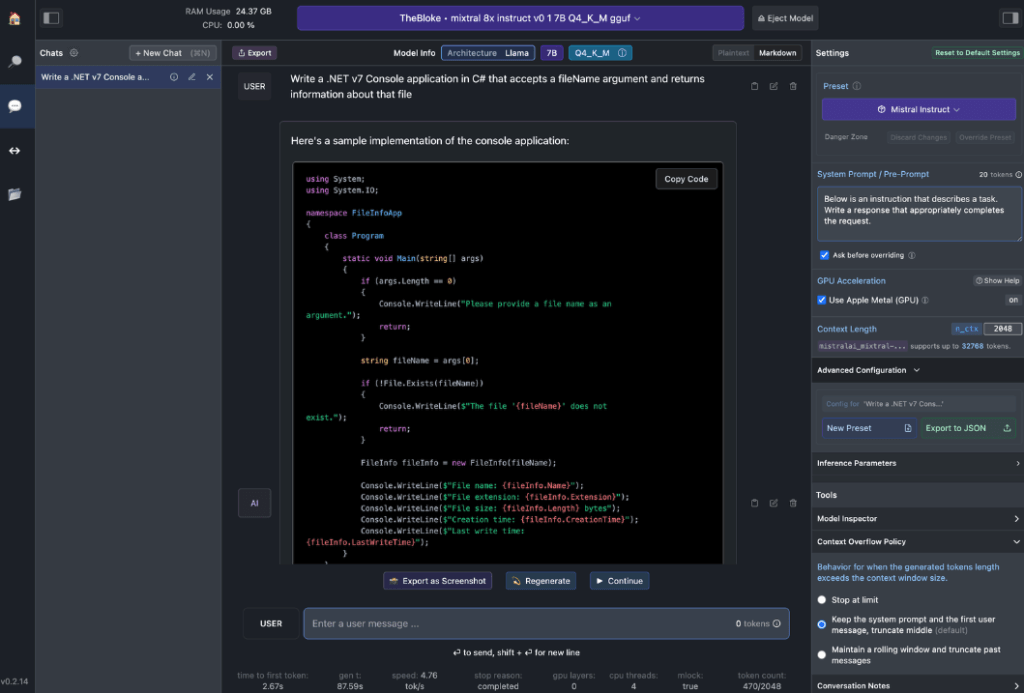

- Interaction avec le modèle local: téléchargez votre modèle de langage (LLM) préféré et interagissez avec lui comme vous le feriez avec n'importe quel assistant IA basé sur le chat. Personnalisez les performances et le format de sortie, et explorez les fonctionnalités expérimentales via diverses invites et options système intégrées.

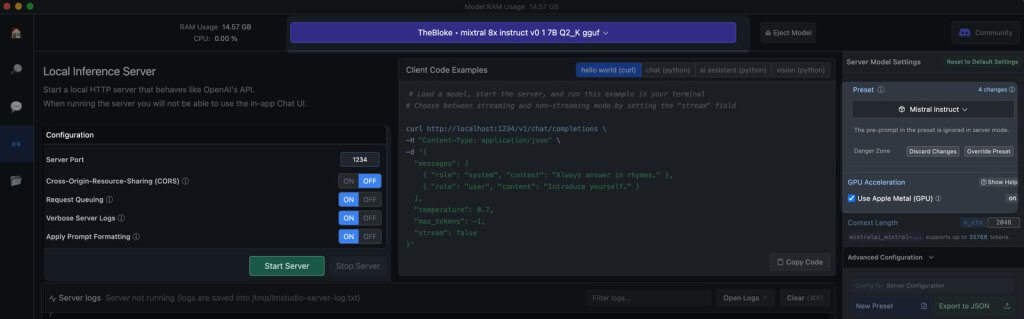

- Émulation d'API OpenAI: c'est là que LM Studio brille vraiment. Chargez votre modèle Hugging Face téléchargé et LM Studio l'entoure ingénieusement d'un proxy API local, imitant l'API OpenAI. Cette compatibilité change la donne, car elle permet une intégration transparente avec de nombreux SDK et extensions d'éditeur et d'IDE populaires qui prennent déjà en charge OpenAI.

Configuration matérielle requise pour les postes de travail

Pour exploiter pleinement le potentiel des modèles Hugging Face hors ligne, vous aurez besoin d'un matériel robuste. Bien que tout ordinateur moderne puisse gérer des tâches de base, des performances optimales nécessitent des spécifications plus puissantes:

Pour les utilisateurs Apple:

- Processeurs M2/M3 Max ou Ultra

- Configurations haut de gamme

- 50+ Go de RAM (partagé avec le GPU sur M2 SoC)

- Support métallique pour des performances améliorées

Pour les utilisateurs Windows:

- Plus de cœurs de processeur

- Mémoire RAM importante

- GPU série RTX 30 ou 40 avec beaucoup de VRAM

Ne vous inquiétez pas si vous ne disposez pas d'un système haut de gamme. De nombreuses options compatibles avec la RAM et la VRAM existent, même parmi les modèles les plus récents. LM Studio évalue utilement les capacités de votre système lorsque vous parcourez et téléchargez des modèles.

En règle générale, des fichiers de modèles plus volumineux et des besoins en ressources plus élevés sont associés à une meilleure qualité de sortie. Bien qu'il soit préférable de ne pas pousser votre système à ses limites absolues, n'ayez pas peur de viser haut dans les limites des capacités de votre matériel.

N'oubliez pas : l'objectif est d'équilibrer les performances du modèle avec les ressources de votre système pour obtenir la meilleure expérience Hugging Face hors ligne.

Modèles recommandés pour une utilisation hors ligne

Lors de l'exécution de modèles Hugging Face hors ligne, le choix du bon modèle est crucial. Grâce à des tests approfondis, j'ai constaté que les modèles suivants fournissent systématiquement des résultats impressionnants pour les tâches de chat et de codage générales:

Chacun de ces modèles offre un équilibre unique entre performances et utilisation des ressources, ce qui en fait d'excellents choix pour un déploiement hors ligne.

Avant de continuer, il est essentiel d’évaluer vous-même ces modèles:

- Téléchargez chaque modèle dans LM Studio

- Utilisez l'onglet de discussion AI pour interagir avec le modèle

- Testez ses performances sur diverses tâches, notamment le codage si c'est votre objectif

- Évaluer la qualité des résultats et leur adéquation avec vos besoins

N'oubliez pas que votre expérience peut varier en fonction de votre cas d'utilisation spécifique et des capacités matérielles. Prenez le temps de trouver le modèle qui correspond le mieux à vos besoins. Ce processus de sélection minutieux vous permettra de disposer du modèle Hugging Face hors ligne le plus efficace pour vos besoins avant de passer à l'intégration et à une utilisation plus avancée.

Serveur local dans LM Studio

Le lancement de votre serveur de modèles Hugging Face hors ligne est très simple:

- Ouvrir LM Studio

- Sélectionnez l'un de vos modèles téléchargés

- Cliquez sur le bouton Démarrer le serveur

Et voilà ! Les paramètres par défaut conviennent généralement à la plupart des utilisateurs. Cependant, si vous souhaitez peaufiner votre expérience, n'hésitez pas à ajuster les options en fonction de vos besoins ou préférences spécifiques.

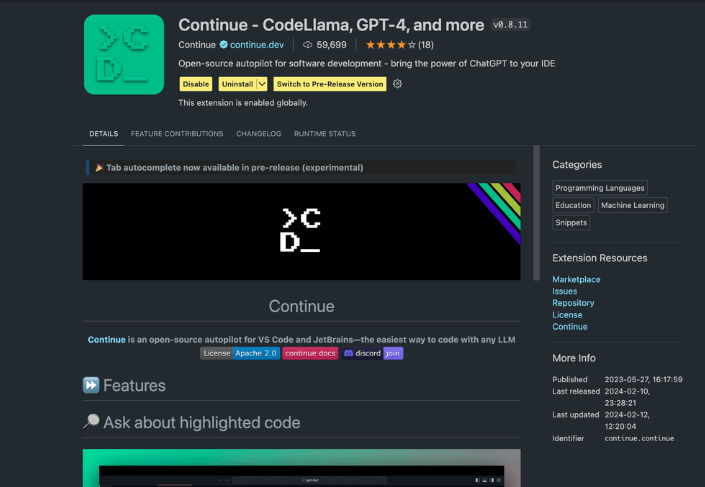

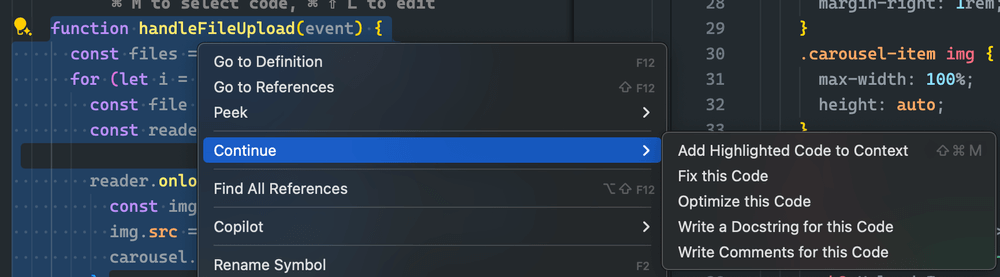

Utilisation de l'extension Continue

Depuis le studio VS Code lancé, accédez à la vue des extensions. Dans la barre de recherche, saisissez «Continuer». Recherchez l'extension appropriée et installez-la.

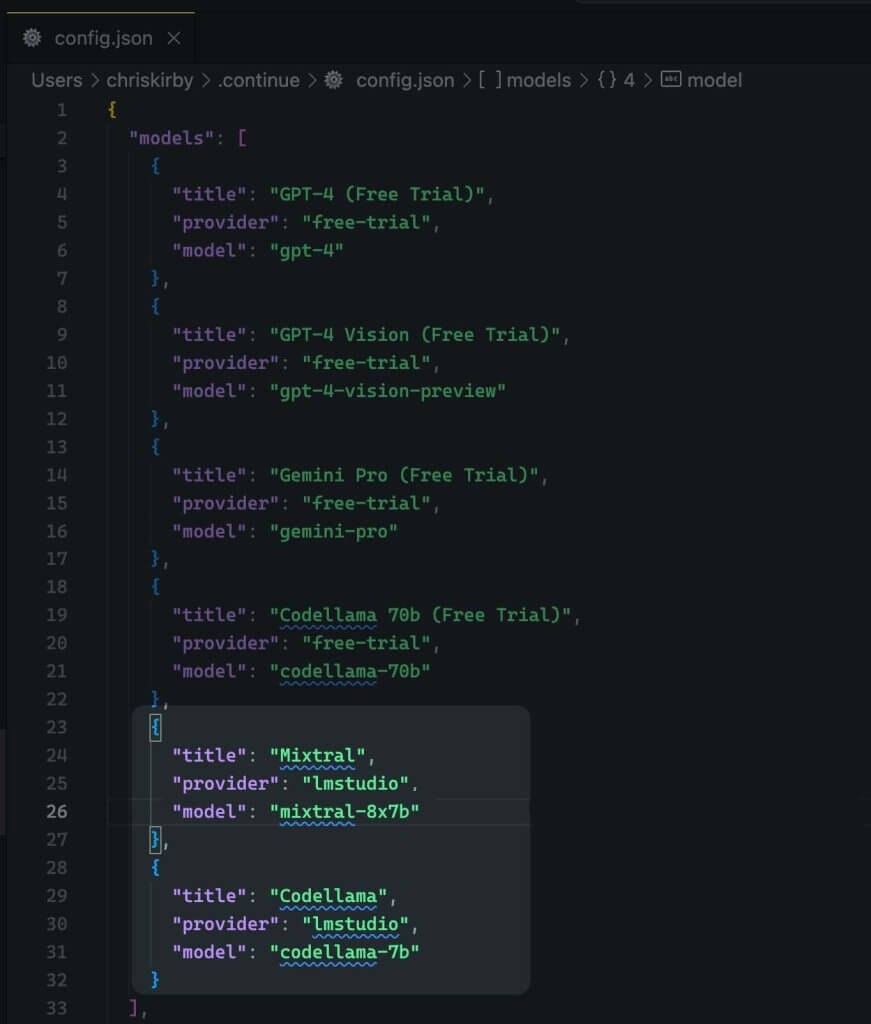

Il faut maintenant modifier la configuration JSON de l'extension. Cela ajoutera le support LM Studio.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Maintenant, enregistre-le.

Ensuite, vous devez utiliser ce modèle local au lieu du code VS.

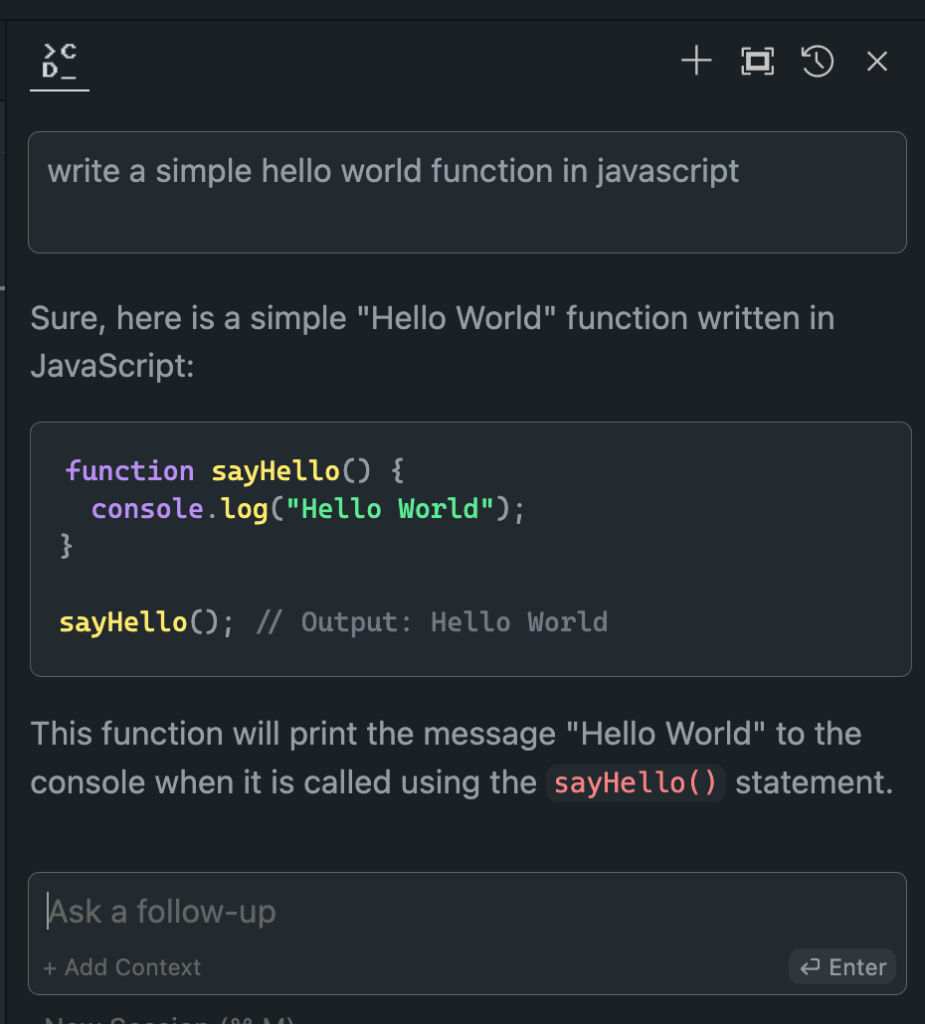

Évaluation des performances des modèles hors ligne et en ligne

Maintenant que nous avons mis en place notre modèle Hugging Face hors ligne, il est temps de passer au moment de vérité. Mettons-le à l'épreuve par rapport à ses homologues en ligne!

Au cours de mes nombreux essais, les résultats ont été révélateurs :

- Performances : Le modèle hors ligne correspond souvent, et dans certains cas, surpasse même, ses équivalents en ligne.

- Rapidité : Sans latence réseau, les réponses peuvent être ultra-rapides.

- Cohérence : plus de variabilité due à la charge du serveur ou à des problèmes de connexion.

Bien que votre expérience puisse varier en fonction du modèle et du matériel choisis, ne soyez pas surpris si vous préférez la version hors ligne. La combinaison de la puissance de traitement locale et de modèles optimisés peut produire des résultats impressionnants.

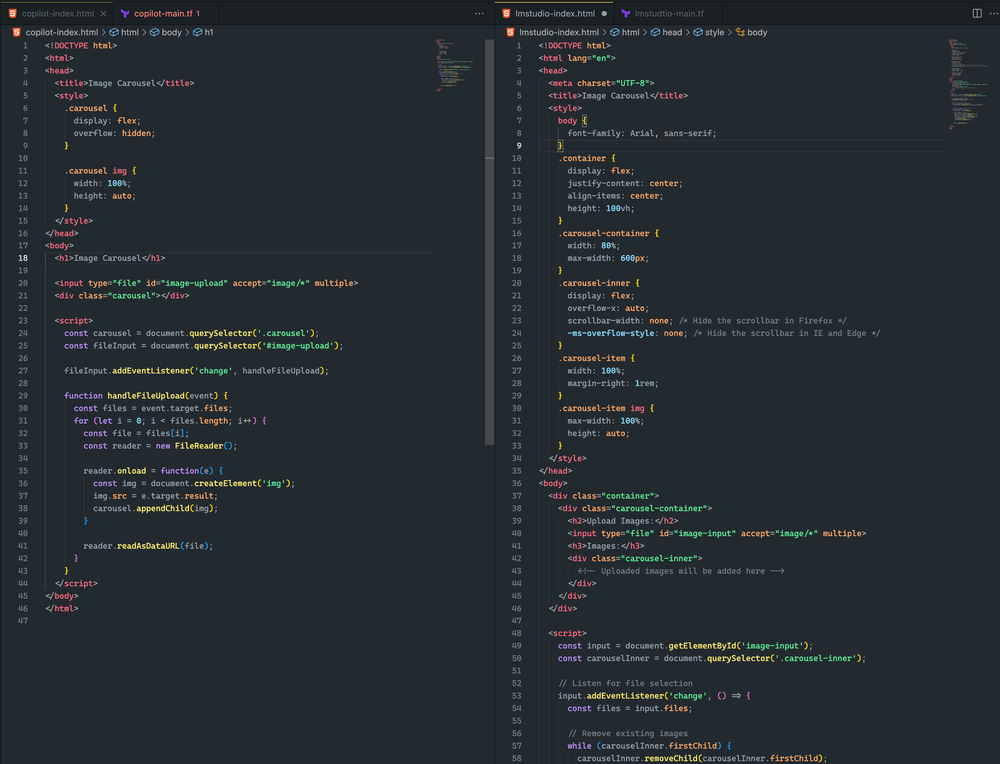

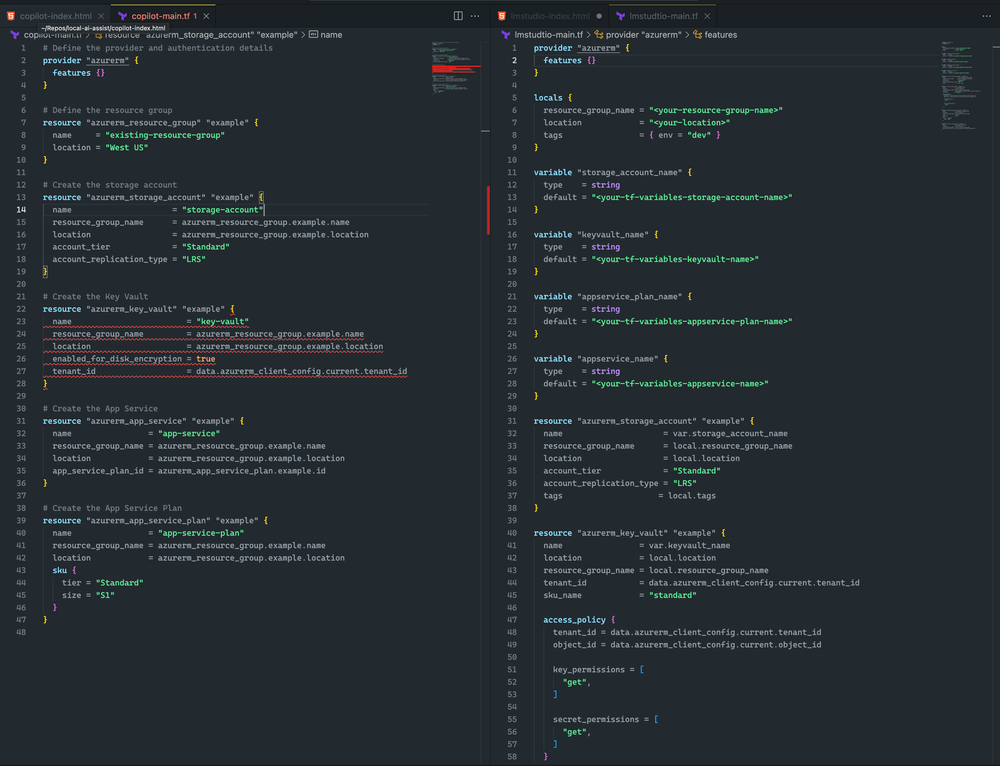

Voyez ici la différence.

Les deux approches étaient assez proches. Bien qu'aucune n'ait abouti à un carrousel d'images, j'ai réussi à télécharger une image et elle s'est affichée dans les deux exemples. Avec d'autres ajustements rapides, je pense pouvoir obtenir un résultat encore meilleur

Je penche plutôt pour LM Studio et Mixtral car Terraform est plus complet et ne présente aucune erreur de syntaxe. Cependant, CoPilot présente un problème mineur: la déclaration du coffre de clés ne contient pas le sku_name , ce qui peut être facilement corrigé.

Pour conclure

N'oubliez pas que le domaine de l'IA évolue rapidement. En maîtrisant le déploiement hors ligne des modèles Hugging Face, vous ne vous contentez pas de suivre le rythme, vous gardez une longueur d'avance. Que vous soyez développeur, chercheur ou passionné d'IA, cette compétence vous permet de repousser les limites du possible avec le traitement local de l'IA.

Alors, lancez-vous. Expérimentez avec différents modèles, peaufinez votre configuration et intégrez ces outils hors ligne à votre flux de travail. Vous découvrirez peut-être que l'avenir du développement de l'IA se trouve juste là, sur votre machine locale, en attente d'être libéré.