Como entusiasta de la IA, he sido testigo directo del increíble auge de los grandes modelos lingüísticos (LLM). Estas potentes herramientas de IA han revolucionado la forma en que interactuamos con la tecnología, lo que ha generado dilemas tanto para las empresas como para los individuos.

¿Deberíamos aprovechar la comodidad de los servicios de suscripción o tomar el control alojando nuestros modelos? Esta pregunta no solo tiene que ver con el costo, sino también con el rendimiento, la privacidad y la escalabilidad.

En esta publicación de blog, exploraré ambas opciones, basándome en mi experiencia y las últimas tendencias de la industria para ayudarlo a tomar una decisión informada que se alinee con sus necesidades y recursos específicos.

Alojamiento LLM vs suscripción ChatGPT: conocer las opciones

Analicemos a nuestros dos principales contendientes en el ámbito LLM.

Create Amazing Websites

Con el mejor generador de páginas gratuito Elementor

Empezar ahoraSuscripción a ChatGPT

ChatGPT se ha convertido en un nombre conocido por una buena razón. Como suscriptor, obtienes:

- Acceso a modelos lingüísticos de última generación

- Actualizaciones y mejoras periódicas

- Una interfaz fácil de usar

- API robusta para integración en diversas aplicaciones

El precio es claro: pagas en función del uso. Para usuarios ocasionales o pequeñas empresas, esto puede resultar bastante rentable.

LLM de código abierto autoalojados

Por otro lado, tenemos el enfoque DIY. Los modelos de código abierto populares como LLaMA y GPT-NeoX ofrecen:

- Control total sobre tu modelo

- Opciones de personalización

- Privacidad de datos

- Potencial de ahorro de costes a gran escala

Aquí tienes dos opciones de implementación principales:

a) Alojamiento en la nube (AWS, Google Cloud, Azure)

b) Hardware local

Cada camino tiene sus pros y sus contras, que exploraremos en profundidad a medida que avancemos.

La elección entre estas opciones no siempre es clara. Depende de sus necesidades específicas, recursos y objetivos a largo plazo. En las siguientes secciones, le guiaré a través de los factores clave que debe tener en cuenta, para ayudarle a tomar la mejor decisión para su situación particular.

Comparación de costos

En lo que respecta a los programas de máster, el costo suele ser un factor decisivo. Analicemos las cifras.

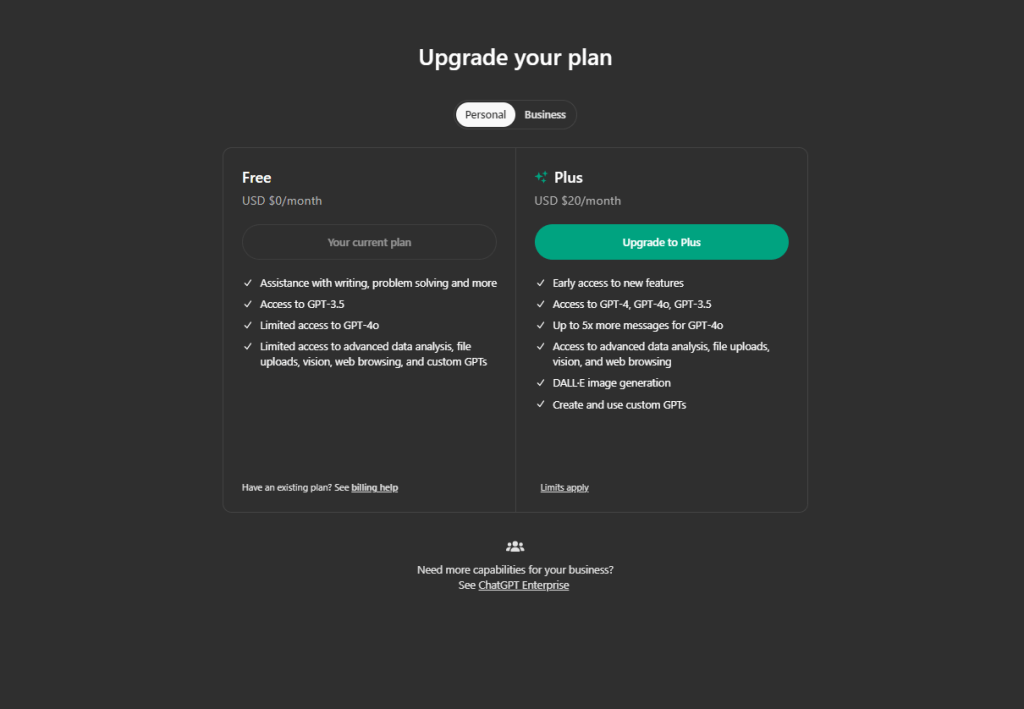

Suscripción a ChatGPT

Si utilizamos ChatGPT la suscripción costará:

- Actualmente, OpenAI cobra $0,002 por cada 1000 tokens.

- Para ponerlo en perspectiva, 1K tokens equivalen aproximadamente a 750 palabras.

- Un día típico con 5000 consultas podría costar alrededor de $6,5.

- Eso es alrededor de $200 por mes para un uso moderado.

Suena razonable, ¿verdad? Pero aquí está el truco: los costos pueden dispararse con un uso intensivo. Tu factura mensual podría volverse rápidamente desorbitante si manejas miles de consultas diarias.

LLM de código abierto autoalojados

Si deseas realizar tu propio LLM autoalojado, te costará:

- Hardware: Una GPU de gama alta como una NVIDIA RTX 3090 cuesta alrededor de $700.

- Alojamiento en la nube: AWS puede costar entre $150 y $160 por día para 1 millón de solicitudes.

- No olvides la electricidad: a $0,12/kWh, tener una GPU potente funcionando las 24 horas del día, los 7 días de la semana tiene un precio considerable.

- Costos de mano de obra: Necesitará experiencia para configurar y mantener su sistema.

La configuración inicial para autohospedaje es más costosa, pero puede resultar más rentable para un uso de gran volumen a lo largo del tiempo.

Costos ocultos a considerar:

- Tiempo: La configuración de un sistema autoalojado no es instantánea.

- Actualizaciones: La tecnología evoluciona rápidamente en el mundo de la IA.

- Tiempo de inactividad: los sistemas autohospedados podrían enfrentar más interrupciones.

El veredicto: el modelo de suscripción de ChatGPT suele ser el ganador en términos de costo para usuarios de bajo volumen. Pero si está considerando millones de consultas mensuales, el autoalojamiento podría ahorrarle dinero a largo plazo.

Rendimiento y calidad

En lo que respecta a los LLM, el rendimiento es fundamental. Veamos en profundidad cómo se comparan ChatGPT y los modelos de código abierto:

Capacidades de ChatGPT

- Respuestas de alta calidad de manera constante

- Amplia base de conocimientos que abarca diversos temas.

- Actualizaciones periódicas que mejoran el rendimiento

- Capacidad para gestionar consultas y tareas complejas

Me ha parecido que ChatGPT es particularmente impresionante en situaciones de escritura creativa y resolución de problemas. Sus respuestas suelen parecer humanas y contextualizadas.

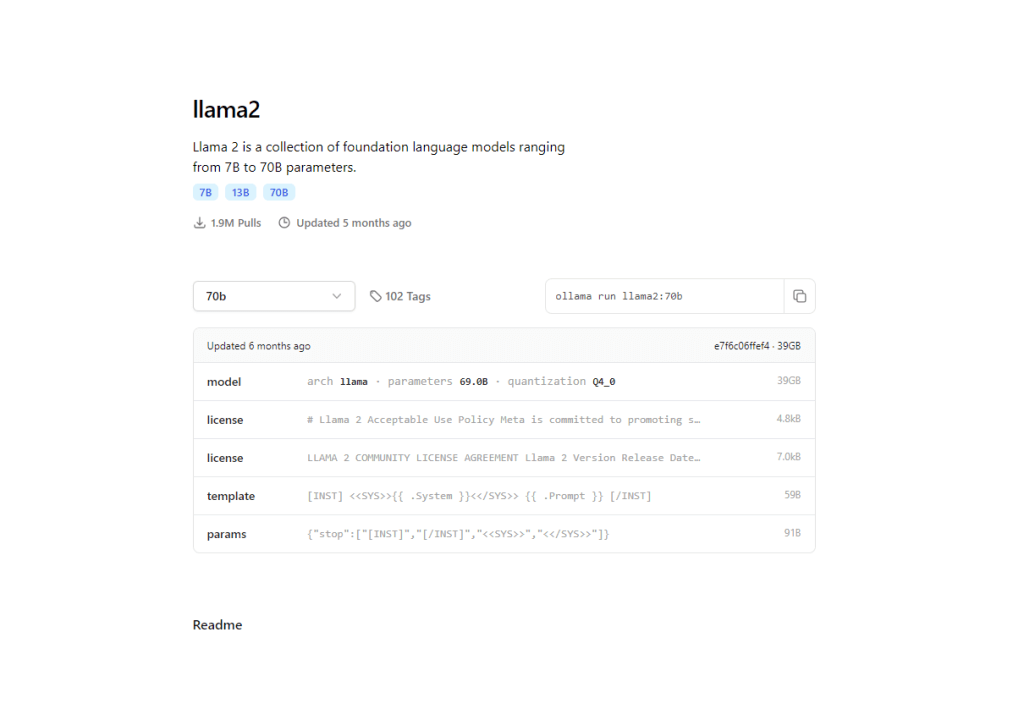

Rendimiento de LLM de código abierto

- Modelos como LLaMA 2 se están poniendo al día rápidamente

- Algunos modelos especializados superan a ChatGPT en dominios específicos

- Potencial de personalización para la optimización de tareas específicas

En mi experiencia, los modelos de código abierto recientes como LLaMA 2 70B pueden igualar o incluso superar a GPT-3.5 en tareas específicas. La brecha se está reduciendo rápidamente.

Aquí es donde los modelos de código abierto brillan. Con el alojamiento propio, puedes:

- Entrenamiento con datos específicos del dominio

- Optimizar para tareas específicas

- Potencialmente superan a los modelos genéricos en aplicaciones específicas

Las empresas han logrado resultados notables al adaptar los modelos de código abierto a sus necesidades específicas.

Ahora bien, si consideramos el rendimiento,

- Latencia: los modelos autoalojados pueden ofrecer tiempos de respuesta más bajos

- Personalización: Adapte los modelos de código abierto a sus requisitos exactos

- Coherencia: ChatGPT garantiza un rendimiento confiable en diversas tareas

El veredicto: ChatGPT ofrece un rendimiento de primer nivel desde el primer momento. Sin embargo, si tiene necesidades específicas y especializadas, un modelo de código abierto optimizado podría superarlo en su caso de uso particular.

Privacidad y control de datos

Hoy en día, la privacidad no es solo un lujo, es una necesidad. Examinemos cómo ChatGPT y los LLM alojados en servidores propios gestionan este aspecto crucial:

Manejo de datos de ChatGPT

- OpenAI tiene políticas de privacidad estrictas

- Los datos enviados a ChatGPT pueden usarse para mejorar el modelo

- Opción de no compartir datos, pero con posibles desventajas en el rendimiento

Si bien OpenAI está comprometido con la privacidad del usuario, enviar datos confidenciales a un tercero siempre conlleva algún riesgo. He visto empresas que dudan en usar ChatGPT para información confidencial.

Beneficios del LLM autohospedado

- Control total sobre sus datos

- Sin riesgo de exposición de datos externos

- Capacidad de implementar medidas de seguridad personalizadas

En mi experiencia, este nivel de control es un cambio radical para industrias como la atención médica o las finanzas, donde la privacidad de los datos es primordial.

He trabajado con empresas que eligieron el autohospedaje específicamente para cumplir estrictos requisitos de cumplimiento.

Factores clave de privacidad:

- Propiedad de los datos: con el autohospedaje, usted conserva la propiedad total de sus datos y modelos.

- Transparencia: Los modelos de código abierto le permiten inspeccionar y comprender el código.

- Personalización: Implemente funciones de privacidad adaptadas a sus necesidades específicas

El veredicto: si la privacidad de los datos es su máxima prioridad, alojar un LLM de código abierto en su propio servidor le ofrece un control sin igual. Sin embargo, las sólidas medidas de privacidad de ChatGPT pueden ser suficientes para aplicaciones menos sensibles.

Escalabilidad y flexibilidad

Exploremos cómo ChatGPT y los LLM autohospedados se comparan en términos de escalabilidad y flexibilidad.

Opciones de escalabilidad de ChatGPT

- Escalabilidad perfecta con mayor uso

- No requiere gestión de infraestructura

- La API permite una fácil integración en varias aplicaciones

Si hablamos de potencialidad de personalización, ChatGPT se limita a parámetros API e ingeniería rápida.

He visto a empresas escalar rápidamente sus capacidades de IA usando ChatGPT sin preocuparse por la logística interna. Es impresionantemente sencillo.

Flexibilidad de LLM autoalojado

- Control total sobre el tamaño y las capacidades del modelo

- Capacidad de escalar horizontalmente en múltiples máquinas

- Libertad para optimizar configuraciones de hardware específicas

Para una futura personalización, tendrás acceso completo a la arquitectura del modelo y podrás entrenar datos en un nivel avanzado.

En mis proyectos, este nivel de control ha sido invaluable para ajustar el rendimiento y la rentabilidad.

El veredicto: ChatGPT se destaca por su escalabilidad sin esfuerzo, lo que lo hace ideal para empresas con demandas fluctuantes. Sin embargo, el alojamiento propio ofrece una flexibilidad incomparable para quienes deseen administrar su propia infraestructura.

Consideraciones técnicas

Como llevo mucho tiempo trabajando con IA, puedo decirte que los aspectos técnicos son cruciales. Veamos lo que necesitas saber.

Para ChatGPT, necesitas una configuración mínima y OpenAI ya se encarga del resto.

Para alojar un modelo LLM por cuenta propia, es necesario comprender en profundidad el aprendizaje automático y el procesamiento del lenguaje natural. Lo mejor sería tener conocimientos sobre infraestructura en la nube o gestión de hardware no local. Además, también necesitará un amplio conocimiento en ajustes y optimización.

Muchas personas subestiman la experiencia necesaria, lo que genera contratiempos. No se trata solo de descargar un modelo, sino de implementarlo y mantenerlo de manera eficaz.

Factores técnicos clave:

- Latencia: los modelos autohospedados pueden ofrecer tiempos de respuesta más bajos si se optimizan correctamente

- Personalización: control total sobre la arquitectura del modelo y los datos de entrenamiento

- Depuración: es más fácil diagnosticar y solucionar problemas con modelos alojados internamente

El veredicto: ChatGPT es el claro ganador para quienes buscan una solución plug-and-play. Sin embargo, si tiene la experiencia técnica y el deseo de un control total, el alojamiento propio puede ofrecer una personalización incomparable y posibles beneficios de rendimiento.

Análisis de casos de uso

Como profesional de la IA, he visto varios escenarios en los que destacan distintas soluciones LLM. Exploremos algunos casos de uso del mundo real para orientar su decisión.

Suscripción a ChatGPT

Las pequeñas y medianas empresas suelen beneficiarse de la facilidad de uso de ChatGPT. Con recursos técnicos limitados y la necesidad de una implementación rápida, he visto a empresas emergentes crear prototipos de funciones de IA rápidamente, ahorrando meses de tiempo de desarrollo.

Los equipos de creación de contenido y marketing prosperan con las diversas capacidades lingüísticas de ChatGPT. Una agencia de marketing con la que trabajé lo utilizó para generar ideas para campañas y redactar publicaciones en redes sociales, lo que aumentó significativamente su productividad.

La automatización de la atención al cliente es otra área en la que ChatGPT se destaca. Su disponibilidad las 24 horas del día, los 7 días de la semana y su capacidad para gestionar consultas generales lo convierten en la opción preferida de muchas empresas a las que he asesorado.

LLM autoalojados

Las grandes empresas con grandes volúmenes suelen considerar que el alojamiento propio es más económico. Ayudé a una plataforma de comercio electrónico a cambiar a un modelo de alojamiento propio, lo que permitió reducir sus costos de inteligencia artificial en un 60 % en un año.

Las industrias altamente reguladas se benefician de las ofertas de alojamiento propio de control. Una empresa de tecnología financiera a la que asesoré eligió esta vía para garantizar el cumplimiento del RGPD y proteger los datos financieros confidenciales.

Las aplicaciones especializadas suelen requerir modelos personalizados. Trabajé con una startup de tecnología legal que perfeccionó un modelo de código abierto sobre documentos legales, superando a los modelos genéricos en el análisis de contratos.

Los factores clave incluyen el volumen de consultas, la confidencialidad de los datos, los recursos técnicos y las necesidades de personalización. Los volúmenes más altos y los datos más confidenciales suelen justificar el alojamiento propio, mientras que los recursos limitados favorecen a ChatGPT.

Conclusión

Después de sumergirme en el mundo de los LLM, queda claro que la elección entre ChatGPT y los modelos alojados por uno mismo no es tan clara como parece. Como entusiasta y profesional de la IA, he visto implementaciones exitosas de ambos enfoques.

ChatGPT destaca por su facilidad de uso, rendimiento constante y actualizaciones periódicas. Es una excelente opción para empresas que buscan una solución de inteligencia artificial rápida y sin complicaciones. El modelo de suscripción funciona bien para uso moderado y aplicaciones generales.

Por otro lado, el alojamiento propio ofrece un control, un potencial de personalización y una privacidad de datos incomparables. Es ideal para usuarios de gran volumen, aplicaciones especializadas e industrias con estrictas regulaciones de datos. La configuración inicial puede ser complicada, pero los beneficios a largo plazo pueden ser sustanciales.

Recuerde que esta no es una opción permanente. A medida que sus necesidades evolucionen y el panorama de la IA cambie, siempre podrá reevaluar y cambiar de enfoque.

En definitiva, la mejor opción es la que se adapta a sus objetivos, recursos y visión de la integración de la IA en su flujo de trabajo. Tanto si opta por la comodidad de ChatGPT como por el control del alojamiento propio, está entrando en un mundo apasionante de posibilidades impulsadas por la IA.