A medida que el mundo se vuelve cada vez más digital, la demanda de contenido de alta calidad nunca ha sido mayor. Afortunadamente, los avances en el procesamiento del lenguaje natural (PLN) han dado lugar a poderosas herramientas de escritura impulsadas por IA, como las desarrolladas por Hugging Face. Pero ¿qué pasa si necesitas utilizar estos modelos sin conexión? No temas, ya que exploraremos cómo aprovechar los modelos de Hugging Face sin una conexión a Internet.

El acceso sin conexión a los modelos de lenguaje de vanguardia de Hugging Face abre un mundo de posibilidades. Ya sea que trabaje en ubicaciones remotas, tenga una conexión a Internet poco confiable o simplemente priorice la privacidad de los datos, la capacidad de ejecutar estos modelos localmente puede cambiar las reglas del juego. Si comprende cómo implementar los modelos de Hugging Face sin conexión, puede desbloquear nuevos niveles de eficiencia, flexibilidad y control en su proceso de creación de contenido.

En esta publicación del blog, analizaremos en profundidad los pasos prácticos que puede seguir para aprovechar el poder de los modelos Hugging Face sin conexión. Desde la implementación del modelo hasta la integración perfecta con sus flujos de trabajo existentes, aprenderá a maximizar el potencial de estas herramientas avanzadas de PNL, incluso cuando no haya una conexión a Internet disponible. Prepárese para mejorar su capacidad de creación de contenido y mantenerse a la vanguardia en el mundo en constante evolución del marketing y la comunicación digitales.

¿Por qué podría querer utilizar el modelo Huggingface sin conexión?

Quizás te preguntes por qué alguien se molestaría en ejecutar modelos de IA sin conexión. Pero créeme, hay algunas razones muy convincentes para sacar tus modelos de Hugging Face de la red.

Create Amazing Websites

Con el mejor generador de páginas gratuito Elementor

Empezar ahoraA continuación se ofrece una explicación concisa de por qué alguien podría querer utilizar modelos de Hugging Face sin conexión:

El uso de modelos Hugging Face sin conexión ofrece varias ventajas clave:

- Confiabilidad: Trabaje sin interrupciones sin preocuparse por problemas de conectividad a Internet.

- Velocidad: elimine la latencia de la red para una inferencia de modelos más rápida.

- Privacidad: mantenga los datos confidenciales localmente, evitando posibles riesgos de seguridad del procesamiento en línea.

- Rentabilidad: reduzca los gastos de computación en la nube ejecutando modelos en su hardware.

- Portabilidad: utilice capacidades avanzadas de IA en ubicaciones remotas o áreas con acceso limitado a Internet.

- Aprendizaje: Obtenga una comprensión más profunda de la arquitectura y el funcionamiento de los modelos trabajando con ellos directamente.

- Personalización: ajuste y adapte modelos más fácilmente para casos de uso específicos cuando tenga acceso local.

Vamos a sumergirnos y explorar cómo aprovechar todo el potencial de los modelos Hugging Face, en cualquier momento y en cualquier lugar.

¿Cómo utilizar los modelos Huggingface sin conexión?

Huggingface es como un Github o una tienda de aplicaciones para IA de código abierto. Aquí, puedes buscar, descargar e incluso usar numerosos LLM de código abierto desde este sitio web. Además, al igual que ChatGPT, tienen Hugging Chat. Este chatbot te permite elegir un modelo que quieras usar y luego puedes entablar una conversación con él como lo harías con cualquier otro asistente de IA multimodelo.

¿Qué tan genial sería poder usar estos modelos completamente gratis, sin conexión y todos los días? Hagámoslo.

Estudio LM

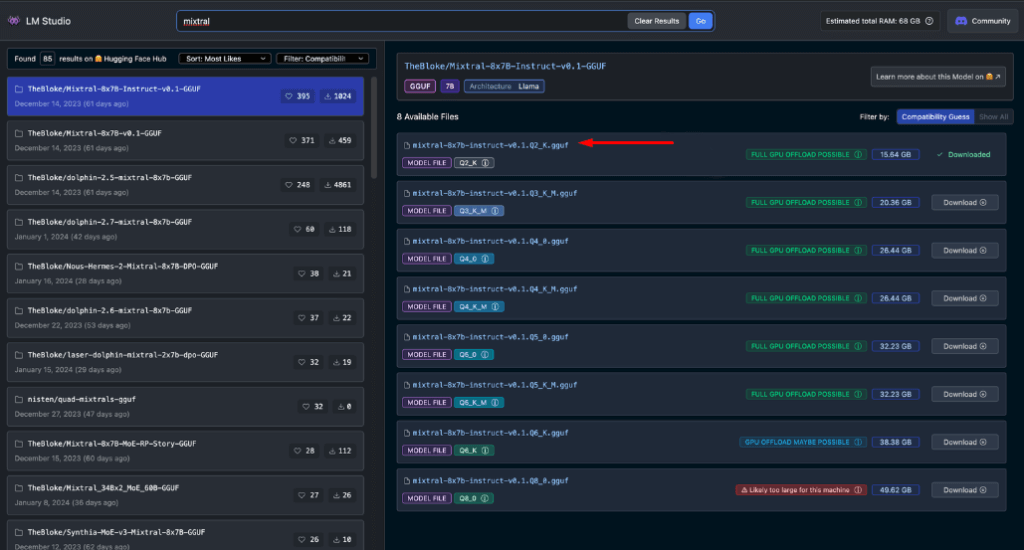

LM Studio está revolucionando la forma en que utilizamos los modelos de IA a nivel local. Esta aplicación versátil, disponible para Windows, Mac (Apple Silicon) y Linux (versión beta), permite a los usuarios descargar y ejecutar modelos de Hugging Face sin conexión con facilidad.

Las características principales de LM Studio incluyen:

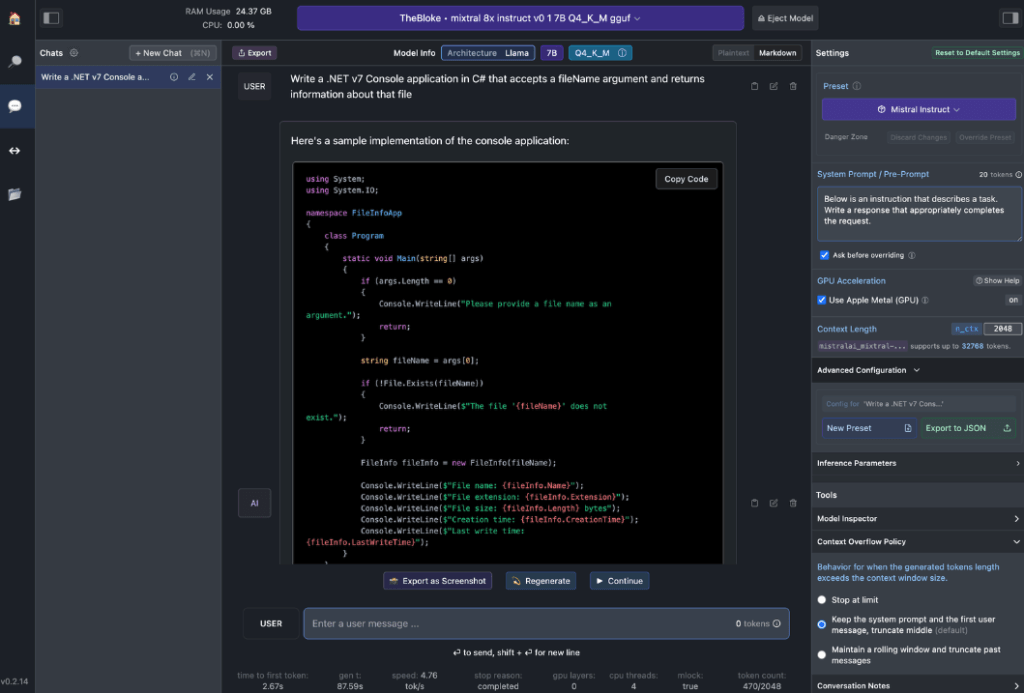

- Interacción con modelos locales: descargue su modelo de lenguaje (LLM) preferido e interactúe con él como lo haría con cualquier asistente de inteligencia artificial basado en chat. Personalice el rendimiento y el formato de salida, y explore funciones experimentales a través de varias opciones e indicaciones integradas en el sistema.

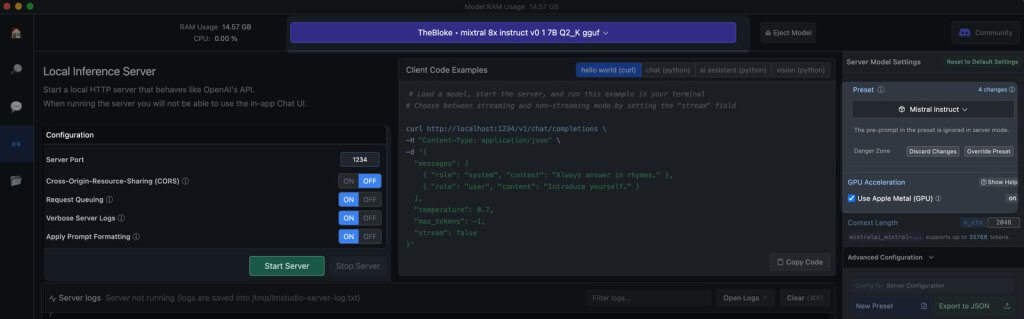

- Emulación de API de OpenAI: aquí es donde LM Studio realmente se destaca. Carga el modelo Hugging Face que descargaste y LM Studio lo envuelve ingeniosamente con un proxy de API local, imitando la API de OpenAI. Esta compatibilidad es un cambio radical, ya que permite una integración perfecta con numerosos SDK y extensiones populares de editores e IDE que ya son compatibles con OpenAI.

Requisitos de hardware de la estación de trabajo

Para aprovechar al máximo el potencial de los modelos Hugging Face sin conexión, necesitarás un hardware sólido. Si bien cualquier computadora moderna puede realizar tareas básicas, el rendimiento óptimo requiere especificaciones más potentes:

Para usuarios de Apple:

- Procesadores M2/M3 Max o Ultra

- Configuraciones de gama alta

- 50+ GB de RAM (compartidos con GPU en SoC M2)

- Soporte de metal para un mejor rendimiento.

Para usuarios de Windows:

- Más núcleos de CPU

- RAM sustancial

- GPU serie RTX 30 o 40 con abundante VRAM

No te preocupes si no tienes un sistema de primera categoría. Existen muchas opciones compatibles con RAM y VRAM, incluso entre los modelos más recientes. LM Studio calcula de forma útil las capacidades de tu sistema a medida que exploras y descargas modelos.

En general, los archivos de modelos más grandes y los requisitos de recursos más elevados se correlacionan con una mejor calidad de salida. Si bien es mejor no llevar el sistema al límite absoluto, no tema apuntar alto dentro de las capacidades de su hardware.

Recuerde: el objetivo es equilibrar el rendimiento del modelo con los recursos de su sistema para obtener la mejor experiencia de Hugging Face sin conexión.

Modelos recomendados para uso sin conexión

Al ejecutar modelos de Hugging Face sin conexión, es fundamental elegir el modelo adecuado. A través de pruebas exhaustivas, descubrí que los siguientes modelos ofrecen resultados consistentemente impresionantes tanto para tareas generales de chat como de codificación:

Cada uno de estos modelos ofrece un equilibrio único entre rendimiento y uso de recursos, lo que los convierte en excelentes opciones para la implementación sin conexión.

Antes de continuar, es esencial evaluar usted mismo estos modelos:

- Descarga cada modelo en LM Studio

- Utilice la pestaña de chat de IA para interactuar con el modelo

- Pruebe su rendimiento en varias tareas, especialmente codificación si ese es su enfoque.

- Evalúe la calidad de los resultados y qué tan bien se alinean con sus necesidades.

Recuerde que su experiencia puede variar según su caso de uso específico y las capacidades del hardware. Tómese el tiempo necesario para encontrar el modelo que mejor se adapte a sus necesidades. Este cuidadoso proceso de selección le garantizará que tendrá el modelo de Hugging Face sin conexión más eficaz para sus necesidades antes de pasar a la integración y al uso más avanzado.

Servidor local en LM Studio

Poner en marcha tu servidor de modelos Hugging Face sin conexión es muy sencillo:

- Abrir LM Studio

- Seleccione uno de sus modelos descargados

- Haga clic en el botón Iniciar servidor

¡Eso es todo! La configuración predeterminada suele ser adecuada para la mayoría de los usuarios. Sin embargo, si buscas mejorar tu experiencia, no dudes en ajustar las opciones para que se adapten a tus necesidades o preferencias específicas.

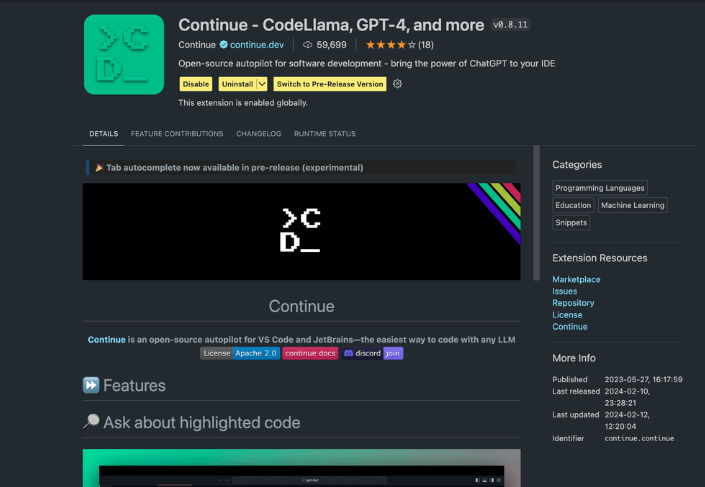

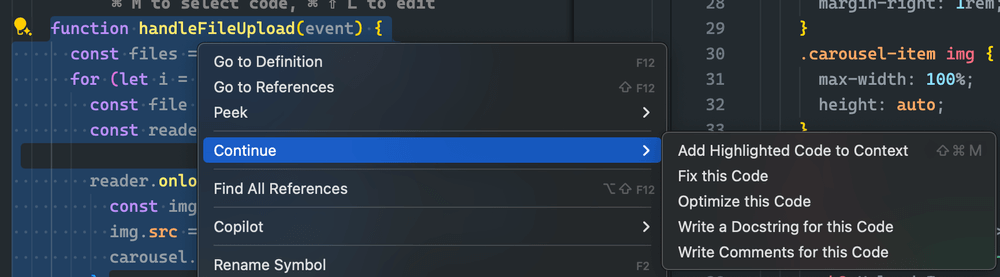

Uso de la extensión Continue

Desde el estudio de VS Code iniciado, dirígete a la vista de extensiones. En la barra de búsqueda, escribe "Continuar". Busca la extensión correcta e instálala.

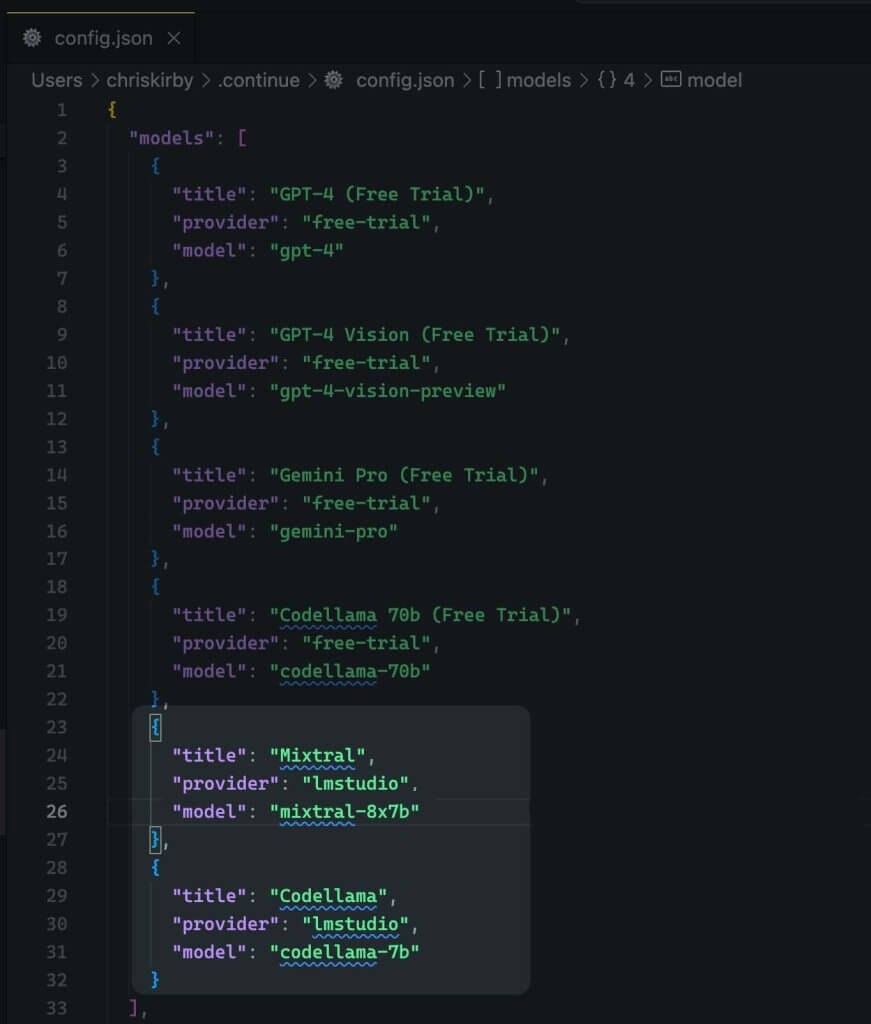

Ahora debemos cambiar la configuración JSON de la extensión. Esto agregará compatibilidad con LM Studio.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Ahora, guárdalo.

A continuación, debes utilizar este modelo local en lugar de VS Code.

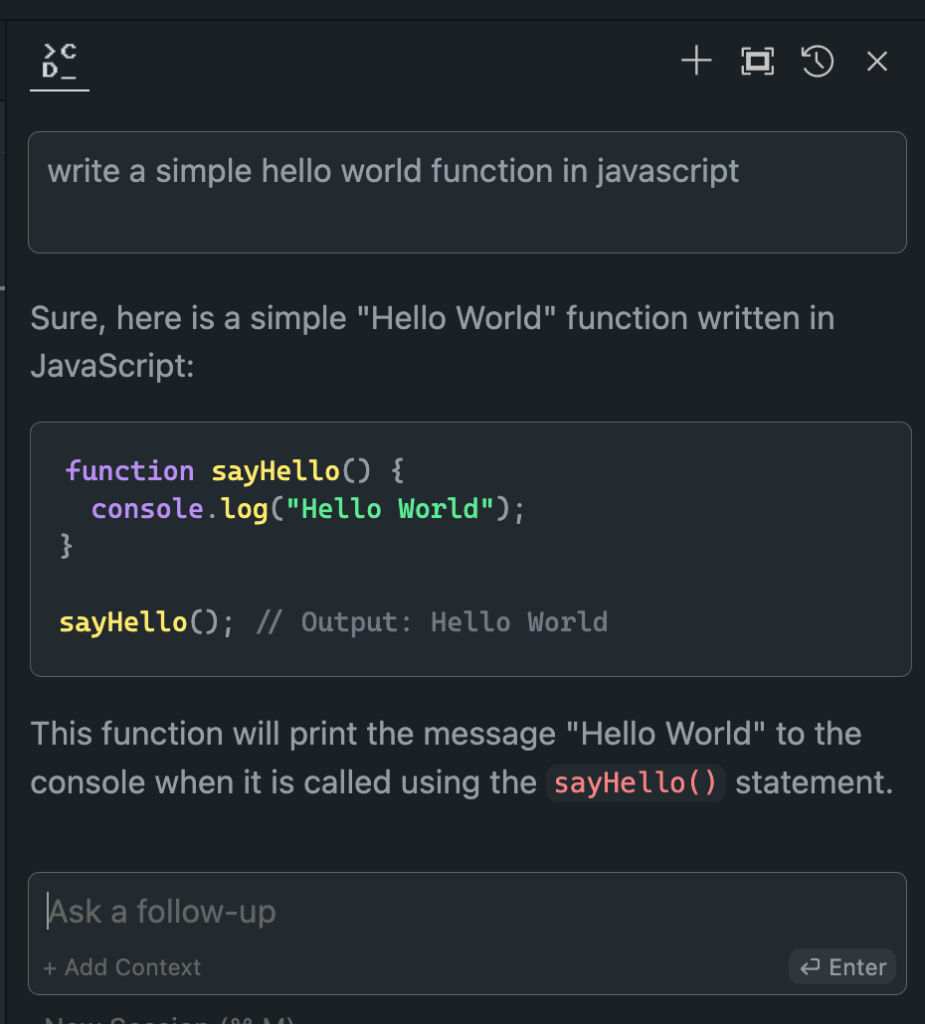

Evaluación del rendimiento del modelo offline y online

Ahora que hemos configurado nuestro modelo de Hugging Face offline, ha llegado el momento de la verdad. ¡Pongámoslo a prueba frente a sus homólogos online!

En mis extensos ensayos, los resultados han sido reveladores:

- Rendimiento: El modelo fuera de línea a menudo iguala y, en algunos casos, incluso supera a sus equivalentes en línea.

- Velocidad: Sin latencia de red, las respuestas pueden ser increíblemente rápidas.

- Consistencia: No más variabilidad debido a la carga del servidor o problemas de conexión.

Si bien la experiencia puede variar según el modelo y el hardware que elijas, no te sorprendas si prefieres la versión sin conexión. La combinación de potencia de procesamiento local y modelos optimizados puede ofrecer resultados impresionantes.

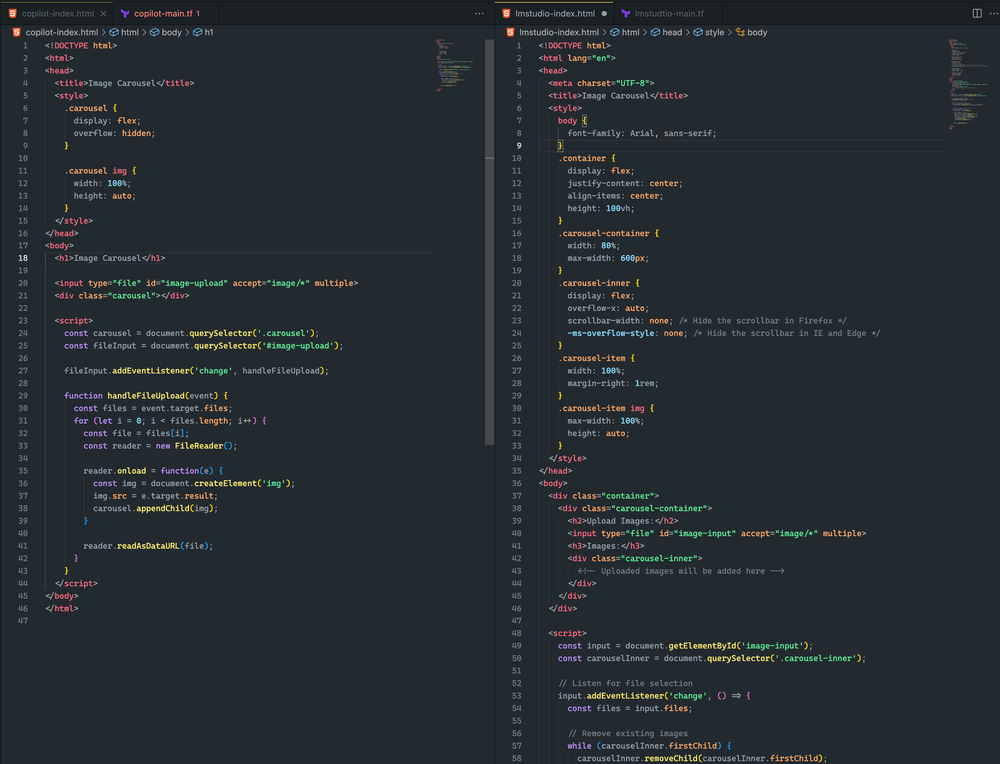

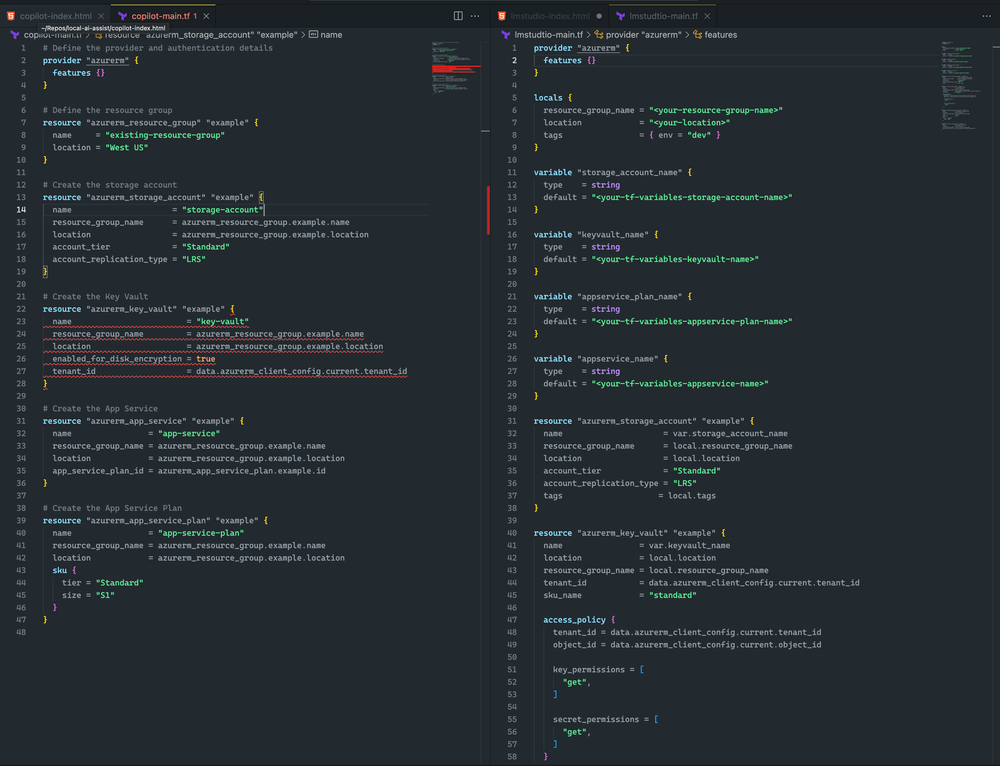

Aquí ve la diferencia.

Ambos enfoques fueron bastante similares. Aunque ninguno de ellos generó un carrusel de imágenes, cargué una imagen con éxito y se representó en ambos ejemplos. Con más ajustes rápidos, creo que puedo lograr un resultado aún mejor

Me inclino por LM Studio y Mixtral porque Terraform es más completo y no tiene errores de sintaxis. Sin embargo, CoPilot tiene un problema menor: en la declaración del almacén de claves falta el sku_name , que se puede solucionar fácilmente.

Terminando

Recuerde que el campo de la IA está evolucionando rápidamente. Si domina la implementación sin conexión de los modelos Hugging Face, no solo estará a la altura, sino que también se mantendrá a la vanguardia. Ya sea que sea un desarrollador, un investigador o un entusiasta de la IA, esta habilidad le permitirá superar los límites de lo que es posible con el procesamiento de IA local.

Así que, anímate. Experimenta con diferentes modelos, ajusta tu configuración e integra estas potentes herramientas offline en tu flujo de trabajo. Es posible que descubras que el futuro del desarrollo de IA está ahí mismo, en tu máquina local, esperando a que lo desatemos.