Als KI-Enthusiast habe ich den unglaublichen Aufstieg großer Sprachmodelle (LLMs) aus erster Hand miterlebt. Diese leistungsstarken KI-Tools haben die Art und Weise, wie wir mit Technologie interagieren, revolutioniert und sowohl Unternehmen als auch Einzelpersonen vor Dilemmata gestellt.

Sollten wir den Komfort von Abonnementdiensten nutzen oder die Kontrolle übernehmen, indem wir unsere Modelle hosten? Bei dieser Frage geht es nicht nur um Kosten – sie berührt auch Leistung, Datenschutz und Skalierbarkeit.

In diesem Blogbeitrag werde ich beide Optionen untersuchen und dabei auf meine Erfahrungen und die neuesten Branchentrends zurückgreifen, um Ihnen zu helfen, eine fundierte Entscheidung zu treffen, die Ihren spezifischen Anforderungen und Ressourcen entspricht.

LLM-Hosting vs. ChatGPT-Abonnement: Die Optionen verstehen

Lassen Sie uns unsere beiden führenden Konkurrenten im LLM-Bereich genauer betrachten.

Erstellen Sie erstaunliche Websites

Mit dem besten kostenlosen Seite Builder Elementor

Jetzt anfangenChatGPT-Abonnement

ChatGPT ist aus gutem Grund zu einem bekannten Namen geworden. Als Abonnent erhalten Sie:

- Zugriff auf modernste Sprachmodelle

- Regelmäßige Updates und Verbesserungen

- Eine benutzerfreundliche Oberfläche

- Robuste API zur Integration in verschiedene Anwendungen

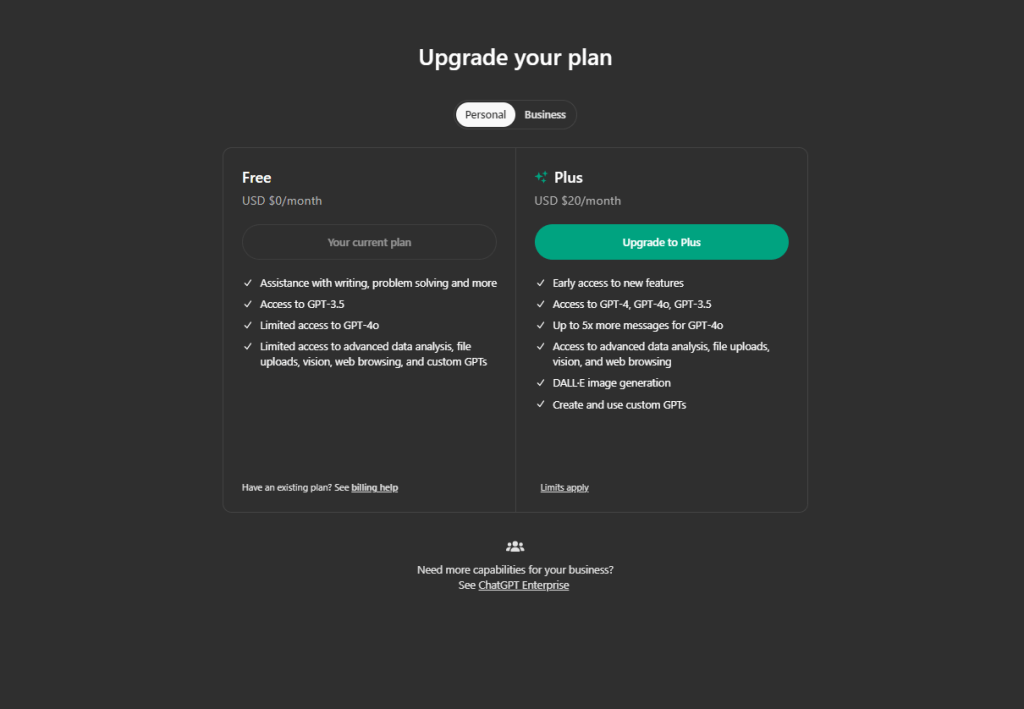

Die Preisgestaltung ist unkompliziert: Sie zahlen nutzungsabhängig. Für Gelegenheitsnutzer oder kleine Unternehmen kann dies recht kostengünstig sein.

Selbst gehostete Open-Source-LLMs

Auf der anderen Seite gibt es den DIY-Ansatz. Beliebte Open-Source-Modelle wie LLaMA und GPT-NeoX bieten:

- Volle Kontrolle über Ihr Modell

- Anpassungsoptionen

- Datenschutz

- Potenzial für Kosteneinsparungen im großen Maßstab

Ihnen stehen hier zwei Hauptbereitstellungsoptionen zur Verfügung:

a) Cloud-Hosting (AWS, Google Cloud, Azure)

b) Hardware vor Ort

Jeder Weg hat seine Vor- und Nachteile, die wir im weiteren Verlauf ausführlich untersuchen werden.

Die Wahl zwischen diesen Optionen ist nicht immer eindeutig. Sie hängt von Ihren spezifischen Bedürfnissen, Ressourcen und langfristigen Zielen ab. In den folgenden Abschnitten werde ich Sie durch die wichtigsten zu berücksichtigenden Faktoren führen und Ihnen dabei helfen, die beste Entscheidung für Ihre individuelle Situation zu treffen.

Kostenvergleich

Bei LLMs sind die Kosten oft ein entscheidender Faktor. Lassen Sie uns die Zahlen aufschlüsseln.

ChatGPT-Abonnement

Wenn wir ChatGPT verwenden, kostet das Abonnement:

- Derzeit berechnet OpenAI 0,002 $ pro 1.000 Token.

- Zum Vergleich: 1.000 Token entsprechen ungefähr 750 Wörtern.

- Ein typischer Tag mit 5.000 Abfragen könnte etwa 6,50$ kosten.

- Das sind etwa 200 $ pro Monat bei mäßiger Nutzung.

Klingt vernünftig, oder? Aber hier ist der Haken: Bei intensiver Nutzung können die Kosten in die Höhe schnellen. Ihre monatliche Rechnung kann schnell ins Unermessliche steigen, wenn Sie täglich Tausende von Abfragen bearbeiten.

Selbst gehostete Open Source LLMs

Wenn Sie Ihr eigenes, selbstgehostetes LLM erstellen möchten, fallen folgende Kosten an:

- Hardware: Eine High-End-GPU wie eine NVIDIA RTX 3090 kostet etwa 700 $.

- Cloud-Hosting: AWS kann für 1 Million Anfragen täglich etwa 150 bis 160 US-Dollar kosten.

- Vergessen Sie den Strom nicht: Bei 0,12 $/kWh summiert sich der Dauerbetrieb einer leistungsstarken GPU rund um die Uhr.

- Arbeitskosten: Sie benötigen Fachwissen, um Ihr System einzurichten und zu warten.

Die Ersteinrichtung beim Self-Hosting ist teurer, kann sich aber bei längerer Nutzung mit hohem Volumen als kostengünstiger erweisen.

Zu berücksichtigende versteckte Kosten:

- Zeit: Die Einrichtung eines selbstgehosteten Systems erfolgt nicht sofort.

- Upgrades: Die Technologie entwickelt sich in der KI-Welt schnell weiter.

- Ausfallzeiten: Bei selbst gehosteten Systemen kann es häufiger zu Unterbrechungen kommen.

Das Urteil: Das Abonnementmodell von ChatGPT ist für Benutzer mit geringem Volumen oft kostengünstiger. Wenn Sie jedoch Millionen von monatlichen Abfragen haben, können Sie durch Self-Hosting auf lange Sicht Geld sparen.

Leistung und Qualität

Wenn es um LLMs geht, ist Leistung das Wichtigste. Sehen wir uns an, wie ChatGPT und Open-Source-Modelle abschneiden:

Die Funktionen von ChatGPT

- Durchgängig qualitativ hochwertige Antworten

- Breite Wissensbasis zu vielfältigen Themen

- Regelmäßige Updates verbessern die Leistung

- Fähigkeit, komplexe Anfragen und Aufgaben zu bearbeiten

Besonders beeindruckend fand ich ChatGPT beim kreativen Schreiben und bei Problemlösungsszenarien. Seine Antworten wirken oft menschlich und kontextbezogen angemessen.

Open-Source-LLM-Leistung

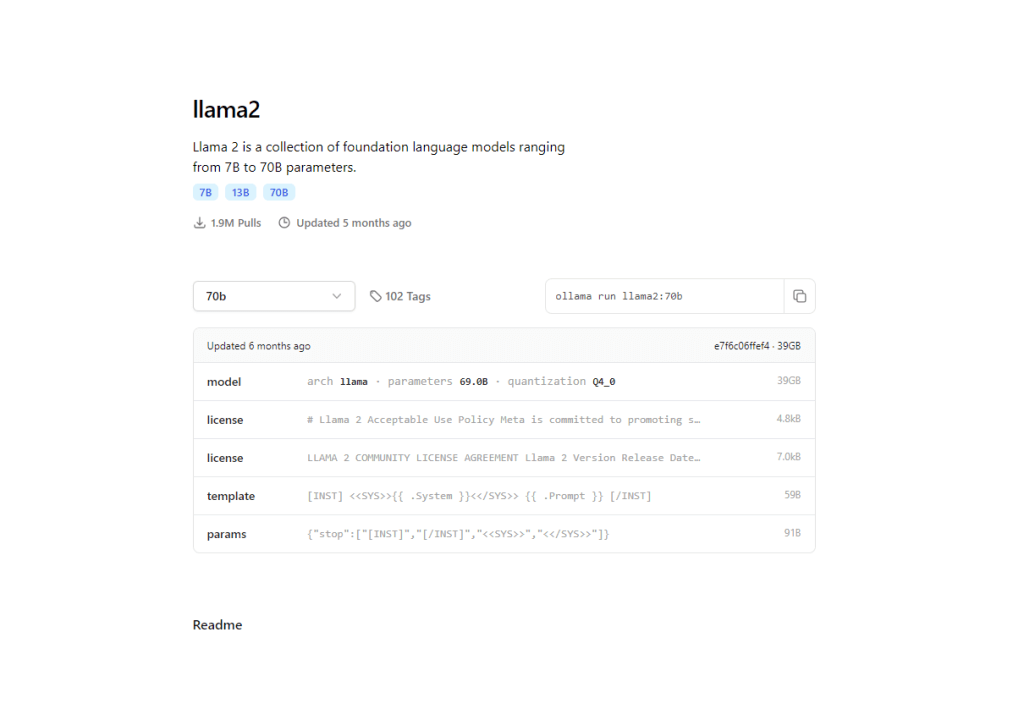

- Modelle wie LLaMA 2 holen schnell auf

- Einige spezialisierte Modelle übertreffen ChatGPT in bestimmten Bereichen

- Individualisierungspotenzial zur aufgabenspezifischen Optimierung

Meiner Erfahrung nach können aktuelle Open-Source-Modelle wie LLaMA 2 70B bei bestimmten Aufgaben mit GPT-3.5 mithalten oder es sogar übertreffen. Die Lücke wird schnell kleiner.

Hier sind Open-Source-Modelle von Vorteil. Mit Self-Hosting können Sie:

- Trainieren Sie mit domänenspezifischen Daten

- Für bestimmte Aufgaben optimieren

- Potenziell bessere Leistung als generische Modelle in Nischenanwendungen

Unternehmen haben durch die Feinabstimmung von Open-Source-Modellen auf ihre spezifischen Anforderungen bemerkenswerte Ergebnisse erzielt.

Wenn wir nun die Leistung betrachten,

- Latenz: Selbstgehostete Modelle bieten möglicherweise kürzere Reaktionszeiten

- Anpassung: Passen Sie Open-Source-Modelle genau an Ihre Anforderungen an

- Konsistenz: ChatGPT gewährleistet zuverlässige Leistung bei verschiedenen Aufgaben

Das Urteil: ChatGPT bietet sofort einsatzbereite Spitzenleistung. Wenn Sie jedoch spezielle, spezialisierte Anforderungen haben, könnte ein fein abgestimmtes Open-Source-Modell in Ihrem speziellen Anwendungsfall möglicherweise die Leistung übertreffen.

Datenschutz und Kontrolle

Heutzutage ist Privatsphäre nicht nur ein Luxus, sondern eine Notwendigkeit. Sehen wir uns an, wie ChatGPT und selbstgehostete LLMs mit diesem wichtigen Aspekt umgehen:

Datenverarbeitung durch ChatGPT

- OpenAI hat strenge Datenschutzrichtlinien

- An ChatGPT gesendete Daten können zur Modellverbesserung verwendet werden

- Möglichkeit, der Datenfreigabe zu widersprechen, allerdings mit möglichen Leistungseinbußen

Obwohl OpenAI sich für die Privatsphäre seiner Benutzer einsetzt, birgt das Senden vertraulicher Daten an Dritte immer ein gewisses Risiko. Ich habe erlebt, dass Unternehmen zögern, ChatGPT für vertrauliche Informationen zu verwenden.

Vorteile eines Self-Hosting-LLM

- Vollständige Kontrolle über Ihre Daten

- Kein Risiko einer externen Datenfreigabe

- Möglichkeit zur Implementierung benutzerdefinierter Sicherheitsmaßnahmen

Meiner Erfahrung nach ist dieses Maß an Kontrolle ein entscheidender Faktor für Branchen wie das Gesundheits- oder Finanzwesen, in denen der Datenschutz von größter Bedeutung ist.

Ich habe mit Unternehmen zusammengearbeitet, die sich speziell für Self-Hosting entschieden haben, um strenge Compliance-Anforderungen zu erfüllen.

Wichtige Datenschutzfaktoren:

- Dateneigentum: Beim Self-Hosting behalten Sie das volle Eigentum an Ihren Daten und Modellen

- Transparenz: Open-Source-Modelle ermöglichen es Ihnen, den Code zu prüfen und zu verstehen

- Anpassung: Implementieren Sie Datenschutzfunktionen, die auf Ihre spezifischen Bedürfnisse zugeschnitten sind

Das Urteil: Wenn Datenschutz Ihre oberste Priorität ist, bietet Ihnen das Self-Hosting eines Open-Source-LLM beispiellose Kontrolle. Für weniger sensible Anwendungen können die robusten Datenschutzmaßnahmen von ChatGPT jedoch ausreichend sein.

Skalierbarkeit und Flexibilität

Lassen Sie uns untersuchen, wie ChatGPT und selbstgehostete LLMs im Hinblick auf Skalierbarkeit und Flexibilität abschneiden.

Skalierbarkeitsoptionen von ChatGPT

- Nahtlose Skalierung bei zunehmender Nutzung

- Kein Infrastrukturmanagement erforderlich

- API ermöglicht einfache Integration in verschiedene Anwendungen

Wenn wir über Anpassungsmöglichkeiten sprechen, ist ChatGPT auf API-Parameter und Prompt-Engineering beschränkt.

Ich habe gesehen, wie Unternehmen ihre KI-Fähigkeiten mit ChatGPT schnell skalierten, ohne sich um die Backend-Logistik kümmern zu müssen. Es ist beeindruckend unkompliziert.

Flexibilität beim selbstgehosteten LLM

- Vollständige Kontrolle über Modellgröße und Funktionen

- Möglichkeit zur horizontalen Skalierung über mehrere Maschinen hinweg

- Freiheit zur Optimierung für bestimmte Hardwarekonfigurationen

Für zukünftige Anpassungen haben Sie vollen Zugriff auf die Modellarchitektur und können Daten auf einem fortgeschrittenen Niveau trainieren.

In meinen Projekten war dieses Maß an Kontrolle für die Feinabstimmung von Leistung und Kosteneffizienz von unschätzbarem Wert.

Das Urteil: ChatGPT zeichnet sich durch mühelose Skalierbarkeit aus und ist daher ideal für Unternehmen mit schwankenden Anforderungen. Selbsthosting bietet jedoch beispiellose Flexibilität für diejenigen, die bereit sind, ihre eigene Infrastruktur zu verwalten.

Technische Überlegungen

Da ich schon lange mit KI arbeite, kann ich Ihnen sagen, dass die technischen Aspekte entscheidend sind. Lassen Sie uns aufschlüsseln, was Sie wissen müssen.

Für ChatGPT benötigen Sie eine minimale Einrichtung und OpenAI kümmert sich bereits um den Rest.

Um ein LLM-Modell selbst zu hosten, müssen Sie sich gut mit maschinellem Lernen und natürlicher Sprachverarbeitung auskennen. Am besten verfügen Sie über Kenntnisse in Cloud-Infrastrukturen oder der Verwaltung externer Hardware. Darüber hinaus benötigen Sie umfassende Kenntnisse in Feinabstimmung und Optimierung.

Viele Leute unterschätzen das erforderliche Fachwissen, was zu Rückschlägen führt. Es geht nicht nur darum, ein Modell herunterzuladen, sondern auch darum, es effektiv bereitzustellen und zu warten.

Wichtige technische Faktoren:

- Latenz: Selbstgehostete Modelle können bei richtiger Optimierung kürzere Reaktionszeiten bieten

- Anpassung: Volle Kontrolle über Modellarchitektur und Trainingsdaten

- Debuggen: Einfachere Diagnose und Behebung von Problemen mit selbstgehosteten Modellen

Das Urteil: ChatGPT ist der klare Gewinner für alle, die eine Plug-and-Play-Lösung suchen. Wenn Sie jedoch über das technische Know-how und den Wunsch nach voller Kontrolle verfügen, kann Self-Hosting beispiellose Anpassungsmöglichkeiten und potenzielle Leistungsvorteile bieten.

Anwendungsfallanalyse

Als KI-Experte habe ich verschiedene Szenarien erlebt, in denen unterschiedliche LLM-Lösungen glänzen. Lassen Sie uns einige Anwendungsfälle aus der Praxis untersuchen, um Ihnen bei der Entscheidung zu helfen.

ChatGPT-Abonnement

Kleine und mittlere Unternehmen profitieren häufig von der Benutzerfreundlichkeit von ChatGPT. Angesichts begrenzter technischer Ressourcen und der Notwendigkeit einer schnellen Bereitstellung habe ich Startups dabei beobachtet, wie sie KI-Funktionen schnell als Prototyp entwickelten und so Monate an Entwicklungszeit sparten.

Content-Erstellungs- und Marketingteams profitieren von den vielfältigen Sprachfunktionen von ChatGPT. Eine Marketingagentur, mit der ich zusammengearbeitet habe, nutzte es zum Brainstorming von Kampagnenideen und zum Verfassen von Social-Media-Posts und steigerte so ihre Produktivität erheblich.

Die Automatisierung des Kundensupports ist ein weiterer Bereich, in dem ChatGPT hervorsticht. Seine 24/7-Verfügbarkeit und die Fähigkeit, allgemeine Anfragen zu bearbeiten, machen es zur ersten Wahl für viele Unternehmen, die ich beraten habe.

Selbst gehostete LLMs

Für große Unternehmen mit hohem Volumen ist Self-Hosting oft wirtschaftlicher. Ich habe einer E-Commerce-Plattform geholfen, auf ein Self-Hosting-Modell umzusteigen und so ihre KI-Kosten innerhalb eines Jahres um 60 % zu senken.

Stark regulierte Branchen profitieren von der Kontrolle, die Self-Hosting bietet. Ein von mir beratenes Fintech-Unternehmen hat sich für diesen Weg entschieden, um die Einhaltung der DSGVO sicherzustellen und sensible Finanzdaten zu schützen.

Spezialisierte Domänenanwendungen erfordern häufig benutzerdefinierte Modelle. Ich habe mit einem Legal-Tech-Startup zusammengearbeitet, das ein Open-Source-Modell für juristische Dokumente optimiert hat und bei der Vertragsanalyse generische Modelle übertrifft.

Zu den Schlüsselfaktoren gehören Abfragevolumen, Datensensibilität, technische Ressourcen und Anpassungsbedarf. Höhere Volumina und sensiblere Daten rechtfertigen oft das Self-Hosting, während begrenzte Ressourcen für ChatGPT sprechen.

Abschluss

Nachdem ich tief in die Welt der LLMs eingetaucht bin, ist klar, dass die Wahl zwischen ChatGPT und selbstgehosteten Modellen nicht schwarz und weiß ist. Als KI-Enthusiast und -Profi habe ich erfolgreiche Implementierungen beider Ansätze gesehen.

ChatGPT glänzt durch seine Benutzerfreundlichkeit, konstante Leistung und regelmäßige Updates. Es ist eine ausgezeichnete Wahl für Unternehmen, die nach einer schnellen, unkomplizierten KI-Lösung suchen. Das Abonnementmodell eignet sich gut für moderate Nutzung und allgemeine Anwendungen.

Self-Hosting hingegen bietet beispiellose Kontrolle, Anpassungspotenzial und Datenschutz. Es ist ideal für Großnutzer, spezialisierte Anwendungen und Branchen mit strengen Datenschutzbestimmungen. Die anfängliche Einrichtung kann eine Herausforderung sein, aber die langfristigen Vorteile können beträchtlich sein.

Denken Sie daran, dass dies keine endgültige Entscheidung ist. Wenn sich Ihre Anforderungen weiterentwickeln und sich die KI-Landschaft verändert, können Sie die Ansätze jederzeit neu bewerten und ändern.

Letztendlich ist die beste Wahl diejenige, die Ihren Zielen, Ressourcen und Ihrer Vision für die KI-Integration in Ihren Workflow entspricht. Egal, ob Sie sich für den Komfort von ChatGPT oder die Kontrolle des Self-Hostings entscheiden, Sie betreten eine aufregende Welt KI-gestützter Möglichkeiten.