Da die Welt immer digitaler wird, war die Nachfrage nach qualitativ hochwertigen Inhalten nie größer. Glücklicherweise haben Fortschritte in der Verarbeitung natürlicher Sprache (NLP) zu leistungsstarken KI-gesteuerten Schreibwerkzeugen geführt, wie sie beispielsweise von Hugging Face entwickelt wurden. Aber was, wenn Sie diese Modelle offline nutzen müssen? Keine Angst, wir werden untersuchen, wie Sie Hugging Face-Modelle auch ohne Internetverbindung nutzen können.

Der Offline-Zugriff auf die hochmodernen Sprachmodelle von Hugging Face eröffnet eine Welt voller Möglichkeiten. Egal, ob Sie an abgelegenen Standorten arbeiten, mit unzuverlässiger Internetverbindung zu kämpfen haben oder einfach nur Datenschutz priorisieren, die Möglichkeit, diese Modelle lokal auszuführen, kann bahnbrechend sein. Wenn Sie verstehen, wie Sie Hugging Face-Modelle offline bereitstellen, können Sie bei der Erstellung Ihres Inhalts neue Ebenen der Effizienz, Flexibilität und Kontrolle erreichen.

In diesem Blogbeitrag gehen wir auf die praktischen Schritte ein, mit denen Sie die Leistungsfähigkeit von Hugging Face-Modellen offline nutzen können. Von der Modellbereitstellung bis zur nahtlosen Integration in Ihre vorhandenen Arbeitsabläufe erfahren Sie, wie Sie das Potenzial dieser fortschrittlichen NLP-Tools maximieren können, selbst wenn keine Internetverbindung verfügbar ist. Machen Sie sich bereit, Ihre Content-Erstellung auf ein neues Niveau zu heben und in der sich ständig weiterentwickelnden Welt des digitalen Marketings und der digitalen Kommunikation immer einen Schritt voraus zu sein.

Warum möchten Sie das Huggingface-Modell möglicherweise offline verwenden?

Sie fragen sich vielleicht, warum sich jemand die Mühe machen sollte, KI-Modelle offline auszuführen. Aber glauben Sie mir, es gibt einige wirklich überzeugende Gründe, Ihre Hugging Face-Modelle vom Netz zu nehmen.

Erstellen Sie erstaunliche Websites

Mit dem besten kostenlosen Seite Builder Elementor

Jetzt anfangenHier ist eine kurze Erklärung, warum jemand Hugging Face-Modelle offline verwenden möchte:

Die Offline-Verwendung von Hugging Face-Modellen bietet mehrere wichtige Vorteile:

- Zuverlässigkeit: Arbeiten Sie ohne Unterbrechung, ohne sich über Probleme mit der Internetverbindung Gedanken machen zu müssen.

- Geschwindigkeit: Eliminieren Sie die Netzwerklatenz für eine schnellere Modellinferenz.

- Datenschutz: Bewahren Sie vertrauliche Daten lokal auf und vermeiden Sie potenzielle Sicherheitsrisiken bei der Online-Verarbeitung.

- Kosteneffizienz: Reduzieren Sie die Kosten für Cloud Computing, indem Sie Modelle auf Ihrer Hardware ausführen.

- Portabilität: Nutzen Sie erweiterte KI-Funktionen an abgelegenen Standorten oder Gebieten mit eingeschränktem Internetzugang.

- Lernen: Erlangen Sie ein tieferes Verständnis der Modellarchitektur und -funktionalität, indem Sie direkt mit ihnen arbeiten.

- Anpassung: Wenn Sie über lokalen Zugriff verfügen, können Sie Modelle einfacher für bestimmte Anwendungsfälle optimieren und anpassen.

Lassen Sie uns eintauchen und erkunden, wie Sie das volle Potenzial von Hugging Face-Modellen jederzeit und überall nutzen können.

Wie verwende ich Huggingface-Modelle offline?

Huggingface ist wie ein Github oder App Store für Open-Source-KI. Hier können Sie zahlreiche Open-Source-LLMs von dieser Website durchsuchen, herunterladen und sogar verwenden. Darüber hinaus haben sie genau wie ChatGPT Hugging Chat. Mit diesem Chatbot können Sie ein Modell auswählen, das Sie verwenden möchten, und später können Sie damit Gespräche führen, wie Sie es mit jedem anderen KI-Assistenten mit mehreren Modellen tun würden.

Wie toll wäre es, diese Modelle täglich völlig kostenlos und offline zu nutzen? Lass es uns tun.

LM Studio

LM Studio revolutioniert die Art und Weise, wie wir KI-Modelle lokal nutzen. Diese vielseitige App, die für Windows, Mac (Apple Silicon) und Linux (Beta) verfügbar ist, ermöglicht es Benutzern, Hugging Face-Modelle problemlos herunterzuladen und offline auszuführen.

Zu den Hauptfunktionen von LM Studio gehören:

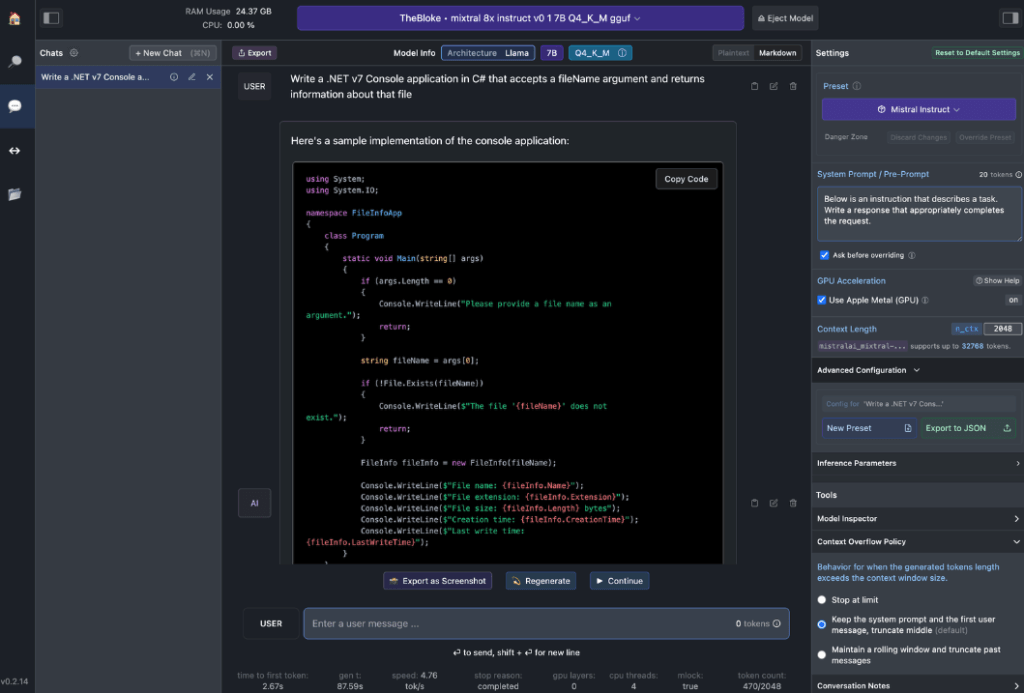

- Lokale Modellinteraktion: Laden Sie Ihr bevorzugtes Sprachmodell (LLM) herunter und interagieren Sie damit wie mit jedem chatbasierten KI-Assistenten. Passen Sie Leistung und Ausgabeformat an und erkunden Sie experimentelle Funktionen über verschiedene integrierte Systemaufforderungen und Optionen.

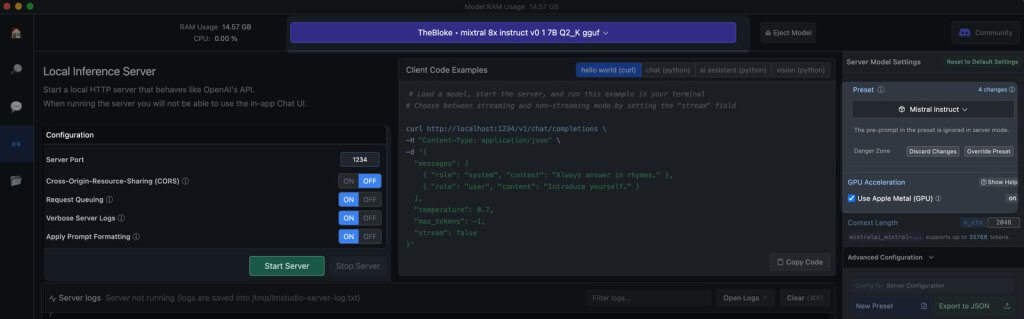

- OpenAI API-Emulation: Hier kann LM Studio wirklich glänzen. Laden Sie Ihr heruntergeladenes Hugging Face-Modell und LM Studio legt auf raffinierte Weise einen lokalen API-Proxy darum, der die OpenAI API nachahmt. Diese Kompatibilität ist bahnbrechend, da sie eine nahtlose Integration mit zahlreichen SDKs und beliebten Editor- und IDE-Erweiterungen ermöglicht, die OpenAI bereits unterstützen.

Hardwareanforderungen für Arbeitsstationen

Um das Potenzial von Offline-Hugging-Face-Modellen voll auszuschöpfen, benötigen Sie robuste Hardware. Zwar kann jeder moderne Computer grundlegende Aufgaben bewältigen, für optimale Leistung sind jedoch leistungsstärkere Spezifikationen erforderlich:

Für Apple-Benutzer:

- M2/M3 Max- oder Ultra-Prozessoren

- High-End-Konfigurationen

- 50+ GB RAM (gemeinsam mit GPU auf M2-SoC)

- Metallhalterung für verbesserte Leistung

Für Windows-Benutzer:

- Mehr Kern-CPU

- Viel RAM

- GPU der RTX 30- oder 40-Serie mit reichlich VRAM

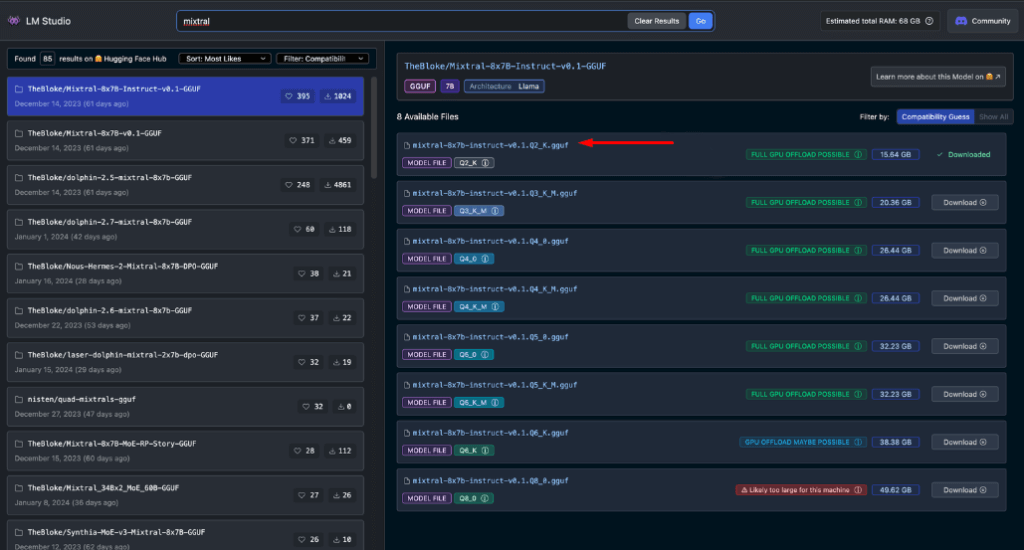

Machen Sie sich keine Sorgen, wenn Sie kein erstklassiges System haben. Selbst unter den neuesten Modellen gibt es viele RAM- und VRAM-freundliche Optionen. LM Studio schätzt die Leistungsfähigkeit Ihres Systems hilfreich ein, während Sie Modelle durchsuchen und herunterladen.

Im Allgemeinen führen größere Modelldateien und ein höherer Ressourcenbedarf zu einer verbesserten Ausgabequalität. Auch wenn Sie Ihr System nicht bis an seine absoluten Grenzen bringen sollten, scheuen Sie sich nicht, im Rahmen der Möglichkeiten Ihrer Hardware hohe Ziele zu verfolgen.

Denken Sie daran: Das Ziel besteht darin, die Modellleistung mit den Ressourcen Ihres Systems in Einklang zu bringen, um das beste Offline-Hugging-Face-Erlebnis zu erzielen.

Empfohlene Modelle für die Offline-Nutzung

Wenn Sie Hugging Face-Modelle offline ausführen, ist die Auswahl des richtigen Modells entscheidend. Durch umfangreiche Tests habe ich festgestellt, dass die folgenden Modelle sowohl für allgemeine Chat- als auch für Codierungsaufgaben durchweg beeindruckende Ergebnisse liefern:

Jedes dieser Modelle bietet ein einzigartiges Gleichgewicht zwischen Leistung und Ressourcennutzung und ist daher eine ausgezeichnete Wahl für die Offlinebereitstellung.

Bevor Sie fortfahren, müssen Sie diese Modelle unbedingt selbst bewerten:

- Laden Sie jedes Modell in LM Studio herunter

- Verwenden Sie die Registerkarte „KI-Chat“, um mit dem Modell zu interagieren

- Testen Sie die Leistung bei verschiedenen Aufgaben, insbesondere beim Codieren, wenn dies Ihr Schwerpunkt ist

- Bewerten Sie die Qualität der Ergebnisse und wie gut diese Ihren Anforderungen entsprechen

Denken Sie daran, dass Ihre Erfahrung je nach Ihrem spezifischen Anwendungsfall und den Hardwarefunktionen unterschiedlich sein kann. Nehmen Sie sich Zeit, um das Modell zu finden, das Ihren Anforderungen am besten entspricht. Dieser sorgfältige Auswahlprozess stellt sicher, dass Sie das effektivste Offline-Hugging-Face-Modell für Ihre Anforderungen haben, bevor Sie mit der Integration und fortgeschritteneren Nutzung fortfahren.

Lokaler Server in LM Studio

Das Starten Ihres Offline-Hugging-Face-Modellservers ist ganz einfach:

- LM Studio öffnen

- Wählen Sie eines Ihrer heruntergeladenen Modelle aus

- Klicken Sie auf die Schaltfläche Server starten

Das ist alles! Die Standardeinstellungen sind im Allgemeinen für die meisten Benutzer geeignet. Wenn Sie Ihr Erlebnis jedoch verfeinern möchten, können Sie die Optionen gerne an Ihre spezifischen Bedürfnisse oder Vorlieben anpassen.

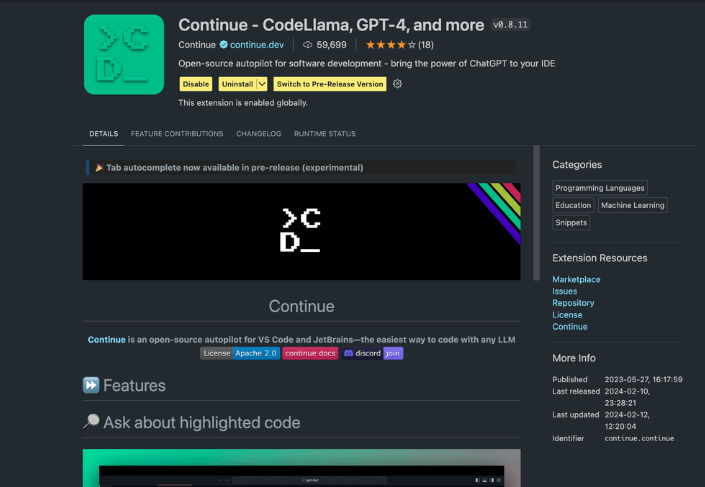

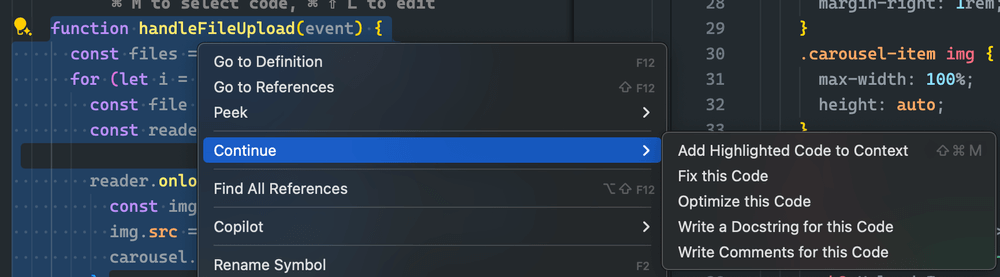

Verwenden der Continue-Erweiterung

Navigieren Sie im gestarteten VS Code Studio zur Erweiterungsansicht. Geben Sie in der Suchleiste „Weiter“ ein. Suchen Sie die richtige Erweiterung und installieren Sie sie.

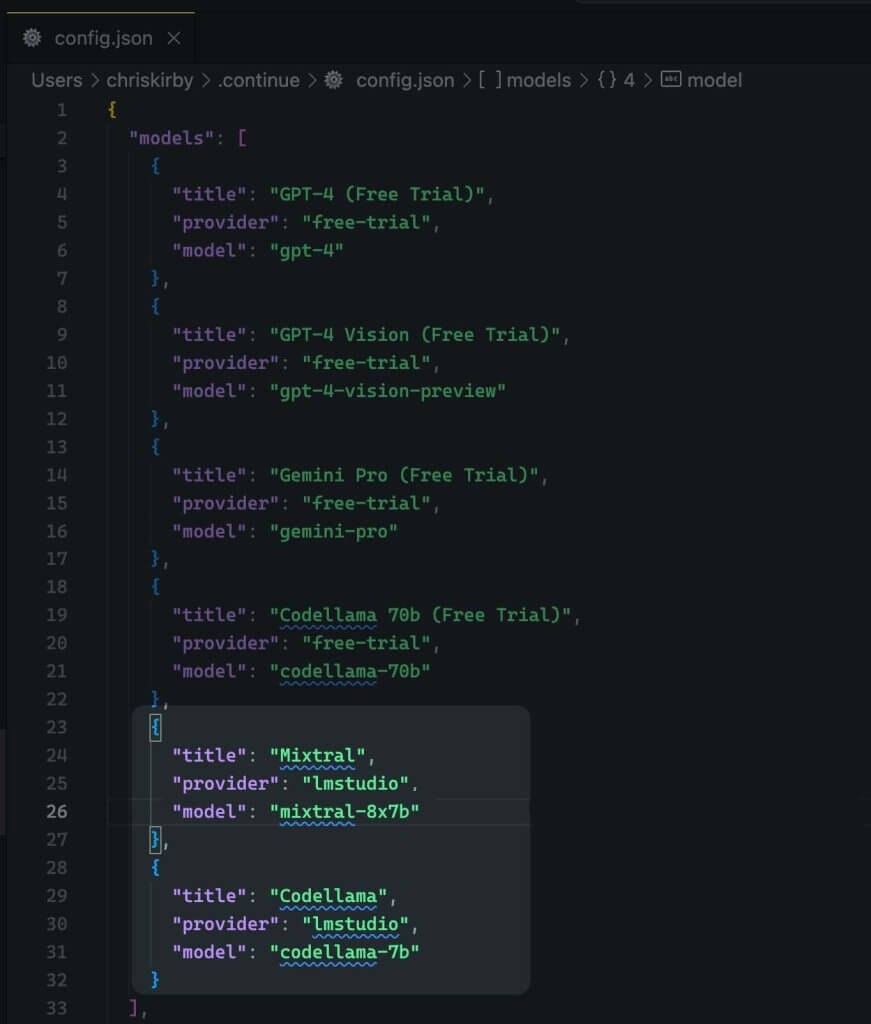

Jetzt müssen wir das Konfigurations-JSON der Erweiterung ändern. Dadurch wird die LM Studio-Unterstützung hinzugefügt.

{

"title": "Mixtral",

"provider": "lmstudio",

"model": "mixtral-8x7b"

}

Speichern Sie es jetzt.

Als Nächstes müssen Sie dieses lokale Modell anstelle von VS-Code verwenden.

Bewertung der Offline- und Online-Modellleistung

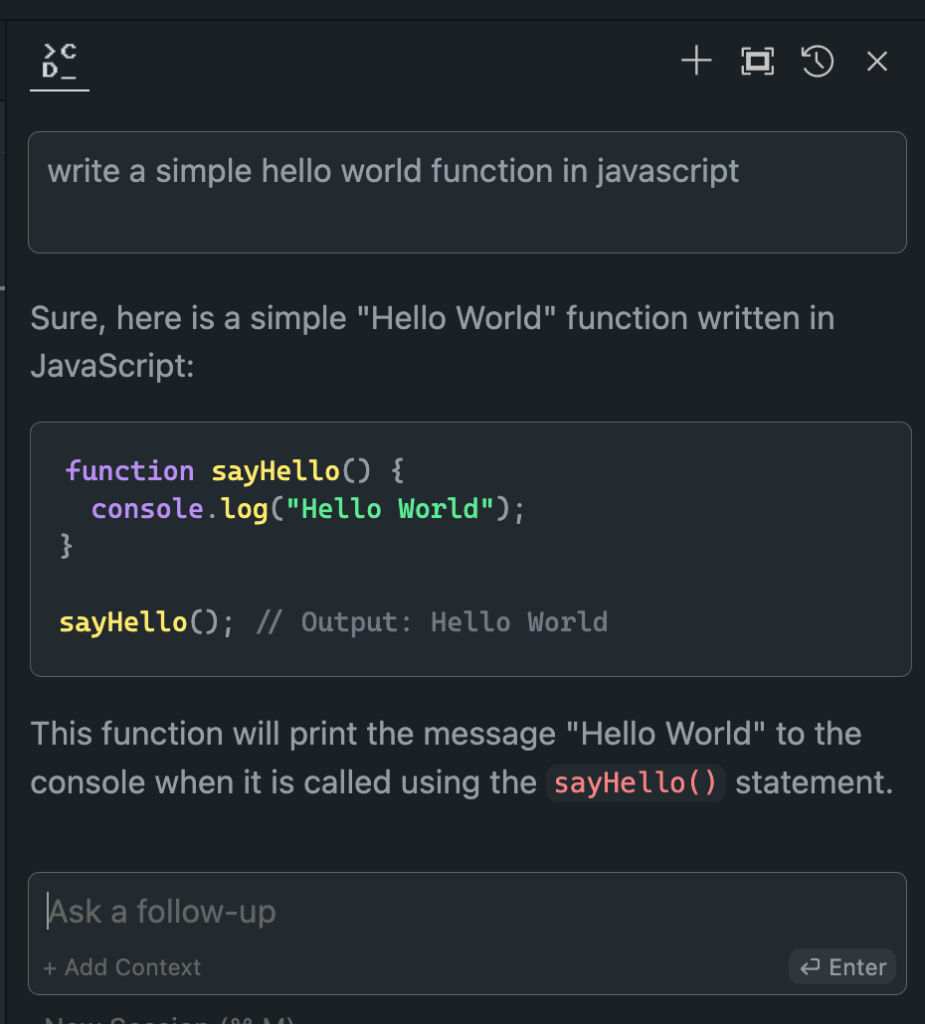

Nachdem wir nun unser Offline-Hugging-Face-Modell eingerichtet haben, ist es Zeit für den Moment der Wahrheit. Lassen Sie es uns im Vergleich zu seinen Online-Gegenstücken testen!

Die Ergebnisse meiner umfangreichen Versuche waren augenöffnend:

- Leistung: Das Offline-Modell ist seinen Online-Äquivalenten oft ebenbürtig und übertrifft sie in manchen Fällen sogar.

- Geschwindigkeit: Ohne Netzwerklatenz können Antworten blitzschnell erfolgen.

- Konsistenz: Keine Variabilität mehr aufgrund von Serverlast oder Verbindungsproblemen.

Auch wenn Ihre Erfahrung je nach gewähltem Modell und Hardware unterschiedlich ausfallen kann, seien Sie nicht überrascht, wenn Sie die Offline-Version bevorzugen. Die Kombination aus lokaler Verarbeitungsleistung und fein abgestimmten Modellen kann beeindruckende Ergebnisse liefern.

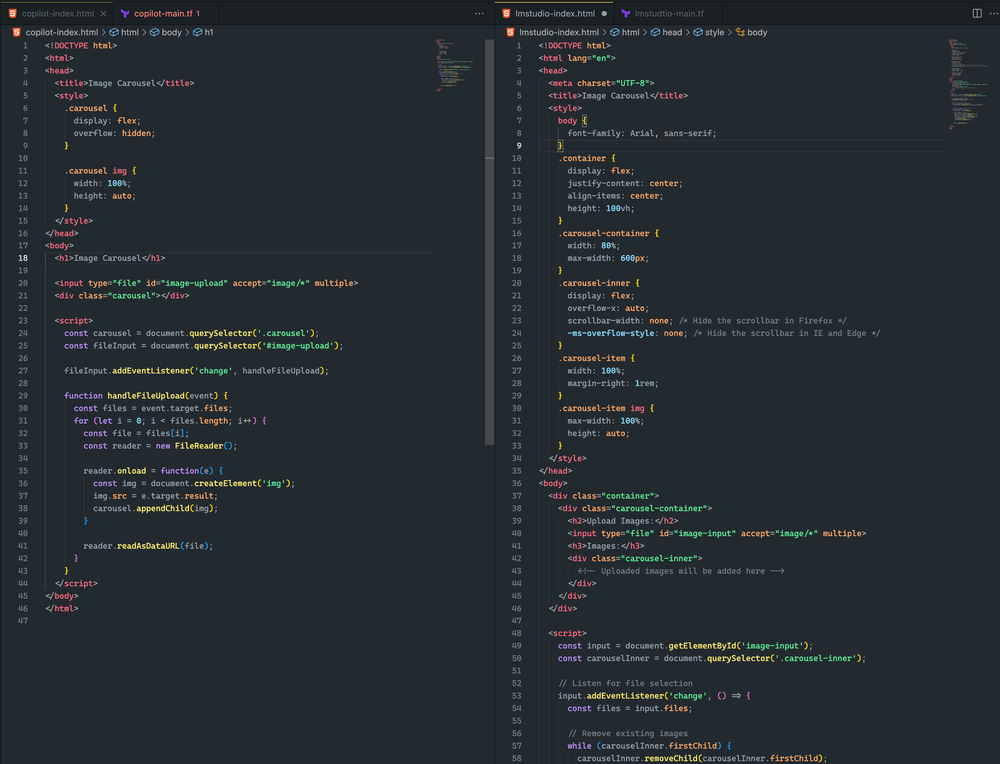

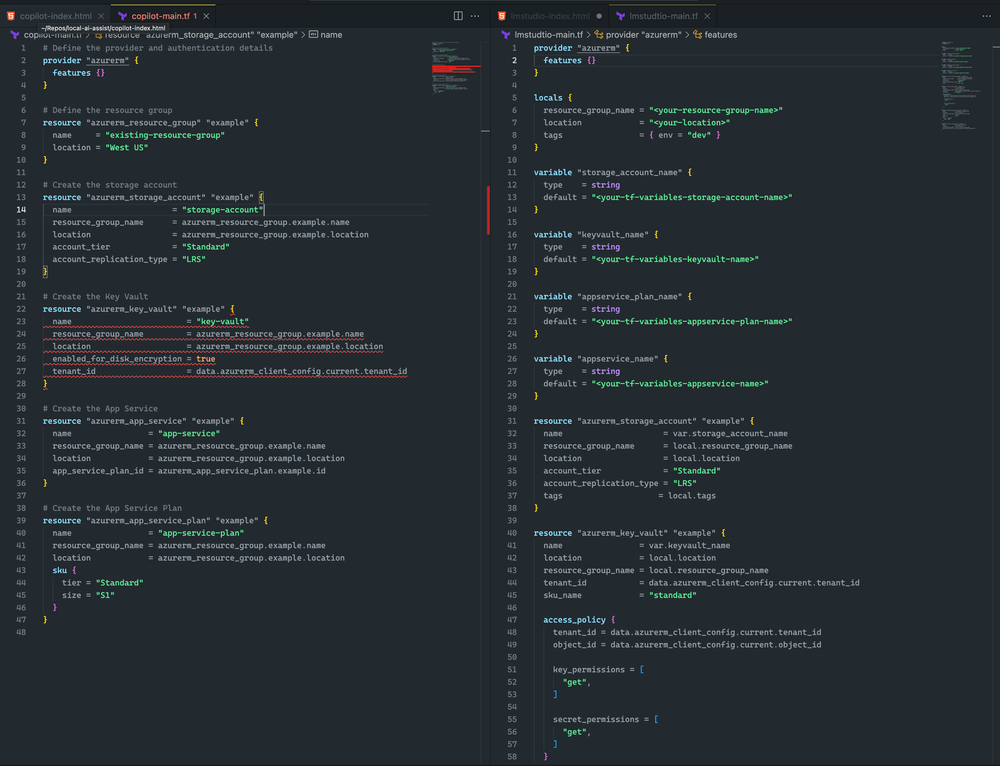

Hier sehen Sie den Unterschied.

Beide Ansätze waren ziemlich ähnlich. Obwohl keiner von beiden zu einem Bildkarussell führte, konnte ich erfolgreich ein Bild hochladen und es wurde in beiden Beispielen gerendert. Mit weiteren zeitnahen Anpassungen glaube ich, dass ich ein noch besseres Ergebnis erzielen kann

Ich tendiere zu LM Studio und Mixtral, da Terraform vollständiger ist und keine Syntaxfehler aufweist. CoPilot hat jedoch ein kleines Problem: In der Key Vault-Deklaration fehlt der sku_name , was leicht behoben werden kann.

Einpacken

Denken Sie daran, dass sich der Bereich der KI rasant weiterentwickelt. Wenn Sie die Offline-Bereitstellung von Hugging Face-Modellen beherrschen, halten Sie nicht nur Schritt, sondern sind auch immer einen Schritt voraus. Egal, ob Sie Entwickler, Forscher oder KI-Enthusiast sind, mit dieser Fähigkeit können Sie die Grenzen dessen erweitern, was mit lokaler KI-Verarbeitung möglich ist.

Also, wagen Sie den Sprung. Experimentieren Sie mit verschiedenen Modellen, optimieren Sie Ihr Setup und integrieren Sie diese Offline-Kraftpakete in Ihren Workflow. Vielleicht entdecken Sie, dass die Zukunft der KI-Entwicklung direkt auf Ihrem lokalen Rechner liegt und nur darauf wartet, entfesselt zu werden.