Hugging Face ist eine wahre Goldgrube für alle, die sich mit natürlicher Sprachverarbeitung beschäftigen. Es enthält eine Vielzahl vorab trainierter Sprachmodelle, die sich in verschiedenen Anwendungen ganz einfach verwenden lassen. Wenn es um Large Language Models (LLMs) geht, ist Hugging Face die erste Wahl. In diesem Artikel tauchen wir in die 10 wichtigsten LLMs zu Hugging Face ein, von denen jedes eine entscheidende Rolle dabei spielt, unser Verständnis und unsere Sprachgenerierung zu verbessern.

Lass uns anfangen!

Was ist das Large Language Model?

Large Language Models (LLMs) sind fortgeschrittene Formen künstlicher Intelligenz, die darauf ausgelegt sind, menschliche Sprache zu verstehen und zu generieren. Sie werden mithilfe von Deep-Learning-Techniken erstellt, insbesondere einer Art neuronalem Netzwerk, das als Transformer bezeichnet wird.

Hier ist eine Aufschlüsselung zur Verdeutlichung:

- Training mit riesigen Datenmengen : LLMs werden mit riesigen Datensätzen trainiert, die Bücher, Artikel, Websites und mehr umfassen. Dieses umfangreiche Training hilft ihnen, die Nuancen der Sprache zu lernen, einschließlich Grammatik, Kontext und sogar ein gewisses Maß an Argumentation.

- Transformatoren : Die Architektur hinter den meisten LLMs wird als Transformator bezeichnet. Dieses Modell verwendet Aufmerksamkeitsmechanismen, um die Wichtigkeit verschiedener Wörter in einem Satz abzuwägen, wodurch es den Kontext besser verstehen kann als frühere Modelle.

- Von ihnen ausgeführte Aufgaben : Nach der Ausbildung können LLMs verschiedene Sprachaufgaben ausführen. Dazu gehören das Beantworten von Fragen, das Zusammenfassen von Texten, das Übersetzen von Sprachen, das Erstellen kreativer Texte und das Codieren.

- Beliebte Modelle : Einige bekannte LLMs sind GPT-3, BERT und T5. Diese vorab trainierten Modelle können für bestimmte Aufgaben feinabgestimmt werden, was sie zu vielseitigen Werkzeugen für Entwickler und Forscher macht.

- Anwendungen : LLMs werden in Chatbots, virtuellen Assistenten, der automatisierten Inhaltserstellung und vielem mehr verwendet. Sie tragen dazu bei, die Interaktion des Benutzers mit der Technologie zu verbessern, indem sie Maschinen dafür sorgen, die menschliche Sprache natürlicher zu verstehen und darauf zu reagieren.

Im Wesentlichen sind Large Language Models wie aufgeladene Gehirne für Computer, die es ihnen ermöglichen, die menschliche Sprache mit beeindruckender Genauigkeit und Vielseitigkeit zu verarbeiten und zu generieren.

HuggingFace und LLM

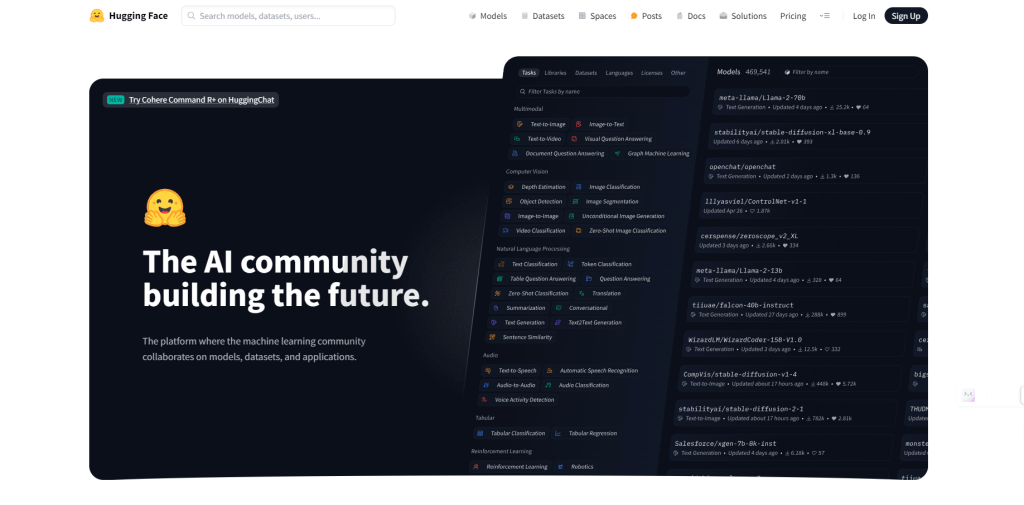

Hugging Face ist ein Unternehmen und eine Plattform, die sich zu einem Zentrum für die Verarbeitung natürlicher Sprache (NLP) und maschinelles Lernen entwickelt hat. Das Unternehmen stellt Tools, Bibliotheken und Ressourcen bereit, um Entwicklern und Forschern die Erstellung und Verwendung von Modellen für maschinelles Lernen zu erleichtern, insbesondere im Zusammenhang mit Sprachverständnis und -generierung.

Hugging Face ist für seine Open-Source-Bibliotheken bekannt, insbesondere Transformers , die einen einfachen Zugriff auf eine breite Palette vortrainierter Sprachmodelle bieten.

Hugging Face hostet viele hochmoderne LLMs wie GPT-3, BERT und T5. Diese Modelle sind auf riesigen Datensätzen vortrainiert und können für verschiedene Anwendungen verwendet werden.

Die Plattform bietet einfache APIs und Tools zur Integration dieser Modelle in Anwendungen, ohne dass umfassende Fachkenntnisse im maschinellen Lernen erforderlich sind.

Mit den Tools von Hugging Face können Sie diese vortrainierten LLMs problemlos anhand Ihrer eigenen Daten optimieren und sie so an bestimmte Aufgaben oder Domänen anpassen.

Forscher und Entwickler können ihre Modelle und Verbesserungen auf der Hugging Face-Plattform teilen und so Innovation und Anwendung in NLP beschleunigen.

Top 5 LLM-Modelle auf Huggingface, die Sie verwenden sollten

Lassen Sie uns einige der Top-LLM-Modelle auf Hugging Face erkunden, die beim Geschichtenerzählen herausragend sind und sogar GPT übertreffen.

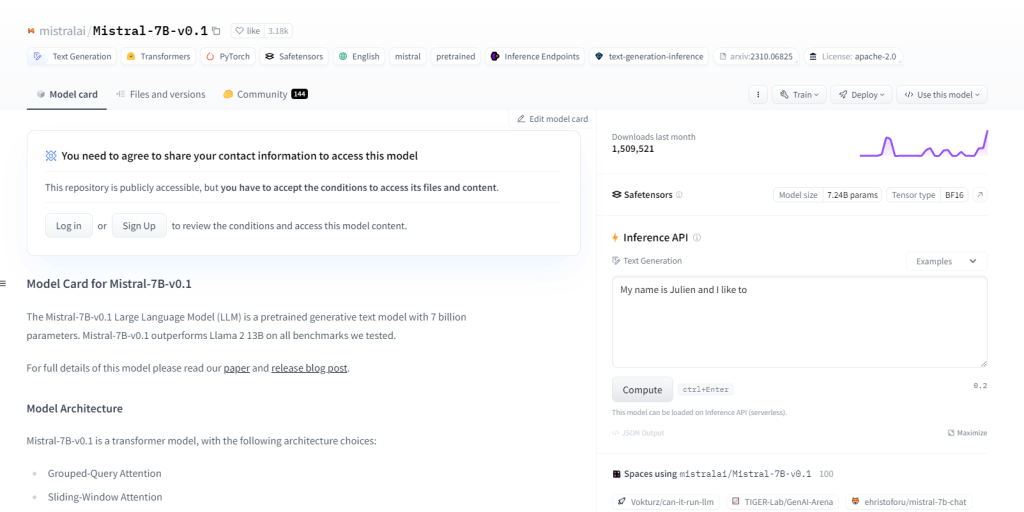

Mistral-7B-v0.1

Mistral-7B-v0.1, ein Large Language Model (LLM) mit 7 Milliarden Parametern, übertrifft Benchmarks wie Llama 2 13B in allen Domänen. Es nutzt eine Transformer-Architektur mit spezifischen Aufmerksamkeitsmechanismen und einem Byte-Fallback-BPE-Tokenizer. Es zeichnet sich durch Textgenerierung, natürliches Sprachverständnis und Sprachübersetzung aus und dient als Basismodell für Forschung und Entwicklung in NLP-Projekten.

Hauptmerkmale

- 7 Milliarden Parameter

- Übertrifft Benchmarks wie Llama 213B

- Transformatorarchitektur

- BPE-Tokenizer

- NLP-Projektentwicklung

- Natürliches Sprachverständnis

- Sprachübersetzung

- Aufmerksamkeit bei gruppierten Abfragen

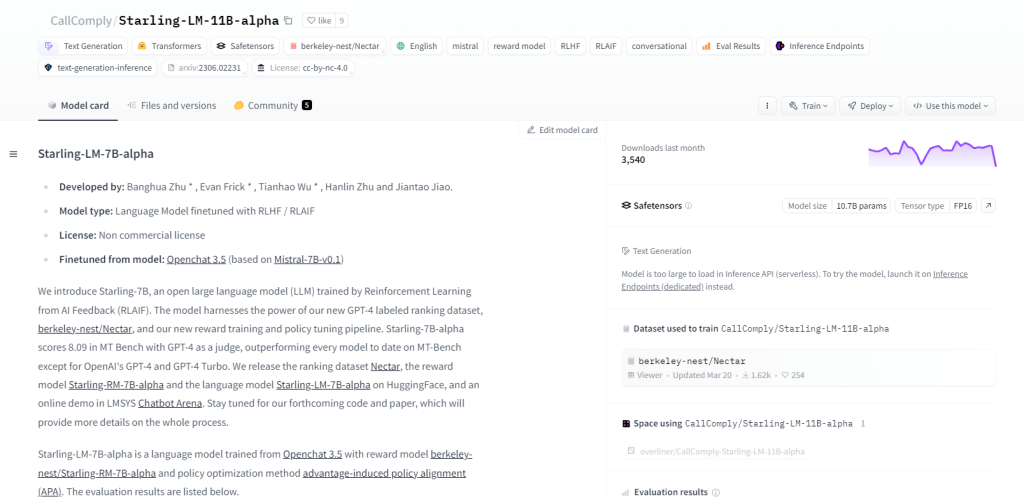

Starling-LM-11B-alpha

Starling-LM-11B-alpha, ein großes Sprachmodell (LLM) mit 11 Milliarden Parametern, stammt von NurtureAI und nutzt das OpenChat 3.5-Modell als Grundlage. Die Feinabstimmung erfolgt durch Reinforcement Learning from AI Feedback (RLAIF), geleitet von von Menschen erstellten Rankings. Dieses Modell verspricht mit seinem Open-Source-Framework und seinen vielseitigen Anwendungen, darunter NLP-Aufgaben, maschinelles Lernen, Bildung und die Erstellung kreativer Inhalte, eine Neugestaltung der Mensch-Maschine-Interaktion.

Hauptmerkmale

- 11 Milliarden Parameter

- Entwickelt von NurtureAI

- Basierend auf dem OpenChat 3.5-Modell

- Feinabstimmung durch RLAIF

- Von Menschen beschriftete Rankings für das Training

- Open-Source-Charakter

- Vielfältige Fähigkeiten

- Verwendung für Forschung, Bildung und kreative Inhaltserstellung

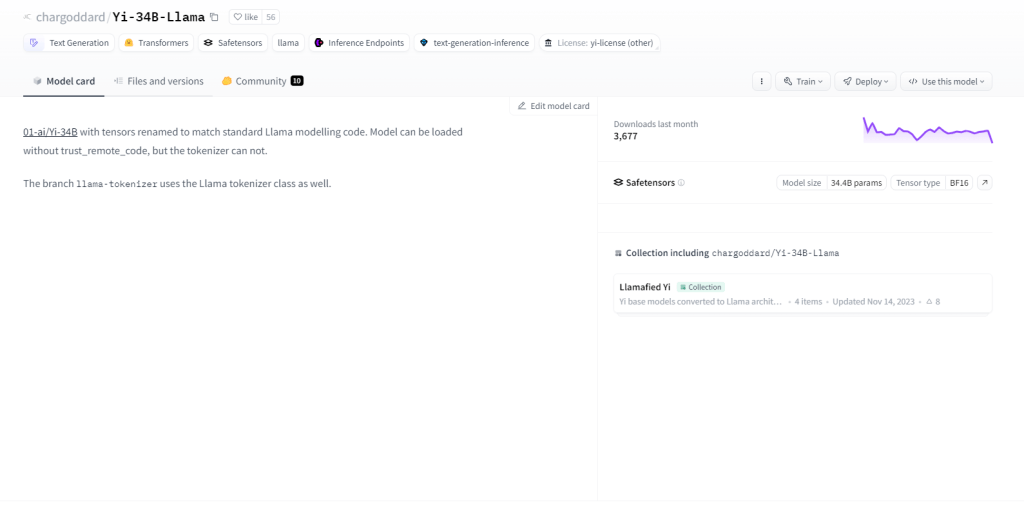

Yi-34B-Lama

Yi-34B-Llama weist mit seinen 34 Milliarden Parametern eine überragende Lernfähigkeit auf. Es zeichnet sich durch multimodale Verarbeitung aus und verarbeitet Text, Code und Bilder effizient. Dank Zero-Shot-Learning passt es sich nahtlos an neue Aufgaben an. Seine zustandsorientierte Natur ermöglicht es ihm, sich an vergangene Interaktionen zu erinnern und so die Benutzereinbindung zu verbessern. Zu den Anwendungsfällen gehören Textgenerierung, maschinelle Übersetzung, Beantwortung von Fragen, Dialog, Codegenerierung und Bildunterschriften.

Hauptmerkmale

- 34 Milliarden Parameter

- Multimodale Verarbeitung

- Zero-Shot-Lernfähigkeit

- Zustandsbehaftete Natur

- Textgenerierung

- Maschinenübersetzung

- Fragen beantworten

- Bildbeschriftung

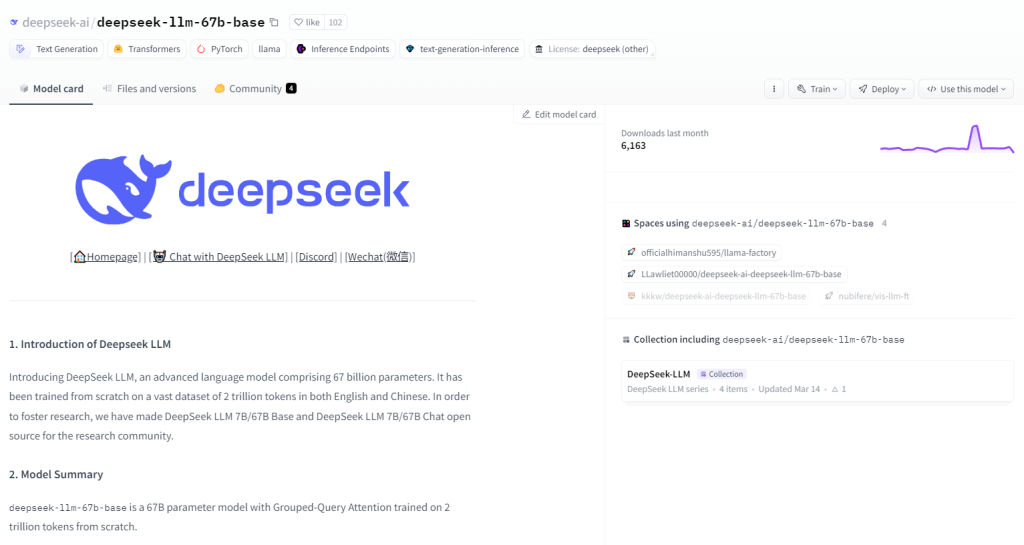

DeepSeek LLM 67B Basis

DeepSeek LLM 67B Base, ein 67 Milliarden Parameter umfassendes Large Language Model (LLM), glänzt bei Schlussfolgerungs-, Codierungs- und Mathematikaufgaben. Mit außergewöhnlichen Ergebnissen, die GPT-3.5 und Llama2 70B Base übertreffen, zeichnet es sich durch Codeverständnis und -generierung aus und weist bemerkenswerte mathematische Fähigkeiten auf. Sein Open-Source-Charakter unter der MIT-Lizenz ermöglicht freie Erkundung. Anwendungsfälle umfassen Programmierung, Bildung, Forschung, Inhaltserstellung, Übersetzung und Fragenbeantwortung.

Hauptmerkmale

- 67-Milliarden-Parameter

- Außergewöhnliche Leistung in den Bereichen Argumentation, Codierung und Mathematik

- HumanEval Pass@1-Ergebnis von 73,78

- Hervorragendes Codeverständnis und -generierung

- Hohe Punktzahlen bei GSM8K 0-shot (84,1)

- Übertrifft GPT-3.5 in den Sprachfähigkeiten

- Open Source unter der MIT-Lizenz

- Hervorragende Fähigkeiten zum Geschichtenerzählen und Erstellen von Inhalten.

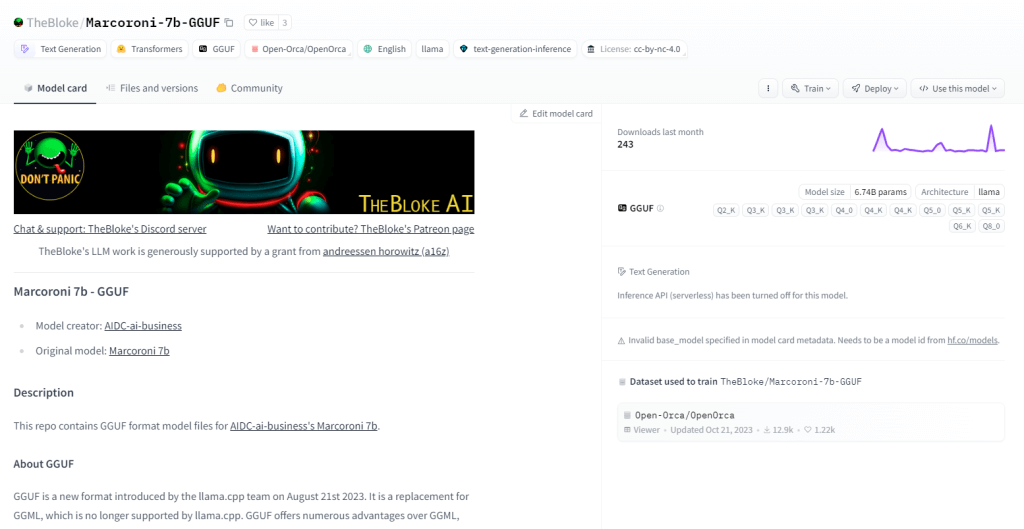

Skote – Svelte Admin- und Dashboard-Vorlage

Marcoroni-7B-v3 ist ein leistungsstarkes, mehrsprachiges generatives Modell mit 7 Milliarden Parametern, das für verschiedene Aufgaben geeignet ist, darunter Textgenerierung, Sprachübersetzung, kreative Inhaltserstellung und Beantwortung von Fragen. Es eignet sich hervorragend für die Verarbeitung von Text und Code und nutzt Zero-Shot-Learning für eine schnelle Aufgabenerledigung ohne vorheriges Training. Marcoroni-7B-v3 ist Open Source und steht unter einer freizügigen Lizenz. Es ermöglicht eine breite Nutzung und Experimentierfreude.

Hauptmerkmale

- Textgenerierung für Gedichte, Code, Skripte, E-Mails und mehr.

- Hochpräzise maschinelle Übersetzung.

- Erstellung ansprechender Chatbots mit natürlicher Konversation.

- Codegenerierung aus natürlichsprachlichen Beschreibungen.

- Umfassende Frage-Antwort-Funktionen.

- Zusammenfassung längerer Texte in prägnante Inhaltsangaben.

- Wirksame Paraphrasierung unter Beibehaltung der ursprünglichen Bedeutung.

- Stimmungsanalyse für Textinhalte.

Einpacken

Die Sammlung großer Sprachmodelle von Hugging Face ist für Entwickler, Forscher und Enthusiasten gleichermaßen bahnbrechend. Dank ihrer vielfältigen Architekturen und Fähigkeiten spielen diese Modelle eine große Rolle dabei, die Grenzen des Verstehens und der Generierung natürlicher Sprachen zu erweitern. Mit der Weiterentwicklung der Technologie sind die Anwendungsmöglichkeiten und Auswirkungen dieser Modelle endlos. Die Reise der Erforschung und Innovation mit großen Sprachmodellen geht weiter und verspricht spannende Entwicklungen in der Zukunft.